如何为 SEO 配置 Magento 2 robots.txt 文件

已发表: 2021-01-21目录

SEO 是您商店成功的重要因素,正确配置的 robots.txt 对使搜索引擎爬虫的工作更轻松做出了不小的贡献。

什么是 robots.txt?

简而言之,robots.txt 是一个文件,它指示搜索引擎爬虫他们可以或不能爬取什么。 如果您的根目录中没有 robots.txt,搜索引擎抓取工具会在您的商店中抓取所有可以抓取的内容,其中包括您不希望搜索引擎抓取工具浪费其抓取预算的重复或不重要的页面。 robots.txt 应该能够解决这个问题。

注意:robots.txt 文件不应用于向 Google 隐藏您的网页。 为此,您应该使用noindex元标记。

Magento 2 中的默认 robots.txt 指令

默认情况下,Magento 生成的 robots.txt 文件只包含网络爬虫的一些基本指令。

# Magento 提供的默认指令 用户代理: * 禁止:/lib/ 禁止:/*.php$ 禁止:/pkginfo/ 禁止:/report/ 禁止:/var/ 禁止:/目录/ 不允许:/客户/ 禁止:/sendfriend/ 禁止:/review/ 不允许:/*SID=

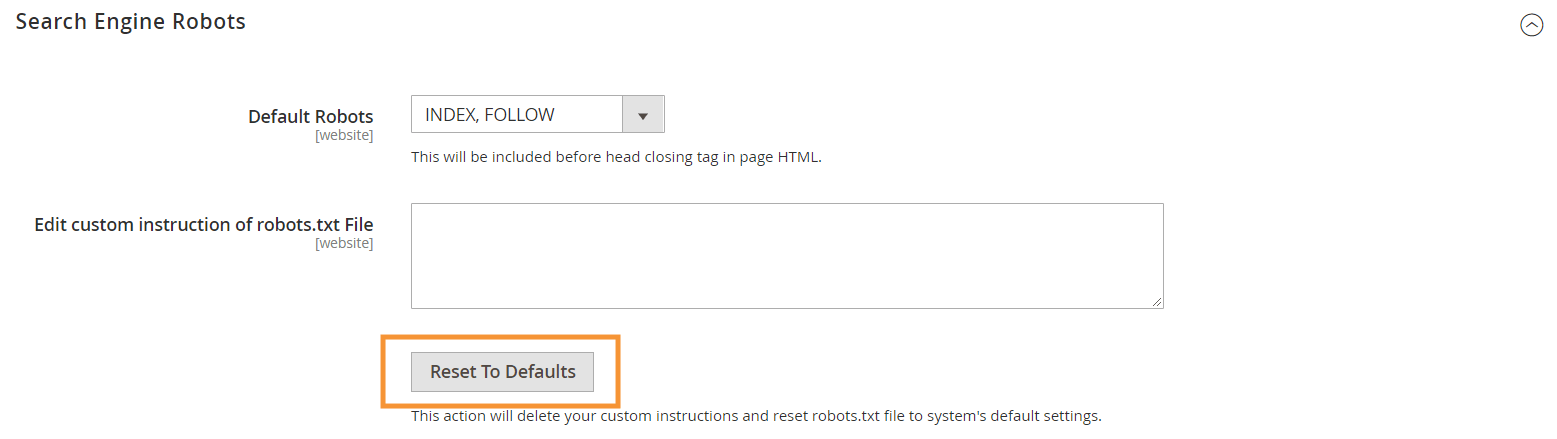

要生成这些默认说明,请在 Magento 后端的 Search Engine Robots 配置中点击Reset to Defaults按钮。

为什么需要在 Magento 2 中制作自定义 robots.txt 指令

虽然 Magento 提供的默认 robots.txt 指令对于告诉爬虫避免爬取系统内部使用的某些文件是必要的,但对于大多数 Magento 商店来说,它们还远远不够。

搜索引擎机器人只有有限的资源用于抓取网页。 对于具有数千甚至数百万个要抓取的 URL 的站点(这比您想象的更常见),您需要优先考虑需要抓取的内容类型(使用 sitemap.xml)并禁止不相关的内容被抓取的页面(带有 robots.txt)。 后一部分是通过禁止在您的 robots.txt 中抓取重复、不相关和不必要的页面来完成的。

robots.txt 指令的基本格式

robots.txt 中的说明以连贯的方式排列,对非技术用户友好:

# 规则1 用户代理:Googlebot 禁止:/nogooglebot/ # 规则 2 用户代理: * 允许: / 站点地图:https://www.example.com/sitemap.xml

-

User-agent:表示该规则所针对的特定爬虫。 一些常见的用户代理是Googlebot、Googlebot-Image、Mediapartners-Google、Googlebot-Video等。有关常见爬虫的广泛列表,请参阅 Google 爬虫概述。

-

Allow&Disallow:指定指定爬虫可以或不能访问的路径。 例如,Allow: /表示爬虫可以不受限制地访问整个站点。

-

Sitemap:指示您商店的站点地图的路径。 站点地图是一种告诉搜索引擎爬虫优先考虑哪些内容的方法,而 robots.txt 中的其余内容则告诉爬虫可以或不能爬取哪些内容。

同样在 robots.txt 中,您可以使用多个通配符作为路径值,例如:

-

*:当放入user-agent时,星号 (*) 指的是所有访问该网站的搜索引擎爬虫(AdsBot 爬虫除外)。 在Allow/Disallow指令中使用时,它表示任何有效字符的 0 个或多个实例(例如,Allow: /example*.css匹配/example.css以及/example12345.css )。 -

$:指定 URL 的结尾。 例如,Disallow: /*.php$将阻止所有以.php结尾的文件 #:指定评论的开始,爬虫将忽略。

注意:除了 sitemap.xml 路径,robots.txt 中的路径总是相对的,这意味着您不能使用完整的 URL(例如 https://simicart.com/nogooglebot/)来指定路径。

在 Magento 2 中配置 robots.txt

要访问 robots.txt 文件编辑器,请在 Magento 2 管理员中:

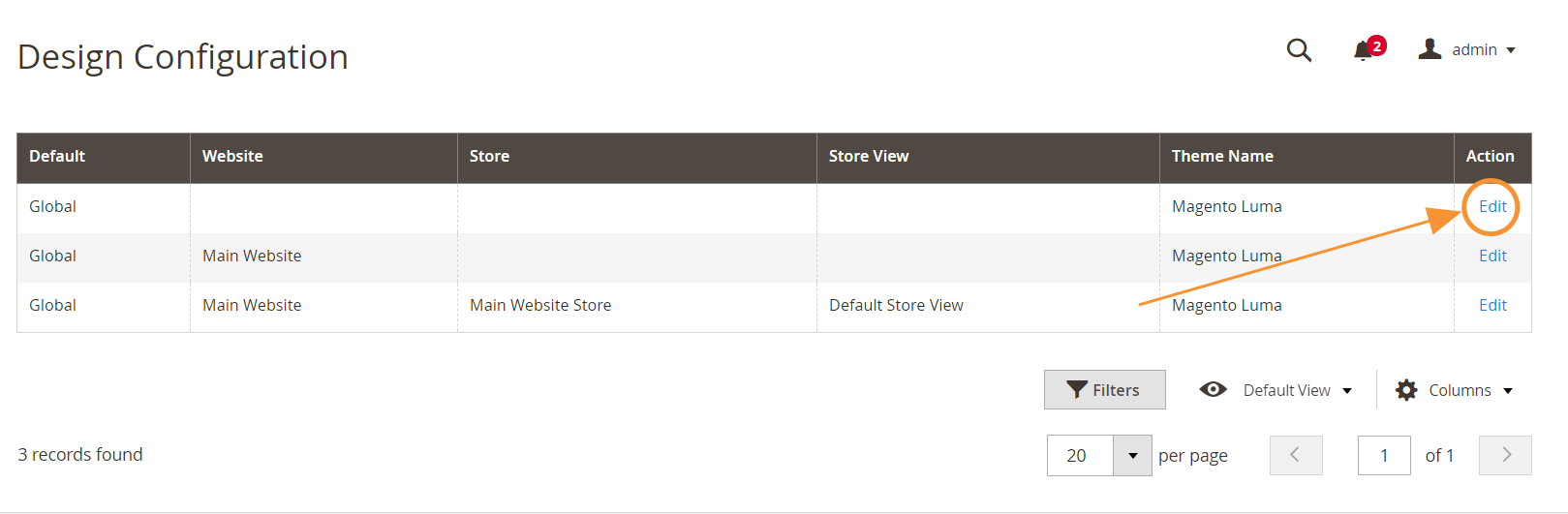

第 1 步:转到内容>设计>配置

第 2 步:编辑第一行中的全局配置

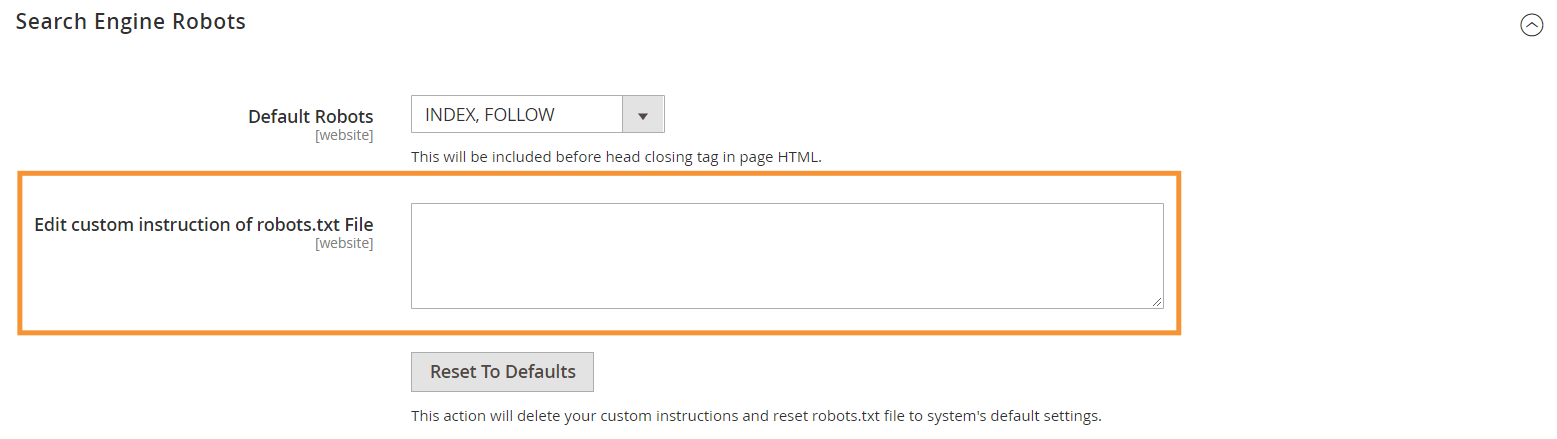

第 3 步:在搜索引擎机器人部分,编辑自定义说明

推荐 robots.txt 说明

这是我们推荐的说明,应该适合一般需求。 当然,每个商店都不同,您可能需要调整或添加更多规则以获得最佳结果。

用户代理: * # 默认指令: 禁止:/lib/ 禁止:/*.php$ 禁止:/pkginfo/ 禁止:/report/ 禁止:/var/ 禁止:/目录/ 不允许:/客户/ 禁止:/sendfriend/ 禁止:/review/ 不允许:/*SID= # 禁止根目录中的常见 Magento 文件: 禁止:/cron.php 禁止:/cron.sh 禁止:/error_log 禁止:/install.php 不允许:/LICENSE.html 不允许:/LICENSE.txt 禁止:/LICENSE_AFL.txt 禁止:/STATUS.txt # 禁止用户帐户 & 结帐页面: 禁止:/checkout/ 禁止:/onestepcheckout/ 不允许:/客户/ 禁止:/客户/帐户/ 禁止:/customer/account/login/ # 禁止目录搜索页面: 禁止:/catalogsearch/ 禁止:/catalog/product_compare/ 禁止:/catalog/category/view/ 不允许:/catalog/product/view/ # 禁止 URL 过滤器搜索 禁止:/*?dir* 禁止:/*?dir=desc 禁止:/*?dir=asc 禁止:/*?limit=all 禁止:/*?mode* # 禁止 CMS 目录: 禁止:/app/ 禁止:/bin/ 禁止:/dev/ 禁止:/lib/ 禁止:/phpserver/ 禁止:/pub/ # 禁止重复内容: 禁止:/标签/ 禁止:/review/ 不允许:/*?*product_list_mode= 不允许:/*?*product_list_order= 禁止:/*?*product_list_limit= 禁止:/*?*product_list_dir= # 服务器设置 # 禁止服务器上的一般技术目录和文件 禁止:/cgi-bin/ 禁止:/cleanup.php 禁止:/apc.php 禁止:/memcache.php 禁止:/phpinfo.php # 禁止版本控制文件夹和其他 禁止:/*.git 禁止:/*.CVS 禁止:/*.Zip$ 禁止:/*.Svn$ 禁止:/*.Idea$ 禁止:/*.Sql$ 禁止:/*.Tgz$ 站点地图:https://www.example.com/sitemap.xml

结论

创建 robots.txt 文件只是 Magento SEO 清单中的众多步骤之一,并且为搜索引擎正确优化 Magento 商店对于大多数商店所有者来说肯定不是一件容易的事。 如果您不想处理这个问题,我们可以为您处理一切。 在 SimiCart,我们提供 SEO 和速度优化服务,保证为您的商店提供最佳结果。