Как настроить файл robots.txt Magento 2 для SEO

Опубликовано: 2021-01-21Оглавление

SEO — важный фактор успеха вашего магазина, и правильно настроенный файл robots.txt в немалой степени облегчает работу сканеров поисковых систем.

Что такое robots.txt?

В двух словах, robots.txt — это файл, который указывает сканерам поисковых систем, что они могут или не могут сканировать. Без robots.txt в вашем корневом каталоге сканеры поисковых систем, проходящие через ваш магазин, будут сканировать все, что смогут, включая дублированные или неважные страницы, на которые вы не хотите, чтобы сканеры поисковых систем тратили свой краулинговый бюджет. Файл robots.txt должен решить эту проблему.

Примечание . Файл robots.txt не следует использовать для сокрытия ваших веб-страниц от Google. Вместо этого вы должны использовать метатег noindex для этой цели.

Инструкции robots.txt по умолчанию в Magento 2

По умолчанию файл robots.txt, сгенерированный Magento, содержит только некоторые основные инструкции для поискового робота.

# Инструкции по умолчанию, предоставляемые Magento Пользовательский агент: * Запретить: /lib/ Запретить: /*.php$ Запретить: /pkginfo/ Запретить: /отчет/ Запретить: /var/ Запретить: /каталог/ Запретить: /клиент/ Запретить: /sendfriend/ Запретить: /обзор/ Запретить: /*SID=

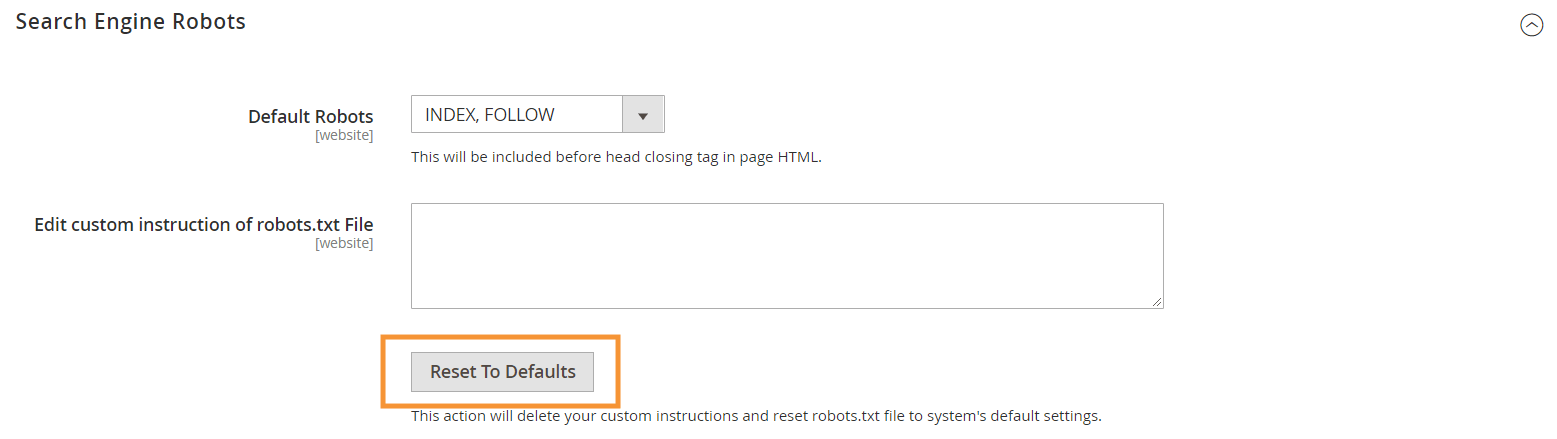

Чтобы сгенерировать эти инструкции по умолчанию, нажмите кнопку « Восстановить настройки по умолчанию » в конфигурации роботов поисковых систем в вашем бэкэнде Magento.

Почему вам нужно создавать собственные инструкции robots.txt в Magento 2

Хотя инструкции по умолчанию robots.txt, предоставляемые Magento, необходимы для того, чтобы сообщать сканерам о необходимости избегать сканирования определенных файлов, которые используются внутри системы, их недостаточно для большинства магазинов Magento.

Роботы поисковых систем имеют ограниченное количество ресурсов для сканирования веб-страниц. Для сайта с тысячами или даже миллионами URL-адресов для сканирования (что встречается чаще, чем вы думаете), вам необходимо расставить приоритеты для типа контента, который необходимо сканировать (с помощью файла sitemap.xml), и запретить нерелевантные. страницы от сканирования (с файлом robots.txt). Последняя часть выполняется путем запрета сканирования повторяющихся, нерелевантных и ненужных страниц в файле robots.txt.

Базовый формат директив robots.txt

Инструкции в файле robots.txt изложены в последовательной форме, удобной для нетехнических пользователей:

# Правило 1 Агент пользователя: Googlebot Запретить: /nogooglebot/ # Правило 2 Пользовательский агент: * Разрешать: / Карта сайта: https://www.example.com/sitemap.xml

-

User-agent: указывает конкретный поисковый робот, для которого предназначено правило. Некоторыми распространенными пользовательскими агентами являютсяGooglebot,Googlebot-Image,Mediapartners-Google,Googlebot-Videoи т. д. Полный список распространенных поисковых роботов см. в разделе Обзор поисковых роботов Google.

-

AllowиDisallow: укажите пути, к которым могут или не могут получить доступ назначенные поисковые роботы. Например,Allow: /означает, что сканер может получить доступ ко всему сайту без ограничений.

-

Sitemap: указывает путь к карте сайта для вашего магазина. Карта сайта — это способ указать сканерам поисковых систем, какой контент должен быть приоритетным, в то время как остальная часть контента в файле robots.txt сообщает сканерам, какой контент они могут или не могут сканировать.

Также в robots.txt вы можете использовать несколько подстановочных знаков для значений пути, таких как:

-

*: при добавлении вuser-agentзвездочка (*) относится ко всем сканерам поисковых систем (кроме сканеров AdsBot), которые посещают сайт. При использовании в директивахAllow/Disallowэто означает 0 или более экземпляров любого допустимого символа (например,Allow: /example*.cssсоответствует /example.css, а также /example12345.css ). -

$: обозначает конец URL-адреса. Например,Disallow: /*.php$заблокирует все файлы, оканчивающиеся на .php. -

#: обозначает начало комментария, который сканеры будут игнорировать.

Примечание . За исключением пути sitemap.xml, пути в robots.txt всегда являются относительными , что означает, что вы не можете использовать полные URL-адреса (например, https://simicart.com/nogooglebot/) для указания путей.

Настройка robots.txt в Magento 2

Чтобы получить доступ к редактору файла robots.txt, в панели администратора Magento 2:

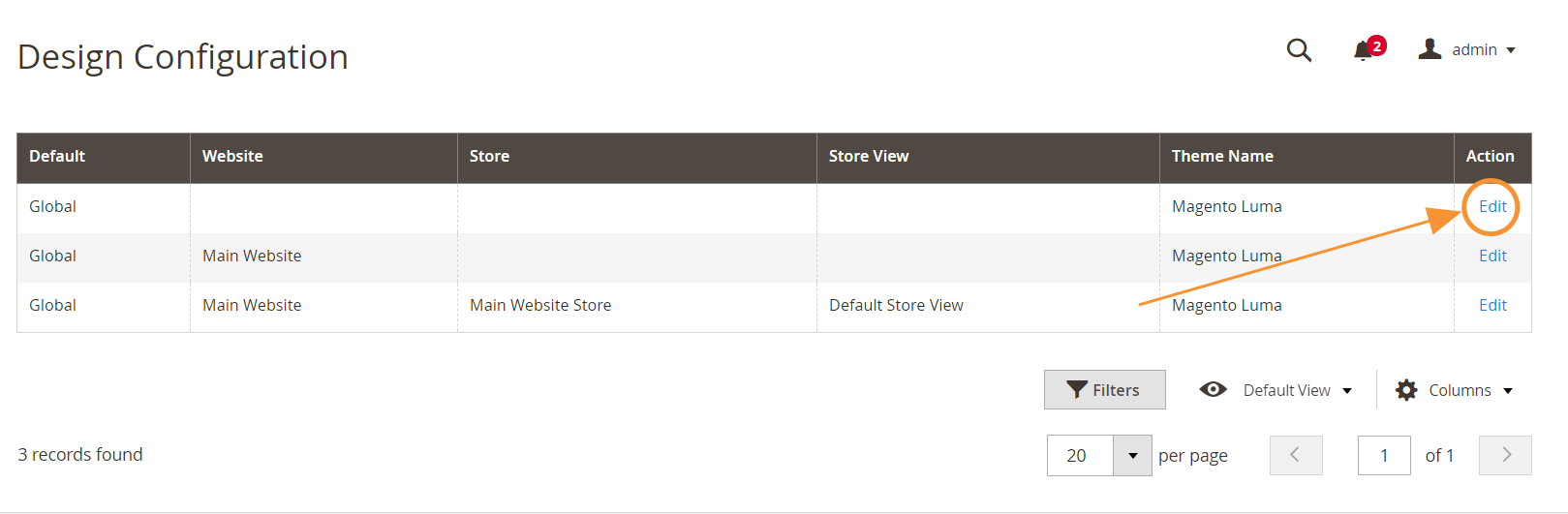

Шаг 1. Перейдите в раздел « Контент » > « Дизайн» > « Конфигурация ».

Шаг 2. Отредактируйте глобальную конфигурацию в первой строке.

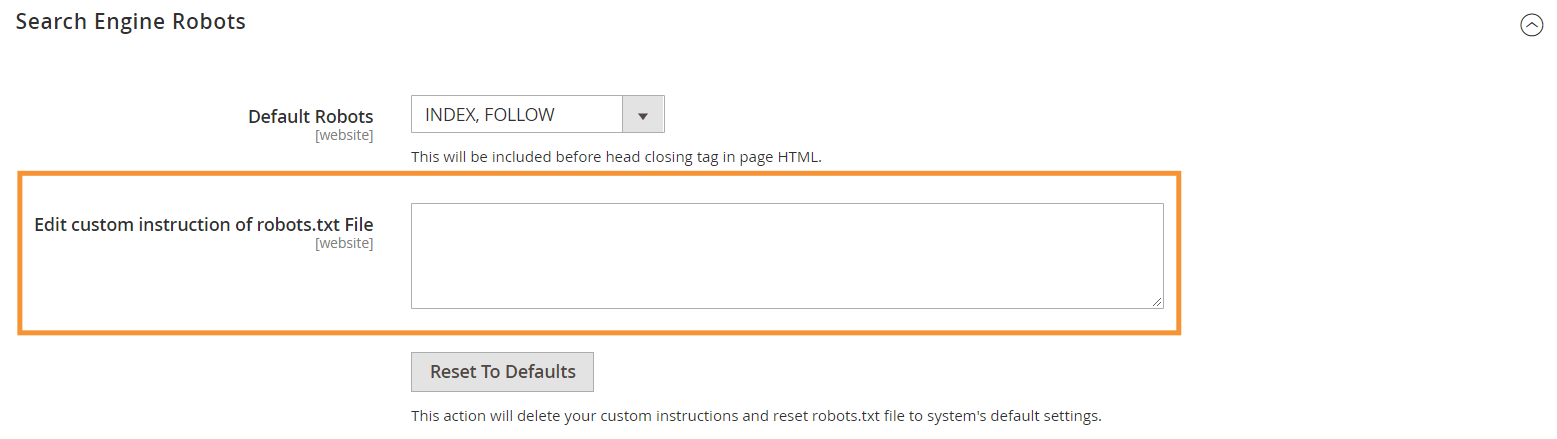

Шаг 3. В разделе "Роботы поисковых систем" измените пользовательские инструкции.

Рекомендуемые инструкции robots.txt

Вот наши рекомендуемые инструкции, которые должны соответствовать общим потребностям. Конечно, каждый магазин уникален, и вам может потребоваться настроить или добавить еще несколько правил для достижения наилучших результатов.

Пользовательский агент: * # Инструкции по умолчанию: Запретить: /lib/ Запретить: /*.php$ Запретить: /pkginfo/ Запретить: /отчет/ Запретить: /var/ Запретить: /каталог/ Запретить: /клиент/ Запретить: /sendfriend/ Запретить: /обзор/ Запретить: /*SID= # Запретить общие файлы Magento в корневом каталоге: Запретить: /cron.php Запретить: /cron.sh Запретить: /error_log Запретить: /install.php Запретить: /LICENSE.html Запретить: /LICENSE.txt Запретить: /LICENSE_AFL.txt Запретить: /STATUS.txt # Запретить учетную запись пользователя & Страницы оформления заказа: Запретить: /checkout/ Запретить: /onestepcheckout/ Запретить: /клиент/ Запретить: /клиент/аккаунт/ Запретить: /клиент/аккаунт/логин/ # Запретить страницы поиска по каталогу: Запретить: /catalogsearch/ Запретить: /catalog/product_compare/ Запретить: /каталог/категория/просмотр/ Запретить: /catalog/product/view/ # Запретить поиск по URL-фильтру Запретить: /*?dir* Запретить: /*?dir=desc Запретить: /*?dir=asc Запретить: /*?limit=all Запретить: /*?режим* # Запретить каталоги CMS: Запретить: /приложение/ Запретить: /bin/ Запретить: /dev/ Запретить: /lib/ Запретить: /phpserver/ Запретить: /pub/ # Запретить дублирование содержимого: Запретить: /тег/ Запретить: /обзор/ Запретить: /*?*product_list_mode= Запретить: /*?*product_list_order= Запретить: /*?*product_list_limit= Запретить: /*?*product_list_dir= # Настройки сервера # Запретить общие технические каталоги и файлы на сервере Запретить: /cgi-bin/ Запретить: /cleanup.php Запретить: /apc.php Запретить: /memcache.php Запретить: /phpinfo.php # Запретить папки контроля версий и прочее Запретить: /*.git Запретить: /*.CVS Запретить: /*.Zip$ Запретить: /*.Svn$ Запретить: /*.Идея$ Запретить: /*.Sql$ Запретить: /*.Tgz$ Карта сайта: https://www.example.com/sitemap.xml

Вывод

Создание файла robots.txt — это только один из многих шагов в контрольном списке Magento SEO, и правильная оптимизация магазина Magento для поисковых систем — непростая задача для большинства владельцев магазинов. Если вы не хотите заниматься этим, мы можем позаботиться обо всем за вас. Здесь, в SimiCart, мы предоставляем услуги SEO и оптимизации скорости, которые гарантируют наилучшие результаты для вашего магазина.