De ce este important SEO tehnic?

Publicat: 2022-08-03Ca parte a unui pachet de servicii SEO, SEO tehnic se ocupă de componentele tehnice ale unui site web, cum ar fi hărțile site-ului, viteza paginii, adresa URL, schema, navigarea și multe altele.

Concluzia: orice afacere online are nevoie de un site web complet optimizat pentru a atrage clienți potențiali calificați. SEO tehnic face site-ul dvs. web rapid, prietenos cu dispozitivele mobile, ușor de utilizat și de încredere.

În acest blog, vă explicăm elementele tehnice de bază ale SEO, astfel încât să vă puteți optimiza site-ul web și, mai important, să știți cum să conversați cu echipa de marketing despre această fațetă cheie a optimizării pentru motoarele de căutare.

SEO tehnic și motoarele de căutare: cum funcționează

Motoarele de căutare sunt programe software concepute pentru a ajuta oamenii care folosesc cuvinte cheie sau expresii să găsească online informațiile pe care le caută.

Google spune că misiunea sa este „de a organiza informațiile din lume și de a le face universal accesibile și utile. De aceea, Căutarea facilitează descoperirea unei game largi de informații dintr-o mare varietate de surse.”

Algoritmii săi de proprietate preiau cele mai relevante și de renume surse de date posibile pentru a le prezenta utilizatorilor de internet.

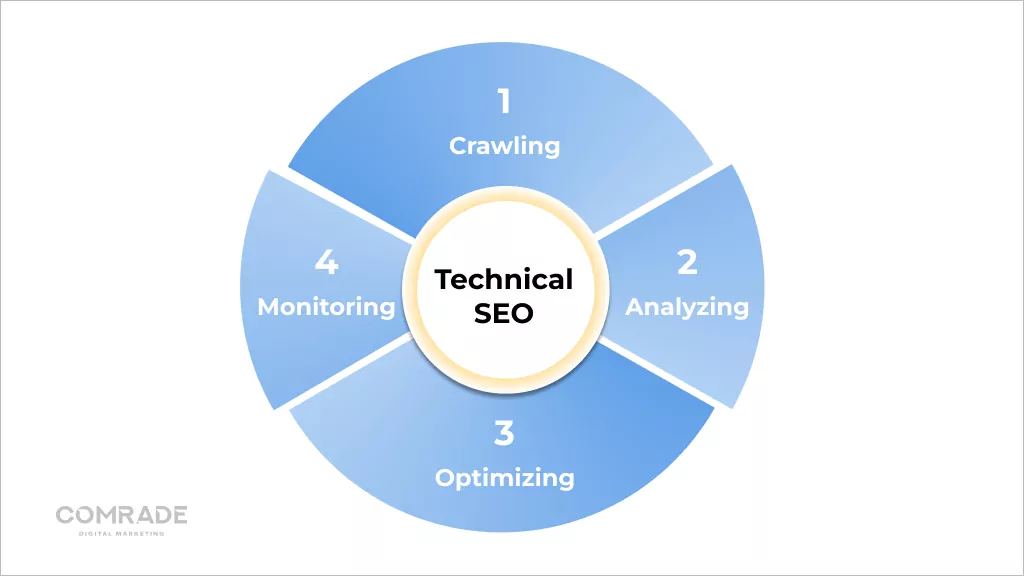

Din punct de vedere tehnic, procesul funcționează astfel:

Crawling

Software-ul sofisticat numit crawler-uri web pentru motoarele de căutare, denumite și „roboți” sau „păianjeni”, cercetează pe internet căutând conținut/URL-uri. Aceștia vor accesa cu crawlere un site web prin descărcarea fișierului său robots.txt, care conține reguli despre adresele URL pe care trebuie să le acceseze cu crawlere un motor de căutare.

Deoarece nu există un registru centralizat al tuturor paginilor web existente, motoarele de căutare precum Google caută în mod constant pagini noi și actualizate pentru a le adăuga la lista lor de pagini cunoscute. Aceasta se numește „descoperire URL”.

Peste 547.200 de site-uri web noi sunt create la nivel global în fiecare zi, de unde și importanța ca Googlebots să acceseze constant cu crawlere web!

Păianjenii accesează cu crawlere paginile cunoscute de motoarele de căutare pentru a determina dacă au fost făcute modificări. Dacă da, vor actualiza indexul ca răspuns la aceste modificări. De exemplu, atunci când un magazin de comerț electronic își actualizează paginile de produse, s-ar putea clasa pentru cuvinte cheie noi.

Crawlerele web au calculat cât de des o pagină web ar trebui să fie accesată din nou cu crawlere și câte pagini de pe un site ar trebui să fie indexate prin bugetul lor de accesare cu crawlere. Aceasta este determinată de limita ratei de accesare cu crawlere și cererea de accesare cu crawlere.

Din cauza resurselor limitate, Googlebots trebuie să-și acorde prioritate efortului de accesare cu crawlere, iar atribuirea unui buget de accesare cu crawlere fiecărui site web îi ajută să facă acest lucru. Dacă SEO tehnic al unui site web este de până la zero, este mai rapid de accesat cu crawlere, crescând limita de accesare cu crawlere (numărul de pagini accesate cu crawlere de un robot într-un anumit interval de timp.)

Dimpotrivă, dacă un site încetinește din cauza SEO tehnică slabă, Googlebots accesează cu crawlere mai puțin. În mod logic, nu are sens să accesezi cu crawlere un site web cu un SEO tehnic slab, deoarece nu va oferi o experiență pozitivă pentru utilizator, ceea ce contravine obiectivelor cheie ale Google.

Cu toate acestea, Google a publicat următoarele despre bugetul de accesare cu crawlere:

„Bugetul de accesare cu crawlere... nu este ceva despre care majoritatea editorilor trebuie să-și facă griji... paginile noi tind să fie accesate cu crawlere în aceeași zi în care sunt publicate. Bugetul de accesare cu crawlere nu este ceva pe care webmasterii trebuie să se concentreze.”

Paginile mai noi sau cele care nu sunt bine conectate sau actualizate pot fi afectate de bugetul de accesare cu crawlere. Cu toate acestea, în majoritatea cazurilor, un site web cu mai puțin de 1000 de adrese URL care este actualizat în mod regulat va fi accesat cu crawlere eficient de cele mai multe ori.

Redare

Redarea este codificarea grafică a informațiilor de pe paginile web. În termeni profani, este procesul de „pictare a textului și a imaginilor pe ecran”, astfel încât motoarele de căutare să poată înțelege despre ce este vorba despre aspectul unei pagini web.

Motoarele de căutare extrag codul HTML al site-ului web și îl traduc în lucruri precum blocuri de text, imagini, videoclipuri și alte elemente. Redarea ajută motoarele de căutare să înțeleagă experiența utilizatorului și este un pas necesar pentru a răspunde la întrebările relevante legate de indexare și clasare.

Indexarea

După ce o pagină este redată, Google încearcă să înțeleagă despre ce este vorba. Aceasta se numește indexare. În timpul acestui proces, Google analizează conținutul textual (informațiile) ale paginilor web, inclusiv etichetele de conținut cheie, cuvintele cheie, atributele alt, imaginile, videoclipurile etc.

De asemenea, analizează relația dintre diferite pagini și site-uri web urmând link-uri externe și interne, precum și backlink-uri. Prin urmare, cu cât o faceți mai bine pentru a vă face site-ul ușor de înțeles (investind în SEO tehnic), cu atât sunt mai mari șansele ca Google să-și indexeze paginile.

Legăturile sunt ca căile neuronale ale internetului care conectează paginile web. Ele sunt necesare pentru ca roboții să înțeleagă conexiunile dintre paginile web și să ajute la contextualizarea conținutului acestora. Cu toate acestea, roboții de căutare nu urmăresc toate adresele URL de pe un site web, ci doar pe acelea cu link-uri dofollow (Link-uri de la alte site-uri web care indică înapoi către ale dvs. și întăresc autoritatea domeniului.)

De aici, importanța construirii de legături. Atunci când linkurile externe provin de la domenii de înaltă calitate, ele întăresc site-ul web la care se leagă, sporind clasamentul SERP. Cu toate acestea, atunci când crawlerele găsesc o pagină web, redă conținutul paginii și țin evidența tuturor – de la cuvintele cheie la actualitatea site-ului – în indexul de căutare Google.

Acest index este în esență o bibliotecă digitală de trilioane de pagini web. Deci, interesant, atunci când introduceți o interogare într-un motor de căutare, nu căutați direct pe web; de fapt căutați în indexul paginilor web al unui motor de căutare.

Clasament

Când un utilizator introduce o interogare, Google trebuie să determine care pagini din indexul său se potrivesc cel mai bine cu ceea ce caută utilizatorul respectiv. Există peste 200 de factori de clasare care pot fi rezumați în cinci categorii majore:

- Semnificația interogării : algoritmul Google analizează intenția întrebării unui utilizator folosind instrumente de limbaj complexe construite pe căutările anterioare și comportamentul de utilizare.

- Relevanța paginii web : determinantul principal al relevanței paginii web este analiza cuvintelor cheie. Cuvintele cheie de pe un site ar trebui să se potrivească cu înțelegerea de către Google a interogării adresate de un utilizator.

- Calitatea conținutului : odată ce Google se potrivește cuvintelor cheie din numeroase pagini web, analizează calitatea conținutului, autoritatea site-ului, PageRank individual și prospețime pentru a prioritiza locul în care se află paginile.

- Utilizabilitatea paginii web : paginile care sunt ușor de utilizat primesc prioritate. Viteza site-ului, capacitatea de răspuns și compatibilitatea cu dispozitivele mobile joacă un rol.

- Context și setări suplimentare : în sfârșit, algoritmul Google va lua în considerare implicarea anterioară a utilizatorilor și setările specifice din motorul de căutare. Unele semnale includ limba paginii și țara către care este vizat conținutul.

Dacă doriți mai mult trafic și să vă poziționați mai sus pe Google și alte motoare de căutare, trebuie să acordați atenție SEO tehnic.

Cum tehnică SEO îmbunătățește accesarea cu crawlere și indexarea site-urilor

La cel mai elementar nivel, motoarele de căutare trebuie să poată găsi, accesa cu crawlere, reda și indexează paginile site-ului dvs. Prin urmare, îmbunătățirea aspectelor tehnice, adică SEO tehnic, ar trebui să aibă ca rezultat clasamente mai ridicate în rezultatele căutării.

Cum să îmbunătățiți accesarea cu crawlere a site-ului web

Eficiența accesării cu crawlere se referă la modul în care roboții pot accesa cu crawlere toate paginile de pe site-ul dvs. O structură URL curată, servere de încredere, hărți de site precise și fișiere robots.txt, toate îmbunătățesc eficiența accesării cu crawlere.

1. Configurați Robots.txt

Un fișier robots.txt conține directive pentru motoarele de căutare și este folosit în principal pentru a le spune crawlerilor ce adrese URL ar trebui să exploreze.

Deși acest lucru pare contrar obiectivelor SEO de a preveni accesarea cu crawlere a paginilor, este util dacă construiți un site web nou și aveți mai multe versiuni ale aceleiași pagini și doriți să evitați să fiți penalizat pentru conținut duplicat.

De asemenea, puteți utiliza un fișier robots.txt pentru a preveni supraîncărcarea serverelor atunci când crawlerele încarcă mai multe părți de conținut simultan, precum și pentru a bloca indexarea paginilor private.

Dacă site-ul dvs. este mare și întâmpinați dificultăți în a vă indexa toate paginile, un fișier robot.txt va ajuta roboții să petreacă timp pe paginile care contează.

2. Alegeți Găzduire bună

Găzduirea afectează viteza site-ului, timpul de nefuncționare a serverului și securitatea, ceea ce influențează performanța tehnică SEO. O gazdă web bună este de încredere, disponibilă și vine cu asistență eficientă pentru clienți.

Știm că găzduirea site-ului web este scumpă, dar adevărul este că primești ceea ce plătești. Am văzut clienții care fac greșeli comune, cum ar fi optarea pentru gratuități, care vin cu un aflux de anunțuri pop-up care încetinesc timpul de încărcare a paginii sau selectează o opțiune mai ieftină care compromite securitatea datelor.

Gazdele web de încredere garantează un timp de funcționare de 99,9%. Prin urmare, gazda dvs. web ar trebui să aibă servere puternice, cu o infrastructură rezistentă. O soluție de găzduire adecvată asigură securitatea, accesibilitatea și fiabilitatea serviciilor dvs. online.

Obțineți un audit de performanță SEO digital gratuit, fără obligații.

solicita audit

3. Ștergeți paginile inutile și redundante

Search Engine Land a publicat recent un articol despre imposibilitatea ca Google să indexeze fiecare pagină a fiecărui site web.

Acest lucru nu este neapărat dezamăgire, deoarece paginile web de calitate scăzută nu ar trebui să fie oricum în rezultatele motoarelor de căutare, deoarece nu oferă nicio valoare vizitatorilor și pierd timpul prețios al unui robot de căutare (bugetul de accesare cu crawlere).

În ciuda acestui fapt, întâlnim adesea umflarea indexului, în special pe site-urile de comerț electronic cu inventare mari de produse și recenzii ale clienților.

De obicei, păianjenii motoarelor de căutare indexează aceste pagini nedorite și erodează scorurile de relevanță, ceea ce poate duce la ignorarea de către Google a paginilor mai importante.

Prin urmare, efectuarea de auditări periodice a paginilor și menținerea unui site web curat asigură că roboții indexează numai adresele URL importante.

4. Evitați paginile duplicate

Paginile duplicate diluează echitatea link-urilor și încurcă motoarele de căutare, deoarece nu știu ce pagini web să claseze, ceea ce înseamnă că de obicei ajungeți să concurezi împotriva ta în SERP-uri. Dacă aveți pagini duplicat pe site-ul dvs. web, este probabil ca ambele pagini să aibă performanțe slabe.

Conținutul duplicat apare atât pe site, cât și în afara site-ului. Conținutul duplicat în afara site-ului este greu de controlat. Pentru a scăpa de conținutul duplicat din afara site-ului (de obicei, materiale de marketing de conținut, cum ar fi bloguri sau pagini de produse), puteți trimite un raport de încălcare a drepturilor de autor la Google, solicitându-i să elimine pagina duplicată din indexul său.

În cele mai multe cazuri, conținutul duplicat de pe site nu este o încercare rău intenționată de a manipula clasamentele motoarelor de căutare, ci mai degrabă din cauza arhitecturii și dezvoltării site-ului web slabe (vezi: secțiunea de indexare pentru mai multe detalii).

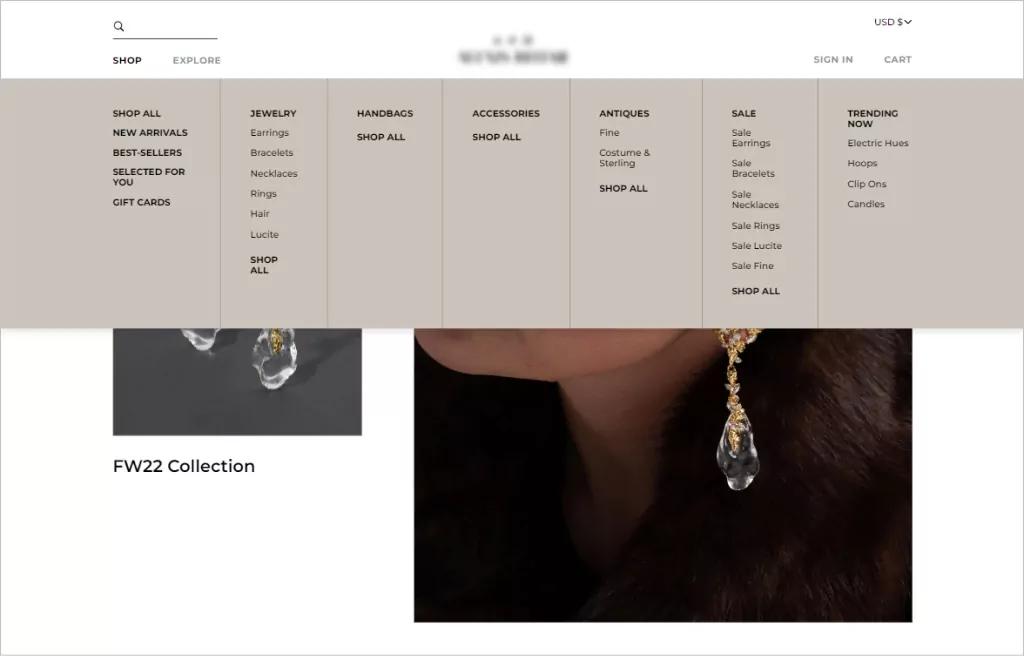

5. Implementați navigarea simplă pe site (pentru utilizatori și roboți)

Când vorbim despre navigarea pe site, ne referim la structura link-urilor și ierarhia unui site web. O bună navigare pe site îi aduce pe utilizatori acolo unde trebuie, cu cât mai puține clicuri posibil.

Ca regulă generală, structura URL a site-ului dvs. ar trebui să permită vizitatorilor să ajungă pe orice pagină și să găsească ceea ce au nevoie în trei clicuri. Dincolo de o estetică consecventă a designului, meniurile de navigare care funcționează cel mai bine au o structură ierarhică clară, cu subcategorii pe care se poate face clic incluse în meniu dacă este necesar.

Ordinea este importantă când vine vorba de navigare. Este mai probabil ca utilizatorii să-și amintească primul și ultimul element de meniu. Prin urmare, majoritatea structurilor de navigare a site-urilor de comerț electronic încep cu o pagină de magazin și se termină cu un îndemn la acțiune, cum ar fi un buton de finalizare a achiziției.

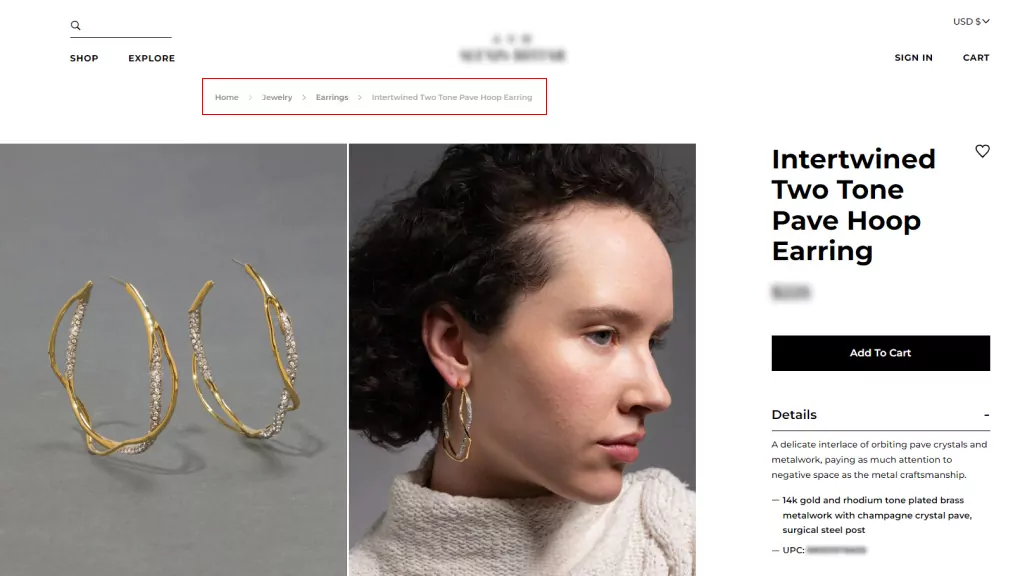

6. Folosiți pesmet

Breadcrumb-urile sunt sisteme de navigare secundare care arată locația unui utilizator pe un site web. Ele simplifică navigarea pentru site-uri web complexe de comerț electronic cu multe categorii și pagini cu variante de produse și sunt utile în special atunci când utilizatorii ajung pe un site printr-un link extern care nu duce la pagina de pornire.

Pesmeturile completează meniurile principale de navigare, dar nu le pot înlocui. Există două tipuri de pesmet:

- Bazat pe locație, care ajută utilizatorii să-și identifice locația curentă în structura site-ului; și

- Bazat pe atribute, care ajută utilizatorii să identifice calitățile importante ale paginii vizualizate.

Folosirea breadcrumbs încurajează oamenii să viziteze mai multe pagini de site și reduce rata de respingere, ceea ce este bun pentru SEO în general. Cu toate acestea, le veți folosi numai dacă structura site-ului dvs. este complexă și trebuie să îmbunătățiți capacitatea unui utilizator de a naviga între paginile de categorii.

7. Furnizați un sitemap.xml

O hartă a site-ului este un fișier care listează toate paginile web ale site-ului dvs. despre care doriți ca motoarele de căutare să le cunoască și să ia în considerare clasarea. Deși hărțile de site nu sunt condiții prealabile pentru a avea un site web, acestea sunt foarte încurajate, deoarece produc accesarea cu crawlere eficientă a site-ului.

Sitemap-urile sunt completări grozave pentru site-urile web noi, cu backlink-uri limitate, care trebuie indexate, precum și pentru site-uri mari în care paginile pot fi trecute cu vederea dacă metadatele nu sunt actualizate cu acuratețe. Același lucru este valabil și pentru site-urile de arhivă unde paginile web nu se leagă în mod natural între ele.

Având o hartă a site-ului, motoarele de căutare au un ghid util pentru a înțelege despre ce este site-ul dvs. și cum sunt legate paginile acestuia. Astfel, crește SEO, clasamentele și traficul.

Cum să verificați și să remediați problema de accesare cu crawlere a site-ului dvs

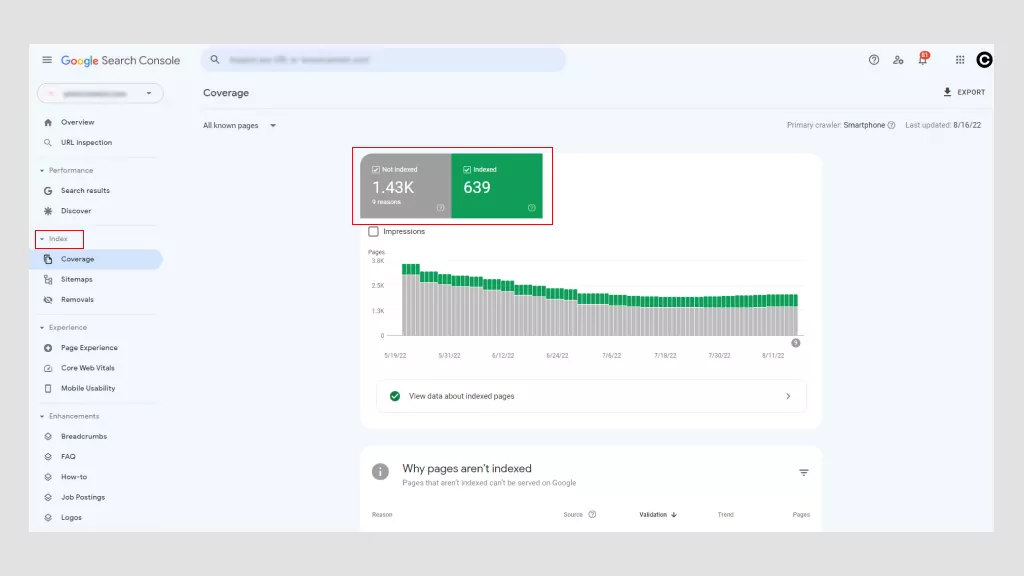

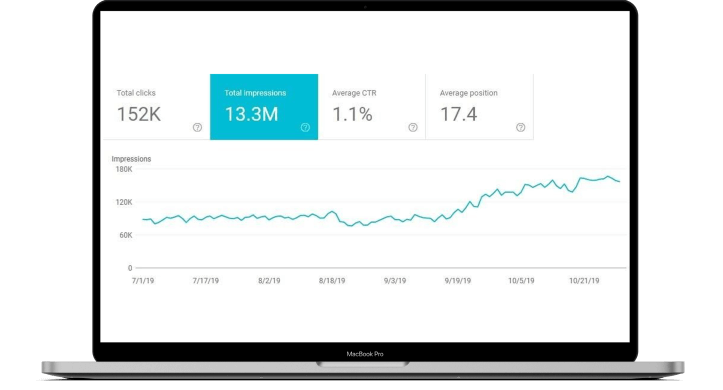

Utilizarea Google Search Console este cea mai bună modalitate de a determina dacă site-ul dvs. are probleme de accesare cu crawlere. Există și alte instrumente, dar avantajul major este că Google este gratuit. Cu Google Search Console, puteți accesa „Erori de accesare cu crawlere” din tabloul de bord principal.

Google împarte aceste erori în două categorii: erori de site și erori URL. Problemele la nivel de site sunt mai îngrijorătoare, deoarece pot afecta utilizarea întregului site web, în timp ce erorile URL sunt specifice paginilor individuale și mai puțin problematice, deși ar trebui totuși remediate.

1. Posibile erori ale site-ului

- Erori DNS : acest lucru se întâmplă când un robot Google nu se poate conecta la numele dvs. de domeniu din cauza unei probleme de timeout sau de căutare. Pentru a remedia acest lucru, verificați setările DNS. Problema poate fi setările DNS configurate greșit, o conexiune la internet defectuoasă sau un browser învechit.

- Erori de conectare la server : de obicei, când un site durează prea mult să răspundă, solicitarea expiră. Aceasta înseamnă că Googlebot s-a conectat la site-ul dvs. web, dar nu a putut încărca pagina din cauza unei modificări a configurației rețelei, a deconectarii Wi-Fi sau a unui cablu de rețea deconectat.

- Erori de preluare Robots.txt : Acesta este momentul în care un robot Google nu poate prelua un fișier robots.txt. Actualizarea fișierului robots.txt și lăsarea roboților să vă acceseze din nou paginile ar trebui să rezolve această problemă.

2. Posibile erori URL

- Not found (404) : Dacă Google încearcă să acceseze cu crawlere o pagină care nu mai există, afișează o eroare 404. O modalitate simplă de a remedia acest lucru este redirecționarea paginii către alta.

- Neurmat : este momentul în care un bot nu a putut urmări complet adresele URL de pe site-ul dvs. web. JavaScript, cookie-urile, ID-urile de sesiune, DHTML sau Flash sunt posibili vinovați.

- 500 eroare internă de server : De cele mai multe ori, aceste erori apar atunci când un server web este supraîncărcat și sunt rezolvate contactând furnizorul dvs. de gazdă web. Dacă, din întâmplare, rulați un site WordPress, veți dori să verificați pluginurile terțelor părți.

Discutați cu experți

Cum să verificați și să remediați problemele de indexare ale site-ului dvs. web

Indexarea este modalitatea Google de a culege și procesa toate datele din paginile dvs. web atunci când accesează cu crawlere web. Acesta permite motoarelor de căutare să optimizeze viteza și performanța atunci când potrivesc interogările utilizatorilor cu informații relevante. Ca atare, Google afișează pagini cu rezultate în câteva secunde!

Google folosește un sistem de indexare pe niveluri în care conținutul cel mai popular este indexat pe un spațiu de stocare mai rapid și mai scump. De aici, importanța conținutului bogat în cuvinte cheie.

Problemele comune de indexare cu care se confruntă webmasterii și soluțiile lor includ:

1. NoIndex Errors

Este posibil să împiedicați păianjenii (roboții) să acceseze cu crawlere o pagină prin includerea unei etichete meta sau a antetului noindex în răspunsul HTTP. Când un Googlebot întâlnește această etichetă, va renunța la pagina din rezultatele Căutării Google, indiferent dacă alte site-uri trimit la aceasta.

Există motive întemeiate pentru a utiliza o etichetă noindex pe o pagină web sau pe o parte a acesteia, de exemplu:

- Pentru a preveni conținutul duplicat.

- Pentru a păstra paginile de administrare și de conectare numai pentru uz intern.

- Pentru a evita indexarea paginilor de destinație plătite. Dacă desfășurați o campanie de captare a clienților potențiali, nu aveți nevoie de sute de pagini duplicat de mulțumire pentru a fi indexate.

O etichetă neindexată ajută la definirea conținutului valoros și organizat din alte pagini, asigurând că cele mai importante pagini sunt disponibile în SERP-uri. Cu toate acestea, erorile neindexate au consecințe negative, mai ales atunci când doriți ca o pagină să fie indexată.

Dacă Google accesează cu crawlere o pagină, dar nu o indexează, acest lucru poate însemna două lucruri. Fie pagina este de calitate scăzută, fie există prea multe adrese URL în tacul de accesare cu crawlere, iar motorul de căutare nu are suficient buget pentru a le parcurge.

Din cauza boom-ului comerțului electronic, este obișnuit ca paginile de produse să întâmpine erori fără indexare. Pentru a combate acest lucru, asigurați-vă că paginile produselor sunt unice (nu copiate din surse externe), implementați etichete canonice pentru a consolida conținutul duplicat și utilizați etichete noindex pentru a bloca Googlebots să indexeze secțiuni de calitate scăzută ale site-ului dvs.

Dacă nu aveți probleme de indexare din cauza multor adrese URL, veți dori să optimizați bugetul de accesare cu crawlere utilizând fișiere robot.txt pentru a direcționa Google către cele mai importante pagini.

Cel mai bun mod de a rezolva erorile noindex este să eliminați eroarea și să trimiteți din nou harta site-ului dvs. prin Google Search Console. Timpul necesar pentru a identifica erorile nonindex variază (de obicei, o scădere a traficului), motiv pentru care monitorizarea regulată a performanței site-ului este primordială.

2. Etichete Hreflang incorecte

Google a introdus etichetele Hreflang în 2011 pentru a-l ajuta să facă referințe încrucișate la pagini similare ca conținut, dar cu public țintă diferite (determinate de obicei de limbă). Ele nu cresc neapărat traficul, ci, în schimb, fac motoarele de căutare să schimbe versiunea corectă a unei pagini web în SERP-uri pentru a oferi conținutul potrivit utilizatorilor potriviți.

Mai jos este modul în care sunt scrise etichetele hreflang.

<link rel="alternate” hreflang="x” target="_blank" href="https://example.com/blog/de/article-name/” />

Sintaxa lor este împărțită în trei părți:

- link rel = „alternativă”: indică motorului de căutare că este o versiune alternativă a paginii.

- hreflang="x”: Specifică limba.

- target="_blank" href="https://example.com/blog/de/article-name: pagina alternativă în care se află adresa URL.

Având în vedere natura capricioasă a etichetelor hreflang, cele mai multe probleme sunt cauzate de greșeli de scriere și de utilizarea de coduri incorecte și de link-uri inexistente.

Dacă codul este incorect, roboții Google vor ignora pur și simplu atributul. Va trebui să revizuiți atributul etichetei hreflang pentru a detecta erorile pe care le puteți face folosind Google Search Console.

3. Site-uri web care nu sunt compatibile cu dispozitivele mobile

În 2019, Google a trecut la indexarea în primul rând pe mobil în mod implicit pentru toate site-urile web noi. Din punct de vedere istoric, a folosit în primul rând versiunea desktop a conținutului unei pagini atunci când se evaluează conținutul, cu toate acestea, mai mult de 50% din interogările de căutare globale provin de pe dispozitive mobile, așa că este mai logic să analizăm versiunea mobilă a oricărui conținut de site.

Site-urile web neadaptate pentru mobil nu se vor clasa la fel de sus în SERP-uri. Astăzi, a avea un site web prietenos cu dispozitivele mobile este unul dintre fundamentele tehnice SEO ale marketingului digital.

Puteți face multe pentru a vă face site-ul accesibil pentru utilizatorii de dispozitive mobile. Optimizarea imaginilor, a funcțiilor de căutare și a navigației pentru mobil sporește experiența utilizatorului.

De exemplu, utilizarea filelor derulante sau a meniurilor de navigare pentru hamburger simplifică călătoria cumpărătorului. Butoanele CTA ar trebui să fie ușor de făcut clic cu degetele, iar textul ar trebui să aibă dimensiunea adecvată pentru ecrane mai mici.

În ceea ce privește SEO tehnic, companiile pot folosi memorarea în cache în browser, pot reduce JavaScript și CCC, pot comprima imaginile pentru a reduce dimensiunea fișierului și pot utiliza paginile AMP ale Google pentru a se asigura că au urmat protocolul corect.

4. Conținut duplicat

După cum am menționat anterior, conținutul duplicat afectează negativ optimizarea motoarelor de căutare. Motoarele de căutare nu pot spune care versiune este originală, iar atunci când aleg duplicatul față de original, pierzi din echitatea linkului și puterea PageRank.

Dacă site-ul dvs. web conține mai multe pagini cu conținut în mare parte identic, există mai multe modalități de a indica adresele URL preferate.

- Canonicalizare : Acesta este procesul de utilizare a etichetelor canonice pentru a direcționa motoarele de căutare către paginile potrivite pentru indexare. În esență, ei spun boților ce pagini doriți să apară în SERP-uri.

- Utilizați 301s : un 301 este un cod de stare HTTP care semnalează o redirecționare permanentă de la o adresă URL la alta. Transmite toată puterea de clasare de la vechiul URL la cel nou.

- Fii consecvent : păstrează consecvența legăturilor tale interne și asigură-te că fiecare pagină are o adresă URL unică și curată.

- Sindicați cu atenție : estimările arată că până la 29% din web conține conținut duplicat. Nu este surprinzător având în vedere asemănarea paginilor produsului și sindicarea conținutului. Din acest motiv, ar trebui să vă asigurați că site-urile pe care este distribuit conținutul dvs. includ un link către pagina dvs. web originală.

- Minimizați conținutul similar : luați în considerare consolidarea paginilor similare. De exemplu, dacă aveți un magazin de comerț electronic care vinde tricouri de culori diferite, dar informațiile despre produs sunt practic aceleași, ar trebui să aveți o pagină de produs cu imagini diferite ale produsului.

Cea mai bună soluție pentru conținutul duplicat este să îl evitați cu totul și să creați conținut unic, bogat în cuvinte cheie pentru site-ul dvs. web și materialul de marketing afiliat.

5. Viteză mică a paginii

Timpii de încărcare a paginilor pe site-urile web cu mai puțin de 10.000 de pagini nu afectează prea mult rata de accesare cu crawlere, cu toate acestea, site-urile mari de comerț electronic care depășesc 10.000 au un impact masiv asupra accesării cu crawlere. Cu toate acestea, chiar dacă site-ul dvs. este mic, viteza paginii contează, deoarece este un factor de clasare în motorul de căutare.

Paginile care durează mai mult de trei secunde afectează experiența utilizatorului. Mai mult, oamenii vor deveni frustrați și vor abandona site-ul dvs. Astfel, o secundă poate face diferența între a face sau a pierde o vânzare!

Viteza lentă a paginii înseamnă potențial mai puține pagini accesate cu crawlere de Google, clasamente și conversii mai scăzute și rate de respingere mai mari. Puteți utiliza PageSpeed Insights de la Google pentru a determina ce trebuie îmbunătățit.

În general, există patru vinovați principali:

- Imagini mari care sunt dimensionate incorect sau nu sunt comprimate

- JavaScript nu este încărcat asincron

- Pluginuri greoaie sau scripturi de urmărire (cod care monitorizează fluxul de trafic pe site.)

- Nu utilizați o rețea de livrare de conținut (CDN).

Îmbunătățirea vitezei paginii web poate însemna mai multe lucruri, de la îmbunătățirea designului site-ului dvs. la redimensionarea imaginilor sau trecerea la un site web prietenos cu dispozitivele mobile. Soluția poate fi simplă sau mai complexă, inducând un efect compus în întregul site.

Totuși, indiferent de problemă, este vital să remediați problemele tehnice SEO legate de viteza paginii. Din când în când, este posibil să faceți acest lucru singur, dar în cele mai multe cazuri, va trebui să angajați un expert tehnic SEO, deoarece poate implica diferite grade de codare.

Cum să verificați dacă paginile dvs. web sunt indexate

Doar copiați adresa URL a paginii dvs. web din bara de adrese și inserați-o în Google. Dacă pagina dvs. web apare în rezultatele căutării, aceasta a fost indexată. Dacă nu apare nimic, nu a fost indexat.

Alternativ, puteți utiliza și instrumentul de inspecție URL de la Google. Acesta inspectează adresa URL a unei pagini și oferă informații despre descoperire, accesibilitate și indexabilitate.

Și amintiți-vă, doar pentru că conținutul web este indexat de Google nu înseamnă că este clasat.

Faptul că adresa dvs. URL este indexată de Google nu înseamnă neapărat că este clasată. Pentru ca o adresă URL să se clasifice, de multe ori este nevoie de mai mult decât doar faptul că Google a putut să o indexeze.

Paginile dvs. web trebuie să aibă conținut de înaltă calitate, care să satisfacă intenția utilizatorului și să îndeplinească cerințele tehnice ale motoarelor de căutare.

Rezervați o consultație gratuită

Cum tehnic SEO îmbunătățește redarea

Procesul de randare permite păianjenilor motoarelor de căutare să vadă aceleași pagini web pe care le faceți în browserul dvs. pe măsură ce se încarcă, adică din perspectiva unui vizitator. Toate motoarele de căutare trebuie să redeze pagini înainte de a le putea indexa.

În timp ce factorii externi intră în joc, baza pentru crearea unei experiențe de randare fluide este în mare parte responsabilitatea dezvoltatorului site-ului web și a SEO tehnic.

Optimizarea tehnică este o provocare, deoarece nu numai că backend-ul site-ului dvs. (ceea ce utilizatorii nu văd online) trebuie să fie codificat într-un mod care să faciliteze accesul cu crawlere, indexarea și randarea motoarelor de căutare, dar trebuie și să funcționeze. mai bun și mai rapid decât concurenții tăi.

Cum să ajutați Google să vă redeze corect site-ul

1. Nu folosiți prea mult JavaScript

O scurtă explicație despre HTML, CSS și JavaScript:

- HTML : Un sistem de formatare folosit pentru a afișa materialul preluat de pe internet. HTML oferă structura de bază a site-urilor modificate de tehnologii precum JavaScript și CSS.

- CSS : Acronim pentru Cascading Style Sheets, CSS este o tehnologie care controlează prezentarea, formatarea și aspectul unui site web.

- JavaScript : un limbaj de script bazat pe text folosit pentru a controla comportamentul diferitelor elemente de pe paginile web.

Redarea JavasScript durează mai mult, ceea ce afectează bugetul de accesare cu crawlere, ceea ce înseamnă că este nevoie de mai mult timp pentru accesarea cu crawlere și indexarea paginilor web. Există multe motive pentru care JavaScript poate împiedica redarea corectă a site-ului dvs. web.

Una dintre cele mai frecvente este atunci când fișierele JavaScript sunt blocate de fișierele robots.txt. Acest lucru împiedică Google și alte motoare de căutare să înțeleagă pe deplin despre ce este vorba site-ul dvs.

Din punct de vedere tehnic SEO, puteți reduce codul, comprima activele site-ului web și puteți distribui active statice cu un CDN care le servește de pe un server mai aproape de utilizatorii site-ului dvs. Acest lucru poate reduce latența de descărcare a paginii.

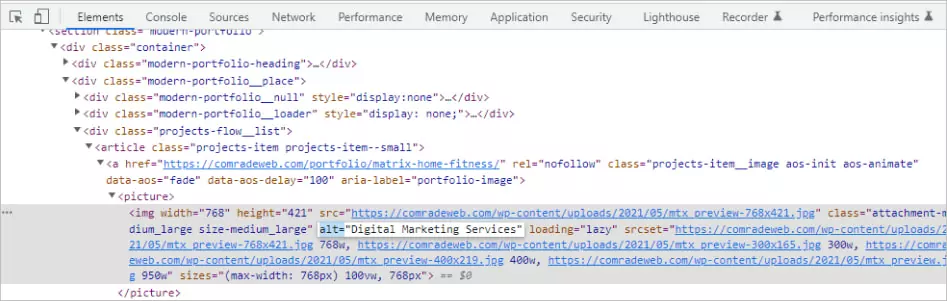

2. Folosiți Atribute Alt

Optimizarea imaginii este adesea trecută cu vederea atunci când vine vorba de optimizarea motoarelor de căutare, dar îmbunătățește viteza de încărcare a paginii și experiența utilizatorului, sporind în același timp clasamentul SERP.

Etichetele Alt sunt de o importanță deosebită, deoarece ajută la afișarea textului atunci când o imagine nu poate fi redată de un browser din cauza unor erori tehnice, cum ar fi conexiunea slabă a lățimii de bandă.

În schimb, ele descriu textual ceea ce ar trebui să arate imaginea. Dacă site-ul dvs. nu are atribute alt, motoarele de căutare nu vor avea idee ce a fost menită să afișeze imaginea dvs.

Există o tehnică pentru a scrie un text alternativ bun. De exemplu, să presupunem că aveți o imagine a unei pisici care se joacă cu o minge de sfoară.

- Descriere proastă: pisica care se joacă

- Descriere bună: pisica neagră care se joacă cu o minge de sfoară

Descrieți întotdeauna imaginile cât mai obiectiv posibil. Furnizați context, dar nu folosiți expresii precum „imaginea cu” sau „imaginea cu” și evitați umplerea cuvintelor cheie.

Puteți folosi chiar și etichete alt pentru butoane. Astfel de descrieri ar putea citi ceva de genul „aplicați acum” sau „obțineți o ofertă”.

Câteva sfaturi pentru SEO: evitați să folosiți imagini în loc de cuvinte. Motoarele de căutare nu pot „citi” așa cum pot oamenii, așa că folosirea unei imagini în locul textului real este confuză pentru crawlere și poate afecta clasamentele.

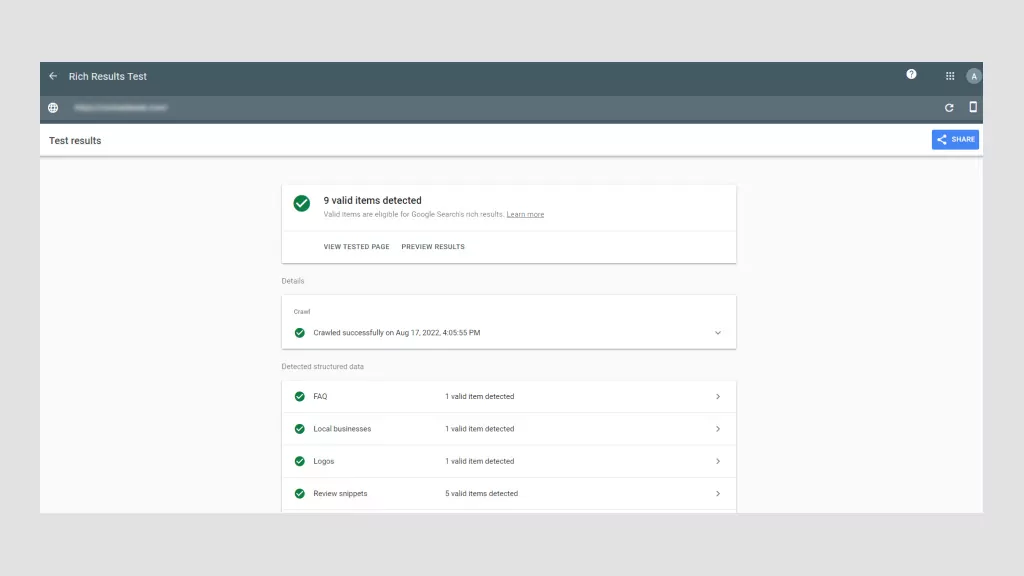

3. Utilizați Schema Data

Datele structurate sunt informații organizate la nivel de cod în conformitate cu reguli, linii directoare și vocabulare specifice. Acesta comunică informații specifice paginii, astfel încât motoarele de căutare să le poată reda și indexa corect.

Modul în care sunt implementate datele structurate este sub forma de marcare a schemei. Odată adăugat la o pagină web, marcajul schemei oferă o definiție și o structură mai clare conținutului site-ului. Este, în esență, o modalitate de a vă descrie site-ul motoarele de căutare folosind un vocabular specific de cod.

În special pentru Google, face ca conținutul dvs. să fie afișat mai mult ca un rezultat bogat sau ca fragment recomandat, care sunt liste de pagini îmbogățite cu elemente vizuale sau interactive suplimentare care le fac să iasă în evidență.

Rezultatele bogate apar în partea de sus a SERP-urilor deasupra rezultatelor text tradiționale. Așadar, chiar dacă pagina dvs. nu se clasează pe primul loc, folosind datele schemei, site-ul dvs. poate fi în continuare primul lucru pe care utilizatorii îl văd pe SERP-uri.

De exemplu, să presupunem că vindeți cărți online. Cu marcarea corectă a schemei, puteți afișa autorul, un rezumat și stelele de recenzie ca un fragment bogat. Există tot felul de date structurate pe care le puteți folosi pentru filme, recenzii, întrebări frecvente, rețete și multe altele, de exemplu.

Datele structurate sunt importante pentru SEO tehnic, deoarece facilitează ca Google și alte motoare de căutare să înțeleagă despre ce sunt paginile dvs. web. În plus, vă crește rata de clic, ceea ce duce la creșterea traficului și la clasamente chiar mai ridicate.

4. Evitați greșelile de cod HTML

Prea multe erori HTML împiedică crawlerele de căutare să analizeze (analizeze) conținutul web și îi determină să părăsească prematur paginile web.

- Utilizarea meniurilor Flash sau JavaScript fără HTML : scriptul de meniu al site-ului dvs. web ar trebui să conțină alternative HTML, astfel încât browserele fără capacitatea de a traduce Flash sau JavaScript pot permite totuși utilizatorilor să navigheze în paginile dvs. Dacă un crawler nu poate „citi” link-uri din cauza Flash sau JavaScript, acestea nu vor avea nicio valoare. Astfel, meniurile HTML fac paginile tale web mai compatibile.

- Utilizarea adreselor URL cu caractere „nesigure” : motoarele de căutare se străduiesc să redeze adrese URL cu simboluri speciale precum „&” sau „%”. Aceste tipuri de caractere sunt nesigure din diferite motive, dar este probabil pentru că au utilizări comune în diferite sisteme de codare, determinând motoarele de căutare să interpreteze greșit sensul lor, ceea ce poate rupe adresa URL.

- Etichete de titlu slabe și etichete meta : etichetele de titlu ar trebui să conțină cuvântul cheie țintă al paginii web, în timp ce etichetele meta ar trebui să explice succint despre ce este vorba în pagină. Ambele etichete sunt critice pentru optimizarea SEO pentru motoarele de căutare. Primul îmbunătățește clasarea, în timp ce al doilea încurajează clicurile. Etichetele de titlu nu trebuie să depășească 76 de caractere, în timp ce etichetele de descriere trebuie să aibă mai puțin de 156 de caractere.

HTML este mai degrabă tehnic, dar, din fericire, există pluginuri SEO tehnice care vă ajută să implementați etichetele corecte fără să știți cum să codificați ca un profesionist. Yoast și Moz sunt standarde din industrie, folosite de profesioniști pentru a asigura HTML perfect.

Lista de verificare tehnică SEO: Cum să îmbunătățiți SEO tehnic

Dacă sunteți serios în privința îmbunătățirii SEO tehnic, trebuie să efectuați un audit SEO tehnic. Gândiți-vă la asta ca la un control de sănătate pentru site-ul dvs.

A fi neglijent în ceea ce privește SEO tehnic poate duce la scăderea traficului și a veniturilor.

Vă recomandăm să efectuați un audit mini-site în fiecare lună și un audit tehnic la scară largă la fiecare patru până la cinci luni.

Pasul 01: Analizați-vă navigarea

Boții Google ar trebui să poată accesa cu crawlere și indexa toate paginile site-ului dvs., inclusiv breadcrumbs și harta site-ului XML a site-ului dvs. Indiferent de tipul de navigare pe care îl are site-ul dvs. web, acesta trebuie să aibă o structură URL curată.

De exemplu, doriți să aveți o structură logică a paginii părinte-copil. Să presupunem că conduci un magazin de decorațiuni pentru casă. O adresă URL părinte ar putea fi: https://lovemyhome.com/bedroom și să conțină pagini cu mobilier și decor pentru dormitor. Prin urmare, adresa URL a unui copil ar putea arăta astfel: https://lovemyhome.com/bedroom/side-tables.

De asemenea, doriți să evitați paginile orfane. Aceasta se întâmplă atunci când o pagină de site nu este legată de nicio altă pagină sau secțiune de pe site-ul dvs. Comunica motoarelor de căutare că nu este important.

Apoi, când vine vorba de navigarea primară, nu uitați să includeți paginile dvs. de servicii și soluții și nu introduceți mai mult de 30 de link-uri în aceste pagini pentru a păstra sucul de link-uri.

Există două componente pentru auditarea arhitecturii site-ului. Primul are de-a face cu factori tehnici, cum ar fi repararea legăturilor întrerupte, iar al doilea are de-a face cu experiența utilizatorului. Software-ul Google face relativ ușor să conduci primul.

However, when it comes to UX, human feedback helps. If you're struggling to view your website with fresh eyes, ask family and friends to review it. The less they know about UX, the better, as they more than likely represent everyday users.

Ask yourself (and them):

- Is my website clear?

- Does my main navigation bar link to the most important pages?

- Is it easy for visitors to contact me?

- Can a visitor understand what my business is about and how I can help them just by visiting my website?

Step 02: Check for Duplicate Content

Using top-tier software like SEMRush, Moz or Screamingfrog is the best way to check for duplicate content. These SEO review tools will flag both external and internal content for specific web pages.

If you're tempted to copy and paste sentences from your web copy into Google Search to see if other URLs pop up, don't. This isn't accurate and unnecessarily wastes precious time when there are far more sophisticated options available.

As we mentioned earlier, roughly 30% of all webpage content is duplicated. So, as always, the more original your content the better. Try to keep your duplicate content below this threshold.

Lastly, you'll want to eliminate boilerplate content. This is when the same content is present on different website pages, like terms and conditions, for example. In this instance, it's better to create a single webpage for T&Cs and ensure all the other pages have internal links to it.

Step 03: Check Site Speed and Mobile-Optimization with Google

You can use Google's PageSpeed Insights to ensure your website is fast on all devices. Google's software scores your website speed out of 100. What's important to remember is that page speed is somewhat relative in the sense that people using a mobile on a 3G connection will experience “slowness” for every website they're using.

Additionally, there is also a trade-off between speed and user experience. Some page elements will impact page speed. Of course, you should aim for the fastest speed possible, so long as you're aware, which we're sure you are after reading this article, that many factors affect search engine optimization SEO.

In terms of site speed analysis, it's handy to analyze your competitors' site speeds, so you know what you're up against and can benchmark your results.

As for mobile optimization, Google also has a Mobile-Friendly Test that live-tests your URL. Its detailed report suggests improvement recommendations and directs you to Google Search Console for in-depth analysis and help.

Step 04: Collect and Redirect “Useless Pages”

None of your web pages should be useless. If they are, you need to get rid of them, especially if they're placeholder pages. These look unprofessional and are bad for SEO. It's honestly better to just launch your website when it's ready.

Any web pages “under construction” with zero content won't rank highly. What's more, if they rank for keywords people are searching for, and they don't offer value, your business immediately loses credibility. They serve no navigational purpose and get ignored by Google bots.

However, some web pages are useful for customers but not for Google in terms of pagination or index filters:

- Landing pages for ads

- Thank-you pages

- Privacy and policy pages

- Admin pages

- Duplicate pages

- Low-value pages (eg, outdated content that may still be valuable)

You can either use a nonindex meta tag or a robots.txt file to prevent Google from indexing these pages. It can take time for Google to instigate these changes. Pages that still appear in results despite noindex directives may not have been crawled since your request. You can ask Google to recrawl these pages by using the Fetch As Googlebot.

Step 05: Check Structured Data

The only way to conduct a structured data audit is with software tools like Google Search Console, Screaming Frog, and Site Bulb. It's possible to do it manually, but we don't recommend this unless you are a technical SEO and/or have loads of time on your hands.

Using Google Search Console will tell you which pages have errors and identify where and/or how the error is occurring. But like any audit, structure data audits are about fixing errors and discovering SEO opportunities.

When conducting a structured data audit you'll want to determine if any data is broken and if there's anything more you can do. For example, if an eCommerce store has implemented a product review markup, but some products have fewer ratings, they might decide to remove the markup and avoid reputational damage until they've improved the product.

Top FREE Tools to Check Your Technical SEO

Every technical SEO specialist worth their salt knows how to conduct an SEO audit manually. However, it's tedious and, given the tools on the market, unnecessary. Below are the tools we'd use to perform a high-quality technical SEO audit.

Google Search Console

This is hands down the best free-side audit tool. Google Search Console analyzes your website the same way that Google does with its bots. This feature alone makes it indispensable. With it, you can: monitor indexing and crawling, identify and fix errors, request indexing, update pages, and review all links.

Google Page Speed

This tool allows you to test web page speed. It is also so simple to use. All you need to do is enter the page's URL and hit “analyze.” Google Page Speed's detailed reports come with a personalized Optimization Score and a list of prioritized suggestions to improve running speed.

Google's Structured Data Markup Helper

Compatible with the majority of search engines, Google's Markup Helper helps you mark up different types of structured data on your website. This tool identifies missing fields that need to be filled in to correct the markup of your structured data. It offers a wide range of markup types and offers the possibility to generate rich snippets.

Ahrefs

The only caveat with Ahrefs is you won't have full functionality unless you pay for a subscription, and have to connect your website to it, unlike Google, where you just copy and paste URLs. Otherwise, it's useful to fix technical errors, submit sitemaps, and see structured data issues.

Ubersuggest

While Ubersuggest is mainly used for keyword research, it can perform full-scale audits to check your website for critical errors, warnings, and recommendations. What's great about Ubersuggest is that it pinpoints areas that need urgent attention and prioritizes them accordingly.

Rezervați o consultație gratuită

Hire the Best SEO Professionals

Technical SEO and audits are mandatory for new and established websites. It's normal to encounter technical SEO issues, most of which are easy to fix. However, you still need the technical know-how. This is where working with an SEO professional can save you time and help avoid costly delays.

Is your technical SEO up to date? If not, we'll conduct a free SEO audit to identify underlying issues and offer recommendations. As a full-service digital marketing agency, we've improved our clients' traffic by 175% on average! Call us today to fix your technical SEO issues.