Por que o SEO técnico é importante?

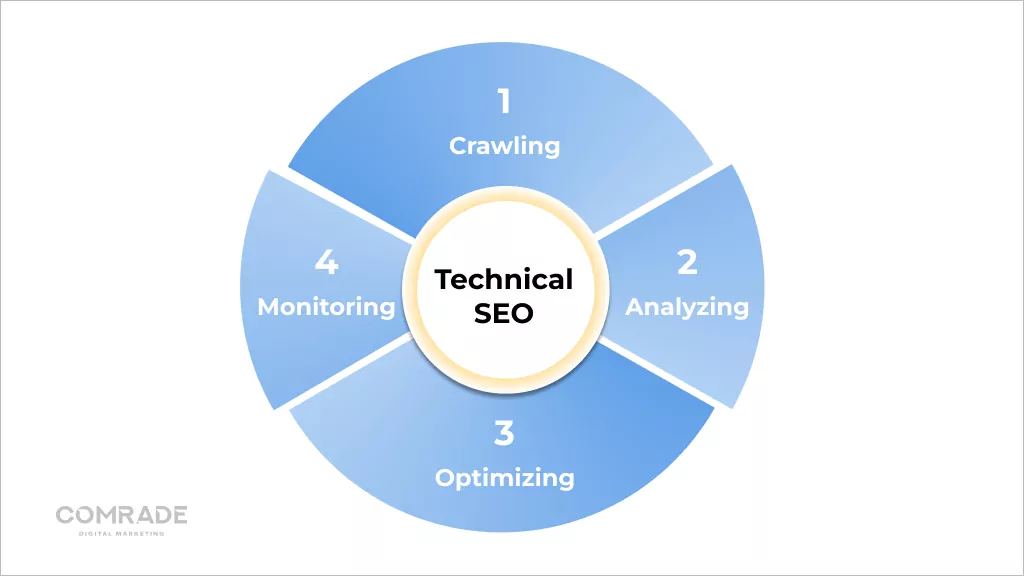

Publicados: 2022-08-03Como parte de um pacote de serviços de SEO, o SEO técnico lida com os componentes técnicos de um site, como mapas do site, velocidade da página, URL, esquema, navegação e muito mais.

Conclusão: todo negócio online precisa de um site totalmente otimizado para atrair leads qualificados. O SEO técnico torna seu site rápido, compatível com dispositivos móveis, fácil de usar e confiável.

Neste blog, explicamos os fundamentos técnicos de SEO, para que você possa otimizar seu site e, mais importante, saber como conversar com sua equipe de marketing sobre essa faceta fundamental da otimização de mecanismos de pesquisa.

SEO técnico e mecanismos de pesquisa: como funciona

Os mecanismos de pesquisa são programas de software projetados para ajudar as pessoas que usam palavras-chave ou frases a encontrar as informações que estão procurando online.

O Google diz que sua missão é “organizar as informações do mundo e torná-las universalmente acessíveis e úteis. É por isso que a Pesquisa facilita a descoberta de uma ampla variedade de informações de uma ampla variedade de fontes.”

Seus algoritmos de propriedade recuperam as fontes de dados mais relevantes e respeitáveis possíveis para apresentar aos usuários da Internet.

Tecnicamente, o processo funciona assim:

Rastejando

Sofisticados softwares chamados web crawlers de mecanismos de busca, também chamados de “robôs” ou “spiders”, vasculham a internet em busca de conteúdo/URLs. Eles rastrearão um site baixando seu arquivo robots.txt, que contém regras sobre quais URLs um mecanismo de pesquisa deve rastrear.

Como não há um registro centralizado de todas as páginas da web existentes, mecanismos de pesquisa como o Google procuram constantemente páginas novas e atualizadas para adicionar à sua lista de páginas conhecidas. Isso é chamado de "descoberta de URL".

Mais de 547.200 novos sites são criados globalmente todos os dias, daí a importância dos Googlebots rastrearem constantemente a web!

Os spiders também rastreiam páginas conhecidas pelos mecanismos de pesquisa para determinar se alguma alteração foi feita. Em caso afirmativo, eles atualizarão o índice em resposta a essas alterações. Por exemplo, quando uma loja de comércio eletrônico atualiza suas páginas de produtos, ela pode ser classificada para novas palavras-chave.

Os rastreadores da Web calculavam a frequência com que uma página da Web deveria ser rastreada novamente e quantas páginas em um site deveriam ser indexadas por meio de seu orçamento de rastreamento. Isso é determinado pelo limite da taxa de rastreamento e pela demanda de rastreamento.

Devido aos recursos limitados, os Googlebots precisam priorizar seu esforço de rastreamento, e atribuir um orçamento de rastreamento a cada site os ajuda a fazer isso. Se o SEO técnico de um site estiver atualizado, é mais rápido rastrear, aumentando o limite de rastreamento (o número de páginas que um bot rastreia em um determinado período de tempo).

Por outro lado, se um site ficar lento devido a um SEO técnico ruim, os Googlebots rastreiam menos. Logicamente, não faz sentido rastrear um site com SEO técnico ruim, pois não fornecerá uma experiência positiva ao usuário, o que vai contra os principais objetivos do Google.

No entanto, o Google publicou o seguinte sobre o orçamento de rastreamento:

“Orçamento de rastreamento... não é algo com o qual a maioria dos editores precisa se preocupar... novas páginas tendem a ser rastreadas no mesmo dia em que são publicadas. O orçamento de rastreamento não é algo em que os webmasters precisam se concentrar.”

Páginas mais recentes ou que não estão bem vinculadas ou atualizadas podem ser afetadas pelo orçamento de rastreamento. No entanto, na maioria dos casos, um site com menos de 1.000 URLs atualizados regularmente será rastreado com eficiência na maioria das vezes.

Renderização

Renderização é a codificação gráfica de informações em páginas da web. Em termos leigos, é o processo de “pintar texto e imagens na tela” para que os mecanismos de busca possam entender do que se trata o layout de uma página da web.

Os mecanismos de pesquisa extraem o código HTML do site e o traduzem em blocos de texto, imagens, vídeos e outros elementos. A renderização ajuda os mecanismos de pesquisa a entender a experiência do usuário e é uma etapa necessária para responder a perguntas relevantes relacionadas à indexação e classificação.

Indexação

Depois que uma página é renderizada, o Google tenta entender do que se trata. Isso se chama indexação. Durante esse processo, o Google analisa o conteúdo textual (informações) das páginas da web, incluindo as principais tags de conteúdo, palavras-chave, atributos alternativos, imagens, vídeos etc.

Também analisa a relação entre diferentes páginas e sites seguindo links externos e internos, bem como backlinks. Portanto, quanto melhor você fizer o trabalho de tornar seu site fácil de entender (investindo em SEO técnico), maiores serão as chances de o Google indexar suas páginas.

Os links são como caminhos neurais da internet conectando páginas da web. Eles são necessários para que os robôs entendam as conexões entre as páginas da web e ajudem a contextualizar seu conteúdo. No entanto, os bots de pesquisa não seguem todos os URLs em um site, apenas aqueles com links dofollow (links de outros sites que apontam para o seu e fortalecem a autoridade do domínio).

Daí a importância do link building. Quando links externos vêm de domínios de alta qualidade, eles fortalecem o site ao qual estão vinculados, aumentando seus rankings SERP. No entanto, quando os rastreadores encontram uma página da Web, eles processam o conteúdo da página e acompanham tudo – desde palavras-chave até a atualização do site – no índice de pesquisa do Google.

Esse índice é essencialmente uma biblioteca digital de trilhões de páginas da web. Então, curiosamente, quando você digita uma consulta em um mecanismo de pesquisa, você não está pesquisando diretamente na web; você está realmente pesquisando o índice de páginas da web de um mecanismo de pesquisa.

Classificação

Quando um usuário digita uma consulta, o Google precisa determinar quais páginas em seu índice correspondem melhor ao que o usuário está procurando. Existem mais de 200 fatores de classificação que podem ser resumidos em cinco categorias principais:

- Significado da consulta : o algoritmo do Google analisa a intenção da pergunta de um usuário usando ferramentas de linguagem complexas criadas em pesquisas anteriores e comportamento de uso.

- Relevância da página da Web : O principal determinante da relevância da página da Web é a análise de palavras-chave. As palavras-chave em um site devem corresponder ao entendimento do Google sobre a consulta que um usuário faz.

- Qualidade do conteúdo : depois que o Google combina palavras-chave de várias páginas da Web, ele analisa a qualidade do conteúdo, a autoridade do site, o PageRank individual e a atualização para priorizar a classificação das páginas.

- Usabilidade da página da Web : As páginas fáceis de usar recebem prioridade. A velocidade do site, a capacidade de resposta e a compatibilidade com dispositivos móveis desempenham um papel importante.

- Contexto e configurações adicionais : por último, o algoritmo do Google levará em consideração o envolvimento anterior do usuário e as configurações específicas do mecanismo de pesquisa. Alguns sinais incluem o idioma da página e o país para o qual o conteúdo é direcionado.

Se você deseja mais tráfego e classificação mais alta no Google e em outros mecanismos de pesquisa, deve prestar atenção ao SEO técnico.

Como o SEO técnico melhora o rastreamento e a indexação de sites

No nível mais elementar, os mecanismos de pesquisa precisam encontrar, rastrear, renderizar e indexar as páginas do seu site. Portanto, melhorar os aspectos técnicos, ou seja, o SEO técnico, deve resultar em classificações mais altas nos resultados de pesquisa.

Como melhorar o rastreamento de sites

A eficiência do rastreamento refere-se à facilidade com que os bots podem rastrear todas as páginas do seu site. Uma estrutura de URL limpa, servidores confiáveis, mapas de site precisos e arquivos robots.txt melhoram a eficiência do rastreamento.

1. Configure Robots.txt

Um arquivo robots.txt contém diretivas para mecanismos de pesquisa e é usado principalmente para informar aos rastreadores quais URLs eles devem explorar.

Embora isso pareça contrário aos objetivos de SEO de impedir que as páginas sejam rastreadas, é útil se você estiver criando um novo site e tiver várias versões da mesma página e desejar evitar ser penalizado por conteúdo duplicado.

Você também pode usar um arquivo robots.txt para evitar que os servidores sejam sobrecarregados quando os rastreadores carregam vários conteúdos de uma só vez, bem como bloquear a indexação de páginas privadas.

Se o seu site for grande e você estiver com dificuldades para indexar todas as suas páginas, um arquivo robot.txt ajudará os bots a gastar tempo em páginas importantes.

2. Escolha uma boa hospedagem

A hospedagem afeta a velocidade do site, o tempo de inatividade do servidor e a segurança, que influenciam o desempenho técnico de SEO. Um bom host é confiável, disponível e vem com suporte ao cliente eficiente.

Sabemos que a hospedagem de sites é cara, mas a verdade é que você recebe o que paga. Vimos clientes cometerem erros comuns, como optar por brindes, que vêm com um influxo de anúncios pop-up que diminuem o tempo de carregamento da página ou selecionam uma opção mais barata que compromete a segurança dos dados.

Os hosts da web confiáveis garantem 99,9% de tempo de atividade. Portanto, seu host deve ter servidores potentes com uma infraestrutura resiliente. Uma solução de hospedagem adequada garante a segurança, acessibilidade e confiabilidade de seus serviços online.

Obtenha uma auditoria de desempenho de SEO digital gratuita e sem compromisso.

solicitar auditoria

3. Excluir páginas inúteis e redundantes

O Search Engine Land publicou recentemente um artigo sobre a impossibilidade iminente de o Google indexar todas as páginas de todos os sites.

Isso não é necessariamente uma desgraça e tristeza, já que páginas da web de baixa qualidade não deveriam estar realmente nos resultados dos mecanismos de pesquisa de qualquer maneira, porque elas não fornecem nenhum valor aos visitantes e desperdiçam o precioso tempo de um bot de pesquisa (orçamento de rastreamento).

Apesar disso, muitas vezes nos deparamos com o inchaço do Índice, principalmente em sites de comércio eletrônico com grandes estoques de produtos e avaliações de clientes.

Normalmente, os spiders dos mecanismos de pesquisa indexam essas páginas indesejáveis e corroem as pontuações de relevância, o que pode fazer com que o Google ignore páginas mais importantes.

Portanto, realizar auditorias regulares de página e manter um site limpo garante que os bots indexem apenas URLs importantes.

4. Evite páginas duplicadas

Páginas duplicadas diluem o valor do link e confundem os mecanismos de pesquisa porque eles não sabem quais páginas da Web classificar, o que significa que você normalmente acaba competindo contra si mesmo nas SERPs. Se você tiver páginas duplicadas em seu site, é provável que ambas as páginas tenham um desempenho insatisfatório.

O conteúdo duplicado ocorre tanto no local quanto fora do local. O conteúdo duplicado fora do site é difícil de controlar. Para se livrar de conteúdo duplicado fora do site (geralmente material de marketing de conteúdo, como blogs ou páginas de produtos), você pode enviar um relatório de violação de direitos autorais ao Google solicitando que ele remova a página duplicada de seu índice.

Na maioria dos casos, o conteúdo duplicado no site não é uma tentativa maliciosa de manipular as classificações do mecanismo de pesquisa, mas sim devido à arquitetura e desenvolvimento de sites ruins (consulte: seção de indexação para obter mais detalhes).

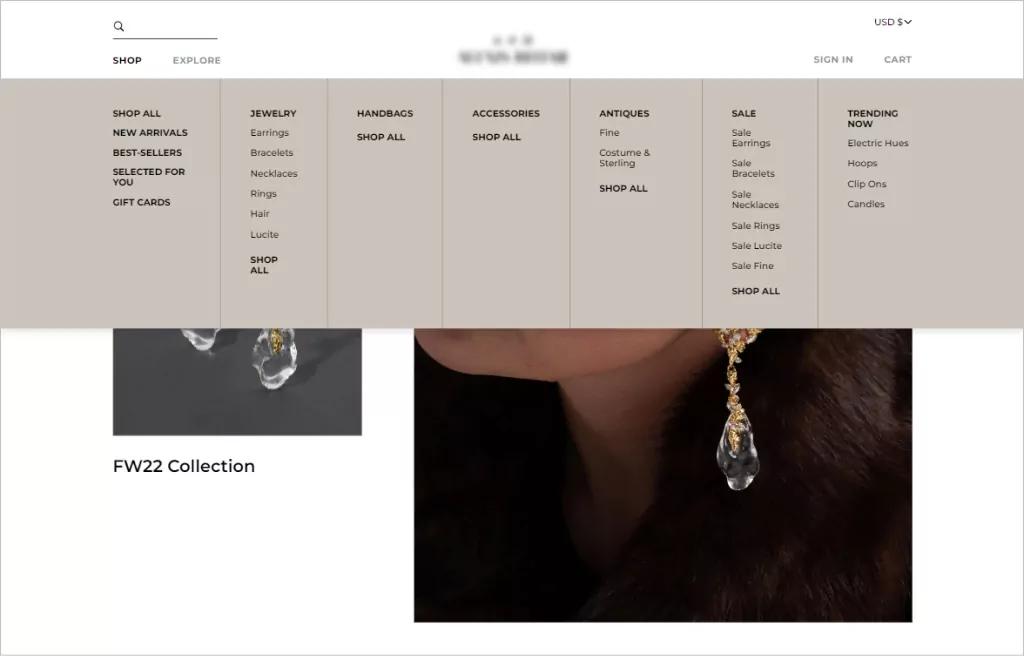

5. Implemente a navegação simples no site (para usuários e robôs)

Quando falamos sobre navegação no site, estamos nos referindo à estrutura e hierarquia de links de um site. Uma boa navegação no site leva os usuários onde eles precisam estar com o menor número de cliques possível.

Como regra geral, a estrutura de URL do seu site deve permitir que os visitantes acessem qualquer página e encontrem o que precisam em três cliques. Além de uma estética de design consistente, os menus de navegação que funcionam melhor têm uma estrutura hierárquica clara, com subcategorias clicáveis incluídas no menu, se necessário.

A ordem é importante quando se trata de navegação. É mais provável que os usuários se lembrem do primeiro e do último itens do menu. Portanto, a maioria das estruturas de navegação do site de comércio eletrônico começa com uma página de loja e termina com uma chamada para ação, como um botão de checkout.

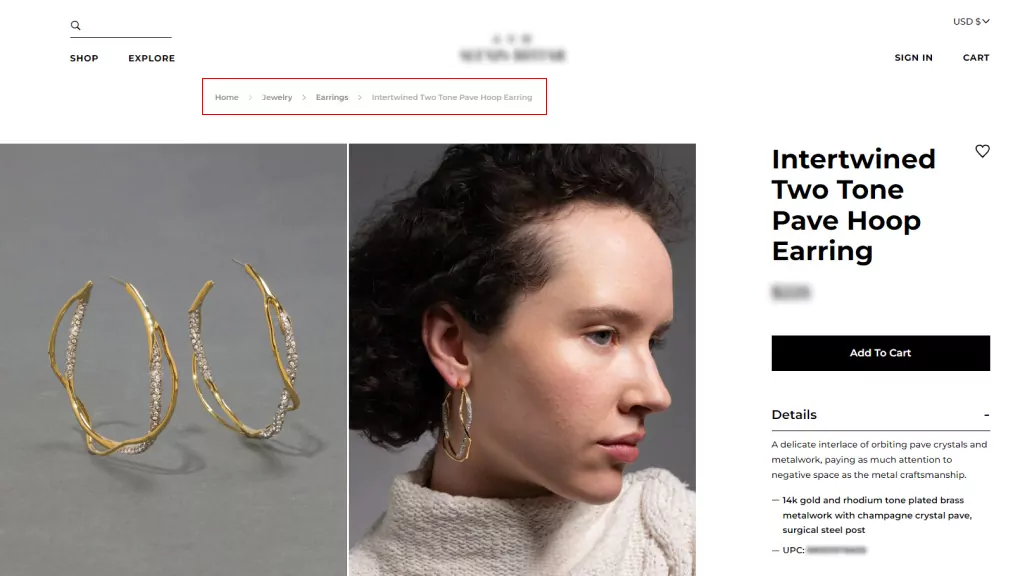

6. Use farinha de rosca

Breadcrumbs são sistemas de navegação secundários que mostram a localização de um usuário em um site. Eles simplificam a navegação para sites de comércio eletrônico complexos com muitas categorias e páginas de variação de produtos e são especialmente úteis quando os usuários chegam a um site por meio de um link externo que não leva à página inicial.

Breadcrumbs complementam os menus de navegação principais, mas não podem substituí-los. Existem dois tipos de pão ralado:

- Baseado em localização, que ajuda os usuários a identificar sua localização atual na estrutura do site; e

- Baseado em atributos, que ajuda os usuários a identificar qualidades importantes da página que está sendo visualizada.

O uso de breadcrumbs incentiva as pessoas a visitar mais páginas do site e reduz a taxa de rejeição, o que é bom para o SEO em geral. No entanto, você só os usará se a estrutura do seu site for complexa e precisar melhorar a capacidade do usuário de navegar entre as páginas da categoria.

7. Forneça um Sitemap.xml

Um mapa do site é um arquivo que lista todas as páginas da web do seu site que você deseja que os mecanismos de pesquisa conheçam e considerem a classificação. Embora os sitemaps não sejam pré-requisitos para ter um site, eles são altamente recomendados porque produzem um rastreamento eficaz do site.

Os Sitemaps são ótimas adições para novos sites, com backlinks limitados, que precisam ser indexados, bem como sites grandes onde as páginas podem ser ignoradas se os metadados não forem atualizados com precisão. O mesmo vale para sites de arquivo onde as páginas da web não se ligam naturalmente umas às outras.

Ter um mapa do site fornece aos mecanismos de pesquisa um guia útil para entender sobre o que é seu site e como suas páginas estão vinculadas. Assim, aumenta o SEO, os rankings e o tráfego.

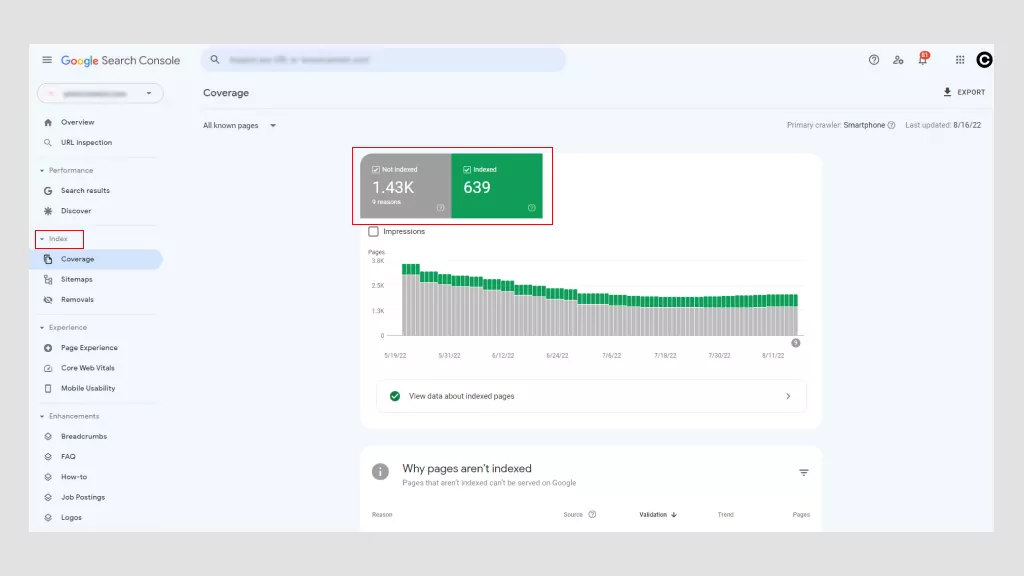

Como verificar e corrigir o problema de rastreamento do seu site

Usar o Google Search Console é a melhor maneira de determinar se seu site tem algum problema de rastreamento. Existem outras ferramentas também, mas o principal benefício é que o Google é gratuito. Com o Google Search Console, você pode acessar “Erros de rastreamento” no painel principal.

O Google divide esses erros em duas categorias: Erros de site e erros de URL. Os problemas no nível do site são mais preocupantes porque podem prejudicar a usabilidade de todo o site, enquanto os erros de URL são específicos de páginas individuais e menos problemáticos, embora ainda devam ser corrigidos.

1. Possíveis Erros do Site

- Erros de DNS : ocorre quando um Googlebot não consegue se conectar ao seu nome de domínio devido a um problema de tempo limite ou de pesquisa. Para corrigir isso, verifique suas configurações de DNS. O problema pode ser configurações de DNS mal configuradas, uma conexão de internet ruim ou um navegador desatualizado.

- Erros de conectividade do servidor : Normalmente, quando um site demora muito para responder, a solicitação atinge o tempo limite. Isso significa que o Googlebot se conectou ao seu site, mas não conseguiu carregar a página devido a uma alteração na configuração da rede, desconexão do Wi-Fi ou cabo de rede desconectado.

- Erros de busca do robots.txt : ocorre quando um Googlebot não consegue recuperar um arquivo robots.txt. Atualizar o arquivo robots.txt e permitir que os bots rastreiem novamente suas páginas devem resolver esse problema.

2. Possíveis erros de URL

- Não encontrado (404) : se o Google tentar rastrear uma página que não existe mais, ele exibirá um erro 404. Uma maneira simples de corrigir isso é redirecionar a página para outra.

- Não seguido : é quando um bot não consegue seguir completamente os URLs do seu site. JavaScript, cookies, IDs de sessão, DHTML ou Flash são possíveis culpados.

- 500 internal server error : Na maioria das vezes, esses erros ocorrem quando um servidor da Web está sobrecarregado e são resolvidos entrando em contato com o provedor de hospedagem da Web. Se por acaso você estiver executando um site WordPress, convém verificar os plugins de terceiros.

Fale com especialistas

Como verificar e corrigir os problemas de indexação do seu site

A indexação é a maneira do Google de coletar e processar todos os dados de suas páginas da web quando ele rastreia a web. Ele permite que os mecanismos de pesquisa otimizem a velocidade e o desempenho ao combinar as consultas dos usuários com informações relevantes. Como tal, o Google exibe páginas de resultados em segundos!

O Google usa um sistema de indexação em camadas em que o conteúdo mais popular é indexado em armazenamento mais rápido e mais caro. Daí a importância do conteúdo rico em palavras-chave.

Problemas comuns de indexação que os webmasters enfrentam e suas soluções incluem:

1. Erros Sem Índice

É possível impedir que spiders (bots) rastreiem uma página incluindo uma metatag ou cabeçalho noindex na resposta HTTP. Quando um Googlebot encontra essa tag, ele retira a página dos resultados da Pesquisa Google, independentemente de outros sites terem links para ela.

Há boas razões para usar uma tag noindex em uma página da web ou em parte dela, por exemplo:

- Para evitar conteúdo duplicado.

- Para manter as páginas de administração e login apenas para uso interno.

- Para evitar que páginas de destino pagas sejam indexadas. Se você estiver executando uma campanha de captura de leads, não precisará de centenas de páginas de agradecimento duplicadas para serem indexadas.

Uma tag não indexada ajuda a definir conteúdo valioso e selecionado de outras páginas, garantindo que as páginas mais importantes estejam disponíveis em SERPs. No entanto, erros não indexados têm consequências negativas, especialmente quando você deseja que uma página seja indexada.

Se o Google rastreia uma página, mas não a indexa, isso pode significar duas coisas. Ou a página é de baixa qualidade ou há muitos URLs na sugestão de rastreamento e o mecanismo de pesquisa não tem orçamento suficiente para passar por eles.

Devido ao boom do comércio eletrônico, é comum que as páginas de produtos apresentem erros não indexados. Para combater isso, certifique-se de que as páginas do produto sejam exclusivas (não copiadas de fontes externas), implemente tags canônicas para consolidar conteúdo duplicado e use tags noindex para impedir que o Googlebots indexe seções de baixa qualidade do seu site.

Se você tiver problemas de não indexação devido a muitos URLs, convém otimizar seu orçamento de rastreamento usando arquivos robot.txt para direcionar o Google para as páginas mais importantes.

A melhor maneira de resolver erros noindex é remover o erro e reenviar o mapa do site do seu site por meio do Google Search Console. O tempo que leva para identificar erros não indexados varia (normalmente um declínio no tráfego), e é por isso que o monitoramento regular do desempenho do site é fundamental.

2. Tags Hreflang incorretas

O Google introduziu as tags Hreflang em 2011 para ajudá-lo a fazer referência cruzada de páginas semelhantes em conteúdo, mas com diferentes públicos-alvo (geralmente determinados pelo idioma). Eles não necessariamente aumentam o tráfego, mas, em vez disso, fazem com que os mecanismos de pesquisa troquem a versão correta de uma página da Web em SERPs para fornecer o conteúdo certo aos usuários certos.

Abaixo está como as tags hreflang são escritas.

<link rel=”alternate” hreflang=”x” target="_blank" href=”https://example.com/blog/de/article-name/” />

Sua sintaxe é dividida em três partes:

- link rel = “alternative”: Indica ao buscador que é uma versão alternativa da página.

- hreflang="x": Especifica o idioma.

- target="_blank" href="https://example.com/blog/de/article-name: a página alternativa onde está o URL.

Dada a natureza meticulosa das tags hreflang, a maioria dos problemas é causada por erros de digitação e uso de códigos incorretos e links inexistentes.

Se o código estiver incorreto, os bots do Google simplesmente ignorarão o atributo. Você terá que revisar o atributo de tag hreflang para detectar erros que você pode fazer usando o Google Search Console.

3. Sites que não são compatíveis com dispositivos móveis

Em 2019, o Google mudou para a indexação mobile-first por padrão para todos os novos sites. Historicamente, ele usava principalmente a versão para desktop do conteúdo de uma página ao avaliar o conteúdo, no entanto, mais de 50% das consultas de pesquisa globais vêm de dispositivos móveis, portanto, faz mais sentido analisar a versão móvel de qualquer conteúdo do site.

Sites mal adaptados para dispositivos móveis não terão uma classificação tão alta em SERPs. Hoje, ter um site compatível com dispositivos móveis é um dos fundamentos técnicos de SEO do marketing digital.

Há muito que você pode fazer para tornar seu site acessível para usuários de dispositivos móveis. A otimização de imagens, recursos de pesquisa e navegação para melhorar a experiência do usuário em dispositivos móveis.

Por exemplo, o uso de guias suspensas ou menus de navegação de hambúrguer simplifica a jornada do comprador. Os botões de CTA devem ser facilmente clicáveis com os dedos e o texto deve ter o tamanho adequado para telas menores.

Na frente técnica de SEO, as empresas podem aproveitar o cache do navegador, minimizar JavaScript e CCC, compactar imagens para diminuir o tamanho do arquivo e utilizar as páginas AMP do Google para garantir que seguiram o protocolo correto.

4. Conteúdo duplicado

Como mencionamos anteriormente, o conteúdo duplicado afeta negativamente a otimização do mecanismo de pesquisa. Os mecanismos de pesquisa não podem dizer qual versão é a original e, quando eles escolhem a duplicata em vez da original, você perde o valor do link e o poder do PageRank.

Se o seu site contém várias páginas com conteúdo praticamente idêntico, há várias maneiras de indicar URLs preferenciais.

- Canonicalização : Este é o processo de usar tags canônicas para direcionar os mecanismos de pesquisa para as páginas corretas para indexação. Essencialmente, eles informam aos bots quais páginas você deseja que apareçam nas SERPs.

- Utilize 301s : Um 301 é um código de status HTTP que sinaliza um redirecionamento permanente de um URL para outro. Ele passa todo o poder de classificação da URL antiga para a nova.

- Seja consistente : mantenha seus links internos consistentes e garanta que cada página tenha um URL único e limpo.

- Sindicalize com cuidado : as estimativas revelam que até 29% da web contém conteúdo duplicado. Não é surpreendente, considerando a similaridade da página do produto e a distribuição do conteúdo. Por esse motivo, você deve garantir que os sites em que seu conteúdo é distribuído incluam um link para sua página da web original.

- Minimize conteúdo semelhante : considere consolidar páginas semelhantes. Por exemplo, se você tem uma loja de comércio eletrônico que vende camisetas de cores diferentes, mas as informações do produto são basicamente as mesmas, você deve ter uma página de produto com imagens de produtos diferentes.

A melhor solução para conteúdo duplicado é evitá-lo completamente e criar conteúdo exclusivo e rico em palavras-chave para seu site e material de marketing afiliado.

5. Velocidade de página lenta

Os tempos de carregamento de página em sites com menos de 10.000 páginas não afetam muito a taxa de rastreamento, no entanto, grandes sites de comércio eletrônico com mais de 10.000 têm um grande impacto no rastreamento. No entanto, mesmo que seu site seja pequeno, a velocidade da página é importante porque é um fator de classificação do mecanismo de pesquisa.

Páginas que demoram mais de três segundos afetam a experiência do usuário. Qualquer coisa mais longa e as pessoas ficarão frustradas e abandonarão seu site. Assim, um segundo pode fazer a diferença entre fazer ou perder uma venda!

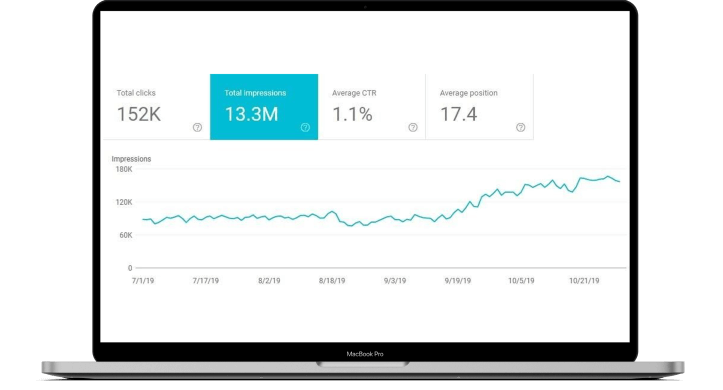

A velocidade da página lenta significa potencialmente menos páginas rastreadas pelo Google, classificações e conversões mais baixas e taxas de rejeição mais altas. Você pode usar o PageSpeed Insights do Google para determinar o que precisa ser melhorado.

Geralmente, existem quatro culpados principais:

- Imagens grandes com tamanho incorreto ou não compactadas

- JavaScript não é carregado de forma assíncrona

- Plugins ou scripts de rastreamento complicados (código que monitora o fluxo de tráfego do site).

- Não usando uma rede de entrega de conteúdo (CDN).

Melhorar a velocidade da página da web pode significar várias coisas, desde aprimorar o design do seu site até redimensionar imagens ou mudar para um site compatível com dispositivos móveis. A solução pode ser simples ou mais complexa, induzindo um efeito composto em todo o seu site.

Ainda assim, independentemente do problema, é vital corrigir problemas técnicos de SEO relacionados à velocidade da página. De vez em quando, é possível fazer isso sozinho, mas na maioria dos casos, você precisará contratar um especialista técnico em SEO, pois pode envolver vários graus de codificação.

Como verificar se suas páginas da Web estão indexadas

Basta copiar o URL da sua página da web da barra de endereços e colá-lo no Google. Se sua página da Web aparecer nos resultados da pesquisa, ela foi indexada. Se nada aparecer, não foi indexado.

Como alternativa, você também pode usar a ferramenta de inspeção de URL do Google. Ele inspeciona a URL de uma página e fornece informações sobre capacidade de descoberta, acessibilidade e indexabilidade.

E lembre-se, só porque o conteúdo da web é indexado pelo Google não significa que está classificado.

O fato de seu URL ser indexado pelo Google não significa necessariamente que está classificado. Para que um URL seja classificado, geralmente é necessário mais do que apenas o fato de o Google conseguir indexá-lo.

Suas páginas da web devem ter conteúdo de alta qualidade que satisfaça a intenção do usuário e atenda aos requisitos técnicos dos mecanismos de pesquisa.

Agende uma Consulta Gratuita

Como o SEO técnico melhora a renderização

O processo de renderização permite que os spiders dos mecanismos de pesquisa vejam as mesmas páginas da web que você vê no navegador enquanto ele é carregado, ou seja, da perspectiva de um visitante. Todos os mecanismos de pesquisa precisam renderizar as páginas antes de indexá-las.

Enquanto fatores externos entram em jogo, a base para criar uma experiência de renderização suave é em grande parte responsabilidade do desenvolvedor do site e do SEO técnico.

A otimização técnica é um desafio porque não apenas o back-end do seu site (o que os usuários não veem on-line) precisa ser codificado de uma maneira que facilite o rastreamento, indexação e renderização dos mecanismos de pesquisa, mas também precisa executar melhor e mais rápido do que seus concorrentes.

Como ajudar o Google a renderizar seu site corretamente

1. Não use muito JavaScript

Uma breve explicação de HTML, CSS e JavaScript:

- HTML : Um sistema de formatação usado para exibir o material recuperado pela Internet. HTML fornece a estrutura básica de sites modificados por tecnologias como JavaScript e CSS.

- CSS : Um acrônimo para Cascading Style Sheets, CSS é uma tecnologia que controla a apresentação, formatação e layout de um site.

- JavaScript : Uma linguagem de script baseada em texto usada para controlar o comportamento de diferentes elementos em páginas da web.

O JavasScript leva mais tempo para renderizar, afetando o orçamento de rastreamento, o que significa que leva mais tempo para rastrear e indexar páginas da web. Há muitas razões pelas quais o JavaScript pode impedir que seu site seja renderizado corretamente.

Um dos mais comuns é quando os arquivos JavaScript são bloqueados por arquivos robots.txt. Isso impede que o Google e outros mecanismos de pesquisa entendam completamente sobre o que é seu site.

Do ponto de vista técnico de SEO, você pode minimizar o código, compactar ativos do site e distribuir ativos estáticos com um CDN que os atende a partir de um servidor mais próximo dos usuários do seu site. Isso pode reduzir a latência do download da página.

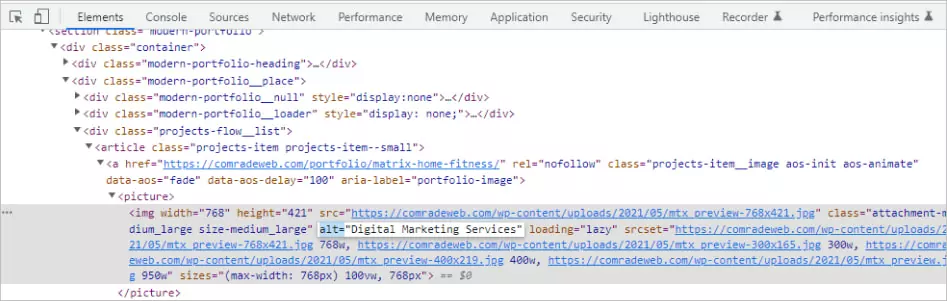

2. Use atributos alternativos

A otimização de imagem é muitas vezes negligenciada quando se trata de otimização de mecanismos de pesquisa, mas melhora a velocidade de carregamento da página e a experiência do usuário enquanto aumenta os rankings SERP.

As tags Alt são de particular importância porque ajudam a exibir o texto quando uma imagem não pode ser renderizada por um navegador devido a erros técnicos, como conexão de largura de banda ruim.

Em vez disso, eles descrevem textualmente o que a imagem deve mostrar. Se o seu site não tiver nenhum atributo alternativo, os mecanismos de pesquisa não terão ideia do que sua imagem deveria exibir.

Existe uma técnica para escrever um bom texto alternativo. Por exemplo, digamos que você tenha a imagem de um gato brincando com um novelo de barbante.

- Descrição ruim: gato brincando

- Boa descrição: gato preto brincando com um novelo de barbante

Sempre descreva as imagens da forma mais objetiva possível. Forneça contexto, mas não use frases como “imagem de” ou “imagem de” e evite o excesso de palavras-chave.

Você pode até usar alt tags para botões. Essas descrições podem ser algo como “inscreva-se agora” ou “obtenha uma cotação”.

Alguns conselhos para SEO: Evite usar imagens no lugar de palavras. Os mecanismos de pesquisa não podem “ler” como os humanos, portanto, usar uma imagem em vez do texto real é confuso para os rastreadores e pode prejudicar os rankings.

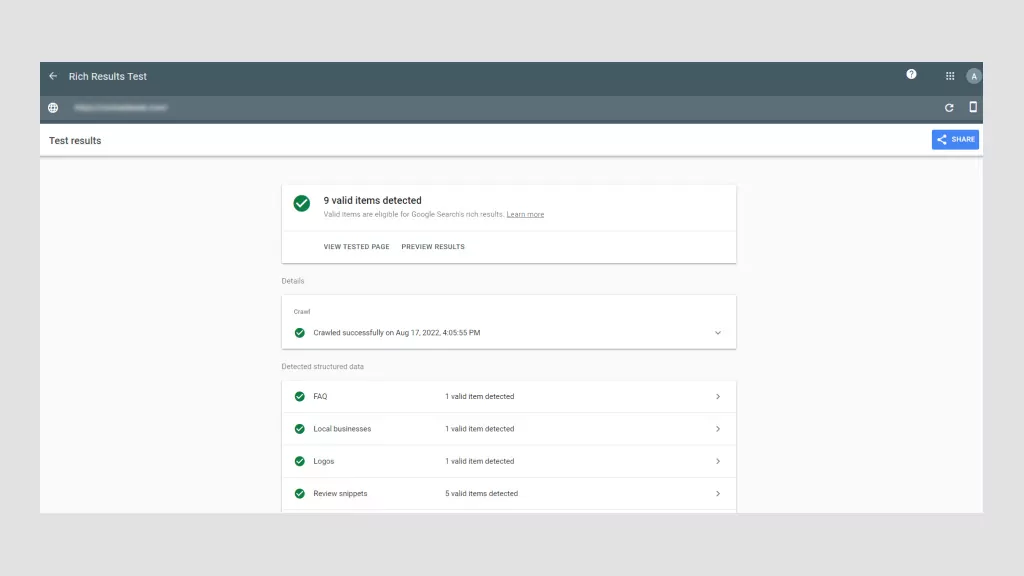

3. Use os dados do esquema

Dados estruturados são informações organizadas em um nível de código de acordo com regras, diretrizes e vocabulários específicos. Ele comunica informações específicas da página, para que os mecanismos de pesquisa possam renderizá-las e indexá-las corretamente.

A forma como os dados estruturados são implementados é na forma de marcação de esquema. Uma vez adicionada a uma página da Web, a marcação de esquema fornece uma definição e estrutura mais claras ao conteúdo do site. É essencialmente uma maneira de descrever seu site para os mecanismos de pesquisa usando um vocabulário de código específico.

Para o Google especificamente, isso aumenta a probabilidade de seu conteúdo ser exibido como um rich resultado ou snippet em destaque, que são listagens de páginas enriquecidas com elementos visuais ou interativos adicionais que os destacam.

Os resultados avançados aparecem na parte superior das SERPs acima dos resultados de texto tradicionais. Portanto, mesmo que sua página não seja a primeira, usando dados de esquema, seu site ainda pode ser a primeira coisa que os usuários veem nas SERPs.

Por exemplo, digamos que você venda livros online. Com a marcação de esquema correta, você pode exibir o autor, um resumo e as estrelas da resenha como um rich snippet. Existem todos os tipos de dados estruturados que você pode usar para filmes, resenhas, perguntas frequentes, receitas e muito mais, por exemplo.

Os dados estruturados são importantes para o SEO técnico porque facilitam o entendimento do Google e de outros mecanismos de pesquisa sobre o que são suas páginas da web. Além disso, aumenta sua taxa de cliques, o que leva a um aumento de tráfego e classificações ainda mais altas.

4. Evite erros de código HTML

Muitos erros de HTML impedem que os rastreadores de pesquisa analisem (analisando) o conteúdo da Web e fazem com que eles saiam prematuramente das páginas da Web.

- Usando menus Flash ou JavaScript sem HTML : o script de menu do seu site deve conter alternativas HTML para que os navegadores sem a capacidade de traduzir Flash ou JavaScript ainda possam permitir que os usuários naveguem em suas páginas. Se um rastreador não puder “ler” links devido ao Flash ou JavaScript, eles não terão nenhum valor. Assim, os menus HTML tornam suas páginas web mais compatíveis.

- Usando URLs com caracteres “inseguros” : os mecanismos de pesquisa lutam para renderizar URLs com símbolos especiais como “&” ou “%”. Esses tipos de caracteres não são seguros por diferentes motivos, mas é provável que eles tenham usos comuns em diferentes sistemas de codificação, fazendo com que os mecanismos de pesquisa interpretem incorretamente seu significado, o que pode quebrar o URL.

- Tags de título e metatags fracas : as tags de título devem conter a palavra-chave de destino da página da web, enquanto as metatags devem explicar sucintamente sobre o que é a página. Ambas as tags são críticas para SEO de otimização de mecanismos de pesquisa. O primeiro melhora a classificação, enquanto o último incentiva os cliques. As tags de título não devem exceder 76 caracteres, enquanto as tags de descrição devem ter menos de 156 caracteres.

HTML é bastante técnico, mas, felizmente, existem plugins técnicos de SEO para ajudá-lo a implementar as tags corretas sem saber codificar como um profissional. Yoast e Moz são padrões da indústria, usados por profissionais para garantir um HTML perfeito.

Checklist de SEO técnico: como melhorar o SEO técnico

Se você leva a sério a melhoria do SEO técnico, precisa realizar uma auditoria técnica de SEO. Pense nisso como um check-up de saúde para o seu site.

Ser negligente com o SEO técnico pode resultar em queda de tráfego e receita.

Recomendamos a realização de uma auditoria de mini-site todos os meses e uma auditoria técnica completa a cada quatro a cinco meses.

Etapa 01: analise sua navegação

Os bots do Google devem ser capazes de rastrear e indexar todas as páginas do seu site, incluindo trilhas de navegação e o mapa do site XML do seu site. Independentemente do tipo de navegação que seu site tenha, ele deve ter uma estrutura de URL limpa.

Por exemplo, você deseja ter uma estrutura lógica de página pai-filho. Digamos que você administre uma loja de decoração para casa. Um URL pai pode ser: https://lovemyhome.com/bedroom e conter páginas com móveis e decoração do quarto. Portanto, um URL filho pode ter esta aparência: https://lovemyhome.com/bedroom/side-tables.

Você também quer evitar páginas órfãs. É quando uma página do site não está vinculada a nenhuma outra página ou seção do seu site. Ele comunica aos motores de busca que não é importante.

Então, quando se trata de navegação primária, lembre-se de incluir suas páginas focadas em serviços e soluções e não insira mais de 30 links nessas páginas para preservar o link juice.

Há dois componentes para auditar a arquitetura do site. O primeiro tem a ver com fatores técnicos, como consertar links quebrados, e o segundo tem a ver com a experiência do usuário. O software do Google torna relativamente fácil conduzir o primeiro.

However, when it comes to UX, human feedback helps. If you're struggling to view your website with fresh eyes, ask family and friends to review it. The less they know about UX, the better, as they more than likely represent everyday users.

Ask yourself (and them):

- Is my website clear?

- Does my main navigation bar link to the most important pages?

- Is it easy for visitors to contact me?

- Can a visitor understand what my business is about and how I can help them just by visiting my website?

Step 02: Check for Duplicate Content

Using top-tier software like SEMRush, Moz or Screamingfrog is the best way to check for duplicate content. These SEO review tools will flag both external and internal content for specific web pages.

If you're tempted to copy and paste sentences from your web copy into Google Search to see if other URLs pop up, don't. This isn't accurate and unnecessarily wastes precious time when there are far more sophisticated options available.

As we mentioned earlier, roughly 30% of all webpage content is duplicated. So, as always, the more original your content the better. Try to keep your duplicate content below this threshold.

Lastly, you'll want to eliminate boilerplate content. This is when the same content is present on different website pages, like terms and conditions, for example. In this instance, it's better to create a single webpage for T&Cs and ensure all the other pages have internal links to it.

Step 03: Check Site Speed and Mobile-Optimization with Google

You can use Google's PageSpeed Insights to ensure your website is fast on all devices. Google's software scores your website speed out of 100. What's important to remember is that page speed is somewhat relative in the sense that people using a mobile on a 3G connection will experience “slowness” for every website they're using.

Additionally, there is also a trade-off between speed and user experience. Some page elements will impact page speed. Of course, you should aim for the fastest speed possible, so long as you're aware, which we're sure you are after reading this article, that many factors affect search engine optimization SEO.

In terms of site speed analysis, it's handy to analyze your competitors' site speeds, so you know what you're up against and can benchmark your results.

As for mobile optimization, Google also has a Mobile-Friendly Test that live-tests your URL. Its detailed report suggests improvement recommendations and directs you to Google Search Console for in-depth analysis and help.

Step 04: Collect and Redirect “Useless Pages”

None of your web pages should be useless. If they are, you need to get rid of them, especially if they're placeholder pages. These look unprofessional and are bad for SEO. It's honestly better to just launch your website when it's ready.

Any web pages “under construction” with zero content won't rank highly. What's more, if they rank for keywords people are searching for, and they don't offer value, your business immediately loses credibility. They serve no navigational purpose and get ignored by Google bots.

However, some web pages are useful for customers but not for Google in terms of pagination or index filters:

- Landing pages for ads

- Thank-you pages

- Privacy and policy pages

- Admin pages

- Duplicate pages

- Low-value pages (eg, outdated content that may still be valuable)

You can either use a nonindex meta tag or a robots.txt file to prevent Google from indexing these pages. It can take time for Google to instigate these changes. Pages that still appear in results despite noindex directives may not have been crawled since your request. You can ask Google to recrawl these pages by using the Fetch As Googlebot.

Step 05: Check Structured Data

The only way to conduct a structured data audit is with software tools like Google Search Console, Screaming Frog, and Site Bulb. It's possible to do it manually, but we don't recommend this unless you are a technical SEO and/or have loads of time on your hands.

Using Google Search Console will tell you which pages have errors and identify where and/or how the error is occurring. But like any audit, structure data audits are about fixing errors and discovering SEO opportunities.

When conducting a structured data audit you'll want to determine if any data is broken and if there's anything more you can do. For example, if an eCommerce store has implemented a product review markup, but some products have fewer ratings, they might decide to remove the markup and avoid reputational damage until they've improved the product.

Top FREE Tools to Check Your Technical SEO

Every technical SEO specialist worth their salt knows how to conduct an SEO audit manually. However, it's tedious and, given the tools on the market, unnecessary. Below are the tools we'd use to perform a high-quality technical SEO audit.

Google Search Console

This is hands down the best free-side audit tool. Google Search Console analyzes your website the same way that Google does with its bots. This feature alone makes it indispensable. With it, you can: monitor indexing and crawling, identify and fix errors, request indexing, update pages, and review all links.

Google Page Speed

This tool allows you to test web page speed. It is also so simple to use. All you need to do is enter the page's URL and hit “analyze.” Google Page Speed's detailed reports come with a personalized Optimization Score and a list of prioritized suggestions to improve running speed.

Google's Structured Data Markup Helper

Compatible with the majority of search engines, Google's Markup Helper helps you mark up different types of structured data on your website. This tool identifies missing fields that need to be filled in to correct the markup of your structured data. It offers a wide range of markup types and offers the possibility to generate rich snippets.

Ahrefs

The only caveat with Ahrefs is you won't have full functionality unless you pay for a subscription, and have to connect your website to it, unlike Google, where you just copy and paste URLs. Otherwise, it's useful to fix technical errors, submit sitemaps, and see structured data issues.

Ubersuggest

While Ubersuggest is mainly used for keyword research, it can perform full-scale audits to check your website for critical errors, warnings, and recommendations. What's great about Ubersuggest is that it pinpoints areas that need urgent attention and prioritizes them accordingly.

Agende uma Consulta Gratuita

Hire the Best SEO Professionals

Technical SEO and audits are mandatory for new and established websites. It's normal to encounter technical SEO issues, most of which are easy to fix. However, you still need the technical know-how. This is where working with an SEO professional can save you time and help avoid costly delays.

Is your technical SEO up to date? If not, we'll conduct a free SEO audit to identify underlying issues and offer recommendations. As a full-service digital marketing agency, we've improved our clients' traffic by 175% on average! Call us today to fix your technical SEO issues.