Auditoria de site com prioridade de seis pontos para sites grandes em uma atualização pós-panda

Publicados: 2011-12-13Acredito que o Google Panda, o Grande Expurgo, está de fato tornando a internet uma melhor fonte de informação, mas para aqueles grandes sites atingidos por ele, é um monstro diferente para lidar com eles.

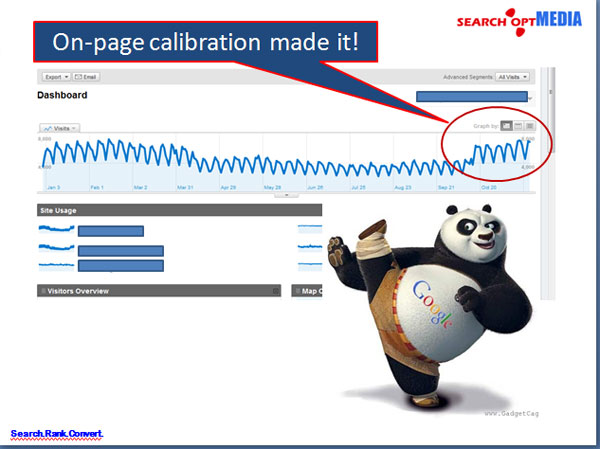

Na maioria dos casos, o SEO para sites enormes em uma atualização pós-panda normalmente lida com sua arquitetura de informações e, ao corrigir a estrutura na página, traz uma grande melhoria no tráfego, taxa de rejeição e SERPs.

No entanto; tendo que lidar com sites enormes, estrategistas da web ou SEOs sempre se deparam com tempo e limitação sobre quais prioridades precisam ser abordadas primeiro para ver melhorias em menos tempo. Claro, os chefes sempre vão querer resultados imediatos como se devesse estar disponível como “ontem”.

Por isso, preparei uma auditoria de site com prioridade de seis pontos para sites corporativos da seguinte forma para ajudar a identificar as prioridades:

I. Indexação de páginas de paginação de endereços e consolidação de link juice pass

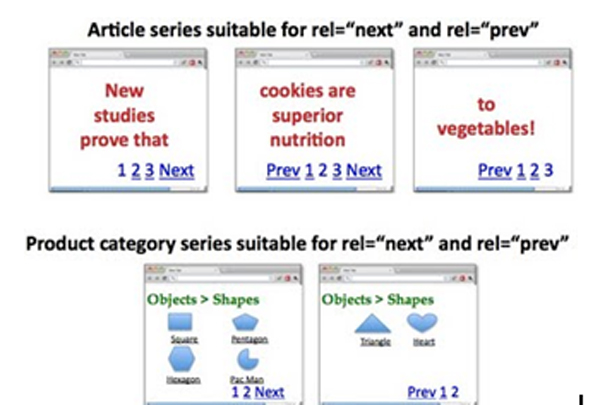

A paginação é sempre uma coisa complicada em sites grandes que muitas vezes é o resultado de hábitos de codificação defeituosos por desenvolvedores que não estão preocupados com a duplicação de páginas.

Como implementar: rel=”prev” e rel=”next”?

Página 1: http://www.example.com/page1.html

<link rel=”canonical” href=”http://www.example.com/page1.html” />

<link rel=”next” href=”http://www.example.com/page2.html” />

Página 2: http://www.example.com/page2.html

<link rel=”canonical” href=”http://www.example.com/page2.html” />

<link rel=”prev” href=”http://www.example.com/page1.html” />

<link rel=”next” href=”http://www.example.com/page2.html” />

….

Última página:

<link rel=”canonical” href=”http://www.example.com/lastpage.html” />

<link rel=”prev” href=”http://www.example.com/secondtothelastpage.html” />

Opção:

A inclusão da página “view-all” também pode ser uma boa estratégia que queremos que o Google indexe além das páginas componentes. Podemos fazer isso usando rel=”canonical” apontando para a página view-all. CONTUDO; se a latência das páginas for alta, é melhor seguir a estratégia rel=”prev” e rel=”next”.

II. Corrigir problemas de duplicação de Meta Titles e Meta Descriptions no GWT

Para resolver os problemas duplicados em títulos e descrições Meta no GWT, precisamos recodificar os títulos e descrições gerados como tal.

Como implementar bons títulos em páginas paginadas?

Página 1: Título aqui com palavras-chave

Página 2: Página 2 de 4, Título aqui com palavras-chave

Página 3: Página 3 de 4, Título aqui com palavras-chave

Com efeito, temos:

<cabeça>

<link rel=”canonical” href=”http://www.example.com/page2.html” />

<link rel=”prev” href=”http://www.example.com/page1.html” />

<link rel=”next” href=”http://www.example.com/page2.html” />

<title> Página 2 de 4, Título aqui com palavras-chave</title>

</head>

Como implementar uma Meta Descriptions melhor e única?

Página 2:

<title>Página 2 de 4, Título aqui com palavras-chave</title>

<meta name=”description” content=”>Listas de 11-20 (de 30) Título aqui com palavras-chave” />

*As palavras-chave da marca no título podem ser removidas para acomodar outras palavras-chave locais ou de cauda longa

Ou

Você pode simplesmente deixar em branco as descrições Meta das páginas componentes para permitir que os robôs direcionem o tráfego e o peso para as principais páginas que sempre desejamos.

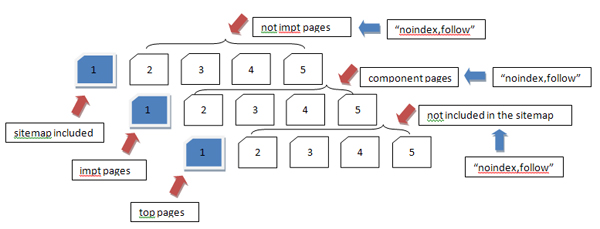

III. Reenvio do sitemap de páginas importantes para reforçar a priorização de recuperação de informações e o uso de “noindex,follow”

Estamos todos cientes de que a resubmissão dos sitemaps serve para a priorização das páginas mais importantes do site a serem indexadas e ponderadas adequadamente pelos motores de busca.

Como implementar “noindex,follow” nas páginas menos importantes?

Inserção do <meta name=”robots” content='noindex, follow' /> ou para ser mais específico para o Google Bots, use <meta name=”googlebot” content='noindex, follow' />

- É importante ressaltar que o uso de “noindex,follow” para páginas componentes (páginas 2,3, etc) deve ser implementado para evitar conteúdos quase duplicados, muitas vezes interpretados pelo Google como conteúdos finos.

- Se as páginas componentes de algum conjunto de páginas forem consideradas necessárias, o “noindex,follow” poderá ser removido

Observe que não é uma boa prática concentrar seus esforços na indexação de TODAS as páginas de um site corporativo, mas, em vez disso, simplesmente se concentre nas páginas importantes para as quais você deseja trazer seu público para visitar.

História:

A prática de criar centenas de milhares de páginas ou até milhões de páginas naquela época apenas para fazer o Google acreditar que o site é um site de autoridade não é mais aplicável nos dias de hoje. O PANDA vai até fazer você se encolher ao criar esses “conteúdos finos” em seu site.

4. Abaixe a TAXA DE RECUPERAÇÃO

BOUNCE RATE é um indicador do Google para a relevância do site para os usuários em seus resultados de pesquisa. A Search Opt Media Inc. acredita que isso tem um grande impacto na classificação nos dias de hoje. Não poderia mais ser desconsiderado.

Como abordá-lo?

Procure títulos de página relacionados ao conteúdo da página. Quando alguém clicar em um resultado de pesquisa, pelo menos terá lido o título. Agora, se o seu H1 for muito diferente disso, as chances são de que as pessoas saiam do seu site imediatamente, supondo que ele não ofereça o que estão procurando.

Mais ainda, a oferta de um bom conteúdo relevante para o resultado da busca é realmente exigida.

Como implementar?

Título, H1, Meta Descrições e cópia do documento devem mostrar conteúdos relevantes dos resultados da pesquisa.

IMPORTANTE: Os escritores de conteúdo devem levar isso a sério.

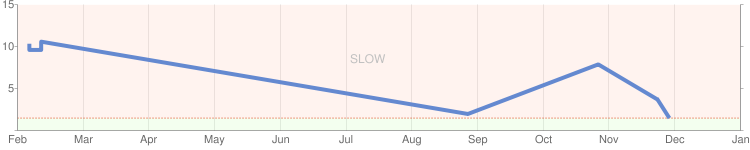

V. Aumente a VELOCIDADE DO LOCAL

As atualizações do Mayday, Cafeína e PANDA são sobre a experiência do usuário especificamente na velocidade do site. Novamente, isso se baseia na premissa de proporcionar uma excelente experiência ao usuário no site. Quanto mais rápido o site se tornar, quanto mais tempo os usuários permanecerem no seu site, maiores serão as visitas de retorno e tudo seguirá para subir nas paradas. Isso é o que o Google quer.

A velocidade do site pode ser um problema do lado do servidor ou um problema do lado do aplicativo. Eu enumerei abaixo as coisas que você precisa fazer para acelerar o seu site.

Como testar e identificar “partes” específicas do site que estão afetando fortemente a velocidade do site?

Ferramentas para usar:

- http://www.webpagetest.org

- http://www.websiteoptimization.com/services/analyze/

- http://tools.pingdom.com/

- https://addons.mozilla.org/en-US/firefox/addon/firebug/

- https://addons.mozilla.org/en-US/firefox/addon/YSlow/

- https://code.google.com/speed/page-speed/download.html

A Search Opt Media Inc. identificou as ferramentas acima para teste e calibração de desempenho de velocidade do site. #s 1-6 são boas ferramentas!

Sobre o problema do lado do servidor, eu recomendaria o seguinte:

1. Use CDN – acho que você já está usando isso.

2. Use o sistema de cache

VI. Limpe todas as páginas 404 encontradas no Google Webmaster Tools (GWT)

Solicitação de remoção de páginas 404 no GWT, bem como as páginas vinculadas às páginas 404. Você pode usar o Link Sleuth do Xenu para identificar links quebrados e páginas 404. Depois disso, corrija-os.

Tendo dito todas as questões prioritárias no site de auditoria de grandes sites , o resultado é tremendo!