Jak skonfigurować plik robots.txt Magento 2 pod kątem SEO?

Opublikowany: 2021-01-21Spis treści

SEO jest ważnym czynnikiem sukcesu Twojego sklepu, a odpowiednio skonfigurowany plik robots.txt w niemałym stopniu ułatwia pracę robotom wyszukiwarek.

Co to jest plik robots.txt?

W skrócie, robots.txt to plik, który instruuje roboty wyszukiwarek, co mogą, a czego nie mogą indeksować. Bez pliku robots.txt w katalogu głównym roboty wyszukiwarek przechodzące do Twojego sklepu będą indeksować wszystko, co mogą, w tym zduplikowane lub nieistotne strony, na które roboty wyszukiwarek nie mają marnować swojego budżetu. Plik robots.txt powinien być w stanie rozwiązać ten problem.

Uwaga : plik robots.txt nie powinien być używany do ukrywania stron internetowych przed Google. W tym celu należy użyć metatagu noindex .

Domyślne instrukcje robots.txt w Magento 2

Domyślnie plik robots.txt wygenerowany przez Magento zawiera tylko podstawowe instrukcje dla robota indeksującego.

# Domyślne instrukcje dostarczone przez Magento Agent użytkownika: * Nie zezwalaj: /lib/ Zabroń: /*.php$ Nie zezwalaj: /pkginfo/ Nie zezwalaj: /zgłoś/ Nie zezwalaj: /var/ Nie zezwalaj: /katalog/ Odrzuć: /klient/ Nie zezwalaj: /wyślij przyjaciela/ Nie zezwalaj: /recenzja/ Nie zezwalaj: /*SID=

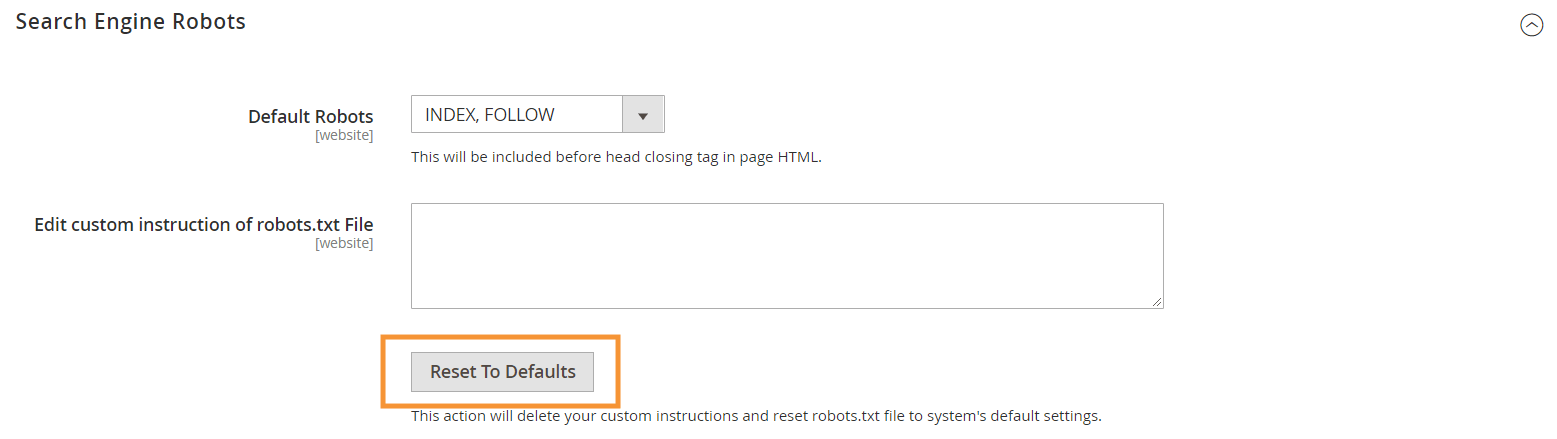

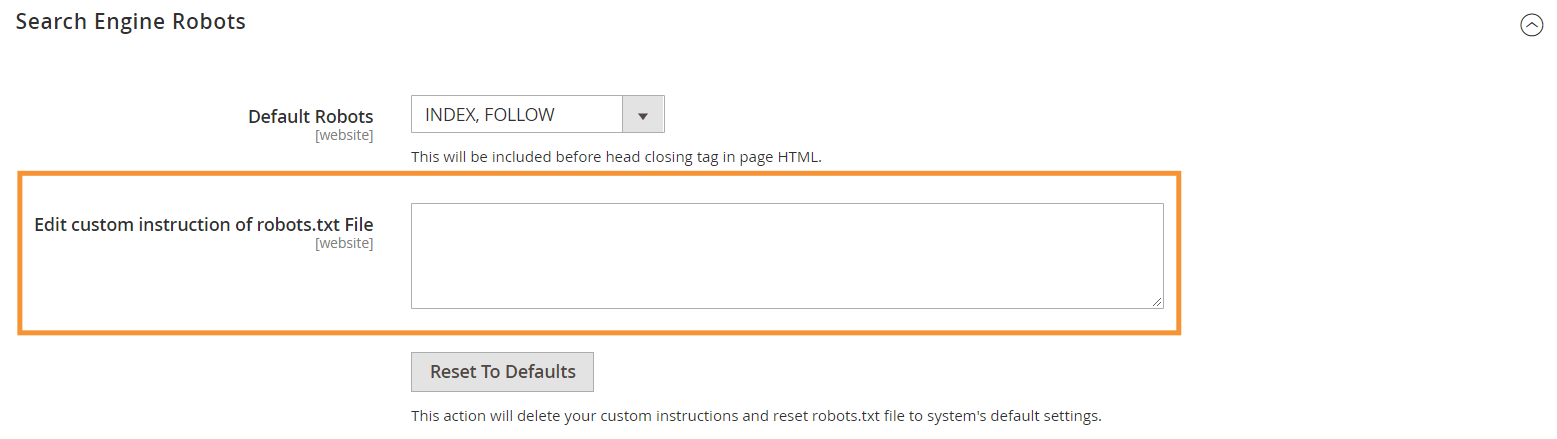

Aby wygenerować te domyślne instrukcje, kliknij przycisk Reset to Defaults w konfiguracji Search Engine Robots w swoim zapleczu Magento.

Dlaczego musisz tworzyć niestandardowe instrukcje robots.txt w Magento 2?

Chociaż domyślne instrukcje w pliku robots.txt dostarczane przez Magento są niezbędne, aby roboty indeksujące unikały indeksowania niektórych plików, które są używane wewnętrznie przez system, w większości sklepów Magento nie są one wystarczające.

Roboty wyszukiwarek mają tylko skończoną ilość zasobów do indeksowania stron internetowych. Aby zaindeksować witrynę z tysiącami, a nawet milionami adresów URL (co jest częstsze, niż mogłoby się wydawać), należy określić priorytet typu treści, które miały być zindeksowane (za pomocą sitemap.xml) i odrzucić nieistotne strony przed zindeksowaniem (z plikiem robots.txt). Druga część polega na uniemożliwieniu indeksowania duplikatów, nieistotnych i niepotrzebnych stron w pliku robots.txt.

Podstawowy format dyrektyw robots.txt

Instrukcje w robots.txt są ułożone w spójny sposób, przyjazny dla nietechnicznych użytkowników:

# Zasada nr 1 Klient użytkownika: Googlebot Nie zezwalaj: /niegooglebot/ # Zasada 2 Agent użytkownika: * Umożliwić: / Mapa witryny: https://www.example.com/sitemap.xml

-

User-agent: wskazuje konkretnego robota, którego dotyczy reguła. Niektóre popularne klienty użytkownika toGooglebot,Googlebot-Image,Mediapartners-Google,Googlebot-Videoitd. Obszerną listę popularnych robotów można znaleźć w artykule Przegląd robotów Google.

-

Allowi nieDisallow: określ ścieżki, do których wyznaczone przeszukiwacze mogą lub nie mogą uzyskać dostępu. Na przykładAllow: /oznacza, że robot może uzyskać dostęp do całej witryny bez ograniczeń.

-

Sitemap: wskazuje ścieżkę do mapy witryny Twojego sklepu. Mapa witryny to sposób na poinformowanie robotów wyszukiwarek, jakie treści mają być traktowane priorytetowo, podczas gdy reszta treści w pliku robots.txt informuje roboty indeksujące, jakie treści mogą, a których nie mogą indeksować.

Również w robots.txt możesz użyć kilku symboli wieloznacznych dla wartości ścieżki, takich jak:

-

*: w kliencieuser-agentgwiazdka (*) odnosi się do wszystkich robotów wyszukiwarek (z wyjątkiem robotów AdsBot), które odwiedzają witrynę. W przypadku użycia w dyrektywachAllow/Disallowoznacza 0 lub więcej wystąpień dowolnego prawidłowego znaku (np.Allow: /example*.csspasuje do /example.css , a także / example12345.css ). -

$: oznacza koniec adresu URL. Na przykładDisallow: /*.php$zablokuje wszystkie pliki, które kończą się na .php -

#: oznacza początek komentarza, który roboty będą ignorować.

Uwaga : z wyjątkiem ścieżki sitemap.xml ścieżki w pliku robots.txt są zawsze względne , co oznacza, że do określania ścieżek nie można używać pełnych adresów URL (np. https://simicart.com/nogooglebot/).

Konfiguracja robots.txt w Magento 2

Aby uzyskać dostęp do edytora plików robots.txt, w panelu administratora Magento 2:

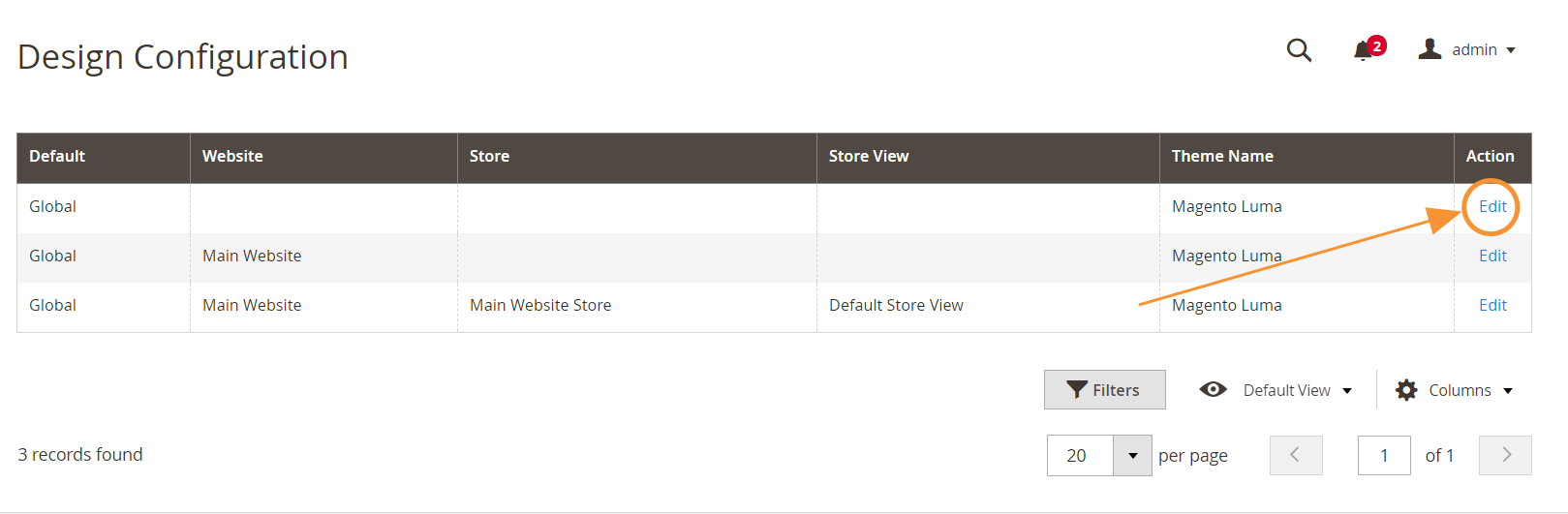

Krok 1 : Przejdź do Treść > Projekt > Konfiguracja

Krok 2 : Edytuj konfigurację globalną w pierwszym wierszu

Krok 3 : W sekcji Roboty wyszukiwarek edytuj niestandardowe instrukcje

Zalecane instrukcje dotyczące pliku robots.txt

Oto nasze zalecane instrukcje, które powinny odpowiadać ogólnym potrzebom. Oczywiście każdy sklep jest inny i być może trzeba będzie poprawić lub dodać kilka dodatkowych reguł, aby uzyskać najlepsze wyniki.

Agent użytkownika: * # Instrukcje domyślne: Nie zezwalaj: /lib/ Zabroń: /*.php$ Nie zezwalaj: /pkginfo/ Nie zezwalaj: /zgłoś/ Nie zezwalaj: /var/ Nie zezwalaj: /katalog/ Odrzuć: /klient/ Nie zezwalaj: /wyślij przyjaciela/ Nie zezwalaj: /recenzja/ Nie zezwalaj: /*SID= # Nie zezwalaj na wspólne pliki Magento w katalogu głównym: Nie zezwalaj: /cron.php Odrzuć: /cron.sh Nie zezwalaj: / dziennik_błędów Zabroń: /install.php Nie zezwalaj: /LICENSE.html Nie zezwalaj: /LICENSE.txt Nie zezwalaj: /LICENSE_AFL.txt Nie zezwalaj: /STATUS.txt # Nie zezwalaj na konto użytkownika & Strony kasy: Nie zezwalaj: /do kasy/ Nie zezwalaj: /jednoetapowe wymeldowanie/ Odrzuć: /klient/ Nie zezwalaj: /klient/konto/ Nie zezwalaj: /klient/konto/logowanie/ # Nie zezwalaj na strony wyszukiwania w katalogu: Nie zezwalaj: /przeszukiwanie katalogów/ Nie zezwalaj: /katalog/porównanie_produktu/ Disallow: /katalog/kategoria/widok/ Disallow: /katalog/produkt/widok/ # Nie zezwalaj na wyszukiwanie z filtrem adresów URL Disallow: /*?katalog* Disallow: /*?katalog=desc Disallow: /*?dir=asc Nie zezwalaj: /*?limit=all Zabroń: /*?tryb* # Nie zezwalaj na katalogi CMS: Nie zezwalaj: /app/ Odrzuć: /bin/ Nie zezwalaj: /dev/ Nie zezwalaj: /lib/ Zabroń: /phpserver/ Nie zezwalaj: /pub/ # Nie zezwalaj na duplikaty treści: Nie zezwalaj: /tag/ Nie zezwalaj: /recenzja/ Disallow: /*?*product_list_mode= Disallow: /*?*product_list_order= Disallow: /*?*product_list_limit= Disallow: /*?*product_list_dir= # Ustawienia serwera # Nie zezwalaj na ogólne katalogi techniczne i pliki na serwerze Nie zezwalaj: /cgi-bin/ Zabroń: /cleanup.php Nie zezwalaj: /apc.php Nie zezwalaj: /memcache.php Zabroń: /phpinfo.php # Nie zezwalaj na foldery kontroli wersji i inne Nie zezwalaj: /*.git Odrzuć: /*.CVS Odrzuć: /*.Zip$ Odrzuć: /*.Svn$ Odrzuć: /*.Idea$ Odrzuć: /*.Sql$ Odrzuć: /*.Tgz$ Mapa witryny: https://www.example.com/sitemap.xml

Wniosek

Utworzenie pliku robots.txt to tylko jeden z wielu kroków na liście kontrolnej SEO Magento – a odpowiednia optymalizacja sklepu Magento pod kątem wyszukiwarek z pewnością nie jest łatwym zadaniem dla większości właścicieli sklepów. Jeśli nie chcesz się tym zajmować, możemy zająć się wszystkim za Ciebie. W SimiCart świadczymy usługi SEO i optymalizacji szybkości, które gwarantują najlepsze wyniki dla Twojego sklepu.