Top 15 des outils ETL pour collecter des données marketing

Publié: 2023-03-22L'analyse marketing avancée moderne est difficile à imaginer sans les outils ETL. Après tout, avant qu'une entreprise ne commence à créer des rapports et à rechercher des informations, toutes les données qu'elle collecte auprès de sources disparates doivent être traitées : nettoyées, vérifiées, rassemblées dans un format unique et combinées. C'est à cela que servent les outils ETL. Dans cet article, nous détaillons les 15 meilleurs services ETL pour 2023 afin que vous puissiez choisir le meilleur pour votre entreprise.

Table des matières

- Qu'est-ce qu'ETL ?

- Types d'outils ETL

- Quels sont les critères de choix des outils ETL ?

- Top 15 des outils ETL pour collecter des données marketing

- Courte conclusion

Qu'est-ce qu'ETL ?

ETL (Extraire, Transformer, Charger) est le processus d'intégration de données qui sous-tend l'analyse basée sur les données. Il se compose de trois étapes :

- Les données sont extraites de la source originale.

- Les données sont ensuite transformées dans un format adapté à l'analyse.

- Enfin, les données sont chargées dans le stockage, un lac de données ou un système de Business Intelligence (BI).

ETL fournit la base d'une analyse de données réussie et fournit une source unique de vérité pour garantir que toutes les données de l'entreprise sont cohérentes et à jour.

Que sont les outils ETL ?

Les outils ETL sont des services qui vous aident à exécuter des processus ETL. En termes simples, les outils ETL permettent aux entreprises de collecter des données de différents types à partir de plusieurs sources, de les convertir en un seul format et de les télécharger dans un référentiel centralisé tel que Google BigQuery, Snowflake ou Azure.

Quels sont les avantages des outils ETL ?

- Gagnez du temps et éliminez le traitement manuel des données. Les outils ETL vous aident à collecter, transformer et consolider automatiquement les données.

- Facilitez le travail avec une grande quantité de données complexes et diverses : fuseaux horaires, noms de clients, identifiants d'appareils, emplacements, etc.

- Réduisez le risque d'erreurs de données causées par des facteurs humains.

- Améliorer la prise de décision. En automatisant le travail avec des données critiques et en réduisant les erreurs, ETL garantit que les données que vous recevez pour analyse sont de haute qualité et dignes de confiance.

- Parce que vous économisez du temps, des efforts et des ressources, le processus ETL vous aide finalement à augmenter votre retour sur investissement.

Considérons les types d'outils ETL.

Types d'outils ETL

Tous les outils ETL peuvent être grossièrement divisés en quatre types en fonction de leur infrastructure et de l'organisation ou du fournisseur de support. Certains sont conçus pour fonctionner dans l'environnement local, certains dans le cloud et d'autres à la fois localement et dans le cloud.

1. Outils ETL basés sur le cloud

Les outils ETL basés sur le cloud extraient les données des sources et les chargent directement dans le stockage cloud. Ils peuvent ensuite transformer ces données en utilisant la puissance et l'échelle du cloud. Il s'agit essentiellement d'une approche moderne du processus ETL familier, dans lequel la transformation des données se produit après le chargement des données dans le stockage.

Les outils ETL traditionnels extraient et transforment les données de différentes sources avant de les charger dans l'entrepôt. Avec l'avènement du stockage en nuage, il n'est plus nécessaire de nettoyer les données à une étape intermédiaire entre l'emplacement de stockage source et cible.

Les outils ETL basés sur le cloud sont particulièrement pertinents pour les analyses avancées. Par exemple, vous pouvez charger des données brutes dans un lac de données, puis les combiner avec des données provenant d'autres sources ou les utiliser pour former des modèles prédictifs. L'enregistrement des données dans leur format brut permet aux analystes d'étendre leurs capacités. Cette approche est plus rapide car elle exploite la puissance des moteurs de traitement de données modernes et réduit les mouvements de données inutiles.

2. Outils ETL d'entreprise

Ce sont des outils ETL développés par des organisations commerciales et font souvent partie de plateformes d'analyse plus importantes. Les avantages des outils ETL d'entreprise incluent la fiabilité et la maturité, car ils sont sur le marché depuis longtemps. Ils peuvent également offrir des fonctionnalités avancées : une interface utilisateur graphique (GUI) pour la conception de flux ETL, la prise en charge de la plupart des bases de données relationnelles et non relationnelles, un haut niveau de support client et une documentation complète.

En termes d'inconvénients, les outils ETL d'entreprise sont généralement plus chers que les alternatives, nécessitent une formation supplémentaire pour les employés et sont difficiles à intégrer.

3. Outils ETL open source

Ce sont des outils ETL gratuits qui offrent une interface graphique pour créer et gérer des flux de données. Grâce à la nature open source de ces services, les utilisateurs peuvent comprendre leur fonctionnement et étendre leurs fonctionnalités.

Les outils ETL open source sont une alternative économique aux services payants. Certains ne prennent pas en charge les transformations complexes et peuvent ne pas offrir de support client.

4. Outils ETL personnalisés

Ce sont des outils ETL que les entreprises créent elles-mêmes à l'aide de SQL, Python ou Java. D'une part, ces solutions présentent une grande flexibilité et peuvent être adaptées aux besoins des entreprises. D'autre part, ils nécessitent beaucoup de ressources pour leurs tests, leur maintenance et leur mise à jour.

Quels sont les critères de choix des outils ETL ?

Lorsque vous choisissez un outil ETL, vous devez tenir compte des besoins de votre entreprise, de la quantité de données à collecter, des sources de ces données et de la manière dont vous les utiliserez.

À quoi faire attention lors du choix d'un outil ETL :

- Facilité d'utilisation et d'entretien.

- Vitesse de l'outil.

- Sécurité et qualité des données. Les outils ETL qui proposent des audits de la qualité des données aident à identifier les incohérences et les doublons et à réduire les erreurs de données. Les fonctionnalités de surveillance peuvent vous avertir si vous avez affaire à des types de données incompatibles et à d'autres problèmes.

- Capacité à traiter des données provenant de nombreuses sources différentes. Une entreprise peut travailler avec des centaines de sources avec différents formats de données. Il peut y avoir des données structurées et semi-structurées, des données de streaming en temps réel, des fichiers plats, des fichiers CSV, etc. Certaines de ces données sont mieux converties par lots, tandis que d'autres données sont mieux gérées par une conversion continue de données en streaming.

- Le nombre et la variété des connecteurs disponibles.

- Évolutivité. La quantité de données collectées ne fera que croître au fil des ans. Oui, vous pourriez être d'accord avec une base de données locale et le téléchargement par lots en ce moment, mais cela sera-t-il toujours suffisant pour votre entreprise ? C'est idéal pour pouvoir faire évoluer indéfiniment les processus et la capacité ETL ! Lorsqu'il s'agit de prendre des décisions basées sur les données, pensez grand et rapidement et tirez parti des services de stockage dans le cloud (comme Google BigQuery) qui vous permettent de traiter rapidement et à peu de frais de grandes quantités de données.

- Possibilité d'intégration avec d'autres composants de votre plate-forme de données, y compris les entrepôts et les lacs de données.

Maintenant que nous avons couvert les types et les fonctionnalités des outils ETL, examinons les plus populaires de ces outils.

Top 15 des outils ETL pour collecter des données marketing

Il existe de nombreux outils ETL sur le marché pour vous aider à simplifier la gestion de vos données tout en vous faisant gagner du temps et de l'argent. Jetons un coup d'œil à certains d'entre eux, en commençant par les outils ETL qui fonctionnent dans le cloud.

1. OWOX BI

OWOX BI est une plateforme d'analyse numérique ETL/ELT sans code qui simplifie la gestion et le reporting des données. La plate-forme OWOX BI vous permet de collecter des données marketing pour des rapports de toute complexité dans le stockage cloud sécurisé de Google BigQuery.

Principales caractéristiques d'OWOX BI :

- Collecte automatique de données à partir de diverses sources.

- Importation automatique des données brutes dans Google BigQuery.

- Nettoyage, déduplication, suivi qualité et mise à jour des données.

- Modélisation des données et préparation de données prêtes à l'emploi.

- Capacité à créer des rapports sans l'aide d'analystes ni de connaissance de SQL.

OWOX BI collecte automatiquement les données brutes de diverses sources et les convertit dans un format pratique pour créer des rapports. Vous recevrez des ensembles de données prêts à l'emploi automatiquement transformés dans la structure nécessaire, en tenant compte des nuances importantes pour les spécialistes du marketing. Vous n'aurez pas besoin de passer du temps à développer et à maintenir des transformations complexes, à vous plonger dans la structure des données et à identifier les raisons des écarts.

OWOX BI libère votre temps précieux afin que vous puissiez accorder plus d'attention à l'optimisation des campagnes publicitaires et des zones de croissance.

Lorsque vous comptez sur OWOX BI, vous n'avez plus besoin d'attendre les rapports d'un analyste. Sur la base de données simulées, vous pouvez obtenir des tableaux de bord prêts à l'emploi ou des rapports personnalisés adaptés à votre entreprise.

Grâce à l'approche unique d'OWOX BI, vous pouvez modifier les sources de données et les structures de données sans réécrire les requêtes SQL ni modifier l'ordre des rapports. Ceci est particulièrement pertinent avec la sortie de Google Analytics 4.

Inscrivez-vous à une démo pour en savoir plus sur les possibilités d'OWOX BI pour votre entreprise.

2. Colle AWS

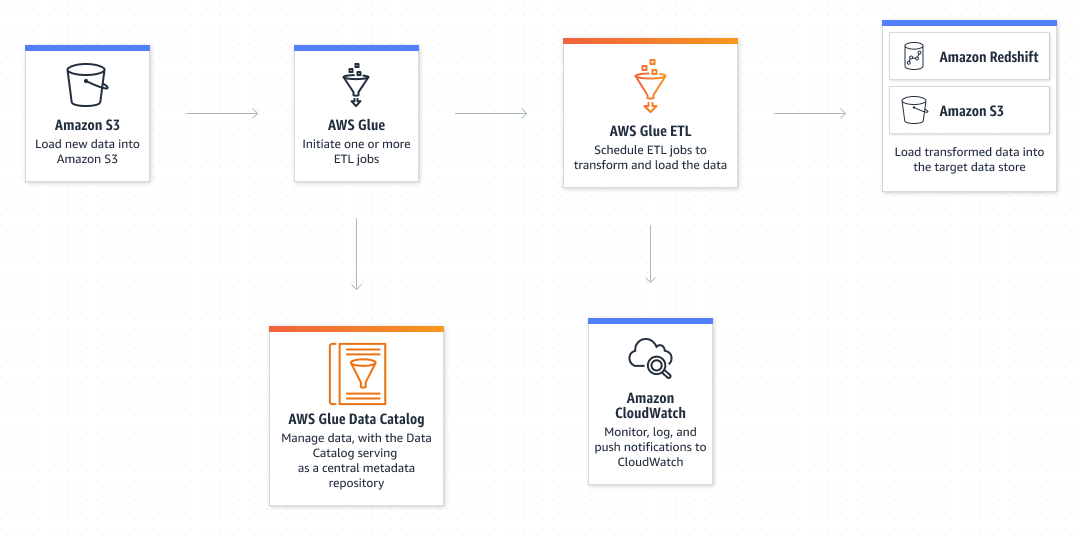

AWS Glue est le service ETL sans serveur d'Amazon qui facilite la découverte, la préparation, le déplacement et l'intégration de données provenant de plusieurs sources pour l'analyse, l'apprentissage automatique et le développement d'applications.

Fonctionnalités clés d'AWS Glue :

- Intégration avec plus de 70 sources de données différentes.

- Capacité à utiliser à la fois une interface graphique et du code (Python/Scala) pour créer et gérer des flux de données.

- Possibilité de travailler en modes ETL et ELT — AWS Glue se concentre principalement sur le traitement par lots, mais il prend également en charge les données en continu.

- Prise en charge des requêtes SQL personnalisées, facilitant les interactions avec les données.

- Capacité à exécuter des processus selon une planification — Par exemple, vous pouvez configurer AWS Glue pour exécuter vos tâches ETL lorsque de nouvelles données deviennent disponibles dans le stockage Amazon S3.

- Data Catalog vous permet de trouver rapidement différents ensembles de données sur AWS sans les déplacer. Une fois cataloguées, les données sont immédiatement disponibles pour la recherche et l'interrogation à l'aide d'Amazon Athena, Amazon EMR et Amazon Redshift Spectrum.

- Fonctionnalité de surveillance de la qualité des données.

3. Usine de données Azure

Azure Data Factory est le service ETL basé sur le cloud de Microsoft pour l'intégration et la transformation évolutives des données sans serveur. Il offre une interface utilisateur sans code pour créer, surveiller et gérer intuitivement les flux de données.

Fonctionnalités clés d'AWS Glue :

- Intégration avec plus de 70 sources de données différentes.

- Capacité à utiliser à la fois une interface graphique et du code (Python/Scala) pour créer et gérer des flux de données.

- Possibilité de travailler en modes ETL et ELT — AWS Glue se concentre principalement sur le traitement par lots, mais il prend également en charge les données en continu.

- Prise en charge des requêtes SQL personnalisées, facilitant les interactions avec les données.

- Capacité à exécuter des processus selon une planification — Par exemple, vous pouvez configurer AWS Glue pour exécuter vos tâches ETL lorsque de nouvelles données deviennent disponibles dans le stockage Amazon S3.

- Data Catalog vous permet de trouver rapidement différents ensembles de données sur AWS sans les déplacer. Une fois cataloguées, les données sont immédiatement disponibles pour la recherche et l'interrogation à l'aide d'Amazon Athena, Amazon EMR et Amazon Redshift Spectrum.

- Fonctionnalité de surveillance de la qualité des données.

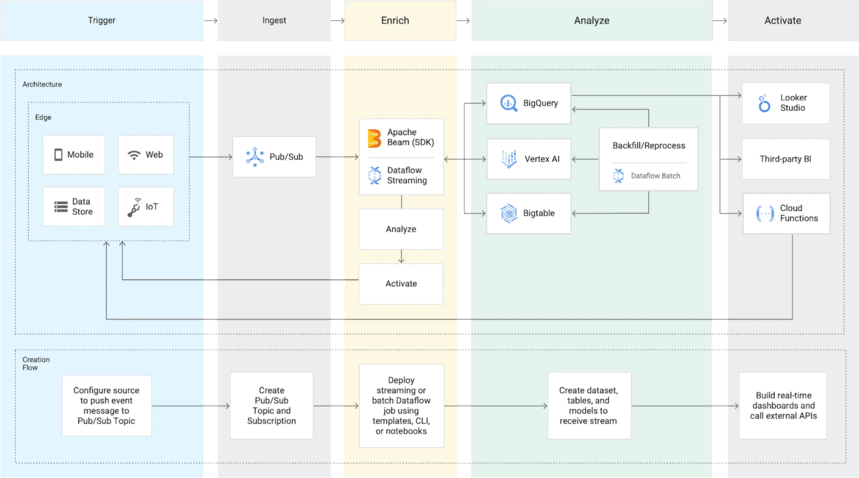

4. Flux de données Google Cloud

Dataflow est un service ETL basé sur le cloud de Google qui vous permet de traiter à la fois des données en continu et par lots et ne vous oblige pas à posséder un serveur.

Principales fonctionnalités de Google Cloud Dataflow :

- Prend en charge de nombreuses sources de données (hors SaaS) : Cloud Dataflow propose à la fois l'ingestion de données par lots et par flux. Pour le traitement par lots, il peut accéder aux bases de données hébergées sur GCP et locales. PubSub est utilisé pour le streaming. Le service transfère les données vers Google Cloud Storage ou BigQuery.

- Exécute des pipelines Apache Beam sur Google Cloud Platform : Apache propose des SDK Java, Python et Go pour la présentation et le transfert d'ensembles de données, à la fois par lots et par flux. Cela permet aux utilisateurs de choisir le bon SDK pour leur pipeline de données.

- Tarification flexible — Vous ne payez que pour les ressources que vous consommez, et les ressources évoluent automatiquement en fonction de vos besoins et de votre charge de travail.

- Dataflow SQL vous permet d'utiliser vos compétences en SQL pour développer des pipelines de streaming Dataflow directement depuis l'interface Web de BigQuery.

- La surveillance intégrée vous permet de dépanner les pipelines de traitement par lots et de diffusion en temps opportun. Vous pouvez également définir des alertes pour les données obsolètes et les retards du système.

- Support client de haut niveau — Google propose plusieurs plans de support pour Google Cloud Platform (dont Cloud Dataflow fait partie) ainsi qu'une documentation complète.

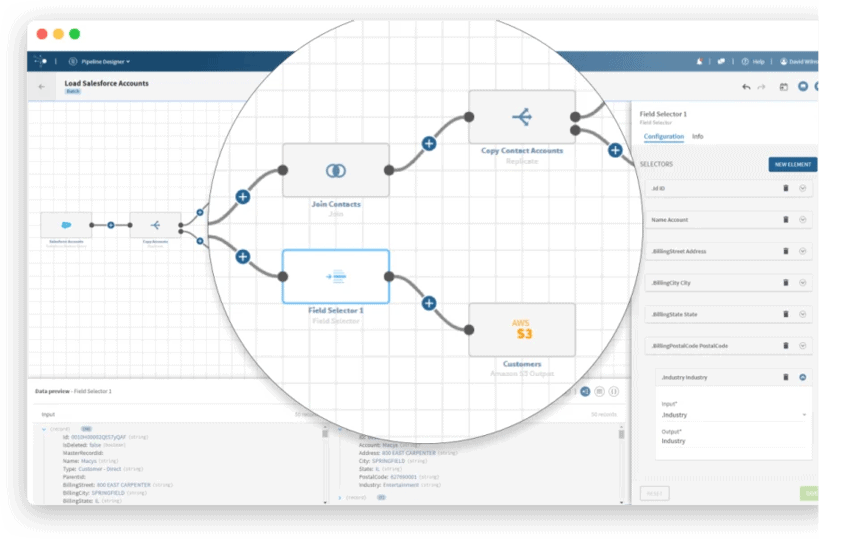

5. Intégrer.io

Integrate.io est une plate-forme d'intégration de données ETL conçue spécifiquement pour les projets de commerce électronique. Il vous permet de traiter des données provenant de centaines de sources en utilisant diverses méthodes (Integrate.io ETL, ELT, Reverse ETL, API Management). Il offre une interface intuitive et sans code pour faciliter le travail des personnes non techniques avec les flux de données.

Fonctionnalités clés d'Integrate.io :

- Connecteurs intégrés pour plus de 150 sources et destinations de données, y compris des entrepôts de données, des bases de données et des plates-formes cloud SaaS.

- Transformation automatique - Il existe plus de 220 options de conversion avec un minimum de code pour répondre à toutes les exigences en matière de données.

- Surveillance et alertes — Configurez des alertes automatiques pour vous assurer que vos pipelines fonctionnent dans les délais.

- Possibilité de recevoir des données de n'importe quelle source disposant d'une API Rest — S'il n'y a pas d'API Rest, vous pouvez créer la vôtre à l'aide du générateur d'API Integrate.io.

- Assistance et consultation par téléphone ou appel vidéo.

Considérons ensuite les outils ETL d'entreprise.

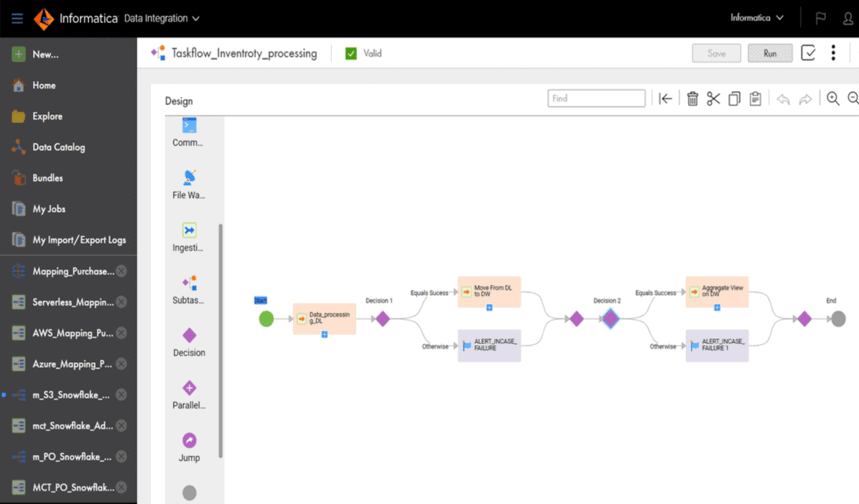

6. Centre d'alimentation Informatica

PowerCenter est une plate-forme d'intégration de données d'entreprise hautes performances développée par Informatica. La société dispose également d'une solution ETL et ELT native du cloud appelée Cloud Data Integration.

Fonctionnalités clés de PowerCenter :

- Un grand nombre de connecteurs, y compris pour les magasins de données cloud tels qu'AWS, Azure, Google Cloud et Salesforce.

- Prend en charge le traitement des données par lots et en continu.

- Une interface utilisateur graphique et des transformations prédéfinies rendent PowerCenter utile pour les professionnels non techniques, tels que les spécialistes du marketing.

- Tests et validation des données automatisés — PowerCenter avertit des erreurs et des défaillances dans le fonctionnement des pipelines de données.

- Des services supplémentaires sont disponibles pour vous permettre de concevoir, déployer et surveiller des pipelines de données. Par exemple, Repository Manager aide à gérer les utilisateurs, Designer permet aux utilisateurs de spécifier le flux de données de la source à la destination et Workflow Manager définit la séquence de tâches.

7. Intégrateur de données Oracle

Oracle Data Integrator est une plate-forme ETL d'entreprise pour la création, le déploiement et la gestion d'entrepôts de données complexes. L'outil charge et transforme les données en un entrepôt de données en utilisant les capacités de la base de données cible au lieu de s'appuyer sur un serveur ETL standard. Les connecteurs prédéfinis simplifient l'intégration en automatisant les tâches d'intégration manuelle nécessaires pour connecter les bases de données et le Big Data.

Fonctionnalités clés d'Oracle Data Integrator :

- Compatible avec des bases de données telles que Sybase, IBM DB2, Teradata, Netezza et Exadata.

- Prend en charge le travail en modes ETL et ELT.

- Trouve automatiquement les erreurs dans les données et les traite avant de les déplacer vers l'emplacement de stockage cible.

- Prise en charge intégrée du Big Data — Vous pouvez utiliser le code Apache Spark conformément aux normes du Big Data pour transformer et cartographier les données.

8. Services de données SAP

SAP Data Services est un logiciel de gestion de données d'entreprise. L'outil vous permet d'extraire des données de n'importe quelle source ainsi que de transformer, d'intégrer et de formater ces données dans n'importe quelle base de données cible. Vous pouvez l'utiliser pour créer des magasins de données ou des entrepôts de données de toute sorte.

Fonctionnalités clés de SAP Data Services :

- L'interface utilisateur graphique simplifie grandement la création et la transformation des flux de données.

- Peut fonctionner à la fois en mode batch et en temps réel.

- Prend en charge les intégrations avec Windows, Sun Solaris, AIX et Linux.

- Idéal pour évoluer, quel que soit le nombre de clients.

- La courbe d'apprentissage peu profonde et l'interface glisser-déposer permettent aux analystes de données ou aux ingénieurs de données d'utiliser cet outil sans compétences de codage particulières.

- Planification et contrôle faciles des processus ETL.

- La présence de variables permet d'éviter les tâches répétitives - Les variables permettent aux utilisateurs d'effectuer diverses actions, telles que décider des étapes à effectuer dans une tâche ou de l'environnement dans lequel la tâche doit s'exécuter, et de modifier facilement les étapes du processus sans recréer la tâche entière.

- Les fonctions intégrées (si/alors ou logique de déduplication) aident à normaliser les données et à améliorer leur qualité.

- Idéal pour les entreprises qui utilisent SAP comme système ERP.

9. IBM DataStage

IBM DataStage est un outil d'intégration de données qui vous aide à concevoir, développer et exécuter des tâches de déplacement et de transformation de données. DataStage prend en charge les processus ETL et ELT. La version de base est destinée au déploiement local. Cependant, une version cloud du service est également disponible, appelée IBM Cloud Pak for Data.

Fonctionnalités clés d'IBM DataStage :

- Grand nombre de connecteurs intégrés pour l'intégration avec les sources de données et les magasins de données (y compris Oracle, Hadoop System et tous les services inclus dans IBM InfoSphere Information Server).

- Effectuez n'importe quelle tâche ETL 30 % plus rapidement grâce à un moteur parallèle et à l'équilibrage de la charge de travail.

- L'interface conviviale et la conception assistée par l'apprentissage automatique contribuent à réduire les coûts de développement.

- Le lignage des données vous permet de voir comment les données sont transformées et intégrées.

- IBM InfoSphere QualityStage vous permet de surveiller la qualité des données.

- Particulièrement pertinent pour les entreprises travaillant avec de grands ensembles de données et les grandes entreprises.

10. Services d'intégration Microsoft SQL Server (SSIS)

SQL Server Integration Services est une plate-forme ETL d'entreprise pour l'intégration et la transformation de données. Il vous permet d'extraire et de transformer des données à partir de sources telles que des fichiers XML, des fichiers plats et des bases de données relationnelles, puis de les charger dans un entrepôt de données. Comme il s'agit d'un produit Microsoft, SSIS ne prend en charge que Microsoft SQL Server.

Fonctionnalités clés de SSIS :

- Peut utiliser les outils de l'interface graphique SSIS pour créer des pipelines sans écrire une seule ligne de code.

- Offre une large gamme de tâches et de transformations intégrées qui minimisent la quantité de code requise pour le développement.

- Peut être intégré à Salesforce et CRM à l'aide de plugins ; peut également être intégré à des logiciels de contrôle des modifications tels que TFS et GitHub.

- Capacités de débogage et gestion facile des erreurs dans les flux de données.

Considérons maintenant les outils ETL open source.

11. Studio ouvert de Talend (TOS)

Talend Open Studio est un logiciel d'intégration open-source gratuit qui permet de transformer des données complexes en informations compréhensibles pour les décideurs. Cet outil simple et intuitif est largement utilisé aux États-Unis. Il peut facilement concurrencer les produits d'autres grands acteurs.

Avec TOS, vous pouvez commencer à créer des pipelines de données de base en un rien de temps. Vous pouvez effectuer des tâches simples d'ETL et d'intégration de données, obtenir des profils graphiques de vos données et gérer des fichiers à partir d'un environnement open source installé localement.

Fonctionnalités clés de Talend Open Studio :

- Plus de 900 connecteurs pour connecter diverses sources de données — Les sources de données peuvent être connectées via l'interface graphique d'Open Studio par glisser-déposer depuis Excel, Dropbox, Oracle, Salesforce, Microsoft Dynamics et d'autres sources de données.

- Fonctionne parfaitement avec les géants du stockage cloud tels qu'Amazon AWS, Google Cloud et Microsoft Azure.

- La technologie Java permet aux utilisateurs d'intégrer plusieurs scripts provenant de bibliothèques du monde entier.

- La communauté Talend est un lieu de partage des meilleures pratiques et de découverte de nouvelles astuces que vous n'avez pas encore essayées.

12. Intégration de données Pentaho (PDI)

Pentaho Data Integration (anciennement connu sous le nom de Kettle) est un outil ETL open source appartenant à Hitachi. Le service dispose de plusieurs interfaces utilisateur graphiques pour créer des pipelines de données. Les utilisateurs peuvent concevoir des tâches et des transformations de données à l'aide du client Spoon PDI, puis les exécuter à l'aide de Kitchen.

Fonctionnalités clés de Pentaho Data Integration :

- Disponible en deux versions : Community et Enterprise (avec fonctionnalités avancées).

- Peut être déployé dans le cloud ou sur site, bien qu'il soit spécialisé dans les scénarios de lots locaux pour ETL.

- Interface utilisateur graphique pratique avec fonctionnalité glisser-déposer.

- La bibliothèque partagée simplifie l'exécution ETL et le processus de développement.

- Fonctionne sur la base de procédures ETL stockées au format XML.

- Diffère des concurrents en ce qu'il ne nécessite pas de génération de code.

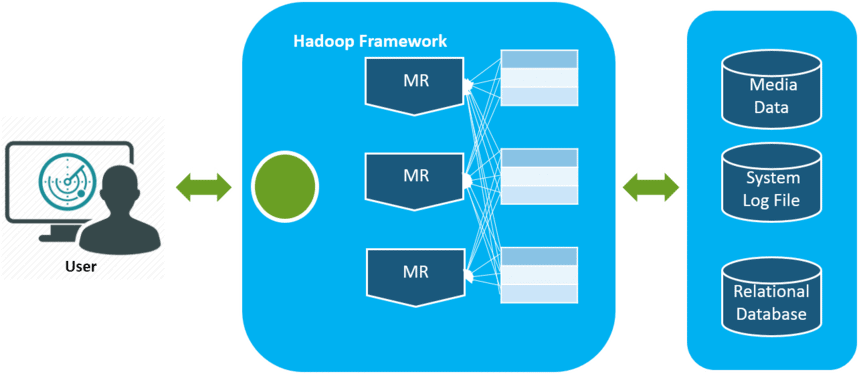

13. Apache Hadoop

Apache Hadoop est une plate-forme open source pour le traitement et le stockage de grandes quantités de données en répartissant la charge informatique sur des clusters informatiques. Le principal avantage de Hadoop est l'évolutivité. Il passe en toute transparence d'une exécution sur un seul nœud à des milliers de nœuds. De plus, son code peut être modifié en fonction des besoins de l'entreprise.

Fonctionnalités clés de Hadoop :

- Open-source basé sur des applications Java et donc compatible avec toutes les plateformes.

- Tolérance aux pannes — Lorsqu'un nœud tombe en panne, les données de ce nœud peuvent être facilement restaurées à partir d'autres nœuds.

- Plusieurs copies des données signifient qu'elles seront disponibles même en cas de panne matérielle.

- Pas besoin d'un client informatique distribué, car le framework s'occupe de tout.

14. Intégration de données Skyvia

Skyvia est la plate-forme de données cloud tout-en-un de Devart pour l'intégration, la gestion, la sauvegarde et l'accès aux données.

Skyvia Data Integration est un outil ETL et ELT sans code pour divers scénarios d'intégration de données. Il fonctionne avec les fichiers CSV, les bases de données (SQL Server, Oracle, PostgreSQL, MySQL), le stockage en nuage (Amazon Redshift, Google BigQuery, Snowflake) et les applications (Salesforce, HubSpot, Dynamics CRM et bien d'autres).

Fonctionnalités clés de l'intégration de données Skyvia :

- Travailler avec le cloud vous évite des mises à jour ou des déploiements manuels.

- Vous permet d'importer des données dans des applications et des bases de données cloud, de répliquer des données cloud et de les exporter vers un fichier CSV pour les partager.

- Crée une synchronisation de données entièrement personnalisable — Vous décidez exactement ce que vous voulez extraire, y compris les champs et objets personnalisés.

- La création d'intégrations ne nécessite pas de connaissances techniques particulières.

- Possibilité d'exécuter automatiquement des intégrations selon un calendrier

- Importation de données sans doublon avec synchronisation bidirectionnelle.

- Modèles prêts à l'emploi pour les scénarios d'intégration de données courants.

15. Jaspersoft

Jaspersoft ETL est le logiciel open source de Jaspersoft, indépendant des données et de l'architecture. Cela signifie que vous pouvez vous connecter aux données de n'importe quelle source et les utiliser n'importe où : sur site, dans le cloud ou dans un environnement hybride. De plus, vous pouvez apporter des modifications au code source de Jaspersoft en fonction de vos besoins.

L'outil Jaspersoft fait partie de la suite Jaspersoft Business Intelligence, qui offre une plateforme de Business Intelligence personnalisable, flexible et conviviale pour les développeurs.

Fonctionnalités clés de Jaspersoft :

- Intégration avec les systèmes de gestion de données standard (Hadoop, Google Analytics et Cassandra), les applications (SugarCRM, SAP, Salesforce) et les environnements Big Data (Hadoop, MongoDB).

- Peut être déployé à la fois localement et dans le cloud.

- L'interface utilisateur graphique permet à l'utilisateur de concevoir, planifier et exécuter facilement le déplacement et la transformation des données.

- Le tableau de bord d'activité permet de surveiller l'exécution des tâches ETL et les performances de l'outil.

- Application mobile où vous pouvez consulter vos données de n'importe où et à tout moment.

Courte conclusion

Les volumes de données collectées par les entreprises augmentent chaque jour et continueront de croître. Pour l'instant, travailler avec des bases de données locales et le chargement par lots est suffisant, mais très bientôt, cela ne satisfera plus les besoins des entreprises. Ainsi, la possibilité de faire évoluer les processus ETL est pratique et particulièrement pertinente pour les analyses avancées.

Lorsqu'il s'agit de choisir un outil ETL, pensez aux besoins spécifiques de votre entreprise. Si vous travaillez localement et que vos données sont prévisibles et ne proviennent que de quelques sources, un outil ETL traditionnel suffira. Mais n'oubliez pas que de plus en plus d'entreprises migrent vers une architecture cloud ou hybride.

Nos clients

grandir 22 % plus rapide

Développez-vous plus rapidement en mesurant ce qui fonctionne le mieux dans votre marketing

Analysez votre efficacité marketing, trouvez les zones de croissance, augmentez le ROI

Obtenir une démo