Que faire si votre classement Google baisse

Publié: 2021-08-12Le trafic de votre site Web a chuté .

Vous vérifiez vos analyses et votre recherche organique a chuté du jour au lendemain.

Vous consultez Google, et votre site n'apparaît plus en haut — attendez, non, il n'est même plus sur la première page !

PANIQUE.

C'est sérieux .

Pas de trafic = pas de prospects et pas de ventes = pas de revenus = pas d'affaires .

Cela semble horrible, n'est-ce pas?

J'espère que ce n'est pas la position dans laquelle vous vous trouvez ce matin. Mais si c'est le cas, pas de panique . Il y a une raison. Nous avons juste besoin de le trouver.

Dans cet article, j'expliquerai exactement ce que vous pouvez faire pour vérifier pourquoi votre classement Google a baissé et ce que vous pouvez faire à ce sujet si c'est le cas.

Tout d'abord, ne paniquez pas

N'ayez pas peur .

Vous êtes (à juste titre) préoccupé par votre classement et votre trafic perdus, mais il y a un ciel bleu devant vous. Les baisses de classement sont rarement permanentes. Au contraire, ils sont une excellente occasion de prendre du recul et de revoir votre stratégie d'optimisation pour les moteurs de recherche (SEO), qui a souvent été créée des années auparavant et suivie sans aucune modification pour les modifications que Google apporte à son algorithme.

Avec une analyse correcte et une stratégie révisée, il est tout à fait possible d'inverser une baisse de classement, et à la fin de cet article, vous en saurez un peu plus sur la façon d'y parvenir.

Voyons donc pourquoi votre classement Google a chuté.

Avis de baisse de classement en direct

Regardez la rediffusion de notre diffusion en direct "Que faire si votre classement Google baisse", où j'ai été rejoint par notre responsable du référencement, Andy Tuxford.

Pourquoi votre classement Google a chuté

Il y a trois raisons pour lesquelles le classement de vos mots clés a chuté :

- Google a mis à jour son algorithme

- Vos concurrents ont amélioré leur jeu SEO

- Un accident s'est produit

Jetons un coup d'œil à chacun de ceux-ci plus en détail.

Google a mis à jour son algorithme

L'algorithme de recherche de Google n'est pas qu'un seul algorithme ; c'est une série d'algorithmes. Au fil des ans, chaque consultant SEO avec un clavier a spéculé sur le nombre de facteurs de classement qu'il contient.

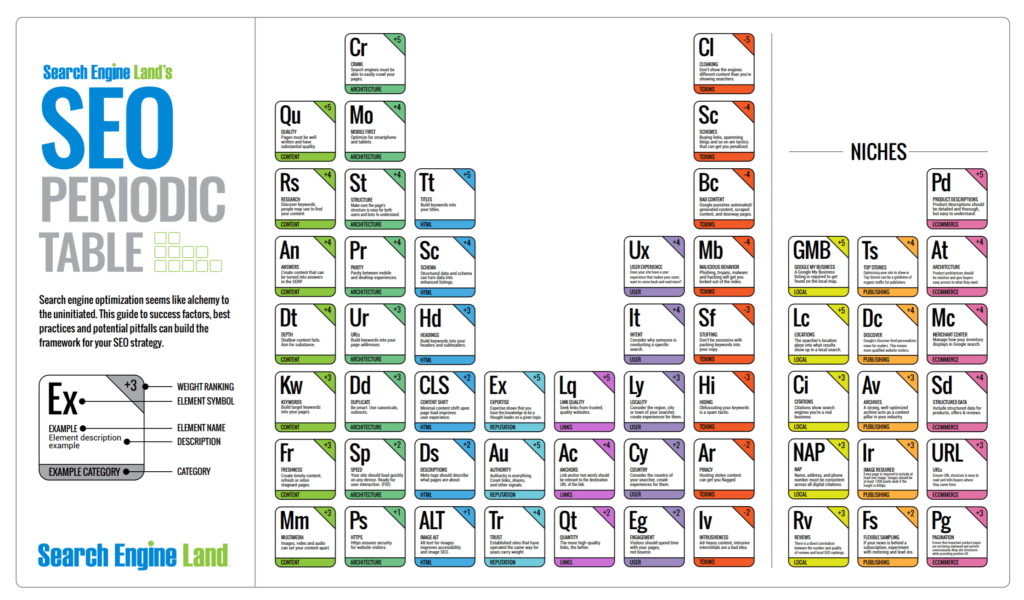

Recherchez « facteurs de classement google », et vous verrez plus de 25 000 résultats qui mentionnent les « 200 facteurs de classement » (supposés) de Google. Mais la réalité est qu'entre tous les algorithmes de Google dans sa "série d'algorithmes", le nombre total de "facteurs de classement" se compte probablement en milliers.

C'est un peu amusant

Bien qu'il soit impossible de répertorier avec précision les milliers de facteurs d'algorithmes probables, ce "tableau périodique SEO" de l'équipe Search Engine Land est assez amusant.

Vous pouvez télécharger le rapport complet du tableau périodique SEO ici.

Avec autant d'algorithmes et de "facteurs" en jeu, il n'est pas surprenant que Google teste et apporte des modifications à un certain nombre d'entre eux quotidiennement - parfois juste pendant quelques jours, et parfois seulement pour une poignée de pays ou de langues.

Votre site Web a peut-être été pris dans un test.

Si tel est le cas, vous pourriez voir votre classement revenir dans une semaine environ.

D'un autre côté, il aurait pu y avoir une large mise à jour du noyau .

Qu'est-ce qu'une mise à jour Broad Core ?

Une mise à jour de base étendue est une mise à jour importante des algorithmes de Google.

Google a depuis longtemps apporté de grands changements périodiques à son algorithme. Les deux plus notables d'entre elles étaient la mise à jour Panda de 2011 et la mise à jour Penguin de 2012. Cependant, depuis août 2018 (lorsque la «Mise à jour médicale» a été abandonnée), Google fait référence à ses mises à jour d'algorithmes plus importantes sous le nom de «Broad Core Updates».

En savoir plus sur la mise à jour Medic et EAT

En 2018, j'ai fait une conférence lors d'un événement exclusif Exposure Ninja où j'ai expliqué ce qu'était la mise à jour Medic, comment elle a changé le paysage du référencement et ce qu'était EAT (plus, comment l'optimiser).

Vous pouvez regarder cette conférence dans son intégralité ici ou vous pouvez en savoir plus sur Medic Update et EAT via ces deux articles de blog :

- Qu'est-ce que la mise à jour de l'algorithme Medic ?

- Qu'est-ce que EAT ? (et pourquoi c'est si important pour le référencement)

Google est assez discret sur ce qu'il essaie de réaliser avec chaque mise à jour générale du noyau, contrairement aux mises à jour Panda et Penguin, ce qui laisse un grand vide pour la spéculation de la communauté SEO.

Il a été constaté que les mises à jour générales de base ont un impact sur des industries entières (comme l'a fait la Medic Update en 2018) ou affectent des éléments spécifiques, tels que les backlinks, la qualité du contenu ou la fiabilité de l'éditeur ou de l'auteur du contenu publié.

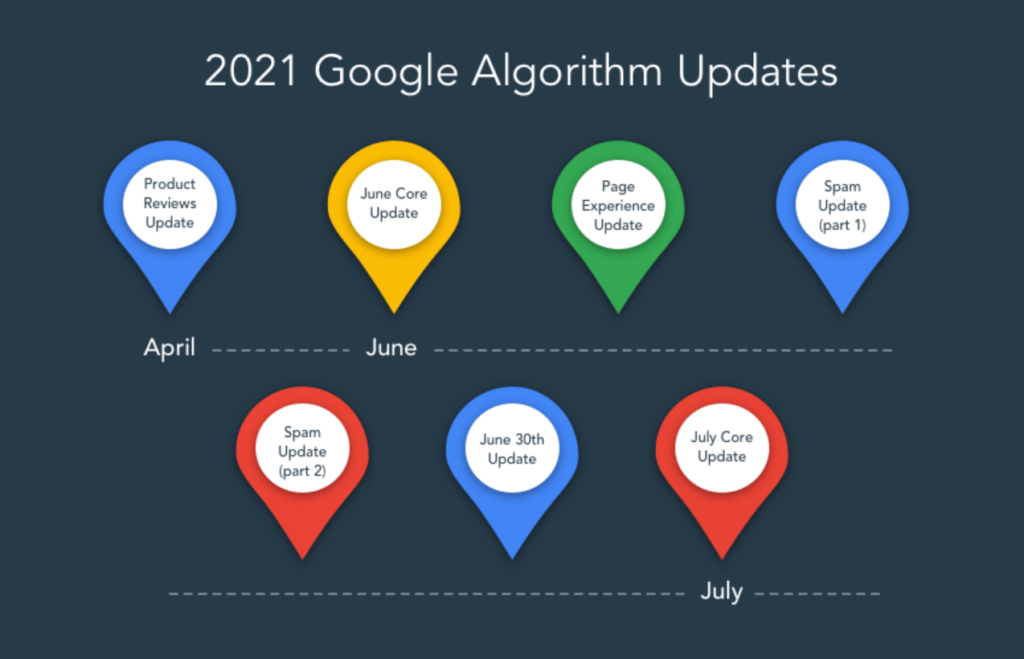

Ces mises à jour ont tendance à tomber tous les trois à six mois ou, comme cela a été le cas à l'été 2021, divisées en deux mises à jour distinctes réparties sur deux mois. Leur déploiement complet peut prendre jusqu'à deux semaines.

Nous avons vu à partir de mises à jour de base générales que, si un site Web voit son classement diminuer (ou augmenter), il n'est pas rare que ces changements de classement soient annulés lors de la prochaine mise à jour générale de base .

Il est donc d'autant plus important que votre site Web soit toujours bien optimisé, et si vous avez constaté une baisse de classement, vous suivez les contrôles de baisse de classement plus loin dans cet article.

Si Google n'a pas mis à jour son ou ses algorithmes, votre baisse de classement pourrait être la conséquence de l'intensification de votre jeu SEO par vos concurrents.

Image via huckabuy.com

Vos concurrents se sont améliorés

C'est facile d'être au sommet si personne d'autre n'est en compétition. Mais si vos concurrents entrent dans le combat et commencent à investir dans leur référencement, la première place n'est plus garantie.

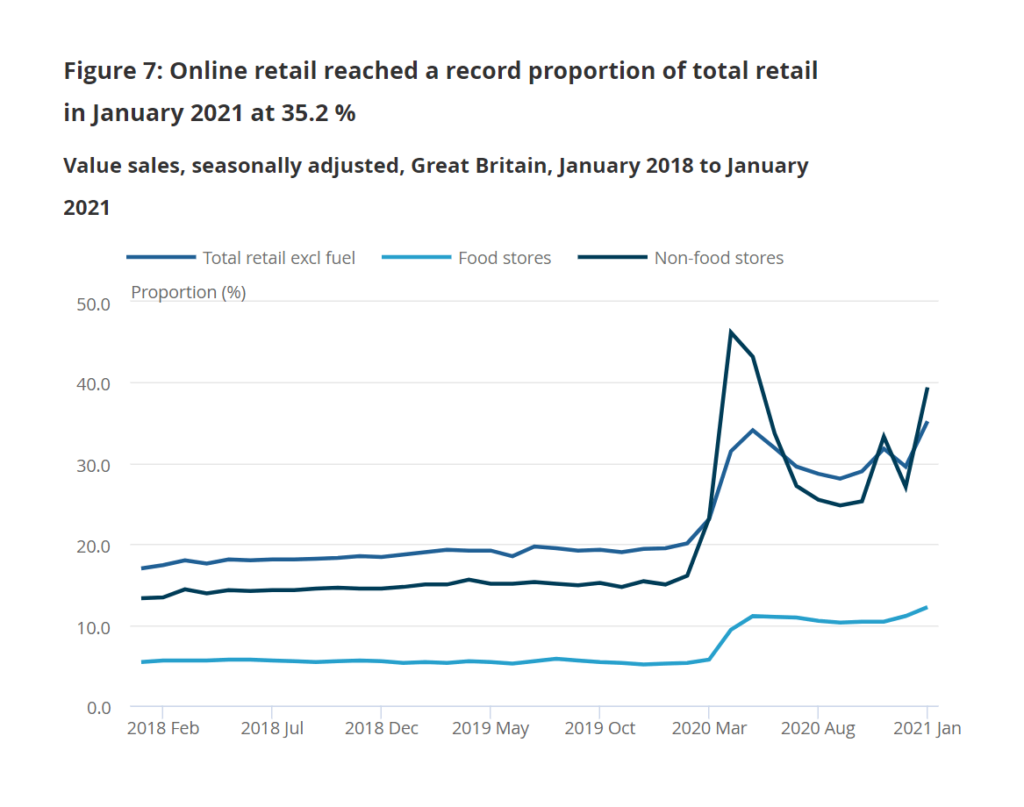

Il était facile de se classer au sommet de Google pendant longtemps, car moins d'entreprises comptaient sur Google pour gagner de nouveaux prospects et de nouvelles ventes. Mais alors que les gens sont devenus plus natifs du numérique et poussés par les verrouillages forcés à acheter en ligne (la proportion des dépenses en ligne est passée de 19,5 % en janvier 2020 à 35,2 % en janvier 2021), les entreprises prennent le marketing numérique plus au sérieux et ont adopté une approche numérique. première approche.

Tiré du site Web de l'Office for National Statistics

Avec le bon investissement et une stratégie de référencement basée sur l'expérience, vos concurrents pourraient améliorer considérablement leur classement dans les moteurs de recherche en six à douze mois.

Si vous voyez les mêmes sites Web concurrents apparaître en haut de Google pour un certain nombre de vos principales cibles de requête de recherche (c'est-à-dire des expressions de mots clés), cela peut en être la raison.

Si Google n'a pas mis à jour son algorithme et que vos concurrents ne mènent pas de campagnes de référencement solides, l'autre cause principale d'une baisse de classement est l'erreur humaine.

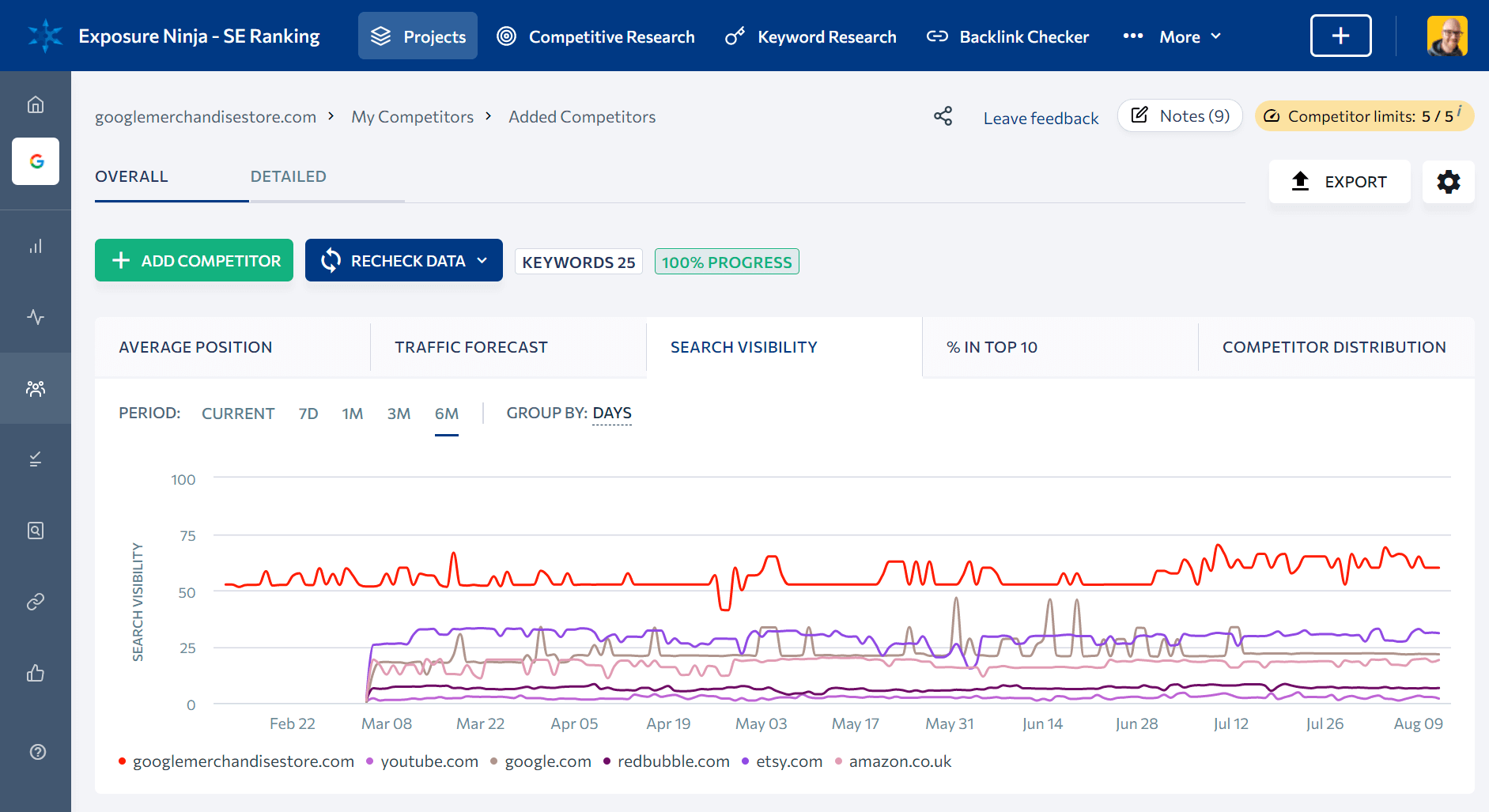

Vous pouvez facilement suivre le classement Google de votre concurrent en utilisant des trackers de classement comme SE Ranking

Un accident s'est produit

Nous faisons tous des erreurs. Aucun de nous n'est parfait.

Messi ne marque pas de but à chaque coup qu'il prend = pas parfait .

Serena Williams ne réussit pas à chaque service d'ouverture (bien qu'elle détienne le record du plus grand nombre d'as dans un tournoi ) = pas parfaite .

Et je n'écris pas toujours des articles de blog définissant l'industrie (bien que j'essaie) = pas parfait .

Nous faisons tous des erreurs, et nous avons tous des accidents aussi - et, malheureusement, les accidents avec un site Web peuvent les faire chuter dans le classement de Google.

J'expliquerai comment vérifier certains de ces accidents plus tard, mais deux des pires que vous puissiez avoir sont :

- Empêcher Google d'explorer votre site Web

- Dire à Google de ne pas indexer les pages de votre site Web (ou l'ensemble, dans certains cas)

Heureusement, vous pouvez inverser ces accidents et les classements (généralement) reviennent assez rapidement par la suite.

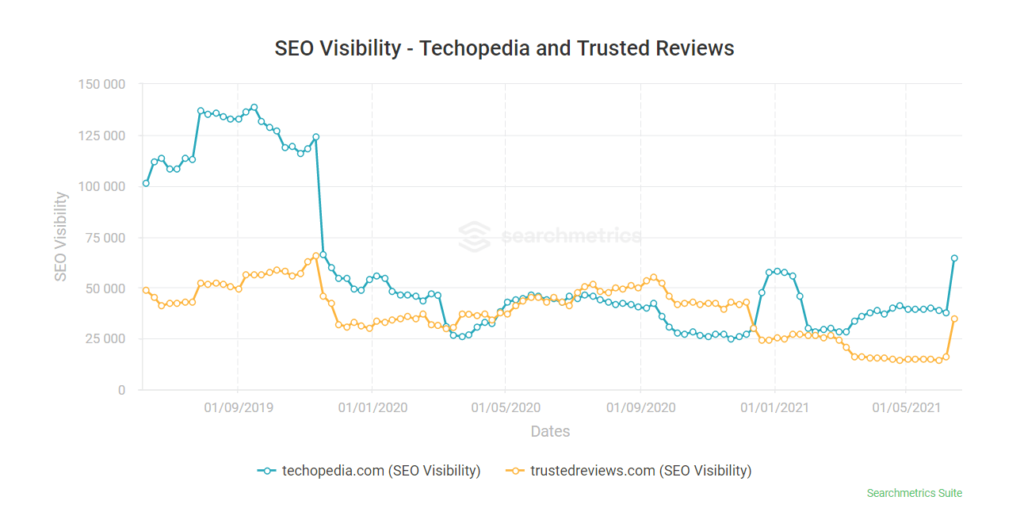

Ce graphique de l'outil de référencement, Searchmetrics, montre un exemple fantastique d'une chute spectaculaire du classement du jour au lendemain

Accédez au sommet de Google gratuitement

Comment vérifier si une mise à jour d'algorithme vous a affecté

La mise à jour de son algorithme par Google est la cause la plus fréquente de baisse du classement des mots clés. Je vais donc commencer par vous montrer comment vous pouvez savoir si vous en avez été affecté.

La première chose à faire est de vérifier directement auprès de Google.

Vérifiez auprès de la liaison publique de Google

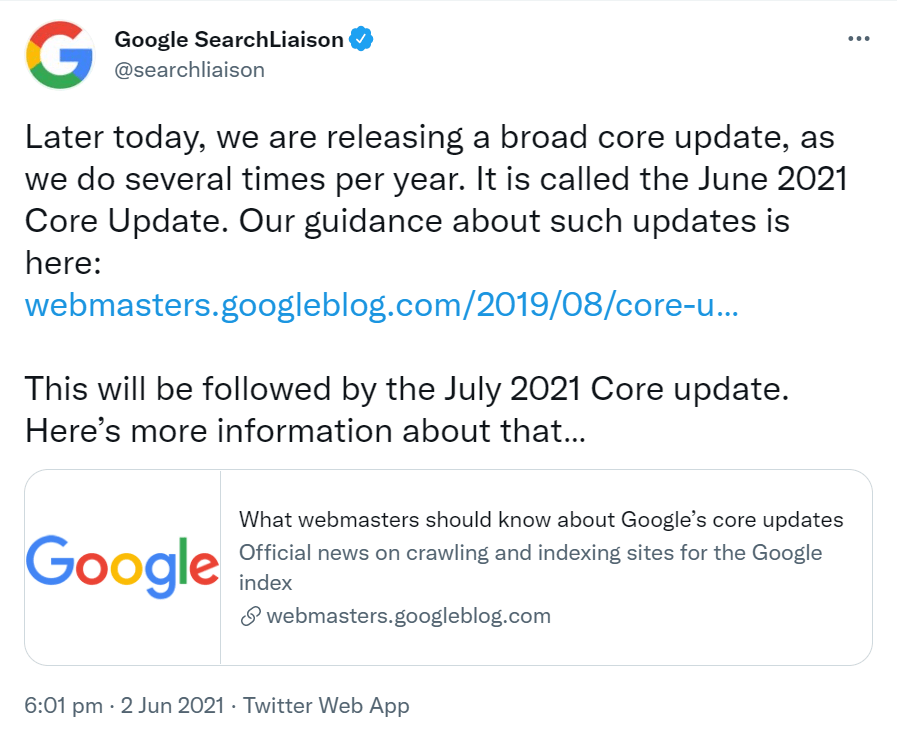

Google a introduit un rôle de liaison publique pour la recherche vers la fin de 2017. Son rôle est de tenir le public informé du fonctionnement de la recherche et de la manière dont Google s'améliore continuellement pour être plus utile et efficace pour ses utilisateurs.

Le compte Twitter du rôle, @searchliaison, est toujours la première chaîne officielle à annoncer le début des mises à jour notables de l'algorithme. Si vous voulez savoir si une mise à jour importante de l'algorithme s'est produite, leur compte est le premier endroit que vous devriez vérifier.

Cependant, il existe plusieurs façons non officielles de détecter et de discuter des mises à jour d'algorithmes.

Vous pouvez suivre toutes les mises à jour de Google Search Liaison sur Twitter

La première façon est de vérifier le compte Twitter de Barry Schwartz.

Barry rend compte de chaque mise à jour d'algorithme, même si le bavardage initial à leur sujet provient des propriétaires et des gestionnaires de sites Web sur les forums SEO.

Si vous pensez que votre classement ne se comporte pas normalement, le compte de Barry est un excellent endroit pour vérifier d'abord si une mise à jour de l'algorithme a été détectée.

Un exemple typique de la couverture de mise à jour de l'algorithme de Barry

Le ou les prochains endroits à vérifier sont les trackers d'algorithmes.

Vérifier les traqueurs d'algorithmes

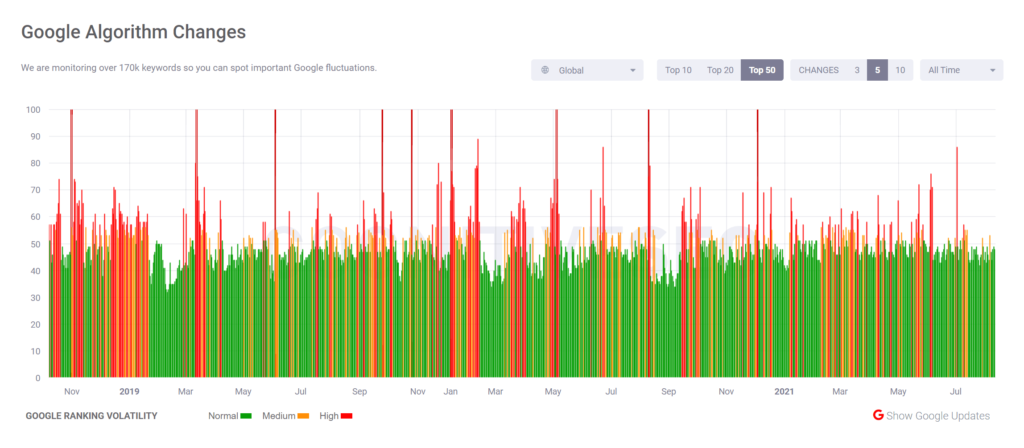

Les trackers d'algorithmes surveillent les résultats de recherche de Google pour détecter les changements de classement de milliers d'expressions de mots clés. Certains suivent même le nombre d'adresses HTTPS incluses ou si la conception des pages de résultats a changé de quelque manière que ce soit.

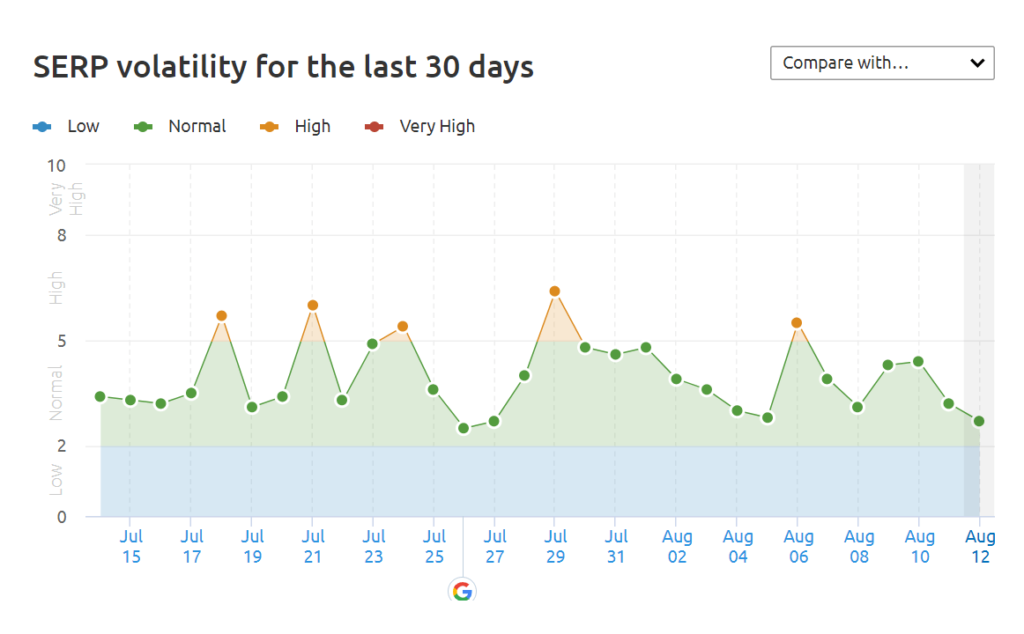

Vous pouvez utiliser des dizaines de trackers pour vérifier si l'algorithme est dans un état de flux ou non, le capteur de Semrush étant la préférence de notre agence.

Alternativement, vous pouvez essayer :

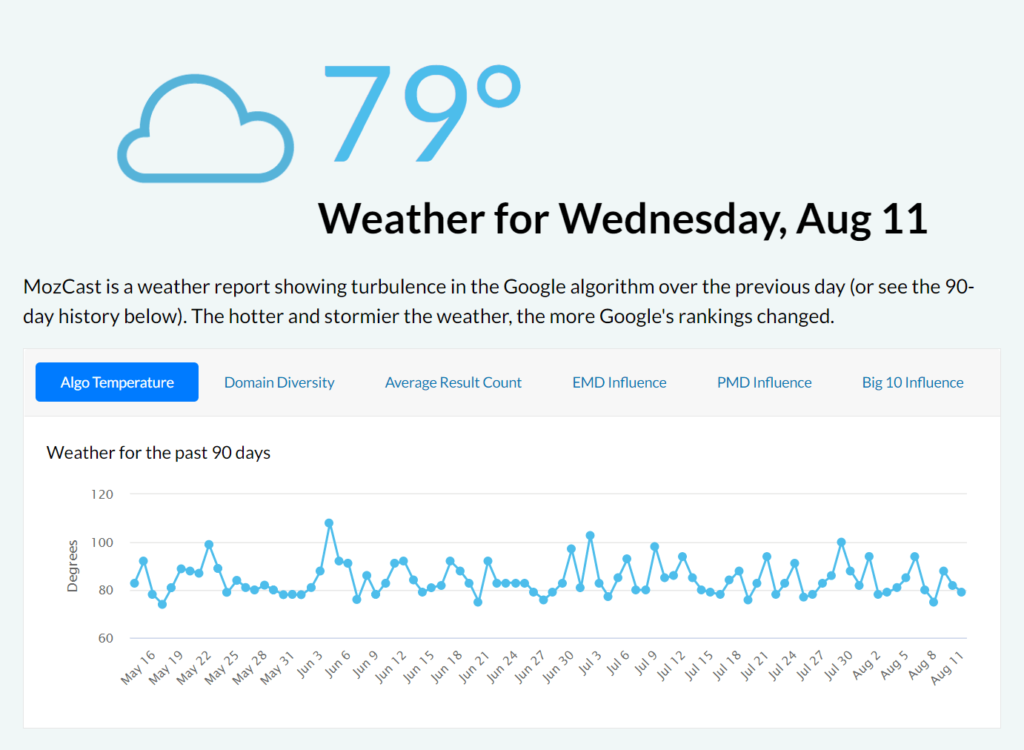

- MozCast de Moz

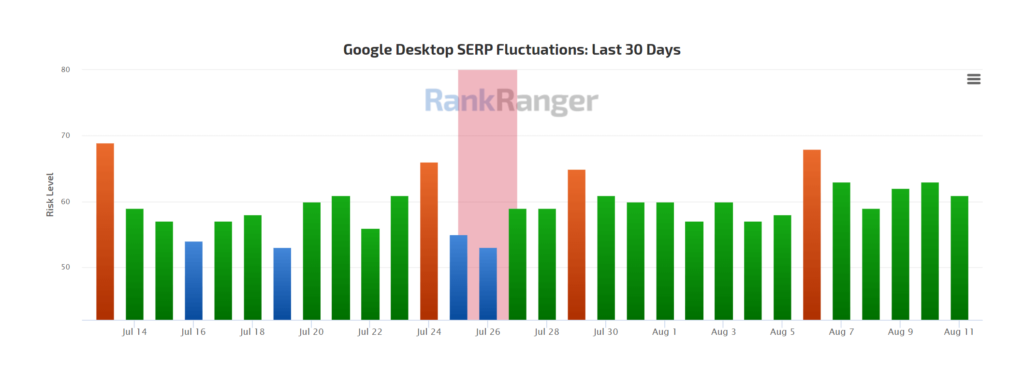

- Fluctuations SERP de RankRanger

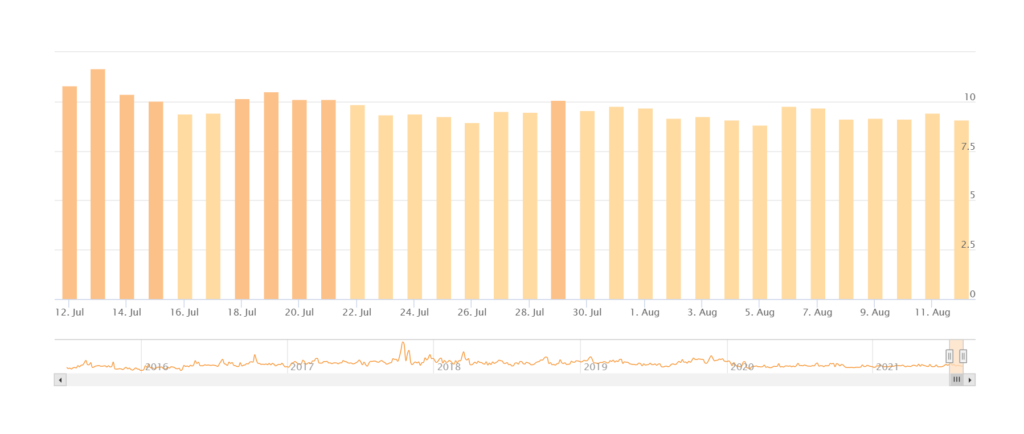

- Note grincheuse d'Accuranker

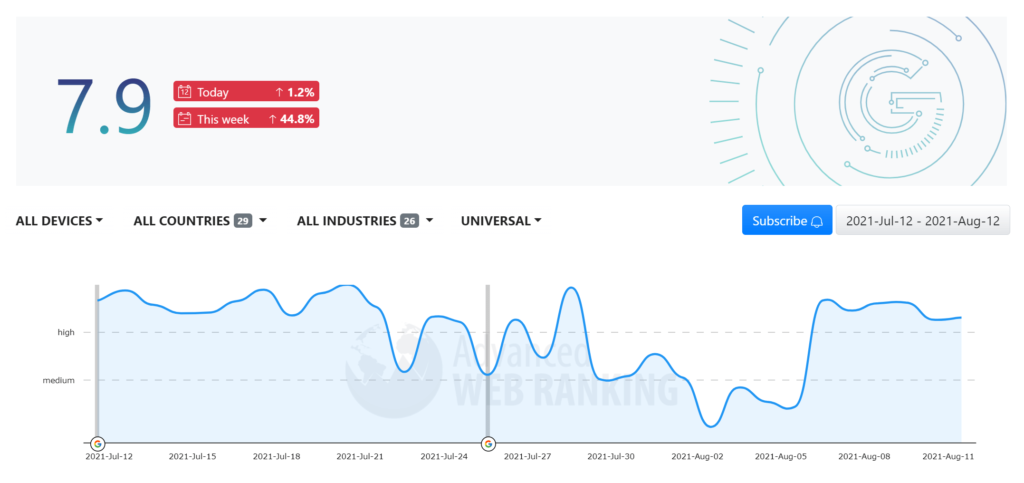

- Traqueur de changement d'algorithme d'Advanced Web Ranking

- Signaux de CognitiveSEO

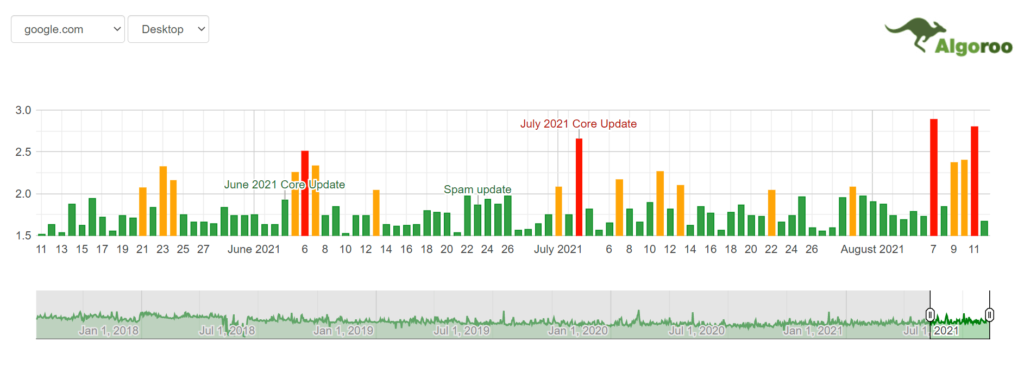

- Algoroo de Dejan Marketing

Supposons que votre logiciel d'analyse vous indique que le trafic de recherche organique de votre site Web a chuté le jour même où l'un des trackers ci-dessus indique que l'algorithme de Google était dans un état de forte fluctuation. Dans ce cas, il est assez sûr de dire qu'une mise à jour de l'algorithme a eu un impact sur votre site Web.

Capteur de Semrush

Mozcast de Moz

Indice de risque de classement de RankRanger

Note grincheuse d'Accuranker

Traqueur de changement d'algorithme d'Advanced Web Ranking

Signaux de CognitiveSEO

Algoroo de Dejan Marketing

Comment vérifier les anciennes mises à jour d'algorithmes

Vous regardez peut-être plus loin dans le temps dans votre logiciel d'analyse et vous constatez une diminution du trafic de recherche au-delà de la période que les trackers d'algorithme ci-dessus suivent (généralement 30 jours). Dans ce cas, vous pouvez recouper la date de la diminution avec les journaux d'historique de l'algorithme conservés par plusieurs fournisseurs de logiciels, consultants et agences SEO différents.

Nous recommandons le journal d'historique des algorithmes de Marie Haynes, qui est mis à jour régulièrement.

Suivi de l'historique des mises à jour de l'algorithme Google de Marie Haynes Consulting

Vous pouvez également essayer (ou croiser) ces autres journaux :

- Historique de mise à jour de l'algorithme Google de Moz

- Mises à jour de l'algorithme Google de RankRanger

- Mises à jour de l'algorithme Google de Search Engine Land

- Historique de mise à jour de l'algorithme Google de Linkgraph

Mais la meilleure façon de vérifier si une mise à jour de l'algorithme historique a eu un impact sur votre site Web est d'utiliser un outil appelé Panguin Tool (que j'adore beaucoup).

Panguin Tool superpose votre trafic organique aux mises à jour d'algorithmes qu'il enregistre dans sa base de données. Si vous constatez une baisse des visites organiques immédiatement après l'une des lignes indicatrices de l'outil, vous pouvez alors supposer en toute sécurité que la mise à jour est la cause de la baisse.

Et, si Google n'a pas été ouvert sur ce qui a changé dans la mise à jour de l'algorithme, vous pouvez compter sur plusieurs analystes SEO et éditeurs de logiciels pour spéculer sur ce qui a pu se passer.

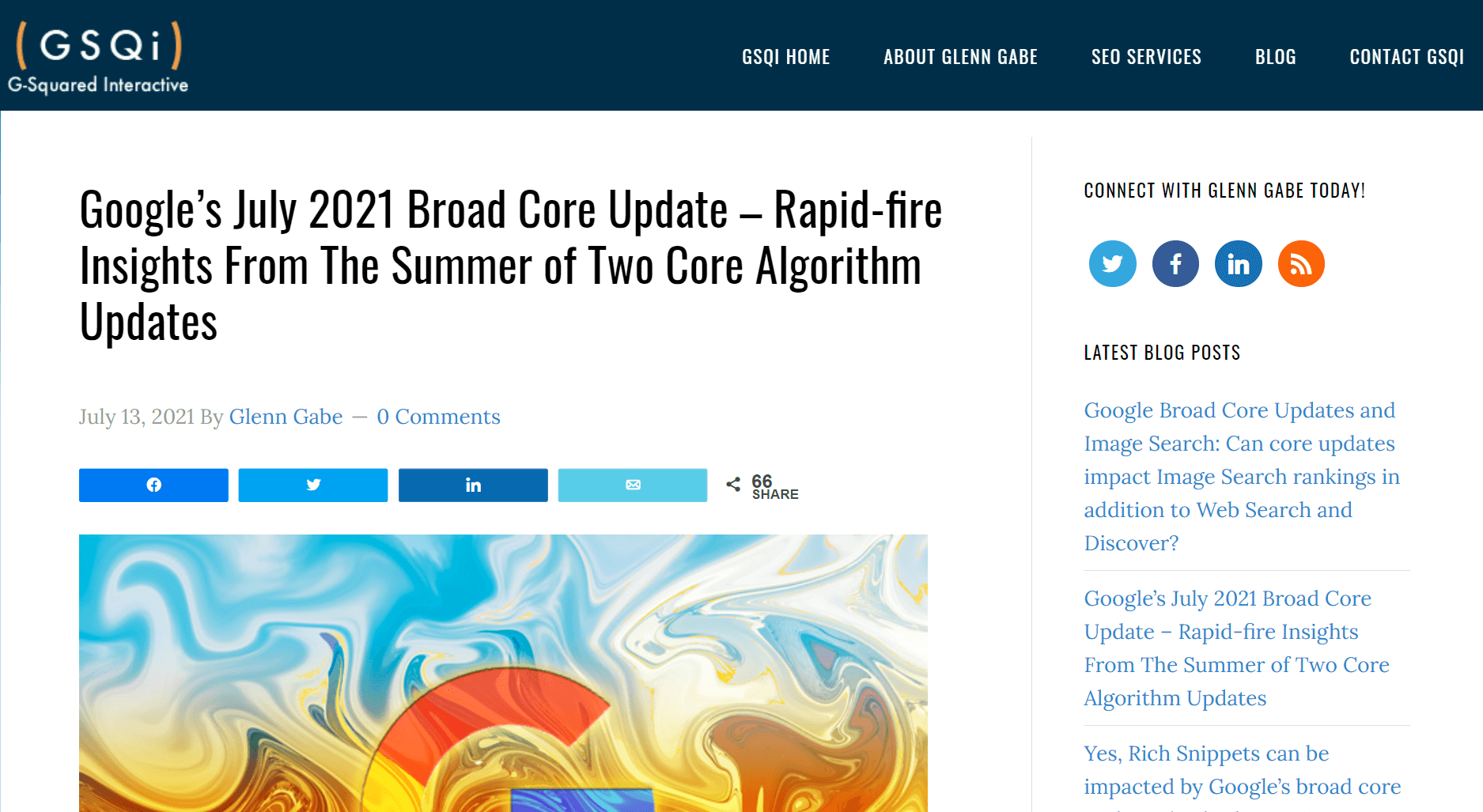

Glenn Gabe possède certaines des meilleures analyses d'algorithmes disponibles, et les sociétés de logiciels Sistrix et Searchmetrics produisent également régulièrement les meilleures analyses basées sur les données.

Un exemple de l'une des fantastiques analyses de mise à jour de base de Glenn

Que dois-je faire si mon classement baisse

Comme pour toute mise à jour logicielle, Google peut annuler certaines de ses modifications quelques semaines après la modification de l'algorithme. Ainsi, si vous avez eu une diminution (ou une augmentation) du classement, vous pourriez le voir s'inverser avant que des dommages durables ne soient causés.

Cela dit, depuis que les mises à jour de Broad Core sont devenues une chose, il est devenu de plus en plus courant que les changements de classement ne soient pas annulés avant la prochaine mise à jour de Broad Core (ou celle qui suit).

A chaque nouvelle mise à jour Broad Core, nous lisons de nouvelles analyses de sites qui ont été lourdement pénalisés lors d'une grosse mise à jour six ou douze mois auparavant, ce qui met en évidence deux choses :

- Cela peut prendre beaucoup de temps pour inverser les baisses de classement

- Le meilleur moment pour prendre des mesures pour inverser une baisse est maintenant

Si le classement de votre site Web a chuté, vous devez prendre des mesures immédiates pour l'inverser.

Vous n'avez peut-être rien fait de "mal" (c'est-à-dire quelque chose d'interdit par les directives de Google pour les webmasters), comme Black Hat SEO, mais il est fort probable que Google ait détecté quelque chose qu'il n'aime pas, et vous devrez corriger cela.

Vous devez examiner votre site Web et vous assurer qu'il n'y a pas de problèmes importants qui auraient pu causer une baisse.

Jetons un coup d'œil aux douze choses que vous devriez vérifier en premier.

Que vérifier sur votre site Web

- Votre site internet est-il indexé ?

- Votre site Web est-il explorable ?

- L'adresse IP de Googlebot est-elle bloquée ?

- Y a-t-il des balises noindex ou nofollow accidentelles ?

- Existe-t-il des redirections HTTP(S) erronées ?

- Existe-t-il des balises canoniques incorrectes ?

- Existe-t-il des balises hreflang incorrectes ?

- Votre site Web est-il adapté aux mobiles ?

- Votre site Web a-t-il des erreurs de crawl ?

- Votre site Web est-il sain?

- Votre site Web a-t-il fait l'objet d'une action manuelle ?

- Avez-vous perdu des backlinks ?

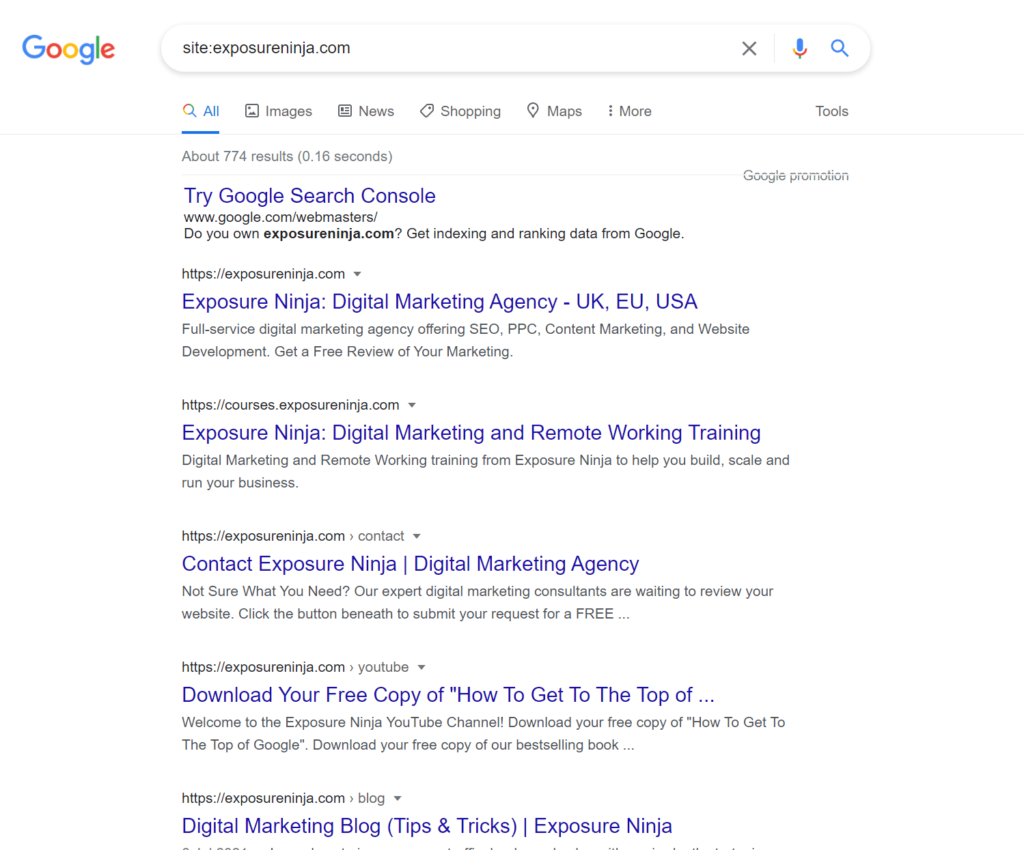

1. Votre site Web est-il indexé ?

Si votre classement a chuté pour une requête de recherche, cela pourrait être symptomatique de la suppression complète de toutes vos pages de l'index.

Le meilleur moyen de vérifier est via un site : rechercher dans Google.

Pour faire un site : tapez site:votrenomdedomaine.com dans Google, et les résultats vous montreront toutes vos pages ou ne vous montreront rien du tout.

Si vous ne voyez rien du tout, votre site Web a été retiré de l'index.

Cela peut généralement prendre un certain temps pour que les URL soient supprimées de l'index de Google, mais il n'est pas rare qu'un site Web soit entièrement supprimé de l'index en raison d'une erreur sur le site Web.

L'un des défauts les plus courants est un site Web indiquant à tort à Google de ne pas explorer le site Web, couvert ensuite.

2. Votre site Web est-il crawlable ?

Si le robot d'exploration Web de Google (Googlebot) n'est pas autorisé à explorer votre site Web, il ne saura pas que vous souhaitez qu'il soit répertorié dans son index.

Logique, non ?

Si votre site Web, intentionnellement ou accidentellement, indique à Google de ne pas explorer votre site Web, il ne le fera normalement pas. Ils ont tendance à respecter les règles comme ça (mais, si nous sommes honnêtes, ce n'est pas garanti).

La plupart des sites Web ont un fichier robots.txt, en particulier ceux construits avec des systèmes de gestion de contenu, comme WordPress.

Ce simple document texte indique aux robots Web (robots) s'ils peuvent explorer un site Web ou non et s'ils doivent ignorer les pages qu'il contient.

Cependant, bien que ce fichier soit incroyablement simple, il est également incroyablement sensible aux erreurs .

Lorsqu'il est modifié de manière incorrecte, le fichier robots.txt peut avoir un impact important sur un site Web et faire disparaître des sections entières du site Web - ou l'intégralité du site Web - des résultats de recherche de Google.

Nous vous recommandons de ne pas "jouer" avec quelqu'un d'autre que quelqu'un qui a de l'expérience dans ce domaine, comme un spécialiste du référencement (vous savez, comme ceux de notre équipe).

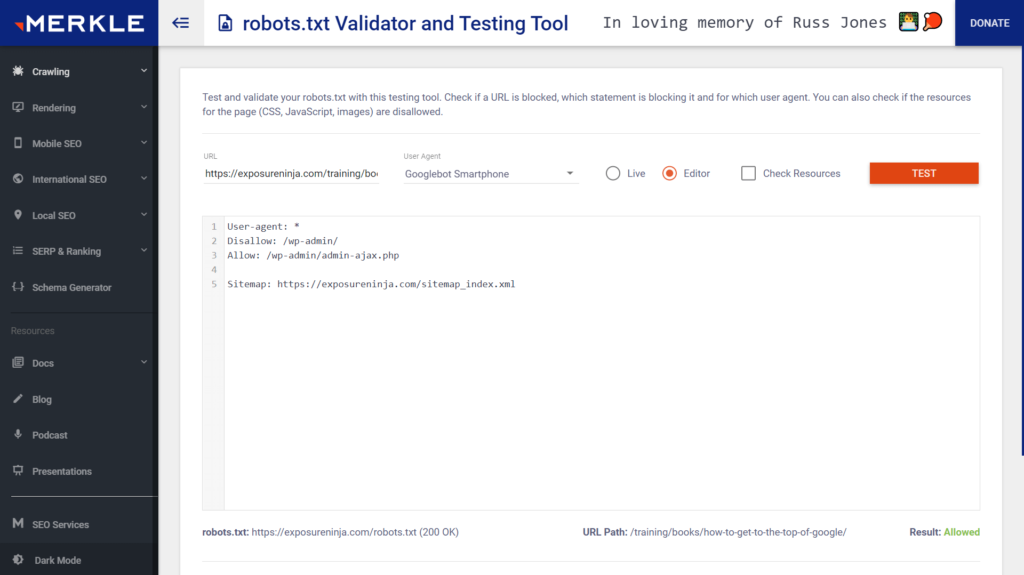

Si vous devez absolument le mettre à jour vous-même, je vous recommande de lire attentivement à ce sujet au préalable et de le tester avec un outil de test robots.txt, comme celui-ci fantastique construit par l'équipe de Merkle.

L'outil de test robots.txt de Merkle est incroyablement utile

Un autre outil de test de robots.txt est l'outil d'exploration Web SEO Spider de Screaming Frog (voici leur guide pratique).

Voici mes guides préférés pour comprendre le fonctionnement du fichier robots.txt :

- Robots.txt pour le référencement : le guide ultime

- Robots.txt et SEO : tout ce que vous devez savoir

- Qu'est-ce que le fichier Robots.txt ?

Accédez au sommet de Google gratuitement

3. L'adresse IP de Googlebot est-elle bloquée ?

Googlebot visite les sites Web de la même manière que vous et moi. Il visite une page via un "navigateur" (en quelque sorte) et s'attend à voir ce que vous et moi voyons. La seule différence est qu'il s'exécute à partir d'un serveur dans un entrepôt et non à partir d'un bureau.

Googlebot fonctionne principalement à partir de serveurs aux États-Unis, mais il fonctionne également à partir de serveurs dans le monde entier. Il le fait pour une raison précise : si votre site Web modifie ce qu'il montre à un visiteur, en fonction de l'emplacement d'où il visite , Googlebot doit le savoir et voir la différence.

Par exemple, si vous possédez un site Web qui dessert à la fois les marchés américain et européen, vous afficherez probablement des produits et des prix différents sur l'un ou l'autre marché en fonction de l'adresse IP de l'acheteur. Google doit voir ces différences. Ils visitent donc votre site Web à partir d'un serveur basé en Europe au lieu d'un serveur basé en Amérique du Nord.

C'est logique, non?

Supposons maintenant que le serveur de votre site Web bloque les visiteurs d'Europe à cause du GDPR (ick). Non seulement ces visiteurs seraient bloqués, mais Googlebot le serait aussi .

Si Googlebot ne peut pas voir vos produits et prix européens, il peut choisir de faire l'une des deux choses suivantes :

- Afficher les produits et les prix américains à la place dans les résultats de recherche Ce serait mauvais pour l'expérience client, car les personnes visitant l'Europe verraient très probablement une page d'avertissement « Je suis désolé, à cause du RGPD, nous ne pouvons pas vous montrer ce site Web »

- Ne pas afficher du tout votre site Web dans les résultats de recherche

Google a une très courte page sur la diffusion de "pages adaptées aux paramètres régionaux" et sur la manière dont Googlebot les explore à partir de différents emplacements/adresses IP. Cela vaut la peine de vérifier.

Vous ne devriez donc vraiment pas bloquer les adresses IP, en particulier les adresses IP de Google.

Si vous souhaitez vérifier si votre site Web les bloque, vous devez en parler à votre développeur et éventuellement à votre hébergeur. Ils peuvent effectuer des vérifications pour voir si des blocages IP sont en place, notamment en effectuant des vérifications de Googlebot.

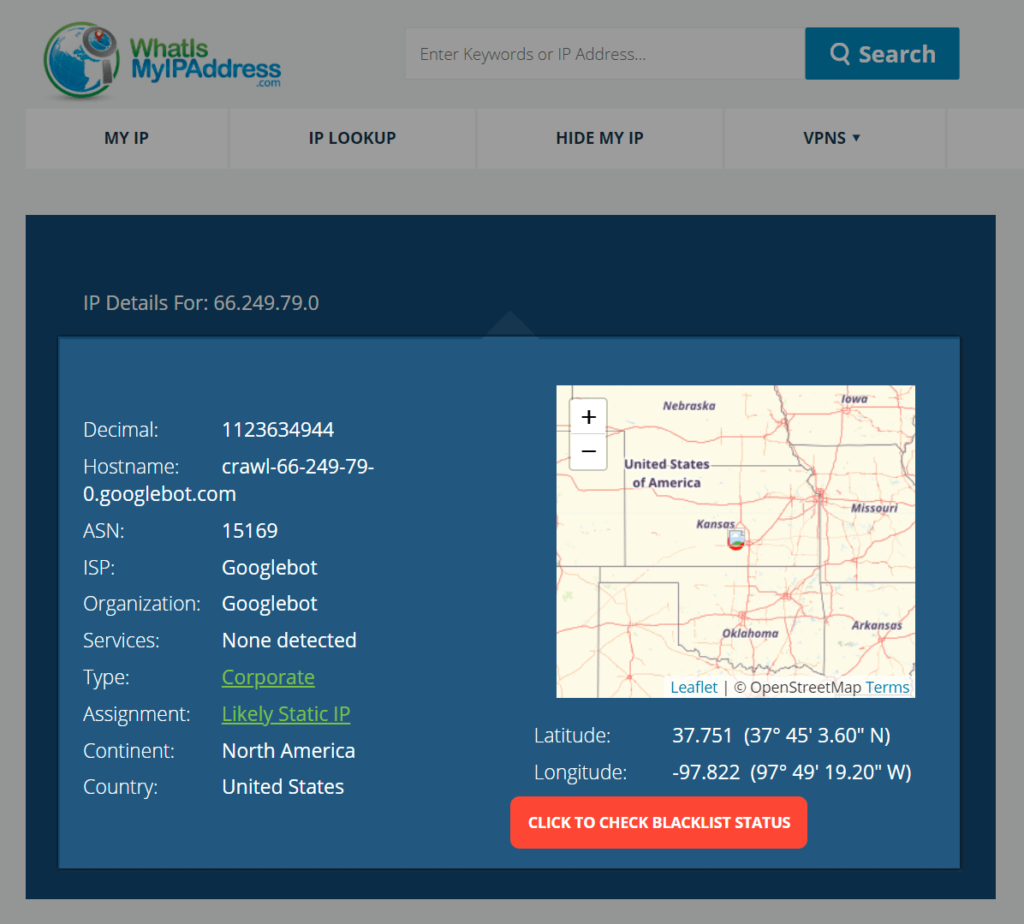

Et si vous êtes triste, comme moi, vous pouvez même faire une vérification de l'emplacement IP et voir où se trouvent les serveurs.

Ici, on peut voir l'emplacement de Googlebot au Kansas whatismyipaddress.com

4. Existe-t-il des balises Noindex ou Nofollow accidentelles ?

Les balises Noindex et Nofollow sont utiles pour indiquer à Google quand ignorer les pages et les liens de votre site Web, mais utilisées de manière incorrecte (ou accidentelle), elles peuvent avoir des conséquences désastreuses pour votre site Web.

Les balises Noindex indiquent aux moteurs de recherche de ne pas répertorier une page (ou un site Web) dans leur index (voir le guide de Google).

Les balises Nofollow indiquent aux robots de ne pas suivre les liens d'une page vers la page liée. Il y a deux raisons principales pour lesquelles cette balise est utilisée :

- Pour empêcher les moteurs de recherche de trouver des pages qu'un propriétaire de site Web ne souhaite pas indexer dans les résultats de recherche

- Pour indiquer aux moteurs de recherche que le site Web de liaison ne souhaite pas être associé au site Web lié

Ces balises sont rarement ajoutées à un site Web ou à une page par défaut. S'ils sont ajoutés, ils le sont à dessein en modifiant un paramètre sur le backend.

Par exemple, si vous vouliez noindexer une page à l'aide du plugin Rankmath SEO, vous devrez le faire manuellement.

Mais des accidents peuvent survenir et des balises noindex et nofollow sont ajoutées de temps en temps.

Ce que vous devez faire est de vérifier si votre site Web contient l'un de ces éléments accidentellement ajoutés. À mon avis et selon mon expérience en tant que consultant SEO, le meilleur outil pour cela est Screaming Frog.

Suivez une leçon de démarrage rapide sur l'audit de Screaming Frog

Screaming Frog est un outil de référencement essentiel, à la fois pour les vérifications rapides et pour l'audit détaillé du site.

Je vous recommande vivement d'apprendre à l'utiliser, même si vous l'utilisez avec un autre outil d'audit de site (comme Sitebulb).

Tout ce que vous avez à faire est d'explorer votre site Web et, une fois que c'est fait, d'utiliser le filtre noindex pour voir combien de pages ne sont pas indexées. Vous en avez peut-être ajoutés à dessein, mais il y en a peut-être d'autres que vous n'avez pas ajoutés. Si tel est le cas, examinez pourquoi ils ont pu être ajoutés et supprimez-les.

Il en va de même pour les balises nofollow. Assurez-vous que vous n'avez pas accidentellement défini tous vos liens internes vers vos pages les plus importantes sur nofollow.

Il convient de noter que Google n'utilise désormais le nofollow que pour "indiquer" s'ils doivent ou non. Cela signifie qu'ils pourraient les ignorer et explorer un lien de toute façon. Vous pourriez avoir de la chance s'il y en a des accidentels, mais il vaut mieux ne pas le laisser au hasard.

Quelle est la différence entre indexable et non indexable ?

Voici une brève vidéo de l'équipe de Screaming Frog expliquant comment trouver des pages indexables et non indexables à l'aide de leur outil :

5. Existe-t-il des redirections HTTP(S) erronées ?

HTTPS signifie Hypertext Transfer Protocol Secure. C'est un élément fondamental du fonctionnement d'Internet.

Vous êtes peut-être plus habitué à voir HTTP que HTTPS, mais HTTPS devrait désormais être la valeur par défaut utilisée par chaque site Web (le S signifie Secure).

L'objectif de HTTPS est qu'il transmet les données de manière plus sécurisée entre un serveur et un navigateur que le protocole HTTP classique.

L'ajout de la partie sécurisée au protocole signifie que les URL doivent passer de http://example.com à https://example.com. Lorsqu'ils sont mal exécutés, les sites Web se cassent ou, dans certains cas, entraînent de graves problèmes de classement.

Une baisse de classement peut se produire car aucune redirection n'est ajoutée par le développeur du site Web qui enverra des personnes (et des robots) de l'adresse HTTP à l'adresse HTTPS. Le résultat est que vous pouvez accéder à un site Web via les deux protocoles.

Par exemple, si vous allez sur http://example.com/ vous vous retrouvez sur une page non sécurisée. Mais si vous allez sur https://example.com/ c'est sécurisé. Même page - une sécurisée et une non.

Le problème est que, pour Google, ce sont deux pages différentes. Deux sites Web différents.

- http://exemple.com

- https://exemple.com

Lorsque vous commencez à inclure le www. préfixe, les choses empirent . Vous vous retrouvez avec quatre pages (ou sites Web).

- http://exemple.com

- http://www.exemple.com

- https://exemple.com

- https://www.exemple.com

Ainsi, au lieu d'avoir un site Web à explorer, Google en explore quatre .

Imaginez maintenant que votre site Web compte 10 000 URL. Sans les redirections en place, Google devrait explorer 40 000 URL et décider laquelle est la bonne à indexer.

La dernière chose que nous voulons, c'est que Google décide quelle page indexer. Nous voulons autant de contrôle que possible sur les pages qui apparaissent dans les résultats de recherche.

Donc, l'une des raisons pour lesquelles votre classement a peut-être chuté est que Google ne peut pas déterminer quelle URL classer, tout cela à cause de quelques redirections manquantes.

La meilleure façon de vérifier si vous avez les bonnes redirections en place est d'utiliser un outil d'araignée SEO, comme Screaming Frog ou Sitebulb, et de voir si les URL sont accessibles via les différents préfixes d'URL (HTTP ou HTTPS et avec ou sans le www. ).

Dans certains cas, vous devrez peut-être créer un enregistrement de toutes vos URL, les modifier dans Google Sheets (ou Excel, eww), puis les télécharger dans votre araignée SEO pour les explorer. C'est laborieux et cela prend un peu de temps, mais parfois cela peut valoir la peine.

Mon point de départ préféré est de vérifier l'URL de la page d'accueil via un outil en ligne gratuit appelé HTTP Status, construit par Sander Heilbron. S'il y a un problème avec la page d'accueil, il est probable que le reste du site Web ait également des problèmes.

6. Existe-t-il des balises canoniques incorrectes ?

Une balise canonique est un code qui indique aux moteurs de recherche qu'une page est similaire ou presque identique à une autre.

Les balises canoniques sont idéales lorsque vous avez plusieurs pages similaires les unes aux autres, comme la chaussure de course identique en plusieurs couleurs. Ils indiquent à Google que les pages sont similaires, mais pas des copies et qu'une seule des variantes doit être répertoriée dans leurs résultats de recherche.

Sans les canoniques, Google pourrait présumer que toutes les pages sont des doublons et choisir de ne classer aucune d'entre elles.

Une utilisation historique des balises canoniques est lorsque les sites Web étaient auparavant conçus pour les mobiles et hébergés sur un sous-domaine distinct, tel que https://m.example.com.

Une autre raison pour laquelle ils sont utilisés est d'éviter que Google ne gaspille des ressources en explorant des pages sans importance de votre site Web, telles que celles créées par les paramètres UTM.

Les paramètres sont très courants sur certaines plateformes de commerce électronique, où ils sont utilisés pour modifier ou filtrer les pages de catégories et de produits par couleur, taille, forme, matériau, etc.

- http://votreboutique.com/trainers/running/jetstream?colour=black

- http://votreboutique.com/trainers/running/jetstream?colour=black&size=44

Votre site Web a peut-être chuté dans le classement parce que des balises canoniques y ont été ajoutées de manière incorrecte.

Un exemple pourrait être que toutes vos pages d'argent clé, telles que vos pages de service ou de catégorie, ont été canonisées vers votre page d'accueil. Cela indiquerait effectivement à Google qu'aucune de vos autres pages n'est importante et qu'ils devraient plutôt classer la page d'accueil. Loin d'être idéal.

Si je suis à la recherche d'une nouvelle paire de bottes de marche, la meilleure expérience d'achat n'est pas que j'arrive sur votre page d'accueil et que je doive ensuite trouver la bonne page cachée dans votre menu.

La meilleure expérience d'achat est ma recherche de "bottes de marche" dans Google, en cliquant sur votre site Web, puis en étant redirigé directement vers la page de votre catégorie de bottes de marche afin que je puisse commencer à naviguer.

Imaginez si je pouvais entrer dans un supermarché en ce moment et être transporté de la porte d'entrée directement dans l'allée droite du supermarché et directement devant l'article d'épicerie que je veux acheter . Ne devrais-je pas immédiatement le ramasser et l'apporter à la caisse ? Vous pariez que je le ferais .

Pour cette raison, vous ne devez pas incorrectement (ou accidentellement) canoniser vos pages les plus importantes vers la mauvaise URL ou votre page d'accueil.

L'algorithme de Google devient plus intelligent et est connu pour choisir la meilleure URL à classer parmi une gamme de pages similaires sans avoir besoin de balises canoniques . Cependant, tous les spécialistes du référencement dans le monde vous diront de ne jamais laisser Google décider de tout ce que vous pouvez contrôler.

Vous devrez vérifier vos balises canoniques et Screaming Frog et Sitebulb sont les meilleurs outils pour le faire.

Certains sites Web les ajouteront automatiquement et les référenceront automatiquement sur chaque page (si vous vérifiez le code source de cette page, vous verrez que WordPress en a automatiquement ajouté un), alors ne vous inquiétez pas si c'est le cas. Vous devez vérifier si vos balises canoniques pointent vers une autre page, puis déterminer si c'est la bonne chose à faire.

Que sont les balises canoniques ?

Cette vidéo est un excellent explicateur sur ce que les canoniques fonctionnent et comment Google les utilise par le génie du Web de Google, John Mueller :

7. Existe-t-il des balises Hreflang incorrectes ?

Les balises hreflang sont similaires aux balises canoniques. Ils indiquent aux moteurs de recherche qu'il existe d'autres pages presque identiques à celle en cours d'examen, mais écrites dans une langue différente.

Les balises hreflang sont courantes sur les sites Web internationaux, en particulier les sites de commerce électronique.

Ils sont simples à ajouter mais faciles à gâcher, comme les autres balises mentionnées ci-dessus. S'ils sont mal mis en œuvre, ils peuvent gravement nuire au classement d'un site Web dans un pays ou dans plusieurs pays à la fois.

La dernière chose dont vous avez besoin est que votre site Web commence soudainement à dire à Google qu'il ne devrait plus classer vos sous-répertoires sud-américains, australiens ou indiens. Il devrait plutôt classer votre magasin canadien (auquel aucune des personnes de ces pays ne peut acheter).

Screaming Frog et Sitebulb sont les meilleurs outils pour vérifier la configuration de vos balises hreflang, si vous en avez (ou si elles ont été ajoutées accidentellement).

Si votre site Web est assez volumineux, il peut être utile d'envisager un outil au niveau de l'entreprise comme Deepcrawl ou ContentKing, car ils auditeront votre site Web à grande échelle. Surtout dans le cas de ContentKing, ils vous avertiront lorsque des balises sont soudainement ajoutées ou modifiées sur votre site Web.

Comment ajouter, tester et valider vos balises Hreflang

Cette vidéo de l'ancienne personnalité de recherche de l'année, Aleyda Solis, explique en profondeur ce que sont les balises hreflang, comment les ajouter et comment les tester et les valider :

8. Votre site Web est-il adapté aux mobiles ?

54,8 % de tout le trafic Internet mondial au premier trimestre 2021 était sur un appareil mobile. Pour cette raison, Google a fait passer son index de résultats de recherche de desktop-first à mobile-first, ce qui signifie qu'ils classent les sites Web sur leur expérience mobile et non sur celle de bureau.

Si votre site Web n'est pas adapté aux mobiles, cela pourrait être la raison pour laquelle votre classement a chuté.

Dans certaines circonstances, Google classera une page non adaptée aux mobiles pour une requête de recherche si la réponse est la meilleure réponse disponible , mais dans la mesure du possible, il classera plutôt un résultat adapté aux mobiles.

Vous devez vérifier si votre site Web est adapté aux mobiles, et le premier endroit où vous pouvez vérifier est via votre téléphone. Tous les smartphones n'ont pas la même taille, donc votre expérience de votre site Web peut différer de la mienne, mais c'est un bon point de départ.

La meilleure façon de vérifier est via l'outil de test adapté aux mobiles de Google. C'est plus pratique que d'utiliser votre smartphone et cela vous donne également de meilleurs commentaires sur les raisons pour lesquelles votre page ou votre site Web n'est pas adapté aux mobiles.

C'est utile pour tester quelques pages à la fois, par exemple lorsque vous avez une page spécifique qui a chuté dans le classement des résultats de recherche, mais moins lorsque vous consultez des milliers de pages à la fois.

Si vous avez un problème avec la compatibilité mobile, vous devrez alors parler avec un développeur de site Web (ou notre équipe) pour discuter d'une refonte de votre site Web ou d'une migration à partir de toute configuration de sous-domaine mobile que vous pourriez avoir en place.

Comment créer un site Web mobile rentable

Vous pouvez entendre notre fondateur, Tim Cameron-Kitchen, discuter de sites Web mobiles rentables dans ce podcast de 2019.

9. Votre site Web a-t-il des erreurs de crawl ?

Tout d'abord. Qu'est-ce qu'une erreur d'exploration ?

Eh bien, une erreur d'exploration est une erreur qui se produit lorsqu'un robot d'exploration Web tel que Googlebot explore votre site Web. Une erreur courante est un 404, ce qui signifie qu'une page est manquante. Mais il y a des centaines , voire des milliers , qui peuvent se produire sur un site Web, en particulier ceux qui ne sont pas entretenus régulièrement.

Si vous êtes nouveau dans le domaine du référencement et que vous ne connaissez pas vraiment votre 404 de votre 301, je vous suggère de consulter le rapport de couverture dans votre compte Google Search Console.

Le rapport de couverture vous indiquera les pages avec lesquelles Google a rencontré des problèmes lors de l'exploration de votre site Web, mais il ne vous dira pas comment les résoudre.

Découvrez le rapport de couverture d'index dans Google Search Console

Cette courte vidéo de Daniel Waisberg, Search Advocate chez Google, explique le fonctionnement du rapport de couverture dans Google Search Console.

Au lieu de cela, je suggérerais d'explorer votre site Web avec un autre robot d'exploration, tel que Sitebulb.

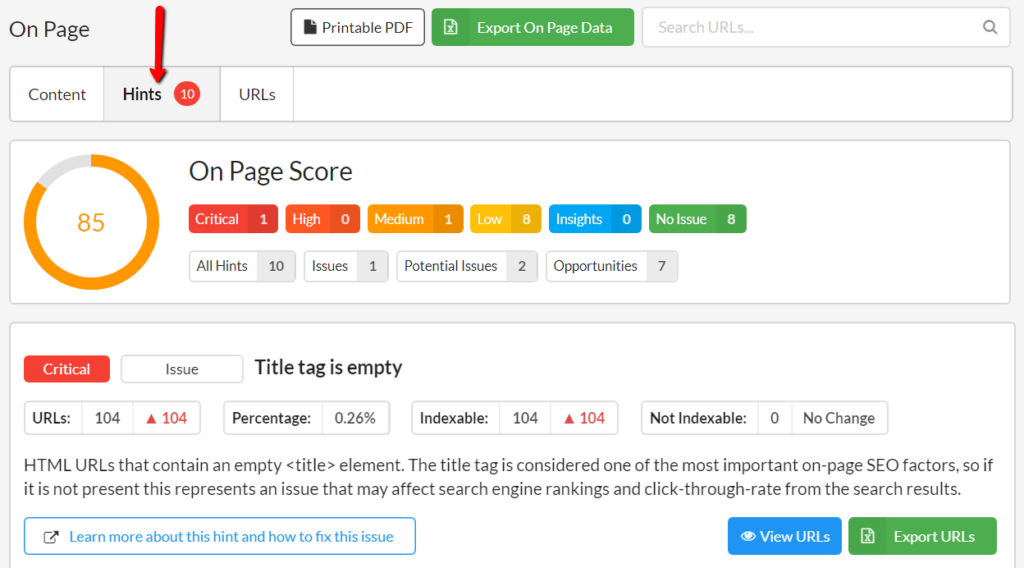

Je choisirais Sitebulb en particulier car il est construit avec de nombreux "Conseils" et une documentation explicative qui explique pourquoi des erreurs peuvent se produire et comment vous pouvez les corriger.

Les conseils de Sitebulb sont faciles à trouver

Jetez un coup d'œil à l'intérieur de Sitebulb

Chez Exposure Ninja, nous utilisons de nombreux outils d'audit de site, chacun avec ses propres meilleures utilisations, mais tous essentiels

Malheureusement, certaines erreurs seront causées par le CMS ou les plugins que vous utilisez sur votre site Web, ce qui entraînera des moments où vous ne pourrez pas faire grand-chose pour les corriger.

Dans la mesure du possible, vous devez en corriger autant que possible, mais toutes les erreurs n'entraîneront pas une augmentation des performances de la page ou une augmentation (ou une reprise) du classement.

Pour vous aider à comprendre quelles erreurs sont critiques pour votre classement (surtout si vous avez eu une baisse), je vous recommande d'utiliser le système de notation intégré de Sitebulb (de Critical à Low) pour hiérarchiser vos erreurs.

Classez vos erreurs par ordre de priorité en fonction de ce qui, selon vous, améliorera l'expérience des visiteurs sur votre site Web (comme l'augmentation de la vitesse du site ou la convivialité pour les mobiles), mais supprimez toutes les erreurs susceptibles d'empêcher une exploration Web efficace.

Si vous travaillez avec plusieurs personnes, y compris des développeurs, et que vous avez besoin d'aide pour hiérarchiser le travail que vous devez faire, je recommande vivement ce conseil du responsable du référencement de Papier, Areej AbuAli, sur la façon de hiérarchiser et d'effectuer le référencement technique.

Comment mettre en œuvre vos correctifs techniques SEO

Vous pouvez regarder l'excellente présentation d'Areej sur la priorisation du référencement technique dans cette vidéo hébergée par la conférence en ligne TurnDigi de Jo Turnbull.

(Une fois cliqué, la vidéo s'ouvre dans une nouvelle fenêtre)

10. Votre site Web est-il sain ?

Il s'agit d'une vue holistique de votre site Web : Votre site Web est-il sain ?

A-t-il des erreurs ? Est-il facile à utiliser? Est-ce rapide ?

À travers des centaines de campagnes de référencement de clients, nous avons toujours constaté que plus le site Web est sain, plus il est facile de le classer plus haut dans les résultats de recherche de Google, ce qui signifie que l'inverse est également vrai.

Plus un site Web est cassé et malsain, plus il est difficile de se classer au sommet de Google et plus il tombe facilement dans les résultats de recherche lorsque des mises à jour d'algorithmes se produisent.

Certains outils d'exploration et d'audit de sites Web incluent un score de santé, généralement un score de 0 à 100.

Maintenant, je ne pense pas nécessairement que ces scores soient la meilleure chose à suivre .

Pourquoi? Parce qu'ils nous amènent à nous focaliser sur un site Web "parfait" alors que nous devrions nous concentrer sur la création du meilleur contenu et de la meilleure expérience de site Web possible .

Cependant, supposons que vous souhaitiez vous donner un objectif à atteindre (ou que vous ayez plusieurs parties prenantes impliquées dans votre référencement ou votre marketing). Dans ce cas, avoir un objectif visuel peut être vraiment utile.

Les auditeurs de site construits dans Semrush et SE Ranking ont ces scores, et tous deux utilisent le même système de signalisation « Erreurs » (haute priorité) par rapport aux « Avertissements » (faible priorité) et les mêmes descriptions de chaque problème.

Quels que soient les outils ou le score que vous utilisez, savoir qu'il y a des problèmes sur votre site Web n'est que la première étape vers la montagne. Les faire réparer est le vrai grand défi (une autre bonne raison de lire l'article d'Areej).

Accédez au sommet de Google gratuitement

11. Votre site Web a-t-il eu une action manuelle ?

Espérons que l'action manuelle est la dernière chose dont vous devriez vous soucier, mais cela vaut la peine de couvrir, juste au cas où.

Une action manuelle se produit lorsqu'une personne chez Google supprime manuellement une page ou un site Web de ses résultats de recherche - lorsqu'elle le fait ; la visibilité de la recherche et le trafic chutent d'une falaise .

En raison du fonctionnement de l'algorithme, Google ne devrait pas avoir besoin de supprimer quoi que ce soit manuellement, vous savez donc que lorsqu'ils doivent le faire , c'est parce qu'il y avait quelque chose de vraiment pas cool sur la page ou le site Web en question.

Il existe de nombreuses raisons pour lesquelles Google peut servir une action manuelle, notamment :

- Votre site Web contient trop de spam

- Il y a trop de liens douteux pointant vers votre site Web

- Il y a des redirections sournoises sur votre site Web

- Il y a des violations de la politique d'utilisation de Google

Google est méchant et méchant

En règle générale, Google ne se contente pas de distribuer des actions manuelles à moins qu'il ne pense vraiment qu'un site Web le mérite, c'est-à-dire que vous faites quelque chose que vous ne devriez pas faire. Mais des accidents se produisent et votre site Web peut contenir du contenu malveillant dont vous n'êtes même pas conscient, peut-être parce que quelqu'un a piraté votre site Web.

La solution aux actions manuelles consiste à résoudre le ou les problèmes signalés par Google et à soumettre votre site Web pour examen.

Une fois soumises, les évaluations peuvent prendre de quelques jours à quelques semaines pour être complétées et approuvées, et pour que les classements soient restaurés. Ces dernières années, il est devenu courant que les baisses de classement des actions manuelles ne soient pas inversées avant la prochaine mise à jour générale du noyau.

Vous pouvez vérifier l'état de votre action manuelle via ce lien vers votre compte Search Console. Ensuite, commencez à examiner votre site Web par rapport à la documentation Google Webmaster Guidelines et aux directives Google Search Quality Evaluator (qui sont utilisées par l'équipe de test de Google).

Inverser une action manuelle n'est jamais un travail de cinq minutes. Il y aura beaucoup de travail à faire, alors assurez-vous d'obtenir le bon soutien de votre spécialiste SEO interne ou de votre agence SEO partenaire.

12. Avez-vous perdu des backlinks ?

Comme indiqué précédemment, l'algorithme de Google est compliqué et multiforme, mais nous pouvons à peu près garantir que les backlinks en sont une grande partie.

Avec cette certitude, nous pouvons supposer que la perte de backlinks a un impact négatif sur le classement.

L'attrition des liens (les backlinks sont supprimés ou supprimés) est normale. Les liens meurent parce que les sites Web meurent, sont mis à jour ou sont redirigés vers de nouveaux domaines. C'est prévu . Mais si les mauvais liens sont perdus (c'est-à-dire les liens juteux provenant de domaines de grande valeur) et non restaurés (ou remplacés par des liens tout aussi solides), alors un pilier central d'un classement solide est perdu.

Heureusement, presque tous les outils de backlink (comme Majestic) enregistrent la perte de liens afin que vous puissiez automatiser vos compétences de détective et voir quand l'un de vos backlinks disparaît.

Ce que vous devez faire ensuite est de créer de nouveaux liens ou de récupérer ces liens perdus.

La plupart du temps, les liens sont supprimés par pur accident. Vous mettez à jour un ancien article de blog avec de nouvelles informations et, pendant que des copier-coller sont en cours, le lien est coupé. Oups .

Votre classement a donc peut-être chuté parce que vous avez perdu vos liens juteux. Si tel est le cas, récupérez-les ou remplacez-les par des liens plus récents et plus solides (n'achetez pas de liens douteux).

Comment récupérer vos backlinks perdus

Cette vidéo de 2013, bien qu'assez ancienne en termes de référencement, est toujours aussi pertinente et applicable pour récupérer les backlinks perdus (et les mentions de marque) qu'elle l'était alors.

Ce que vous devez faire ensuite

- Vérifiez que votre contenu correspond à l'intention de recherche

- Améliorez votre contenu

- Gagnez de nouveaux backlinks

- Être patient

1. Vérifiez que votre contenu correspond à l'intention de recherche

Lorsque vous et moi recherchons quelque chose en ligne, nous avons une intention. Nous voulons trouver la réponse à notre question ou la solution à notre problème. Pour cette raison, le contenu d'un site Web d'entreprise doit correspondre à l'intention des personnes recherchant leurs produits ou services.

Il existe quatre types de recherche différents et l'intention utilisée pour chacun :

Requêtes de navigation - Ces requêtes se produisent lorsque les gens veulent aller quelque part en ligne. Par exemple, « Gmail » lorsque vous souhaitez consulter vos e-mails ou « Facebook » lorsque vous souhaitez voir ce que votre tante a mangé au déjeuner.

Requêtes d'information — Il s'agit de requêtes de recherche. Lorsque vous voulez être plus intelligent avec votre argent, vous pouvez rechercher "qu'est-ce qu'un ISA ?" ou "comment vendre mon rein pour de l'argent".

Requêtes commerciales - Les requêtes commerciales concernent la recherche de la façon de dépenser votre argent. Par exemple, lorsque vous comparez des mélangeurs, vous recherchez probablement "meilleur mélangeur de moins de 100 £" ou "nutribullet pro 900 avis 2021".

Requêtes transactionnelles - Vous utilisez des requêtes transactionnelles lorsque vous êtes prêt à acheter le produit que vous avez recherché, comme "acheter nutribullet 900" ou "acheter nutribullet 900 livraison gratuite".

Les problèmes de classement surviennent lorsque le contenu écrit pour une page ne correspond pas à l'intention de la personne qui effectue la recherche.

Par exemple, si je recherche "acheter un matelas queen size" et que le premier résultat est un article de comparaison de matelas, cet article ne correspond pas à mon intention. Mon intention est d' acheter, pas de faire des recherches sur l'achat .

Connaître la bonne intention pour votre contenu peut être délicat, d'autant plus que vous devenez incroyablement habitué à vos produits ou services. Ce que vous pensez être la bonne copie pour une page peut ne pas convenir aux requêtes de recherche qui amènent les gens sur cette page.

Les pages de catégories de produits de commerce électronique sont un autre exemple. En raison des vieux mythes SEO selon lesquels "les pages ont besoin d'au moins 500 mots", une copie horrible est écrite pour les pages de catégorie sur l'histoire du produit, qui l'a inventé, d'où proviennent les matériaux dans le monde, etc.

Ce que les gens veulent vraiment voir, ce sont les produits eux-mêmes.

Ils veulent savoir :

- Quels produits sont disponibles

- S'ils sont de couleurs, de formes et de tailles différentes

- S'ils sont en stock

- Combien coûtent-ils

Créer un lien vers un guide "Comment choisir les bonnes chaussures de course" à partir d'une page de catégorie serait une bien meilleure expérience d'achat car j'aurais la possibilité de l'utiliser si cela s'applique à moi, alors que si j'ai fait mes recherches, tout Je veux voir sont les produits eux-mêmes.

L'intention de la copie doit correspondre à l'intention de la recherche. Un bon moyen de le savoir est de parler à vos clients (à la fois ceux qui n'ont pas encore converti et ceux qui l'ont fait).

Votre marché cible aura des problèmes qu'il essaie de surmonter et il saura quelles requêtes de recherche il aura utilisées pour se rendre sur votre site Web.

S'ils ont utilisé Google pour trouver votre site Web, vous pourrez utiliser le rapport sur les performances dans la Search Console pour voir quelles requêtes ils ont utilisées pour trouver chaque page de votre site Web. Vous pouvez ensuite comparer ces requêtes à ces URL et mettre à jour chaque page en conséquence.

S'ils n'ont pas utilisé Google pour vous trouver, pas de problème . Appelez-les pendant 15 minutes (en échange d'une carte-cadeau/bon d'achat) et interrogez-les sur la façon dont ils connaissent votre entreprise et, surtout, sur les problèmes qu'ils ont ou ont eus.

Ensuite, vous devrez améliorer votre contenu.

Comment analyser l'intention du chercheur

L'équipe Ahrefs a des centaines de superbes vidéos sur le référencement, y compris cette superbe vidéo sur l'intention de recherche.

2. Améliorez votre contenu

Il ne suffit pas que votre contenu corresponde à l'intention de recherche . Votre contenu doit également mieux correspondre à cette intention de recherche que toutes les autres URL dans les résultats de recherche.

J'utilise un processus vraiment très simple pour améliorer notre contenu. Voici comment je procède :

- Rechercher les requêtes de recherche pour lesquelles je veux que mon article se classe en premier

- Faites une liste des vingt meilleurs résultats de classement

- Prenez note des thèmes récurrents, des titres et des questions dans chacun d'eux

- Reformatez toutes ces informations dans mon plan d'article existant

C'est ça. Hyper simple .

Vous regardez ce qui est classé et faites de votre contenu une mise à niveau sur les autres pages.

Le hic, c'est que vous n'allongez pas votre contenu dans le but d'être le plus complet et le plus profond. Il ne sert à rien d'écrire un contenu incroyablement intense de 10 000 mots si un simple article de 200 mots répond mieux à la question .

Par exemple, si j'écris sur "ce qu'est le taux de rebond", je pourrais aller plus loin. Je pourrais parler de ce que c'est, comment l'optimiser, comment résoudre toutes les différentes erreurs qu'il peut y avoir, ce que devrait être un bon taux de rebond moyen, quel est le taux de rebond moyen par secteur, etc.

Mais si je cherche juste "qu'est-ce qu'un bon taux de rebond", je ne me soucierai peut-être pas (encore) de la façon de le résoudre. J'aimerais peut-être un lien vers un article sur le dépannage des mauvais taux de rebond que je pourrai lire plus tard. Mais pour l'instant, je me concentre uniquement sur la réponse à ma question actuelle ("qu'est-ce qu'un bon taux de rebond ?").

Votre contenu doit être le meilleur pour les requêtes de recherche et l'intention auxquelles vous essayez de répondre. Il n'est pas nécessaire que ce soit le meilleur contenu pour chaque requête de recherche possible .

Mise en garde : si vous écrivez dans le contexte de l'article, il est logique d'inclure des informations sur d'autres requêtes. Plus que toute autre chose, vous voulez offrir aux gens la meilleure expérience possible , même si cela signifie se classer deuxième ou troisième et non premier.

Si vous cherchez quelque chose d'un peu plus avancé concernant les contours de contenu, ce fil Twitter jette un regard vraiment intéressant sur la façon dont vous pouvez utiliser l'IA dans la recherche et la création de contenu.

Comment améliorer votre contenu en pensant au référencement

Cette vidéo de l'équipe de Surfer offre un aperçu fantastique de la façon dont vous pouvez améliorer votre contenu en pensant au référencement (tout en écrivant d'abord pour les humains).

3. Gagnez de nouveaux backlinks

Le référencement et la création de liens ne sont jamais des activités uniques. Les bons liens construits aujourd'hui aident votre site Web aujourd'hui, mais demain ce seront d'anciens backlinks et ils n'auront plus leur éclat.

Il est préférable de gagner constamment de nouveaux backlinks grâce à une excellente création et promotion de contenu.

Il existe de nombreuses façons de gagner de nouveaux backlinks, et je veux vraiment dire gagner . Vous pouvez faire de la sensibilisation et informer les autres propriétaires de sites Web du nouveau contenu que vous avez créé et voir s'ils seraient également intéressés à le faire connaître à leurs lecteurs (en créant un lien vers celui-ci). C'est parfaitement bien . C'est acheter des backlinks de faible valeur que vous devez éviter.

50 façons gratuites de créer des backlinks

Il existe des centaines de façons de gagner des backlinks pour votre site Web, mais si vous êtes limité en temps ou en argent, j'ai récemment diffusé un flux en direct dans lequel je décris cinquante façons différentes de créer de nouveaux liens.

4. Soyez patient

Je déteste le dire, mais parfois la meilleure chose à faire est d'attendre .

Il se peut qu'il n'y ait rien de mal avec votre site Web . Google a peut-être mis à jour son algorithme et, suite à une erreur, votre site Web a été injustement abandonné dans le classement. Cela peut arriver .

Parfois, un site Web peut devoir attendre la prochaine mise à jour de l'algorithme de base large pour voir une restauration des classements perdus, parfois jusqu'à un an après la chute.

La bonne action à prendre est une action positive et immédiate après une baisse de classement.

- Vérifiez tout sur votre site Web

- Voir ce qui doit être amélioré ou remplacé entièrement

- Vérifiez votre référencement sur site et votre référencement hors site

- Vérifiez vos backlinks (et créez-en de nouveaux)

Effectuez toutes les vérifications décrites ci-dessus et travaillez pour améliorer votre contenu et votre stratégie de création de liens en continu, et vous verrez votre classement s'améliorer, c'est garanti .

Combien de temps faut-il pour se remettre d'une baisse de classement

Nous avons vu des baisses de classement inversées du jour au lendemain, mais c'est principalement le cas lorsque Googlebot a bloqué par erreur un site Web ou a été accidentellement non indexé sur l'ensemble du site.

Historiquement, nous avons vu des sites Web recevoir des corrections de classement dans les deux semaines suivant une baisse (ou une augmentation) du classement. Pourtant, depuis que le nom de la mise à jour Broad Core a été inventé en 2018, nous avons constaté que la récupération de la baisse de classement ne se produit parfois pas avant la prochaine mise à jour Broad Core (3 à 6 mois plus tard).

Cela peut donc prendre des jours, des semaines, (principalement) des mois et (parfois) des années pour se remettre d'une baisse de classement - mais cela ne sera possible que si vous auditez entièrement votre site Web et apportez les améliorations nécessaires pour obtenir cette inversion de classement.

L'importance des canaux de trafic diversifiés

Nous adorons le référencement parce que nous avons prouvé à maintes reprises qu'il s'agit de la meilleure source de trafic hautement qualifié qui augmente les revenus des entreprises.

Mais, même ainsi, nous conseillons toujours vivement à toutes les entreprises de diversifier leurs sources de trafic afin qu'en cas de baisse de classement, elles disposent toujours d'un flux de trafic constant à convertir en prospects et en ventes.

Si vous n'avez pas encore diversifié votre trafic, je vous recommande d'ajouter la publicité au paiement par clic et le marketing des médias sociaux à votre stratégie de marketing numérique.

D'autres canaux, comme le marketing d'affiliation, peuvent également être excellents, mais nous vous recommandons d'ajouter d' abord le PPC et les médias sociaux à votre mix, ainsi que le marketing par e-mail.

Créer une stratégie marketing multicanal en 5 étapes

Cette vidéo de Tim explique comment vous pouvez transformer toutes vos idées et tâches marketing en une stratégie de marketing numérique exploitable.

Vous ne savez toujours pas pourquoi votre classement a chuté ?

Si vous avez examiné toutes les raisons possibles pour lesquelles votre classement Google a chuté et que vous ne savez toujours pas pourquoi, la meilleure chose à faire est de parler à un expert SEO qualifié. Heureusement, notre équipe en est pleine.

Si vous souhaitez que notre équipe examine votre site Web, il vous suffit de demander. Soumettez votre site Web pour examen, et nous examinerons non seulement le classement de votre site Web, mais nous soulignerons également comment vous pouvez augmenter votre trafic, vos prospects et vos ventes.

N'hésitez pas. Demandez dès maintenant une évaluation gratuite de votre site Web et de votre marketing.