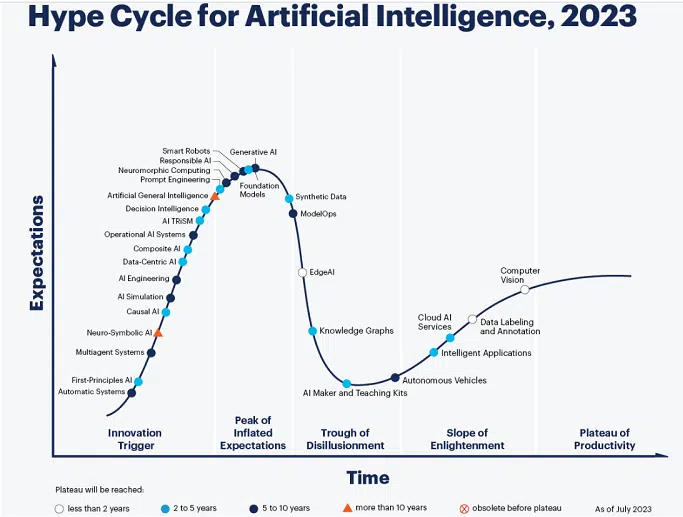

¿Qué le depara el futuro a la genAI? El ciclo de exageración de Gartner

Publicado: 2023-09-21No sorprende a nadie que la IA generativa y los modelos fundamentales que la respaldan se encuentren actualmente en la cima de lo que Gartner llama "el pico de las expectativas infladas" en la última versión del "Ciclo de exageración de Gartner para la inteligencia artificial". Eso significa que están tambaleándose al borde del precipicio que podría precipitarlos al “abrevadero de la desilusión”.

Hablamos con Afraz Jaffri, analista director de Gartner especializado en análisis, ciencia de datos e inteligencia artificial, sobre cómo debemos interpretar la situación. La entrevista ha sido editada para mayor extensión y claridad.

P: Está proyectando que los modelos básicos tardarán entre dos y cinco años y la IA generativa tardará entre cinco y diez años en alcanzar la “meseta de productividad”. ¿En qué se basa eso?

R: Aquí es donde podemos ver una adopción real, no sólo entre un número selecto de empresas, lo que probablemente se hará mucho más rápido, sino entre todos los niveles de organizaciones, predominantemente en forma de aplicaciones empaquetadas. Cada pieza de software tendrá algún tipo de funcionalidad de IA generativa, pero tomará más tiempo comprender las ganancias reales de productividad de esas características. Es una carrera para que todos puedan lanzar un producto o característica de IA generativa dentro de su software; en todos esos casos, los beneficios tardarán más en materializarse y también en medirse.

Los modelos de cimentaciones cubren un amplio espectro; no sólo los grandes modelos de lenguaje sino también los modelos de imagen y vídeo. Por eso el tiempo hasta estabilizarse será más largo. Es un cubo de todo tipo de modelos.

Profundice: por qué nos importa la IA en el marketing

P: Es posible imaginar cosas que podrían ser muy perjudiciales para la IA generativa. Una es la regulación: existen preocupaciones reales, especialmente en Europa, sobre los grandes modelos lingüísticos que extraen datos personales. El otro se relaciona con los derechos de autor. ¿Ha tenido en cuenta aquí ese tipo de posibles perturbaciones?

R: Sí, son parte del pensamiento. La primera cuestión es en realidad el aspecto de la confianza. Independientemente de las regulaciones externas, todavía existe una sensación fundamental de que es muy difícil controlar los resultados de los modelos y garantizar que los resultados sean realmente correctos. Ese es un gran obstáculo. Como mencionaste, también existe la nube en torno a las regulaciones. Si en Europa los modelos están sujetos a una regulación significativa, es posible que ni siquiera estén disponibles; Ya hemos visto ChatGPT eliminado allí desde hace algún tiempo. Si las grandes empresas ven que es demasiado complicado cumplir, es posible que simplemente retiren sus servicios de esa región.

También está el lado legal. Estos modelos se basan, como usted dijo, en datos que incluyen datos protegidos por derechos de autor extraídos de la web. Si los proveedores de esos datos comienzan a solicitar un canje adecuado, eso también tendrá un impacto en el nivel futuro de uso de estos modelos. Luego está el lado de la seguridad. ¿Qué tan seguros pueden ser estos modelos contra cosas como ataques? Definitivamente hay algunos vientos en contra aquí para navegar.

P: Escuchamos mucho sobre el “humano en el circuito”. Antes de publicar cualquier cosa creada por IA generativa a una audiencia, es necesario contar con la revisión y aprobación humana. Pero uno de los beneficios de genAI es la velocidad y escala de su creatividad. ¿Cómo pueden los humanos mantenerse al día?

R: La velocidad y la escala están ahí para que los humanos las utilicen al hacer las cosas que necesitan hacer. Está ahí para ayudar a las personas que, por ejemplo, necesitan revisar 10 documentos para obtener una respuesta a algo; ahora pueden hacerlo en un minuto. Debido a la cuestión de la confianza, esos son los tipos de tareas más valiosos para utilizar un modelo de lenguaje.

P: Si la IA responsable está a cinco o diez años de distancia de la meseta, parece que estás prediciendo un viaje lleno de obstáculos.

R: Se desconoce el mundo regulatorio y otros sistemas; e incluso cuando se formalicen y se conozcan, habrá diferentes regulaciones para diferentes geografías. La naturaleza innata de estos modelos es que tienden a no ser seguros. Ser capaz de controlar eso llevará tiempo para aprender. ¿Cómo se comprueba que un modelo va a ser seguro? ¿Cómo se audita un modelo para determinar su cumplimiento? ¿Por seguridad? Las mejores prácticas son difíciles de conseguir; Cada organización está adoptando su propio enfoque. Olvídese de la IA generativa, otros modelos de IA, aquellos que las organizaciones han utilizado durante algún tiempo, todavía cometen errores y todavía presentan sesgos.

P: ¿ Cómo debería prepararse la gente para el inminente momento de desilusión?

R: Las organizaciones seguirán diferentes trayectorias en su experiencia con la IA generativa, por lo que eso no significa necesariamente que una organización deba caer en el abismo. Generalmente sucede cuando no se gestionan las expectativas. Si comienza analizando algunos casos de uso específicos, algunas piezas de implementación específicas y tiene buenas métricas para el éxito, y también inversiones en gestión y organización de datos; buena gobernanza, buenas políticas; Si combinas todo eso con una narrativa práctica sobre lo que los modelos pueden hacer, entonces habrás controlado el revuelo y será menos probable que caigas en el abismo.

P: ¿ Diría que el ciclo de exageración de la IA se está ejecutando más rápido que otros que ha observado?

R: El ciclo de exageración de la IA tiende a inclinarse hacia las innovaciones que se mueven más rápido a lo largo de la curva, y también tienden a tener un mayor impacto en lo que pueden hacer. Por el momento, es el centro de las iniciativas de financiación para los capitalistas de riesgo. Es un área muy focal, también en el ámbito de la investigación. Muchas de estas cosas surgen del mundo académico, que es muy activo en este espacio.

P: Finalmente, AGI, o inteligencia general artificial (IA que replica la inteligencia humana). Tienes eso como algo que llegará dentro de diez años o más. ¿Está cubriendo sus apuestas porque podría no ser posible en absoluto?

R: Sí. Tenemos un marcador que está "obsoleto antes de la meseta". Existe un argumento para decir que en realidad nunca sucederá, pero decimos que serán más de 10 años porque hay muchas interpretaciones diferentes de lo que realmente es AGI. Muchos investigadores respetados dicen que estamos en el camino que nos llevará a AGI, pero se necesitan muchos más avances e innovaciones para ver cómo es realmente el camino. Creemos que es algo más lejano de lo que mucha gente cree.

Profundice más: descubra soluciones de martech de vanguardia de forma gratuita, ¡en línea la próxima semana!

¡Consigue MarTech! A diario. Gratis. En tu bandeja de entrada.

Ver términos.

Historias relacionadas

Nuevo en MarTech