Cómo configurar el archivo robots.txt de Magento 2 para SEO

Publicado: 2021-01-21Tabla de contenido

El SEO es un factor importante para el éxito de su tienda, y un archivo robots.txt configurado correctamente contribuye en gran medida a facilitar el trabajo de los rastreadores de los motores de búsqueda.

¿Qué es robots.txt?

En pocas palabras, robots.txt es un archivo que instruye a los rastreadores de motores de búsqueda sobre lo que pueden o no rastrear. Sin un archivo robots.txt en su directorio raíz, los rastreadores de motores de búsqueda que se encuentren en su tienda rastrearán todo lo que puedan, y esto incluye páginas duplicadas o sin importancia en las que no desea que los rastreadores desperdicien su presupuesto de rastreo. Un archivo robots.txt debería poder abordar esto.

Nota : el archivo robots.txt no debe usarse para ocultar sus páginas web de Google. En su lugar, debe usar la etiqueta meta noindex para este propósito.

Instrucciones predeterminadas de robots.txt en Magento 2

De forma predeterminada, el archivo robots.txt generado por Magento contiene solo algunas instrucciones básicas para el rastreador web.

# Instrucciones predeterminadas proporcionadas por Magento Agente de usuario: * No permitir: /lib/ No permitir: /*.php$ No permitir: /pkginfo/ No permitir: /informe/ No permitir: /var/ No permitir: /catálogo/ No permitir: /cliente/ No permitir: /enviaramigo/ No permitir: /reseña/ No permitir: /*SID=

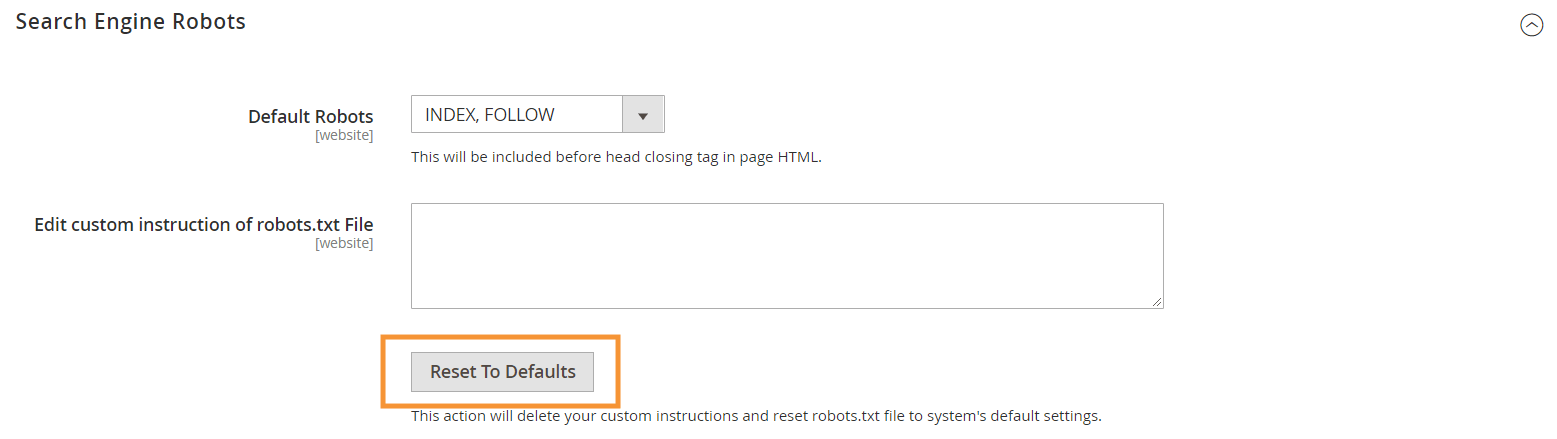

Para generar estas instrucciones predeterminadas, presione el botón Restablecer valores predeterminados en la configuración de Search Engine Robots en su backend de Magento.

Por qué necesita crear instrucciones personalizadas de robots.txt en Magento 2

Si bien las instrucciones predeterminadas de robots.txt proporcionadas por Magento son necesarias para decirles a los rastreadores que eviten rastrear ciertos archivos que el sistema usa internamente, no son suficientes para la mayoría de las tiendas de Magento.

Los robots de los motores de búsqueda solo tienen una cantidad finita de recursos para rastrear páginas web. Para un sitio con miles o incluso millones de URL para rastrear (que es más común de lo que piensa), deberá priorizar el tipo de contenido que se debe rastrear (con un sitemap.xml) y rechazar contenido irrelevante. las páginas sean rastreadas (con un archivo robots.txt). La última parte se realiza impidiendo que se rastreen páginas duplicadas, irrelevantes e innecesarias en su archivo robots.txt.

Formato básico de las directivas robots.txt

Las instrucciones en robots.txt se presentan de manera coherente, fácil de usar para usuarios no técnicos:

# Regla 1 Agente de usuario: robot de Google No permitir: /nogooglebot/ # Regla 2 Agente de usuario: * Permitir: / Mapa del sitio: https://www.example.com/sitemap.xml

-

User-agent: indica el rastreador específico para el que es la regla. Algunos agentes de usuario comunes sonGooglebot,Googlebot-Image,Mediapartners-Google,Googlebot-Video, etc. Para obtener una lista extensa de rastreadores comunes, consulte Descripción general de los rastreadores de Google.

-

AllowyDisallowpermitir: especifique las rutas a las que los rastreadores designados pueden o no acceder. Por ejemplo,Allow: /significa que el rastreador puede acceder a todo el sitio sin restricciones.

-

Sitemap: indica la ruta al sitemap de tu tienda. El mapa del sitio es una forma de decirle a los rastreadores de motores de búsqueda qué contenido priorizar, mientras que el resto del contenido en robots.txt les dice a los rastreadores qué contenido pueden o no rastrear.

También en robots.txt, puede usar varios comodines para valores de ruta como:

-

*: cuando se coloca enuser-agent, el asterisco (*) hace referencia a todos los rastreadores de motores de búsqueda (excepto los rastreadores de AdsBot) que visitan el sitio. Cuando se usa en las directivasAllow/Disallow, significa 0 o más instancias de cualquier carácter válido (por ejemplo,Allow: /example*.csscoincide con /example.css y también /example12345.css ). -

$: designa el final de una URL. Por ejemplo,Disallow: /*.php$bloqueará todos los archivos que terminen en .php -

#: designa el comienzo de un comentario, que los rastreadores ignorarán.

Nota : a excepción de la ruta sitemap.xml, las rutas en robots.txt siempre son relativas , lo que significa que no puede usar URL completas (p. ej., https://simicart.com/nogooglebot/) para especificar rutas.

Configuración de robots.txt en Magento 2

Para acceder al editor de archivos robots.txt, en su administrador de Magento 2:

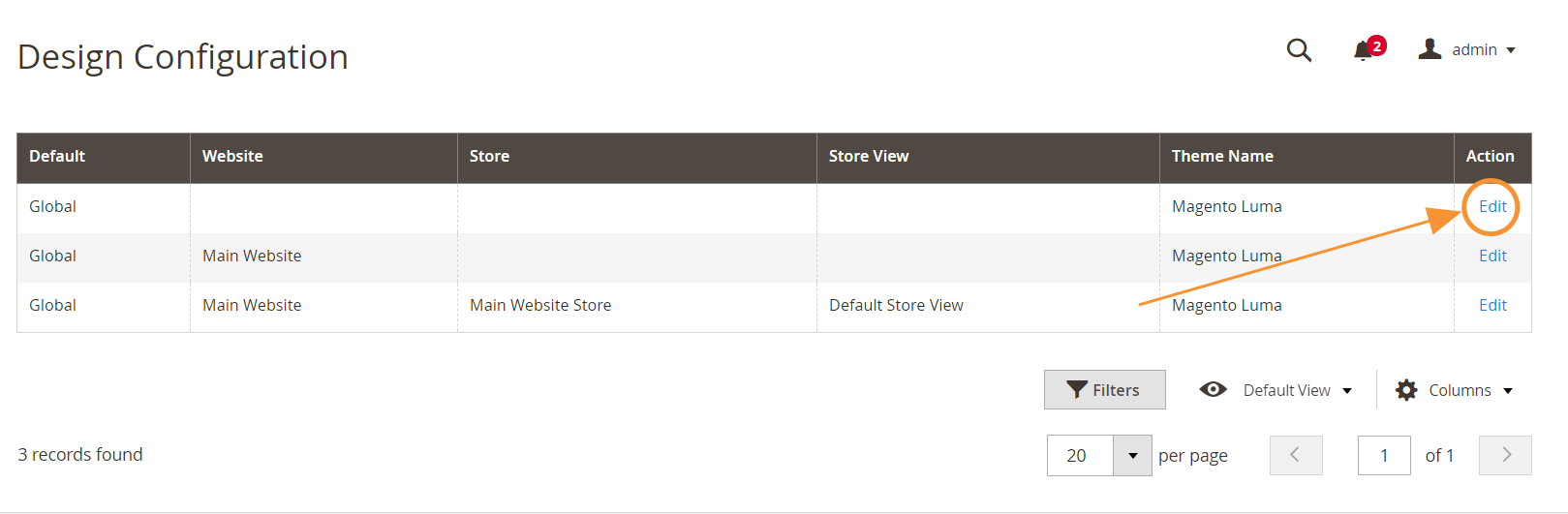

Paso 1 : Vaya a Contenido > Diseño > Configuración

Paso 2 : edite la configuración global en la primera fila

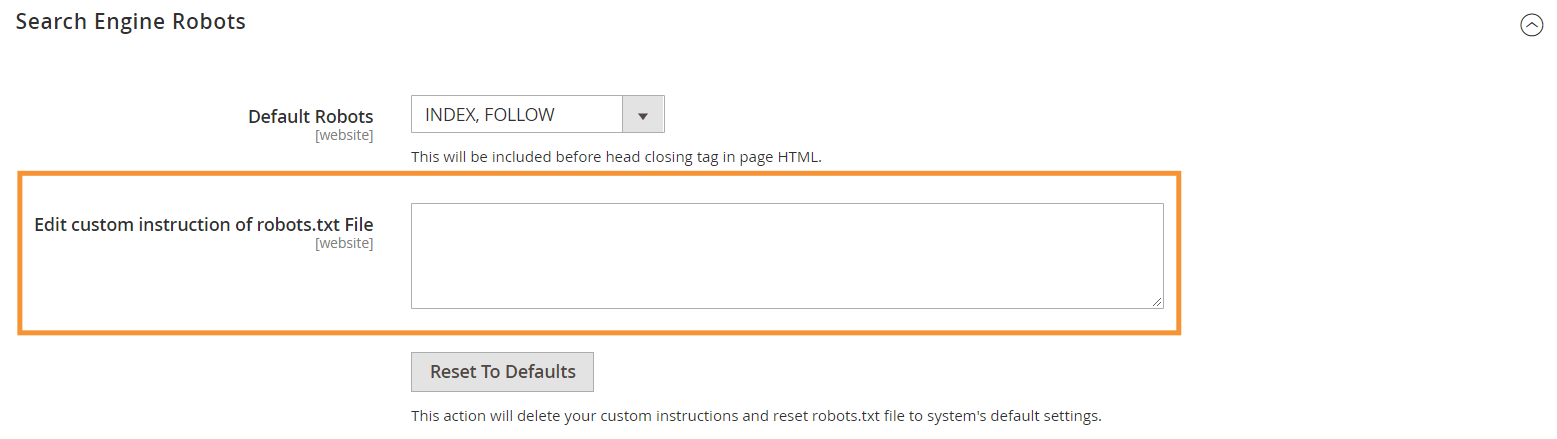

Paso 3 : en la sección Robots de motores de búsqueda, edite las instrucciones personalizadas

Instrucciones recomendadas de robots.txt

Aquí están nuestras instrucciones recomendadas que deben ajustarse a las necesidades generales. Por supuesto, cada tienda es diferente y es posible que deba modificar o agregar algunas reglas más para obtener los mejores resultados.

Agente de usuario: * # Instrucciones predeterminadas: No permitir: /lib/ No permitir: /*.php$ No permitir: /pkginfo/ No permitir: /informe/ No permitir: /var/ No permitir: /catálogo/ No permitir: /cliente/ No permitir: /enviaramigo/ No permitir: /reseña/ No permitir: /*SID= # No permitir archivos comunes de Magento en el directorio raíz: No permitir: /cron.php No permitir: /cron.sh No permitir: /error_log No permitir: /install.php No permitir: /LICENCIA.html No permitir: /LICENCIA.txt No permitir: /LICENSE_AFL.txt No permitir: /ESTADO.txt # Deshabilitar cuenta de usuario & Páginas de pago: No permitir: /pagar/ No permitir: /onestepcheckout/ No permitir: /cliente/ No permitir: /cliente/cuenta/ No permitir: /cliente/cuenta/inicio de sesión/ # No permitir páginas de búsqueda de catálogo: No permitir: /búsqueda de catálogo/ No permitir: /catalog/product_compare/ No permitir: /catálogo/categoría/vista/ No permitir: /catálogo/producto/ver/ # No permitir búsquedas de filtro de URL No permitir: /?dir* No permitir: //?dir=desc No permitir: //?dir=asc No permitir: //?limit=all No permitir: /?modo* # No permitir directorios CMS: No permitir: /aplicación/ No permitir: /bin/ No permitir: /dev/ No permitir: /lib/ No permitir: /servidorphp/ No permitir: /pub/ # No permitir contenido duplicado: No permitir: /etiqueta/ No permitir: /reseña/ No permitir: /?*product_list_mode= No permitir: /?*product_list_order= No permitir: /?*product_list_limit= No permitir: /?*product_list_dir= # Configuración del servidor # No permitir directorios y archivos técnicos generales en un servidor No permitir: /cgi-bin/ No permitir: /cleanup.php No permitir: /apc.php No permitir: /memcache.php No permitir: /phpinfo.php # No permitir carpetas de control de versiones y otros No permitir: /*.git No permitir: /*.CVS No permitir: /*.Zip$ No permitir: /*.Svn$ No permitir: /*.Idea$ No permitir: /*.Sql$ No permitir: /*.Tgz$ Mapa del sitio: https://www.example.com/sitemap.xml

Conclusión

Crear un archivo robots.txt es solo uno de los muchos pasos en la lista de verificación de Magento SEO, y optimizar adecuadamente una tienda Magento para los motores de búsqueda no es una tarea fácil para la mayoría de los propietarios de tiendas. Si no desea ocuparse de esto, podemos encargarnos de todo por usted. Aquí en SimiCart, brindamos servicios de optimización de velocidad y SEO que garantizan los mejores resultados para su tienda.