マーケティング データを収集するための上位 15 の ETL ツール

公開: 2023-03-22最新の高度なマーケティング分析は、ETL ツールなしでは想像しがたいものです。 結局のところ、企業がレポートの作成と洞察の検索を開始する前に、さまざまなソースから収集したすべてのデータを処理する必要があります。クリーニング、検証、1 つの形式への変換、および結合です。 これが ETL ツールの目的です。 この記事では、2023 年の上位 15 の ETL サービスについて詳しく説明し、ビジネスに最適なサービスを選択できるようにします。

目次

- ETLとは?

- ETL ツールの種類

- ETL ツールを選択する基準は何ですか?

- マーケティング データを収集するための上位 15 の ETL ツール

- 短い結論

ETLとは?

ETL (抽出、変換、読み込み) は、データ駆動型分析を支えるデータ統合プロセスです。 次の 3 つの手順で構成されます。

- データは元のソースから抽出されます。

- その後、データは分析に適した形式に変換されます。

- 最後に、データはストレージ、データ レイク、またはビジネス インテリジェンス (BI) システムに読み込まれます。

ETL は、データ分析を成功させるための基盤を提供し、すべての企業データの一貫性と最新性を確保するための信頼できる唯一の情報源を提供します。

ETL ツールとは

ETL ツールは、ETL プロセスの実行を支援するサービスです。 簡単に言えば、ETL ツールを使用すると、企業は複数のソースからさまざまな種類のデータを収集し、単一の形式に変換して、Google BigQuery、Snowflake、Azure などの中央リポジトリにアップロードできます。

ETL ツールの利点は何ですか?

- 時間を節約し、手作業によるデータ処理を排除します。 ETL ツールは、データを自動的に収集、変換、および統合するのに役立ちます。

- タイムゾーン、クライアント名、デバイス ID、場所など、大量の複雑で多様なデータを簡単に操作できるようにします。

- 人的要因によるデータ エラーのリスクを軽減します。

- 意思決定を改善します。 ETL は、重要なデータの処理を自動化し、エラーを減らすことで、分析のために受け取るデータが高品質で信頼できるものであることを保証します。

- 時間、労力、およびリソースを節約できるため、ETL プロセスは最終的に ROI の向上に役立ちます。

ETL ツールの種類を考えてみましょう。

ETL ツールの種類

すべての ETL ツールは、インフラストラクチャとサポートする組織またはベンダーに応じて、大まかに 4 つのタイプに分けることができます。 ローカル環境で動作するように設計されたものもあれば、クラウドで動作するように設計されたものもあれば、ローカルとクラウドの両方で動作するように設計されたものもあります。

1. クラウドベースの ETL ツール

クラウドベースの ETL ツールは、ソースからデータを抽出し、クラウド ストレージに直接ロードします。 次に、クラウドのパワーとスケールを使用して、このデータを変換できます。 これは基本的に、データがストレージにロードされた後にデータ変換が行われる、おなじみの ETL プロセスに対する最新のアプローチです。

従来の ETL ツールは、さまざまなソースからデータを抽出して変換してから、ウェアハウスにロードします。 クラウド ストレージの出現により、ソース ストレージとターゲット ストレージの場所の間の中間段階でデータをクリーニングする必要がなくなりました。

クラウドベースの ETL ツールは、高度な分析に特に関連しています。 たとえば、生データをデータ レイクにロードしてから、それを他のソースからのデータと組み合わせたり、予測モデルのトレーニングに使用したりできます。 データを生の形式で保存することで、アナリストは能力を拡張できます。 このアプローチは、最新のデータ処理エンジンの能力を活用し、不要なデータ移動を削減するため、より高速です。

2. エンタープライズ ETL ツール

これらは、商業組織によって開発された ETL ツールであり、多くの場合、大規模な分析プラットフォームの一部です。 エンタープライズ ETL ツールの利点には、長い間市場に出回っているため、信頼性と成熟度が含まれます。 また、ETL フローを設計するためのグラフィカル ユーザー インターフェイス (GUI)、ほとんどのリレーショナルおよび非リレーショナル データベースのサポート、高レベルのカスタマー サポート、豊富なドキュメントなど、高度な機能を提供する場合もあります。

マイナス面としては、エンタープライズ ETL ツールは通常、他のツールよりも高価であり、従業員に追加のトレーニングが必要であり、統合が困難です。

3. オープンソースの ETL ツール

これらは、データ フローを作成および管理するための GUI を提供する無料の ETL ツールです。 これらのサービスはオープンソースであるため、ユーザーはサービスの仕組みを理解し、機能を拡張できます。

オープンソースの ETL ツールは、有料サービスに代わる予算です。 複雑な変換をサポートしていないものや、カスタマー サポートを提供していないものもあります。

4. カスタム ETL ツール

これらは、企業が SQL、Python、または Java を使用して独自に作成する ETL ツールです。 一方では、このようなソリューションには優れた柔軟性があり、ビジネス ニーズに適応できます。 一方で、テスト、メンテナンス、および更新には多くのリソースが必要です。

ETL ツールを選択する基準は何ですか?

ETL ツールを選択するときは、ビジネス要件、収集するデータの量、そのデータのソース、およびその使用方法を考慮する必要があります。

ETL ツールを選択する際の注意事項:

- 使いやすさとメンテナンス。

- ツールの速度。

- データのセキュリティと品質。 データ品質監査を提供する ETL ツールは、不整合や重複を特定し、データ エラーを減らすのに役立ちます。 監視機能は、互換性のないデータ型やその他の問題に対処している場合に警告することができます。

- 多くの異なるソースからのデータを処理する能力。 1 つの企業で、さまざまなデータ形式の数百ものソースを扱うことができます。 構造化データと半構造化データ、リアルタイム ストリーミング データ、フラット ファイル、CSV ファイルなどがあります。このデータの一部はバッチで変換するのが最適ですが、他のデータは継続的なストリーミング データ変換で処理するのが最適です。

- 利用可能なコネクタの数と種類。

- スケーラビリティ。 収集されるデータの量は、年々増加する一方です。 はい、今はローカル データベースとバッチ アップロードで問題ないかもしれませんが、ビジネスにとっては常にそれで十分でしょうか? ETL プロセスと容量を無期限にスケーリングできることが理想的です。 データ駆動型の意思決定を行う場合は、大規模かつ迅速に考え、大量のデータを迅速かつ安価に処理できるクラウド ストレージ サービス (Google BigQuery など) を活用してください。

- ウェアハウスやデータ レイクなど、データ プラットフォームの他のコンポーネントと統合する機能。

ETL ツールの種類と機能について説明したので、これらのツールの中で最も人気のあるツールを見てみましょう。

マーケティング データを収集するための上位 15 の ETL ツール

市場には、時間とお金を節約しながらデータ管理を簡素化するのに役立つ ETL ツールが数多くあります。 クラウドで動作する ETL ツールから始めて、それらのいくつかを見てみましょう。

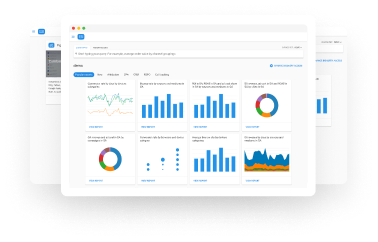

1. OWOX BI

OWOX BI は、データ管理とレポート作成を簡素化するコード不要の ETL/ELT デジタル分析プラットフォームです。 OWOX BI プラットフォームを使用すると、安全な Google BigQuery クラウド ストレージで複雑なレポートのマーケティング データを収集できます。

OWOX BI の主な機能:

- さまざまなソースからの自動データ収集。

- 生データの Google BigQuery への自動インポート。

- クリーニング、重複排除、品質監視、およびデータ更新。

- データ モデリングとビジネス対応データの準備。

- アナリストの助けや SQL の知識がなくてもレポートを作成できます。

OWOX BI は、さまざまなソースから生データを自動的に収集し、レポートの作成に便利な形式に変換します。 マーケティング担当者にとって重要なニュアンスを考慮して、必要な構造に自動的に変換された既製のデータセットを受け取ります。 複雑な変換の開発と維持、データ構造の掘り下げ、不一致の理由の特定に時間を費やす必要はありません。

OWOX BI は貴重な時間を解放するので、広告キャンペーンと成長分野の最適化により多くの注意を払うことができます。

OWOX BI を利用すれば、アナリストからのレポートを待つ必要がなくなります。 シミュレートされたデータに基づいて、ビジネスに適した既製のダッシュボードまたはカスタマイズされたレポートを取得できます。

OWOX BI 独自のアプローチにより、SQL クエリを書き直したり、レポートの順序を変更したりすることなく、データ ソースとデータ構造を変更できます。 これは特に、Google アナリティクス 4 のリリースに関連しています。

デモにサインアップして、ビジネスにおける OWOX BI の可能性について詳しく学んでください。

2. AWS グルー

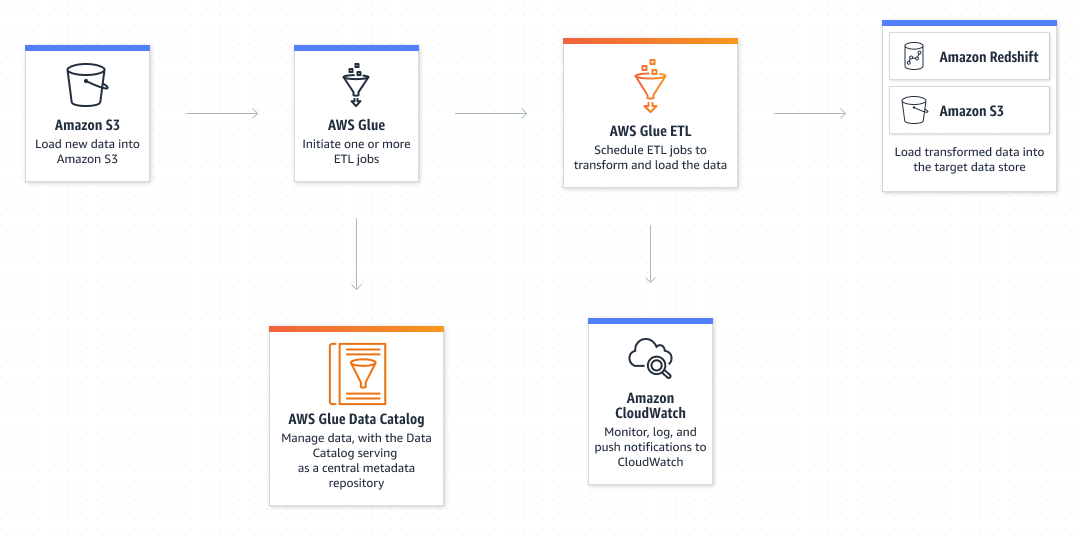

AWS Glue は、分析、機械学習、およびアプリケーション開発のために、複数のソースからデータを簡単に検出、準備、移動、および統合できるようにする Amazon のサーバーレス ETL サービスです。

AWS Glue の主な機能:

- 70 を超えるさまざまなデータ ソースとの統合。

- GUI とコード (Python/Scala) の両方を使用して、データ フローを作成および管理する機能。

- ETL モードと ELT モードの両方で動作する可能性 — AWS Glue は主にバッチ処理に重点を置いていますが、ストリーミング データもサポートしています。

- カスタム SQL クエリのサポートにより、データのやり取りが容易になります。

- スケジュールに従ってプロセスを実行する機能 — たとえば、Amazon S3 ストレージで新しいデータが利用可能になったときに ETL タスクを実行するように AWS Glue を設定できます。

- Data Catalog を使用すると、AWS 上のさまざまなデータセットを移動せずにすばやく見つけることができます — カタログ化されると、Amazon Athena、Amazon EMR、および Amazon Redshift Spectrum を使用してデータを検索およびクエリできるようになります。

- データ品質監視機能。

3. Azure データ ファクトリ

Azure Data Factory は、スケーラブルなサーバーレス データの統合と変換のための Microsoft のクラウドベースの ETL サービスです。 データ フローを直感的に作成、監視、および管理するためのコード不要のユーザー インターフェイスを提供します。

AWS Glue の主な機能:

- 70 を超えるさまざまなデータ ソースとの統合。

- GUI とコード (Python/Scala) の両方を使用して、データ フローを作成および管理する機能。

- ETL モードと ELT モードの両方で動作する可能性 — AWS Glue は主にバッチ処理に重点を置いていますが、ストリーミング データもサポートしています。

- カスタム SQL クエリのサポートにより、データのやり取りが容易になります。

- スケジュールに従ってプロセスを実行する機能 — たとえば、Amazon S3 ストレージで新しいデータが利用可能になったときに ETL タスクを実行するように AWS Glue を設定できます。

- Data Catalog を使用すると、AWS 上のさまざまなデータセットを移動せずにすばやく見つけることができます — カタログ化されると、Amazon Athena、Amazon EMR、および Amazon Redshift Spectrum を使用してデータを検索およびクエリできるようになります。

- データ品質監視機能。

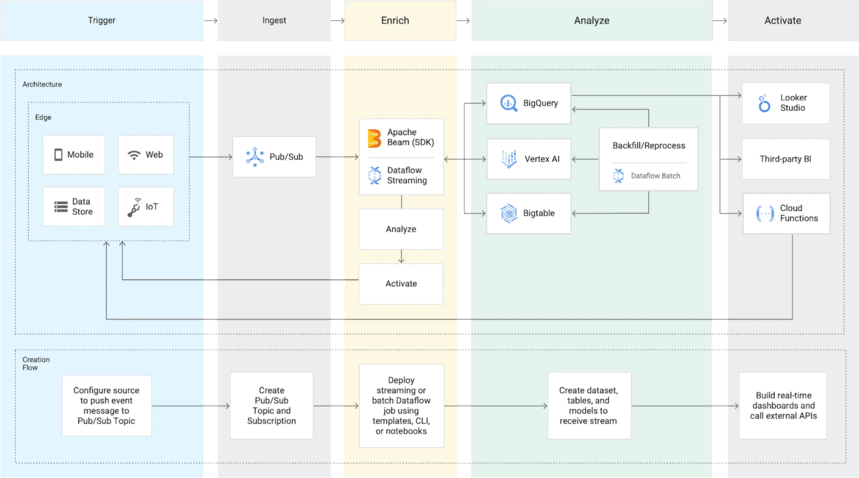

4. Google クラウド データフロー

Dataflow は Google のクラウドベースの ETL サービスで、ストリーミング データとバッチ データの両方を処理でき、サーバーを所有する必要はありません。

Google Cloud Dataflow の主な機能:

- 多くのデータ ソース (SaaS を除く) をサポート — Cloud Dataflow は、バッチ データとストリーミング データの両方の取り込みを提供します。 バッチ処理の場合、GCP でホストされているデータベースとローカル データベースの両方にアクセスできます。 ストリーミングには PubSub を使用します。 このサービスは、データを Google Cloud Storage または BigQuery に転送します。

- Google Cloud Platform で Apache Beam パイプラインを実行します — Apache は、バッチとストリーミングの両方でデータセットを表示および転送するための Java、Python、および Go SDK を提供します。 これにより、ユーザーはデータ パイプラインに適した SDK を選択できます。

- 柔軟な価格設定 — 消費したリソースに対してのみ料金が発生し、リソースは要件とワークロードに基づいて自動的にスケーリングされます。

- Dataflow SQL を使用すると、SQL スキルを使用して、BigQuery ウェブ インターフェースから直接 Dataflow ストリーミング パイプラインを開発できます。

- 組み込みの監視により、バッチおよびストリーミング パイプラインをタイムリーにトラブルシューティングできます。 古いデータやシステムの遅延に関するアラートを設定することもできます。

- 高レベルのカスタマー サポート — Google は、Google Cloud Platform (Cloud Dataflow が含まれる) の複数のサポート プランと包括的なドキュメントを提供しています。

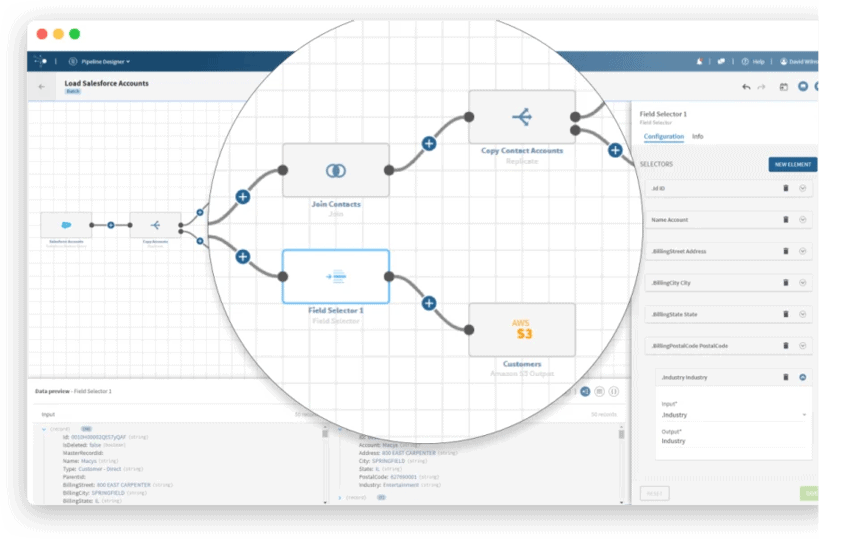

5.Integrate.io

Integrate.io は、e コマース プロジェクト専用に設計された ETL データ統合プラットフォームです。 さまざまな方法 (Integrate.io ETL、ELT、リバース ETL、API 管理) を使用して、何百ものソースからのデータを処理できます。 直観的でノーコードのインターフェイスを提供し、技術者以外の人がデータ ストリームを簡単に操作できるようにします。

Integrate.io の主な機能:

- データ ウェアハウス、データベース、SaaS クラウド プラットフォームなど、150 以上のデータ ソースと宛先用の組み込みコネクタ。

- 自動変換 — 最小限のコードで 220 を超える変換オプションがあり、あらゆるデータ要件を満たすことができます。

- 監視とアラート — 自動アラートを設定して、パイプラインがスケジュールどおりに実行されていることを確認します。

- Rest API を持つ任意のソースからデータを受信する機能 — Rest API がない場合は、Integrate.io API ジェネレーターを使用して独自のデータを作成できます。

- 電話やビデオ通話によるサポート・相談。

次に、エンタープライズ ETL ツールについて考えてみましょう。

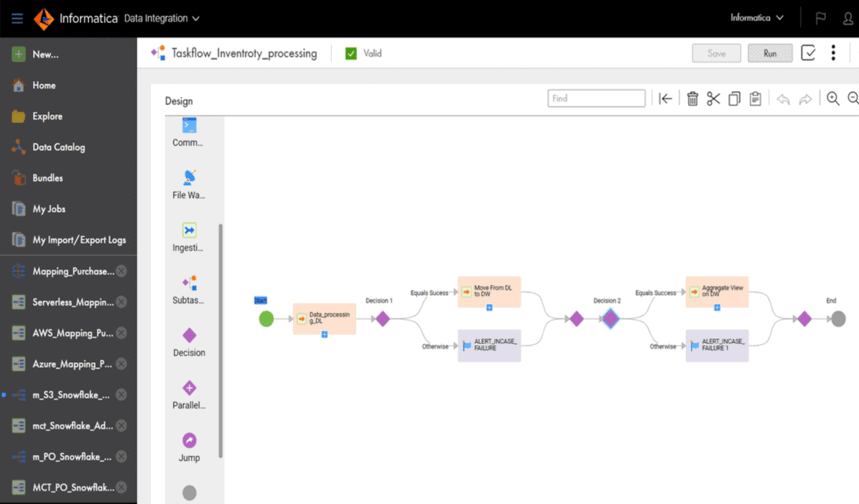

6.インフォマティカのPowerCenter

PowerCenter は、Informatica が開発した高性能のエンタープライズ データ統合プラットフォームです。 同社は、Cloud Data Integration と呼ばれるクラウドネイティブの ETL および ELT ソリューションも提供しています。

PowerCenter の主な機能:

- AWS、Azure、Google Cloud、Salesforce などのクラウド データ ストア用を含む、膨大な数のコネクタ。

- バッチ データ処理とストリーミング データ処理の両方をサポートします。

- グラフィカル ユーザー インターフェイスと事前構築済みのトランスフォーメーションにより、PowerCenter はマーケティング担当者などの非技術専門家にとって便利です。

- 自動化されたテストとデータ検証 — PowerCenter は、データ パイプラインの操作におけるエラーと障害について警告します。

- データ パイプラインの設計、展開、および監視を可能にする追加のサービスを利用できます。 たとえば、Repository Manager はユーザーの管理を支援し、Designer はユーザーがソースから宛先へのデータの流れを指定できるようにし、ワークフロー マネージャーはタスク シーケンスを定義します。

7. オラクル データ インテグレーター

Oracle Data Integrator は、複雑なデータ ウェアハウスを構築、デプロイ、および管理するためのエンタープライズ ETL プラットフォームです。 このツールは、通常の ETL サーバーに依存する代わりに、ターゲット データベースの機能を使用して、データをデータ ウェアハウスに読み込んで変換します。 事前構築済みのコネクタは、データベースとビッグ データの接続に必要な手動の統合タスクを自動化することで、統合を簡素化します。

Oracle Data Integrator の主な機能:

- Sybase、IBM DB2、Teradata、Netezza、Exadata などのデータベースと互換性があります。

- ETL および ELT モードでの作業をサポートします。

- データのエラーを自動的に検出して処理してから、データをターゲット ストレージの場所に移動します。

- 組み込みのビッグ データ サポート — ビッグ データ標準に従って Apache Spark コードを使用して、データを変換およびマッピングできます。

8.SAPデータサービス

SAP Data Services は、エンタープライズ データ管理ソフトウェアです。 このツールを使用すると、任意のソースからデータを抽出し、このデータを任意のターゲット データベースに変換、統合、およびフォーマットできます。 これを使用して、あらゆる種類のデータ マートまたはデータ ウェアハウスを作成できます。

SAP Data Services の主な機能:

- グラフィカル ユーザー インターフェイスにより、データ ストリームの作成と変換が大幅に簡素化されます。

- バッチモードとリアルタイムの両方で作業できます。

- Windows、Sun Solaris、AIX、および Linux との統合をサポートします。

- クライアントの数に関係なく、スケーリングに最適です。

- 浅い学習曲線とドラッグ アンド ドロップ インターフェイスにより、データ アナリストやデータ エンジニアは、特別なコーディング スキルがなくてもこのツールを使用できます。

- ETL プロセスの計画と制御が容易。

- 変数の存在は反復タスクの回避に役立ちます — 変数を使用すると、ユーザーは、タスクで実行するステップやタスクを実行する環境を決定するなど、さまざまなアクションを実行でき、タスク全体を再作成することなくプロセス ステップを簡単に変更できます。

- 組み込み関数 (if/then または重複排除ロジック) は、データの正規化と品質の向上に役立ちます。

- SAP を ERP システムとして使用している企業に最適です。

9. IBM データステージ

IBM DataStage は、データ移動および変換タスクの設計、開発、および実行を支援するデータ統合ツールです。 DataStage は、ETL プロセスと ELT プロセスの両方をサポートしています。 基本バージョンはローカル展開用です。 ただし、IBM Cloud Pak for Data と呼ばれるサービスのクラウド バージョンも利用できます。

IBM DataStage の主な機能:

- データ・ソースおよびデータ・ストア (Oracle、Hadoop システム、および IBM InfoSphere Information Server に含まれるすべてのサービスを含む) と統合するための多数の組み込みコネクター。

- 並列エンジンとワークロード バランシングにより、ETL タスクを 30% 速く完了します。

- ユーザーフレンドリーなインターフェースと機械学習支援設計により、開発コストを削減できます。

- データリネージュにより、データがどのように変換および統合されるかを確認できます。

- IBM InfoSphere QualityStage を使用すると、データ品質をモニターできます。

- 大規模なデータセットや大企業を扱う企業に特に関連します。

10. Microsoft SQL Server 統合サービス (SSIS)

SQL Server Integration Services は、データの統合と変換のためのエンタープライズ ETL プラットフォームです。 XML ファイル、フラット ファイル、リレーショナル データベースなどのソースからデータを抽出して変換し、データ ウェアハウスにロードできます。 Microsoft 製品であるため、SSIS は Microsoft SQL Server のみをサポートします。

SSIS の主な機能:

- SSIS GUI ツールを使用して、コードを 1 行も書かずにパイプラインを作成できます。

- 開発に必要なコードの量を最小限に抑える、幅広い組み込みタスクと変換を提供します。

- プラグインを使用して Salesforce および CRM と統合できます。 TFS や GitHub などの変更管理ソフトウェアと統合することもできます。

- データ ストリームでのデバッグ機能と簡単なエラー処理。

次に、オープンソースの ETL ツールについて考えてみましょう。

11. タレンド オープン スタジオ (TOS)

Talend Open Studio は、複雑なデータを意思決定者が理解できる情報に変換するのに役立つ無料のオープンソース統合ソフトウェアです。 このシンプルで直感的なツールは、米国で広く使用されています。 他の主要企業の製品と簡単に競合できます。

TOS を使用すると、基本的なデータ パイプラインの構築をすぐに開始できます。 簡単な ETL およびデータ統合タスクを実行し、データのグラフィカル プロファイルを取得し、ローカルにインストールされたオープンソース環境からファイルを管理できます。

Talend Open Studio の主な機能:

- さまざまなデータ ソースに接続するための 900 を超えるコネクタ — データ ソースは、Excel、Dropbox、Oracle、Salesforce、Microsoft Dynamics、およびその他のデータ ソースからのドラッグ アンド ドロップを使用して、Open Studio GUI を介して接続できます。

- Amazon AWS、Google Cloud、Microsoft Azure などの巨大なクラウド ストレージとうまく連携します。

- Java テクノロジにより、ユーザーは世界中のライブラリから複数のスクリプトを統合できます。

- Talend コミュニティは、ベスト プラクティスを共有し、まだ試していない新しいトリックを見つける場所です。

12. Pentaho データ統合 (PDI)

Pentaho Data Integration (旧称 Kettle) は、日立が所有するオープンソースの ETL ツールです。 このサービスには、データ パイプラインを作成するためのグラフィカル ユーザー インターフェイスがいくつかあります。 ユーザーは、Spoon PDI クライアントを使用してタスクとデータ変換を設計し、Kitchen を使用してそれらを実行できます。

Pentaho データ統合の主な機能:

- Community と Enterprise (拡張機能付き) の 2 つのバージョンがあります。

- クラウドまたはオンプレミスにデプロイできますが、ETL のローカル バッチ シナリオに特化しています。

- ドラッグ アンド ドロップ機能を備えた便利なグラフィカル ユーザー インターフェイス。

- 共有ライブラリにより、ETL の実行と開発プロセスが簡素化されます。

- XML 形式で保存された ETL 手順に基づいて動作します。

- コード生成が不要な点が競合他社と異なります。

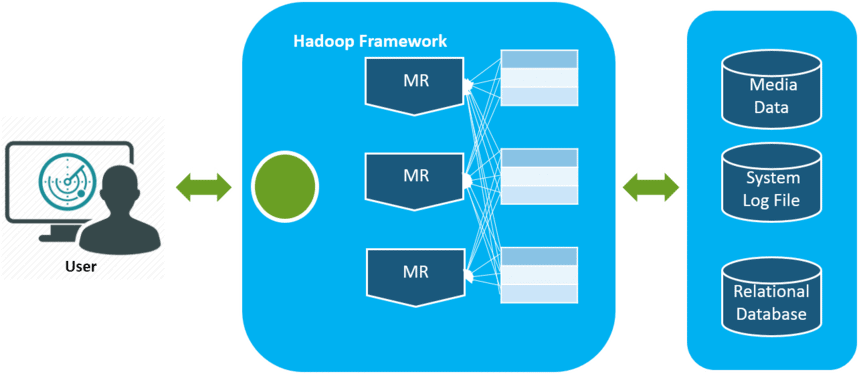

13.アパッチハドループ

Apache Hadoop は、コンピューティング クラスター間でコンピューティング負荷を分散することにより、大量のデータを処理および格納するためのオープン ソース プラットフォームです。 Hadoop の主な利点はスケーラビリティです。 単一ノードでの実行から数千ノードへの実行にシームレスに移行します。 さらに、そのコードはビジネス要件に従って変更できます。

Hadoop の主な機能:

- Java アプリケーションに基づくオープンソースであるため、すべてのプラットフォームと互換性があります。

- 耐障害性 — ノードに障害が発生した場合、そのノード上のデータを他のノードから簡単に復元できます。

- データの複数のコピーは、ハードウェア障害が発生した場合でも使用できることを意味します。

- フレームワークがすべてを処理するため、分散コンピューティング クライアントは必要ありません。

14. Skyvia データ統合

Skyvia は、統合、管理、バックアップ、およびデータ アクセスのための Devart のオールインワン クラウド データ プラットフォームです。

Skyvia Data Integration は、さまざまなデータ統合シナリオに対応するコード不要の ETL および ELT ツールです。 CSV ファイル、データベース (SQL Server、Oracle、PostgreSQL、MySQL)、クラウド ストレージ (Amazon Redshift、Google BigQuery、Snowflake)、アプリケーション (Salesforce、HubSpot、Dynamics CRM など) で動作します。

Skyvia データ統合の主な機能:

- クラウドを使用すると、手動での更新や展開から解放されます。

- データをクラウド アプリケーションおよびデータベースにインポートし、クラウド データを複製し、共有のために CSV ファイルにエクスポートできます。

- 完全にカスタマイズ可能なデータ同期を作成 — カスタム フィールドやオブジェクトなど、何を抽出するかを正確に決定します。

- 統合の作成には、特別な技術的知識は必要ありません。

- スケジュールに従って統合を自動的に実行する機能

- 双方向同期による重複のないデータ インポート。

- 一般的なデータ統合シナリオ用の既製のテンプレート。

15.ジャスパーソフト

Jaspersoft ETL は、データとアーキテクチャに依存しない Jaspersoft のオープンソース ソフトウェアです。 これは、オンプレミス、クラウド、ハイブリッド環境など、あらゆるソースからデータに接続して、どこでも作業できることを意味します。 さらに、必要に応じて Jaspersoft ソース コードに変更を加えることができます。

Jaspersoft ツールは、Jaspersoft Business Intelligence スイートの一部であり、カスタマイズ可能で柔軟性があり、開発者にとって使いやすいビジネス インテリジェンス プラットフォームを提供します。

Jaspersoft の主な機能:

- 標準データ管理システム (Hadoop、Google アナリティクス、および Cassandra)、アプリケーション (SugarCRM、SAP、Salesforce)、およびビッグ データ環境 (Hadoop、MongoDB) との統合。

- ローカルとクラウドの両方にデプロイできます。

- グラフィカル ユーザー インターフェイスにより、ユーザーはデータの移動と変換を簡単に設計、計画、および実行できます。

- アクティビティ ダッシュボードは、ETL タスクの実行とツールのパフォーマンスを監視するのに役立ちます。

- いつでもどこでもデータを確認できるモバイルアプリ。

短い結論

企業が収集するデータの量は日々増えており、今後も増え続けるでしょう。 今のところ、ローカル データベースとバッチ ロードを操作するだけで十分ですが、すぐに、これではビジネス ニーズを満たせなくなります。 したがって、ETL プロセスをスケーリングする機能は便利であり、特に高度な分析に関連しています。

ETL ツールの選択に関しては、ビジネスの特定のニーズについて考えてください。 ローカルで作業していて、データが予測可能であり、少数のソースからのみ取得されている場合は、従来の ETL ツールで十分です。 しかし、ますます多くの企業がクラウドまたはハイブリッド アーキテクチャに移行していることを忘れないでください。

我々の顧客

育つ 22%高速化

マーケティングで最も効果的なものを測定することで、より速く成長する

マーケティング効率を分析し、成長分野を見つけ、ROI を高めます

デモを入手