Warum ist technisches SEO wichtig?

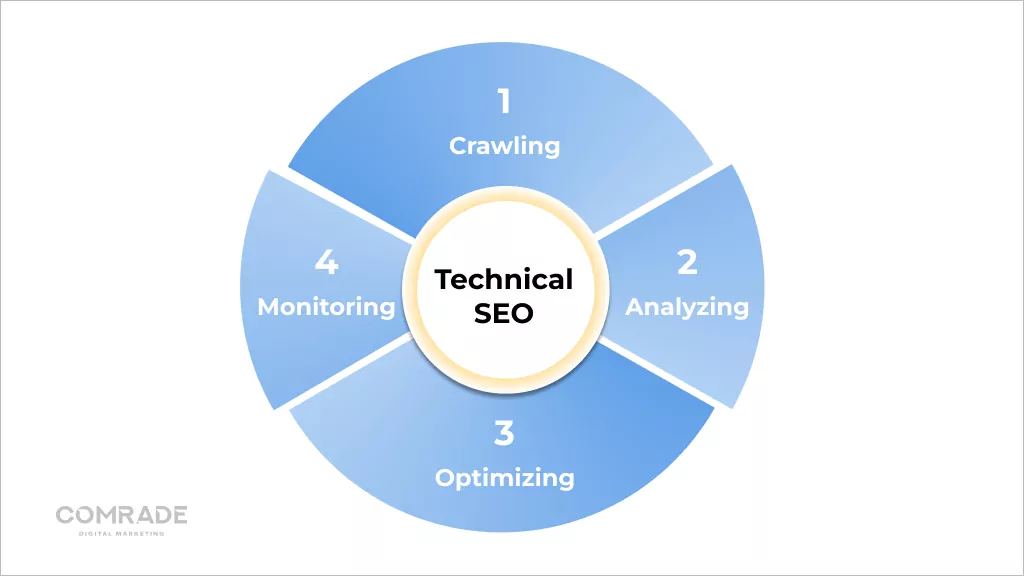

Veröffentlicht: 2022-08-03Als Teil eines SEO-Servicepakets befasst sich technisches SEO mit den technischen Komponenten einer Website wie Sitemaps, Seitengeschwindigkeit, URL, Schema, Navigation und mehr.

Fazit: Jedes Online-Geschäft braucht eine vollständig optimierte Website, um qualifizierte Leads zu gewinnen. Technisches SEO macht Ihre Website schnell, mobilfreundlich, benutzerfreundlich und zuverlässig.

In diesem Blog erklären wir technische SEO-Grundlagen, damit Sie Ihre Website optimieren können und, was noch wichtiger ist, wissen, wie Sie sich mit Ihrem Marketingteam über diesen Schlüsselaspekt der Suchmaschinenoptimierung unterhalten können.

Technisches SEO und Suchmaschinen: Wie es funktioniert

Suchmaschinen sind Softwareprogramme, die entwickelt wurden, um Personen zu helfen, die Schlüsselwörter oder Phrasen verwenden, um die Informationen zu finden, nach denen sie online suchen.

Google sagt, seine Mission sei es, „die Informationen der Welt zu organisieren und sie universell zugänglich und nützlich zu machen. Deshalb macht es die Suche einfach, eine breite Palette von Informationen aus einer Vielzahl von Quellen zu finden.“

Seine proprietären Algorithmen rufen die relevantesten und seriösesten Datenquellen ab, die Internetnutzern präsentiert werden können.

Technisch funktioniert der Prozess wie folgt:

Krabbeln

Ausgefeilte Software namens Suchmaschinen-Webcrawler, auch als „Roboter“ oder „Spider“ bezeichnet, durchsuchen das Internet nach Inhalten/URLs. Sie crawlen eine Website, indem sie ihre robots.txt-Datei herunterladen, die Regeln darüber enthält, welche URLs eine Suchmaschine crawlen soll.

Da es kein zentralisiertes Verzeichnis aller vorhandenen Webseiten gibt, suchen Suchmaschinen wie Google ständig nach neuen und aktualisierten Seiten, um sie ihrer Liste bekannter Seiten hinzuzufügen. Dies wird als „URL-Erkennung“ bezeichnet.

Jeden Tag werden weltweit mehr als 547.200 neue Websites erstellt, daher ist es wichtig, dass Googlebots ständig das Web durchsuchen!

Spider durchsuchen auch Seiten, die Suchmaschinen bekannt sind, um festzustellen, ob Änderungen vorgenommen wurden. Wenn dies der Fall ist, aktualisieren sie den Index als Reaktion auf diese Änderungen. Wenn beispielsweise ein E-Commerce-Shop seine Produktseiten aktualisiert, kann er für neue Keywords ranken.

Über ihr Crawl-Budget berechneten Webcrawler, wie oft eine Webseite neu gecrawlt und wie viele Seiten einer Website indexiert werden sollten. Dies wird durch die Begrenzung der Crawling-Rate und die Crawling-Nachfrage bestimmt.

Aufgrund begrenzter Ressourcen müssen Googlebots ihren Crawling-Aufwand priorisieren, und die Zuweisung eines Crawling-Budgets für jede Website hilft ihnen dabei. Wenn die technische SEO einer Website auf dem neuesten Stand ist, kann sie schneller gecrawlt werden, wodurch das Crawling-Limit erhöht wird (Die Anzahl der Seiten, die ein Bot innerhalb eines bestimmten Zeitrahmens crawlt).

Umgekehrt, wenn eine Website aufgrund schlechter technischer SEO langsamer wird, crawlen Googlebots weniger. Logischerweise macht es keinen Sinn, eine Website mit schlechter technischer SEO zu crawlen, da sie keine positive Benutzererfahrung bietet, was den Hauptzielen von Google zuwiderläuft.

Allerdings hat Google folgendes zum Crawl-Budget veröffentlicht:

„Das Crawling-Budget … ist etwas, worüber sich die meisten Publisher keine Sorgen machen müssen … neue Seiten werden in der Regel am selben Tag gecrawlt, an dem sie veröffentlicht werden. Das Crawl-Budget ist nichts, worauf sich Webmaster konzentrieren müssen.“

Neuere Seiten oder solche, die nicht gut verlinkt oder aktualisiert sind, können vom Crawling-Budget betroffen sein. In den meisten Fällen wird jedoch eine Website mit weniger als 1000 URLs, die regelmäßig aktualisiert wird, die meiste Zeit effizient gecrawlt.

Rendern

Rendering ist die grafische Kodierung von Informationen auf Webseiten. Laienhaft ausgedrückt handelt es sich um den Prozess des „Malens von Text und Bildern auf dem Bildschirm“, damit Suchmaschinen verstehen können, worum es beim Layout einer Webseite geht.

Suchmaschinen extrahieren den HTML-Code der Website und übersetzen ihn in Dinge wie Textblöcke, Bilder, Videos und andere Elemente. Rendering hilft Suchmaschinen, die Benutzererfahrung zu verstehen, und ist ein notwendiger Schritt, um relevante Fragen im Zusammenhang mit Indexierung und Ranking zu beantworten.

Indizierung

Nachdem eine Seite gerendert wurde, versucht Google zu verstehen, worum es geht. Dies wird Indexierung genannt. Während dieses Vorgangs analysiert Google den textlichen Inhalt (Informationen) von Webseiten, einschließlich wichtiger Inhalts-Tags, Schlüsselwörter, Alt-Attribute, Bilder, Videos usw.

Es analysiert auch die Beziehung zwischen verschiedenen Seiten und Websites, indem externe und interne Verlinkungen sowie Backlinks verfolgt werden. Je besser Sie also darin sind, Ihre Website leicht verständlich zu machen (in technisches SEO zu investieren), desto höher sind die Chancen, dass Google seine Seiten indexiert.

Links sind wie neurale Pfade des Internets, die Webseiten verbinden. Sie sind notwendig, damit Roboter die Verbindungen zwischen Webseiten verstehen und ihre Inhalte kontextualisieren können. Such-Bots folgen jedoch nicht allen URLs auf einer Website, sondern nur solchen mit DoFollow-Links (Links von anderen Websites, die auf Ihre zurückverweisen und die Domain-Autorität stärken).

Daher die Bedeutung des Linkaufbaus. Wenn externe Links von hochwertigen Domains stammen, stärken sie die Website, auf die sie verlinken, und verbessern ihre SERP-Rankings. Wenn Crawler dennoch eine Webseite finden, rendern sie den Inhalt der Seite und verfolgen alles – von Schlüsselwörtern bis zur Aktualität der Website – im Google-Suchindex.

Dieser Index ist im Wesentlichen eine digitale Bibliothek mit Billionen von Webseiten. Wenn Sie also eine Suchanfrage in eine Suchmaschine eingeben, durchsuchen Sie interessanterweise nicht direkt das Internet. Sie durchsuchen tatsächlich den Index der Webseiten einer Suchmaschine.

Rangfolge

Wenn ein Benutzer eine Suchanfrage eingibt, muss Google bestimmen, welche Seiten in seinem Index am besten zu dem passen, wonach dieser Benutzer sucht. Es gibt über 200 Ranking-Faktoren, die in fünf Hauptkategorien zusammengefasst werden können:

- Bedeutung der Suchanfrage: Der Algorithmus von Google analysiert die Absicht der Frage eines Nutzers mithilfe komplexer Sprachtools, die auf vergangenen Suchanfragen und dem Nutzungsverhalten basieren.

- Webseitenrelevanz : Die primäre Determinante der Webseitenrelevanz ist die Keyword-Analyse. Schlüsselwörter auf einer Website sollten dem Verständnis von Google von der Suchanfrage eines Nutzers entsprechen.

- Inhaltsqualität : Sobald Google Keywords von zahlreichen Webseiten abgleicht, überprüft es die Inhaltsqualität, die Autorität der Website, den individuellen PageRank und die Aktualität, um den Rang der Seiten zu priorisieren.

- Benutzerfreundlichkeit von Webseiten : Seiten, die einfach zu bedienen sind, erhalten Priorität. Website-Geschwindigkeit, Reaktionsfähigkeit und Mobilfreundlichkeit spielen eine Rolle.

- Zusätzlicher Kontext und zusätzliche Einstellungen : Schließlich berücksichtigt der Algorithmus von Google frühere Benutzerinteraktionen und spezifische Einstellungen innerhalb der Suchmaschine. Einige Signale beinhalten die Sprache der Seite und das Land, auf das sich der Inhalt richtet.

Wer mehr Traffic und ein höheres Ranking bei Google und anderen Suchmaschinen möchte, muss auf technisches SEO achten.

Wie technisches SEO das Crawlen und Indizieren von Websites verbessert

Auf der elementarsten Ebene müssen Suchmaschinen in der Lage sein, die Seiten Ihrer Website zu finden, zu crawlen, zu rendern und zu indizieren. Daher sollte die Verbesserung technischer Aspekte, dh technischer SEO, zu höheren Platzierungen in den Suchergebnissen führen.

So verbessern Sie das Website-Crawling

Crawling-Effizienz bezieht sich darauf, wie nahtlos Bots alle Seiten Ihrer Website crawlen können. Eine saubere URL-Struktur, zuverlässige Server, genaue Sitemaps und robots.txt-Dateien verbessern die Crawling-Effizienz.

1. Richten Sie Robots.txt ein

Eine robots.txt-Datei enthält Anweisungen für Suchmaschinen und wird hauptsächlich verwendet, um Crawlern mitzuteilen, welche URLs sie durchsuchen sollen.

Obwohl dies den SEO-Zielen zu widersprechen scheint, das Crawlen von Seiten zu verhindern, ist es nützlich, wenn Sie eine neue Website erstellen und mehrere Versionen derselben Seite haben und vermeiden möchten, für doppelten Inhalt bestraft zu werden.

Sie können auch eine robots.txt-Datei verwenden, um zu verhindern, dass Server überlastet werden, wenn Crawler mehrere Inhalte gleichzeitig laden, und um zu verhindern, dass private Seiten indexiert werden.

Wenn Ihre Website groß ist und Sie Schwierigkeiten haben, alle Ihre Seiten zu indizieren, hilft eine robot.txt-Datei Bots, Zeit auf wichtigen Seiten zu verbringen.

2. Wählen Sie gutes Hosting

Das Hosting wirkt sich auf die Geschwindigkeit der Website, die Serverausfallzeit und die Sicherheit aus, die die technische SEO-Leistung beeinflussen. Ein guter Webhoster ist zuverlässig, verfügbar und bietet einen effizienten Kundensupport.

Wir wissen, dass Website-Hosting teuer ist, aber die Wahrheit ist, dass Sie bekommen, wofür Sie bezahlen. Wir haben gesehen, dass Kunden häufige Fehler machen, wie z. B. die Entscheidung für Werbegeschenke, die mit einem Zustrom von Popup-Anzeigen einhergehen, die die Ladezeit der Seite verlangsamen, oder sie wählen eine billigere Option, die die Datensicherheit gefährdet.

Vertrauenswürdige Webhoster garantieren eine Verfügbarkeit von 99,9 %. Daher sollte Ihr Webhost über leistungsfähige Server mit einer robusten Infrastruktur verfügen. Eine geeignete Hosting-Lösung gewährleistet die Sicherheit, Zugänglichkeit und Zuverlässigkeit Ihrer Online-Dienste.

Holen Sie sich ein kostenloses, unverbindliches digitales SEO-Performance-Audit.

Audit anfordern

3. Löschen Sie unnötige und redundante Seiten

Search Engine Land hat kürzlich einen Artikel über die drohende Unmöglichkeit veröffentlicht, dass Google jede Seite jeder Website indiziert.

Das ist nicht unbedingt alles düster, denn minderwertige Webseiten sollten ohnehin nicht in den Suchmaschinenergebnissen erscheinen, da sie den Besuchern keinen Mehrwert bieten und die kostbare Zeit eines Suchbots (Crawl-Budget) verschwenden.

Trotzdem stoßen wir häufig auf Index-Aufblähungen, insbesondere auf E-Commerce-Websites mit großen Produktbeständen und Kundenbewertungen.

Typischerweise indizieren Suchmaschinen-Spider diese unerwünschten Seiten und untergraben die Relevanzwerte, was dazu führen kann, dass Google wichtigere Seiten ignoriert.

Daher stellen regelmäßige Seitenprüfungen und das Sauberhalten einer Website sicher, dass Bots nur wichtige URLs indizieren.

4. Vermeiden Sie doppelte Seiten

Doppelte Seiten verwässern den Linkwert und verwirren Suchmaschinen, weil sie nicht wissen, welche Webseiten sie ranken sollen, was bedeutet, dass Sie normalerweise in den SERPs gegen sich selbst antreten. Wenn Sie doppelte Seiten auf Ihrer Website haben, ist es wahrscheinlich, dass beide Seiten eine schlechte Leistung erbringen.

Duplicate Content tritt sowohl Onsite als auch Offsite auf. Offsite-Duplicate Content ist schwer zu kontrollieren. Um duplizierte Inhalte außerhalb der Website (normalerweise Content-Marketing-Material wie Blogs oder Produktseiten) zu entfernen, können Sie einen Urheberrechtsverletzungsbericht an Google senden und Google auffordern, die doppelte Seite aus seinem Index zu entfernen.

In den meisten Fällen ist Duplicate Content auf der Website kein böswilliger Versuch, Suchmaschinen-Rankings zu manipulieren, sondern eher auf eine schlechte Website-Architektur und Website-Entwicklung zurückzuführen (weitere Einzelheiten finden Sie im Abschnitt „Indizierung“).

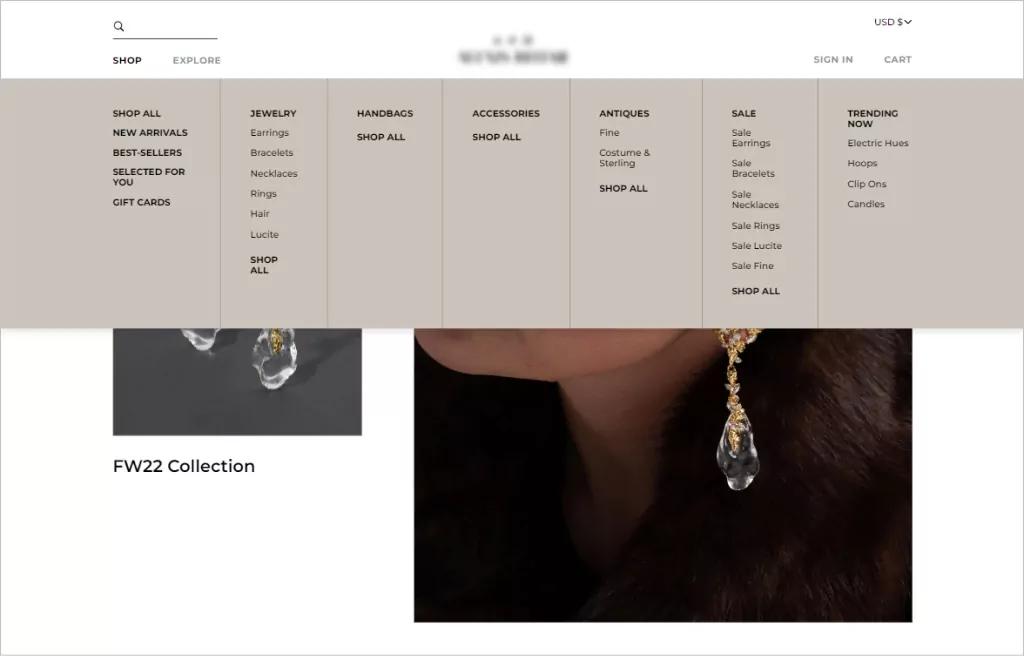

5. Implementieren Sie eine einfache Website-Navigation (für Benutzer und Roboter)

Wenn wir von Websitenavigation sprechen, beziehen wir uns auf die Linkstruktur und -hierarchie einer Website. Eine gute Website-Navigation bringt Benutzer mit so wenigen Klicks wie möglich dorthin, wo sie sein müssen.

Als allgemeine Faustregel sollte die URL-Struktur Ihrer Website es Besuchern ermöglichen, auf jeder Seite zu landen und mit drei Klicks zu finden, was sie suchen. Abgesehen von einer konsistenten Designästhetik haben Navigationsmenüs, die am besten funktionieren, eine klare hierarchische Struktur, mit anklickbaren Unterkategorien, die bei Bedarf im Menü enthalten sind.

Bei der Navigation ist Ordnung wichtig. Benutzer erinnern sich eher an den ersten und letzten Menüpunkt. Daher beginnen die meisten Navigationsstrukturen für E-Commerce-Websites mit einer Shop-Seite und enden mit einem Call-to-Action wie einem Checkout-Button.

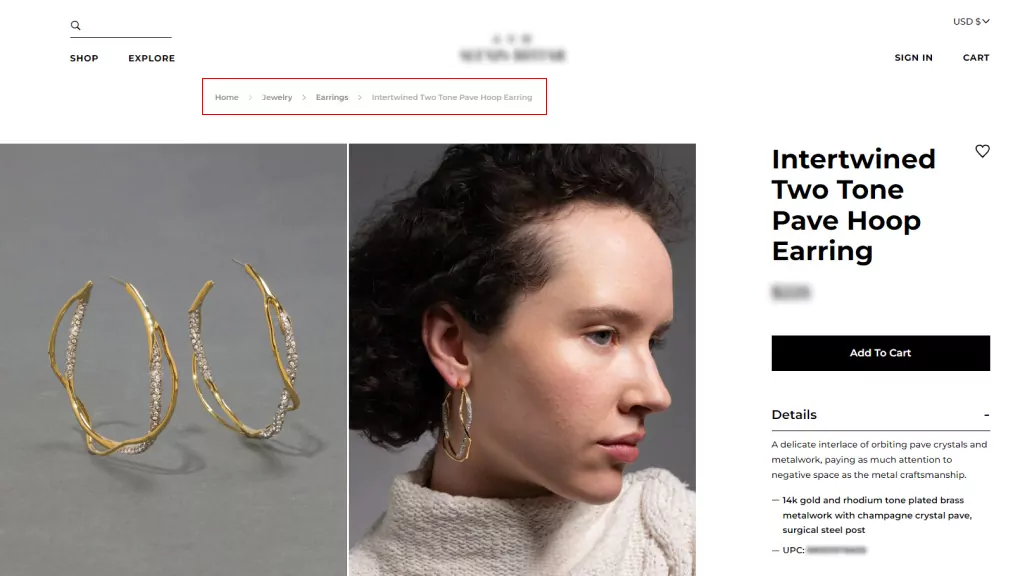

6. Verwenden Sie Semmelbrösel

Breadcrumbs sind sekundäre Navigationssysteme, die den Standort eines Benutzers auf einer Website anzeigen. Sie optimieren die Navigation für komplexe E-Commerce-Websites mit vielen Kategorien und Produktvariationsseiten und sind besonders nützlich, wenn Benutzer über einen externen Link auf eine Website gelangen, der nicht zur Startseite führt.

Breadcrumbs ergänzen Hauptnavigationsmenüs, können sie aber nicht ersetzen. Es gibt zwei Arten von Paniermehl:

- Standortbasiert, was Benutzern hilft, ihren aktuellen Standort in der Site-Struktur zu identifizieren; und

- Attributbasiert, was Benutzern hilft, wichtige Eigenschaften der angezeigten Seite zu identifizieren.

Die Verwendung von Breadcrumbs ermutigt die Leute, mehr Webseiten zu besuchen, und reduziert die Absprungrate, was insgesamt gut für SEO ist. Sie werden sie jedoch nur verwenden, wenn Ihre Websitestruktur komplex ist und Sie die Fähigkeit eines Benutzers verbessern müssen, zwischen Kategorieseiten zu navigieren.

7. Stellen Sie eine Sitemap.xml bereit

Eine Sitemap ist eine Datei, die alle Webseiten Ihrer Website auflistet, die Suchmaschinen kennen und in deren Ranking sie berücksichtigt werden sollen. Sitemaps sind zwar keine Voraussetzung für eine Website, sie werden jedoch dringend empfohlen, da sie ein effektives Website-Crawling ermöglichen.

Sitemaps sind großartige Ergänzungen für neue Websites mit begrenzten Backlinks, die indiziert werden müssen, sowie für große Websites, auf denen Seiten möglicherweise übersehen werden, wenn Metadaten nicht genau aktualisiert werden. Dasselbe gilt für Archivseiten, bei denen Webseiten nicht automatisch miteinander verlinkt sind.

Eine Sitemap bietet Suchmaschinen einen nützlichen Leitfaden, um zu verstehen, worum es auf Ihrer Website geht und wie ihre Seiten verlinkt sind. So steigert es SEO, Rankings und Traffic.

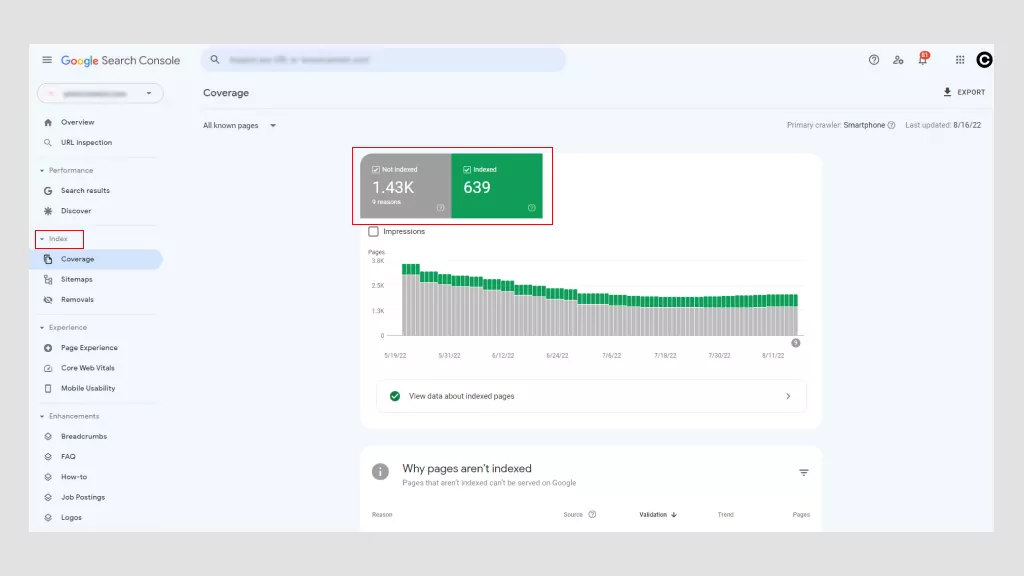

So überprüfen und beheben Sie das Crawling-Problem Ihrer Website

Die Verwendung der Google Search Console ist der beste Weg, um festzustellen, ob Ihre Website Crawling-Probleme hat. Es gibt auch andere Tools, aber der Hauptvorteil ist, dass Google kostenlos ist. Mit der Google Search Console können Sie über das Haupt-Dashboard auf „Crawling-Fehler“ zugreifen.

Google teilt diese Fehler in zwei Kategorien ein: Websitefehler und URL-Fehler. Probleme auf Websiteebene sind besorgniserregender, da sie möglicherweise die Benutzerfreundlichkeit Ihrer gesamten Website beeinträchtigen, während URL-Fehler spezifisch für einzelne Seiten sind und weniger problematisch sind, obwohl sie dennoch behoben werden sollten.

1. Mögliche Site-Fehler

- DNS-Fehler : Dies ist der Fall, wenn ein Googlebot aufgrund einer Zeitüberschreitung oder eines Suchproblems keine Verbindung zu Ihrem Domainnamen herstellen kann. Um dies zu beheben, überprüfen Sie Ihre DNS-Einstellungen. Das Problem können falsch konfigurierte DNS-Einstellungen, eine schlechte Internetverbindung oder ein veralteter Browser sein.

- Server-Konnektivitätsfehler : Wenn eine Website zu lange braucht, um zu antworten, kommt es normalerweise zu einer Zeitüberschreitung bei der Anfrage. Dies bedeutet, dass der Googlebot mit Ihrer Website verbunden ist, die Seite jedoch aufgrund einer Änderung der Netzwerkkonfiguration, einer Trennung des WLANs oder eines ausgesteckten Netzwerkkabels nicht laden konnte.

- Robots.txt-Abruffehler : In diesem Fall kann ein Googlebot eine robots.txt-Datei nicht abrufen. Das Aktualisieren Ihrer robots.txt-Datei und das erneute Crawlen Ihrer Seiten durch Bots sollte dieses Problem lösen.

2. Mögliche URL-Fehler

- Nicht gefunden (404) : Wenn Google versucht, eine Seite zu crawlen, die nicht mehr existiert, zeigt es einen 404-Fehler an. Eine einfache Möglichkeit, dies zu beheben, besteht darin, die Seite auf eine andere umzuleiten.

- Nicht verfolgt : Dies ist der Fall, wenn ein Bot URLs auf Ihrer Website nicht vollständig folgen konnte. JavaScript, Cookies, Sitzungs-IDs, DHTML oder Flash sind mögliche Übeltäter.

- 500 internal server error : Meistens treten diese Fehler auf, wenn ein Webserver überlastet ist, und werden behoben, indem Sie sich an Ihren Webhostanbieter wenden. Wenn Sie zufällig eine WordPress-Site betreiben, sollten Sie Plugins von Drittanbietern überprüfen.

Sprechen Sie mit Experten

So überprüfen und beheben Sie die Indexierungsprobleme Ihrer Website

Die Indexierung ist die Methode von Google, alle Daten von Ihren Webseiten zu sammeln und zu verarbeiten, wenn das Web gecrawlt wird. Es ermöglicht Suchmaschinen, die Geschwindigkeit und Leistung zu optimieren, wenn sie die Suchanfragen der Benutzer mit relevanten Informationen abgleichen. Als solches zeigt Google Ergebnisseiten innerhalb von Sekunden an!

Google verwendet ein abgestuftes Indizierungssystem, bei dem die beliebtesten Inhalte auf schnellerem, teurerem Speicher indiziert werden. Daher die Bedeutung von Keyword-reichen Inhalten.

Häufige Indexierungsprobleme, mit denen Webmaster konfrontiert sind, und ihre Lösungen umfassen:

1. NoIndex-Fehler

Es ist möglich, Spider (Bots) daran zu hindern, eine Seite zu crawlen, indem Sie ein noindex-Meta-Tag oder einen Header in die HTTP-Antwort einfügen. Wenn ein Googlebot auf dieses Tag stößt, entfernt er die Seite aus den Google-Suchergebnissen, unabhängig davon, ob andere Websites darauf verlinken.

Es gibt gute Gründe, ein noindex-Tag auf einer Webseite oder einem Teil davon zu verwenden, zum Beispiel:

- Um Duplicate Content zu verhindern.

- Admin- und Anmeldeseiten nur für den internen Gebrauch zu behalten.

- Um zu verhindern, dass bezahlte Zielseiten indexiert werden. Wenn Sie eine Lead-Erfassungskampagne durchführen, müssen Sie nicht Hunderte von doppelten Dankesseiten indizieren.

Ein Nicht-Index-Tag hilft dabei, wertvolle und kuratierte Inhalte von anderen Seiten zu definieren und sicherzustellen, dass die wichtigsten Seiten in SERPs verfügbar sind. Nicht-Index-Fehler haben jedoch negative Folgen, insbesondere wenn Sie möchten, dass eine Seite indexiert wird.

Wenn Google eine Seite crawlt, aber nicht indexiert, kann das zweierlei bedeuten. Entweder ist die Qualität der Seite niedrig, oder es gibt zu viele URLs im Crawling-Hinweis, und die Suchmaschine hat nicht genug Budget, um sie zu verarbeiten.

Aufgrund des E-Commerce-Booms kommt es bei Produktseiten häufig zu Nicht-Index-Fehlern. Um dem entgegenzuwirken, stellen Sie sicher, dass Produktseiten einzigartig sind (nicht von externen Quellen kopiert), implementieren Sie kanonische Tags, um doppelte Inhalte zu konsolidieren, und verwenden Sie noindex-Tags, um Googlebots daran zu hindern, Bereiche Ihrer Website mit geringer Qualität zu indizieren.

Wenn Sie aufgrund vieler URLs Noindex-Probleme haben, sollten Sie Ihr Crawl-Budget optimieren, indem Sie robot.txt-Dateien verwenden, um Google zu den wichtigsten Seiten zu leiten.

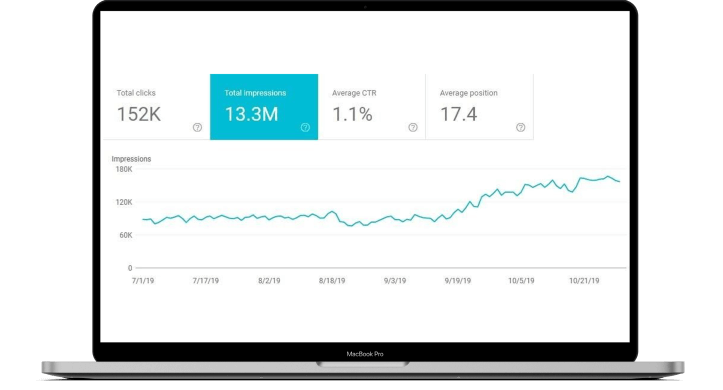

Der beste Weg, noindex-Fehler zu beheben, besteht darin, den Fehler zu entfernen und die Sitemap Ihrer Website erneut über die Google Search Console einzureichen. Die Zeit, die benötigt wird, um Nicht-Index-Fehler zu identifizieren, ist unterschiedlich (normalerweise ein Rückgang des Datenverkehrs), weshalb eine regelmäßige Überwachung der Website-Leistung von größter Bedeutung ist.

2. Falsche Hreflang-Tags

Google führte Hreflang-Tags im Jahr 2011 ein, um Seiten mit ähnlichen Inhalten, aber unterschiedlichen Zielgruppen (normalerweise durch Sprache bestimmt) zu verweisen. Sie erhöhen nicht unbedingt den Traffic, sondern bringen Suchmaschinen dazu, die richtige Version einer Webseite in SERPs auszutauschen, um den richtigen Benutzern den richtigen Inhalt zu liefern.

Unten sehen Sie, wie hreflang-Tags geschrieben werden.

<link rel=“alternate“ hreflang=“x“ target="_blank“ href=“https://example.com/blog/de/article-name/“ />

Ihre Syntax ist in drei Teile gegliedert:

- link rel = „alternative“: Zeigt der Suchmaschine an, dass es sich um eine alternative Version der Seite handelt.

- hreflang="x": Legt die Sprache fest.

- target="_blank" href="https://example.com/blog/de/article-name: Die alternative Seite, auf der die URL steht.

Angesichts der heiklen Natur von hreflang-Tags werden die meisten Probleme durch Tippfehler und die Verwendung falscher Codes und nicht vorhandener Links verursacht.

Wenn der Code falsch ist, ignorieren Google-Bots das Attribut einfach. Sie müssen das hreflang-Tag-Attribut überarbeiten, um Fehler zu erkennen, was Sie mit der Google Search Console tun können.

3. Websites, die nicht für Mobilgeräte optimiert sind

Im Jahr 2019 hat Google für alle neuen Websites standardmäßig auf die Mobile-First-Indexierung umgestellt. In der Vergangenheit wurde bei der Bewertung von Inhalten hauptsächlich die Desktop-Version des Inhalts einer Seite verwendet. Mehr als 50 % der weltweiten Suchanfragen stammen jedoch von Mobilgeräten, sodass es sinnvoller ist, die mobile Version eines bestimmten Website-Inhalts zu analysieren.

Websites, die für Mobilgeräte schlecht geeignet sind, werden in den SERPs nicht so hoch eingestuft. Heutzutage ist eine für Mobilgeräte optimierte Website eine der technischen SEO-Grundlagen des digitalen Marketings.

Sie können eine Menge tun, um Ihre Website für mobile Benutzer zugänglich zu machen. Die Optimierung von Bildern, Suchfunktionen und Navigation für Mobilgeräte verbessert die Benutzererfahrung.

Beispielsweise optimiert die Verwendung von Dropdown-Registerkarten oder Hamburger-Navigationsmenüs die Reise des Käufers. CTA-Schaltflächen sollten sich leicht mit den Fingern anklicken lassen, und die Textgröße sollte für kleinere Bildschirme angemessen sein.

An der technischen SEO-Front können Unternehmen das Browser-Caching nutzen, JavaScript und CCC verkleinern, Bilder komprimieren, um die Dateigröße zu verringern, und die AMP-Seiten von Google verwenden, um sicherzustellen, dass sie das richtige Protokoll befolgt haben.

4. Doppelte Inhalte

Wie bereits erwähnt, wirkt sich Duplicate Content negativ auf die Suchmaschinenoptimierung aus. Suchmaschinen können nicht erkennen, welche Version das Original ist, und wenn sie das Duplikat dem Original vorziehen, verlieren Sie an Link-Equity und PageRank-Power.

Wenn Ihre Website mehrere Seiten mit weitgehend identischen Inhalten enthält, gibt es mehrere Möglichkeiten, bevorzugte URLs anzugeben.

- Kanonisierung : Dies ist der Prozess der Verwendung von kanonischen Tags, um Suchmaschinen auf die richtigen Seiten für die Indexierung zu leiten. Im Wesentlichen teilen sie Bots mit, welche Seiten Sie in den SERPs erscheinen lassen möchten.

- Verwenden Sie 301s : Ein 301 ist ein HTTP-Statuscode, der eine permanente Weiterleitung von einer URL zu einer anderen signalisiert. Es übergibt die gesamte Ranking-Power von der alten URL an die neue.

- Seien Sie konsistent : Halten Sie Ihre internen Links konsistent und stellen Sie sicher, dass jede Seite eine eindeutige und saubere URL hat.

- Sorgfältig syndizieren : Schätzungen zufolge enthalten bis zu 29 % des Webs doppelte Inhalte. Es ist nicht überraschend, wenn man die Ähnlichkeit der Produktseiten und die Syndizierung von Inhalten bedenkt. Aus diesem Grund sollten Sie sicherstellen, dass die Websites, auf denen Ihre Inhalte syndiziert werden, einen Link zurück zu Ihrer ursprünglichen Webseite enthalten.

- Minimieren ähnlicher Inhalte : Erwägen Sie, ähnliche Seiten zu konsolidieren. Wenn Sie beispielsweise einen E-Commerce-Shop haben, der T-Shirts in verschiedenen Farben verkauft, die Produktinformationen jedoch im Wesentlichen gleich sind, sollten Sie eine Produktseite mit unterschiedlichen Produktbildern haben.

Die beste Lösung für doppelte Inhalte besteht darin, sie vollständig zu vermeiden und einzigartige, schlüsselwortreiche Inhalte für Ihre Website und das dazugehörige Marketingmaterial zu erstellen.

5. Langsame Seitengeschwindigkeit

Seitenladezeiten auf Websites mit weniger als 10.000 Seiten wirken sich nicht allzu sehr auf die Crawling-Rate aus, große E-Commerce-Websites mit mehr als 10.000 haben jedoch einen massiven Einfluss auf das Crawling. Doch selbst wenn Ihre Website klein ist, ist die Seitengeschwindigkeit wichtig, da sie ein Suchmaschinen-Rankingfaktor ist.

Seiten, die länger als drei Sekunden dauern, beeinträchtigen die Benutzererfahrung. Alles länger und die Leute werden frustriert und verlassen Ihre Website. Somit kann eine Sekunde über den Abschluss oder Verlust eines Verkaufs entscheiden!

Eine langsame Seitengeschwindigkeit bedeutet möglicherweise weniger Seiten, die von Google gecrawlt werden, niedrigere Rankings und Conversions sowie höhere Absprungraten. Sie können die PageSpeed Insights von Google verwenden, um festzustellen, was verbessert werden muss.

Im Allgemeinen gibt es vier Hauptschuldige:

- Große Bilder, die die falsche Größe haben oder nicht komprimiert sind

- JavaScript wird nicht asynchron geladen

- Umständliche Plugins oder Tracking-Skripte (Code, der den Fluss des Website-Verkehrs überwacht.)

- Verwenden Sie kein Content Delivery Network (CDN).

Die Verbesserung der Webseitengeschwindigkeit kann mehrere Dinge bedeuten, von der Verbesserung Ihres Website-Designs über die Größenanpassung von Bildern bis hin zum Wechsel zu einer für Mobilgeräte optimierten Website. Die Lösung kann einfach oder komplexer sein und einen zusammengesetzten Effekt auf Ihrer gesamten Website hervorrufen.

Unabhängig vom Problem ist es dennoch wichtig, technische SEO-Probleme im Zusammenhang mit der Seitengeschwindigkeit zu beheben. Gelegentlich ist es möglich, dies selbst zu tun, aber in den meisten Fällen müssen Sie einen technischen SEO-Experten beauftragen, da dies verschiedene Grade der Codierung beinhalten kann.

So überprüfen Sie, ob Ihre Webseiten indiziert sind

Kopieren Sie einfach die URL Ihrer Webseite aus der Adressleiste und fügen Sie sie in Google ein. Wenn Ihre Webseite in den Suchergebnissen auftaucht, wurde sie indexiert. Wenn nichts angezeigt wird, wurde es nicht indiziert.

Alternativ können Sie auch das URL-Inspektionstool von Google verwenden. Es überprüft die URL einer Seite und bietet Einblicke in die Auffindbarkeit, Zugänglichkeit und Indexierbarkeit.

Und denken Sie daran, nur weil Webinhalte von Google indexiert werden, heißt das noch lange nicht, dass es sich um ein Ranking handelt.

Die Tatsache, dass Ihre URL von Google indexiert wird, bedeutet nicht unbedingt, dass es sich um ein Ranking handelt. Damit eine URL rankt, braucht es oft mehr als nur die Tatsache, dass Google sie indexieren konnte.

Ihre Webseiten müssen qualitativ hochwertigen Inhalt haben, der die Absicht des Benutzers erfüllt und den technischen Anforderungen von Suchmaschinen entspricht.

Buchen Sie eine kostenlose Beratung

Wie technisches SEO das Rendering verbessert

Der Rendering-Prozess ermöglicht es Suchmaschinen-Spidern, dieselben Webseiten zu sehen, die Sie in Ihrem Browser sehen, während er geladen wird, dh aus der Perspektive eines Besuchers. Alle Suchmaschinen müssen Seiten rendern, bevor sie sie indexieren können.

Während externe Faktoren ins Spiel kommen, liegt die Grundlage für die Schaffung eines reibungslosen Rendering-Erlebnisses weitgehend in der Verantwortung des Website-Entwicklers und der technischen SEO.

Die technische Optimierung ist eine Herausforderung, da nicht nur das Backend Ihrer Website (was Benutzer online nicht sehen) so codiert werden muss, dass es für Suchmaschinen einfach zu crawlen, zu indizieren und zu rendern ist, sondern es muss auch funktionieren besser und schneller als Ihre Mitbewerber.

So helfen Sie Google, Ihre Website korrekt zu rendern

1. Verwenden Sie nicht zu viel JavaScript

Eine kurze Erklärung zu HTML, CSS und JavaScript:

- HTML : Ein Formatierungssystem, das verwendet wird, um über das Internet abgerufenes Material anzuzeigen. HTML stellt die Grundstruktur von Websites bereit, die durch Technologien wie JavaScript und CSS modifiziert werden.

- CSS : Ein Akronym für Cascading Style Sheets, CSS ist eine Technologie, die die Darstellung, Formatierung und das Layout einer Website steuert.

- JavaScript : Eine textbasierte Skriptsprache, die verwendet wird, um das Verhalten verschiedener Elemente auf Webseiten zu steuern.

Das Rendern von JavaScript dauert länger, was sich auf das Crawling-Budget auswirkt, was bedeutet, dass das Crawlen und Indizieren von Webseiten länger dauert. Es gibt viele Gründe, warum JavaScript die korrekte Darstellung Ihrer Website verhindern kann.

Eine der häufigsten ist, wenn JavaScript-Dateien durch robots.txt-Dateien blockiert werden. Dies verhindert, dass Google und andere Suchmaschinen vollständig verstehen, worum es auf Ihrer Website geht.

Aus technischer SEO-Sicht können Sie Code minimieren, Website-Assets komprimieren und statische Assets mit einem CDN verteilen, das sie von einem Server aus bereitstellt, der näher bei Ihren Website-Benutzern liegt. Dies kann die Latenz beim Herunterladen von Seiten verringern.

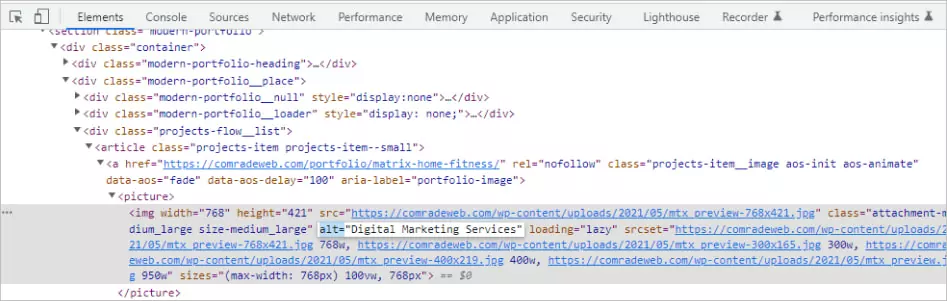

2. Verwenden Sie Alt-Attribute

Die Bildoptimierung wird oft übersehen, wenn es um die Suchmaschinenoptimierung geht, aber sie verbessert die Seitenladegeschwindigkeit und das Benutzererlebnis und verbessert gleichzeitig das SERP-Ranking.

Alt-Tags sind von besonderer Bedeutung, da sie helfen, Text anzuzeigen, wenn ein Bild aufgrund technischer Fehler wie schlechter Bandbreitenverbindung nicht von einem Browser gerendert werden kann.

Stattdessen beschreiben sie in Textform, was das Bild zeigen soll. Wenn Ihre Website keine Alt-Attribute hat, haben Suchmaschinen keine Ahnung, was Ihr Bild anzeigen sollte.

Es gibt eine Technik, um guten Alt-Text zu schreiben. Nehmen wir zum Beispiel an, Sie haben ein Bild von einer Katze, die mit einem Fadenknäuel spielt.

- Schlechte Beschreibung: Katze spielt

- Gute Beschreibung: schwarze Katze, die mit einem Fadenknäuel spielt

Beschreiben Sie Bilder immer so objektiv wie möglich. Geben Sie Kontext an, aber verwenden Sie keine Ausdrücke wie „Bild von“ oder „Bild von“, und vermeiden Sie Keyword-Stuffing.

Sie können sogar Alt-Tags für Schaltflächen verwenden. Solche Beschreibungen könnten so etwas wie „Jetzt bewerben“ oder „Angebot einholen“ lauten.

Einige SEO-freundliche Ratschläge: Vermeiden Sie die Verwendung von Bildern anstelle von Wörtern. Suchmaschinen können nicht so „lesen“, wie Menschen es können, daher ist die Verwendung eines Bildes anstelle des eigentlichen Textes für Crawler verwirrend und kann das Ranking beeinträchtigen.

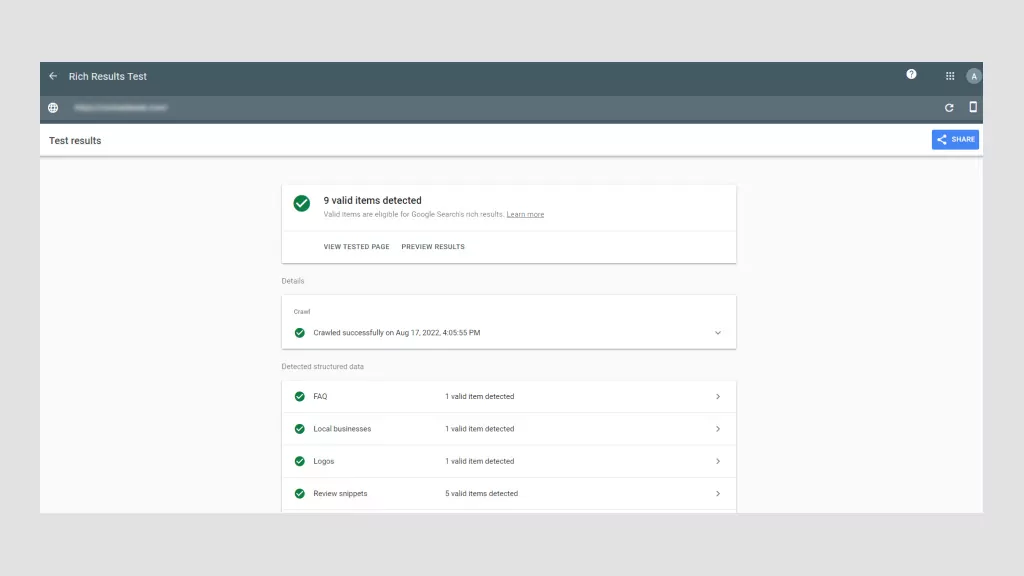

3. Verwenden Sie Schemadaten

Strukturierte Daten sind Informationen, die auf Codeebene nach bestimmten Regeln, Richtlinien und Vokabularen organisiert sind. Es übermittelt spezifische Seiteninformationen, sodass Suchmaschinen diese korrekt rendern und indizieren können.

Strukturierte Daten werden in Form von Schema-Markups implementiert. Einmal zu einer Webseite hinzugefügt, verleiht Schema-Markup dem Website-Inhalt eine klarere Definition und Struktur. Es ist im Wesentlichen eine Möglichkeit, Ihre Website für Suchmaschinen mit einem bestimmten Code-Vokabular zu beschreiben.

Insbesondere für Google erhöht es die Wahrscheinlichkeit, dass Ihre Inhalte als Rich-Suchergebnis oder Featured Snippet angezeigt werden, bei denen es sich um Seitenauflistungen handelt, die mit zusätzlichen visuellen oder interaktiven Elementen angereichert sind, die sie hervorheben.

Rich-Ergebnisse erscheinen oben in SERPs über traditionellen Textergebnissen. Selbst wenn Ihre Seite also nicht an erster Stelle steht, kann Ihre Website durch die Verwendung von Schemadaten immer noch das Erste sein, was Benutzer auf SERPs sehen.

Angenommen, Sie verkaufen Bücher online. Mit dem richtigen Schema-Markup können Sie den Autor, eine Zusammenfassung und Bewertungssterne als Rich Snippet anzeigen. Es gibt alle Arten von strukturierten Daten, die Sie beispielsweise für Filme, Rezensionen, FAQs, Rezepte und mehr verwenden können.

Strukturierte Daten sind wichtig für technisches SEO, da sie es Google und anderen Suchmaschinen erleichtern, zu verstehen, worum es auf Ihren Webseiten geht. Darüber hinaus erhöht es Ihre Klickrate, was zu mehr Traffic und noch höheren Rankings führt.

4. Vermeiden Sie Fehler im HTML-Code

Zu viele HTML-Fehler hindern Suchcrawler daran, Webinhalte zu parsen (analysieren) und führen dazu, dass sie Webseiten vorzeitig verlassen.

- Verwenden von Flash- oder JavaScript-Menüs ohne HTML : Ihr Website-Menüskript sollte HTML-Alternativen enthalten, damit Browser ohne die Fähigkeit, Flash oder JavaScript zu übersetzen, Benutzer weiterhin auf Ihren Seiten navigieren können. Wenn ein Crawler Links aufgrund von Flash oder JavaScript nicht „lesen“ kann, haben sie keinen Wert. Somit machen HTML-Menüs Ihre Webseiten kompatibler.

- Verwenden von URLs mit „unsicheren“ Zeichen : Suchmaschinen haben Schwierigkeiten, URLs mit Sonderzeichen wie „&“ oder „%“ wiederzugeben. Diese Arten von Zeichen sind aus verschiedenen Gründen unsicher, aber wahrscheinlich, weil sie in verschiedenen Codierungssystemen häufig verwendet werden, was dazu führt, dass Suchmaschinen ihre Bedeutung falsch interpretieren, was die URL beschädigen kann.

- Schwache Titel-Tags und Meta-Tags : Titel-Tags sollten das Ziel-Keyword der Webseite enthalten, während Meta-Tags prägnant erklären sollten, worum es auf der Seite geht. Beide Tags sind für die Suchmaschinenoptimierung SEO von entscheidender Bedeutung. Ersteres verbessert das Ranking, während letzteres Klicks fördert. Titel-Tags sollten 76 Zeichen nicht überschreiten, während Beschreibungs-Tags weniger als 156 Zeichen umfassen sollten.

HTML ist ziemlich technisch, aber glücklicherweise gibt es technische SEO-Plugins, die Ihnen helfen, die richtigen Tags zu implementieren, ohne zu wissen, wie man wie ein Profi programmiert. Yoast und Moz sind Industriestandards, die von Profis verwendet werden, um perfektes HTML zu gewährleisten.

Checkliste für technisches SEO: Wie man technisches SEO verbessert

Wenn Sie es ernst meinen mit der Verbesserung des technischen SEO, müssen Sie ein technisches SEO-Audit durchführen. Betrachten Sie es als einen Gesundheitscheck für Ihre Website.

Nachlässigkeit bei der technischen SEO kann zu sinkenden Zugriffszahlen und Einnahmen führen.

Wir empfehlen, jeden Monat ein Mini-Site-Audit und alle vier bis fünf Monate ein umfassendes technisches Audit durchzuführen.

Schritt 01: Analysieren Sie Ihre Navigation

Google-Bots sollten in der Lage sein, alle Seiten Ihrer Website zu crawlen und zu indizieren, einschließlich Breadcrumbs und der XML-Sitemap Ihrer Website. Unabhängig von der Art der Navigation muss Ihre Website eine saubere URL-Struktur haben.

Beispielsweise möchten Sie eine logische Eltern-Kind-Seitenstruktur haben. Angenommen, Sie betreiben ein Einrichtungsgeschäft. Eine übergeordnete URL könnte lauten: https://lovemyhome.com/bedroom und Seiten mit Schlafzimmermöbeln und -dekor enthalten. Daher könnte eine untergeordnete URL wie folgt aussehen: https://lovemyhome.com/bedroom/side-tables.

Sie möchten auch verwaiste Seiten vermeiden. Dies ist der Fall, wenn eine Website-Seite nicht mit einer anderen Seite oder einem anderen Abschnitt Ihrer Website verlinkt ist. Es teilt Suchmaschinen mit, dass es unwichtig ist.

Denken Sie dann bei der Primärnavigation daran, Ihre service- und lösungsorientierten Seiten einzubeziehen, und fügen Sie nicht mehr als 30 Links auf diesen Seiten ein, um Linkjuice zu sparen.

Die Prüfung der Site-Architektur besteht aus zwei Komponenten. Der erste hat mit technischen Faktoren wie der Behebung defekter Links zu tun, und der zweite hat mit der Benutzererfahrung zu tun. Die Software von Google macht es relativ einfach, die erste durchzuführen.

However, when it comes to UX, human feedback helps. If you're struggling to view your website with fresh eyes, ask family and friends to review it. The less they know about UX, the better, as they more than likely represent everyday users.

Ask yourself (and them):

- Is my website clear?

- Does my main navigation bar link to the most important pages?

- Is it easy for visitors to contact me?

- Can a visitor understand what my business is about and how I can help them just by visiting my website?

Step 02: Check for Duplicate Content

Using top-tier software like SEMRush, Moz or Screamingfrog is the best way to check for duplicate content. These SEO review tools will flag both external and internal content for specific web pages.

If you're tempted to copy and paste sentences from your web copy into Google Search to see if other URLs pop up, don't. This isn't accurate and unnecessarily wastes precious time when there are far more sophisticated options available.

As we mentioned earlier, roughly 30% of all webpage content is duplicated. So, as always, the more original your content the better. Try to keep your duplicate content below this threshold.

Lastly, you'll want to eliminate boilerplate content. This is when the same content is present on different website pages, like terms and conditions, for example. In this instance, it's better to create a single webpage for T&Cs and ensure all the other pages have internal links to it.

Step 03: Check Site Speed and Mobile-Optimization with Google

You can use Google's PageSpeed Insights to ensure your website is fast on all devices. Google's software scores your website speed out of 100. What's important to remember is that page speed is somewhat relative in the sense that people using a mobile on a 3G connection will experience “slowness” for every website they're using.

Additionally, there is also a trade-off between speed and user experience. Some page elements will impact page speed. Of course, you should aim for the fastest speed possible, so long as you're aware, which we're sure you are after reading this article, that many factors affect search engine optimization SEO.

In terms of site speed analysis, it's handy to analyze your competitors' site speeds, so you know what you're up against and can benchmark your results.

As for mobile optimization, Google also has a Mobile-Friendly Test that live-tests your URL. Its detailed report suggests improvement recommendations and directs you to Google Search Console for in-depth analysis and help.

Step 04: Collect and Redirect “Useless Pages”

None of your web pages should be useless. If they are, you need to get rid of them, especially if they're placeholder pages. These look unprofessional and are bad for SEO. It's honestly better to just launch your website when it's ready.

Any web pages “under construction” with zero content won't rank highly. What's more, if they rank for keywords people are searching for, and they don't offer value, your business immediately loses credibility. They serve no navigational purpose and get ignored by Google bots.

However, some web pages are useful for customers but not for Google in terms of pagination or index filters:

- Landing pages for ads

- Thank-you pages

- Privacy and policy pages

- Admin pages

- Duplicate pages

- Low-value pages (eg, outdated content that may still be valuable)

You can either use a nonindex meta tag or a robots.txt file to prevent Google from indexing these pages. It can take time for Google to instigate these changes. Pages that still appear in results despite noindex directives may not have been crawled since your request. You can ask Google to recrawl these pages by using the Fetch As Googlebot.

Step 05: Check Structured Data

The only way to conduct a structured data audit is with software tools like Google Search Console, Screaming Frog, and Site Bulb. It's possible to do it manually, but we don't recommend this unless you are a technical SEO and/or have loads of time on your hands.

Using Google Search Console will tell you which pages have errors and identify where and/or how the error is occurring. But like any audit, structure data audits are about fixing errors and discovering SEO opportunities.

When conducting a structured data audit you'll want to determine if any data is broken and if there's anything more you can do. For example, if an eCommerce store has implemented a product review markup, but some products have fewer ratings, they might decide to remove the markup and avoid reputational damage until they've improved the product.

Top FREE Tools to Check Your Technical SEO

Every technical SEO specialist worth their salt knows how to conduct an SEO audit manually. However, it's tedious and, given the tools on the market, unnecessary. Below are the tools we'd use to perform a high-quality technical SEO audit.

Google Search Console

This is hands down the best free-side audit tool. Google Search Console analyzes your website the same way that Google does with its bots. This feature alone makes it indispensable. With it, you can: monitor indexing and crawling, identify and fix errors, request indexing, update pages, and review all links.

Google Page Speed

This tool allows you to test web page speed. It is also so simple to use. All you need to do is enter the page's URL and hit “analyze.” Google Page Speed's detailed reports come with a personalized Optimization Score and a list of prioritized suggestions to improve running speed.

Google's Structured Data Markup Helper

Compatible with the majority of search engines, Google's Markup Helper helps you mark up different types of structured data on your website. This tool identifies missing fields that need to be filled in to correct the markup of your structured data. It offers a wide range of markup types and offers the possibility to generate rich snippets.

Ahrefs

The only caveat with Ahrefs is you won't have full functionality unless you pay for a subscription, and have to connect your website to it, unlike Google, where you just copy and paste URLs. Otherwise, it's useful to fix technical errors, submit sitemaps, and see structured data issues.

Ubersuggest

While Ubersuggest is mainly used for keyword research, it can perform full-scale audits to check your website for critical errors, warnings, and recommendations. What's great about Ubersuggest is that it pinpoints areas that need urgent attention and prioritizes them accordingly.

Buchen Sie eine kostenlose Beratung

Hire the Best SEO Professionals

Technical SEO and audits are mandatory for new and established websites. It's normal to encounter technical SEO issues, most of which are easy to fix. However, you still need the technical know-how. This is where working with an SEO professional can save you time and help avoid costly delays.

Is your technical SEO up to date? If not, we'll conduct a free SEO audit to identify underlying issues and offer recommendations. As a full-service digital marketing agency, we've improved our clients' traffic by 175% on average! Call us today to fix your technical SEO issues.