Top 15 ETL-Tools zum Sammeln von Marketingdaten

Veröffentlicht: 2023-03-22Moderne fortschrittliche Marketinganalysen sind ohne ETL-Tools kaum vorstellbar. Bevor ein Unternehmen mit der Erstellung von Berichten und der Suche nach Erkenntnissen beginnt, müssen schließlich alle Daten, die es aus unterschiedlichen Quellen sammelt, verarbeitet werden: bereinigt, verifiziert, in ein einziges Format gebracht und kombiniert werden. Dafür sind ETL-Tools da. In diesem Artikel stellen wir die 15 besten ETL-Services für 2023 vor, damit Sie den besten für Ihr Unternehmen auswählen können.

Inhaltsverzeichnis

- Was ist ETL?

- Arten von ETL-Tools

- Was sind die Kriterien für die Auswahl von ETL-Tools?

- Top 15 ETL-Tools zum Sammeln von Marketingdaten

- Kurzes Fazit

Was ist ETL?

ETL (Extract, Transform, Load) ist der Datenintegrationsprozess, der datengesteuerte Analysen untermauert. Es besteht aus drei Schritten:

- Daten werden aus der ursprünglichen Quelle extrahiert .

- Die Daten werden dann in ein für die Analyse geeignetes Format umgewandelt .

- Schließlich werden die Daten in einen Speicher, einen Data Lake oder ein Business Intelligence (BI)-System geladen .

ETL bildet die Grundlage für eine erfolgreiche Datenanalyse und bietet eine einzige Quelle der Wahrheit, um sicherzustellen, dass alle Unternehmensdaten konsistent und aktuell sind.

Was sind ETL-Tools?

ETL-Tools sind Dienste, die Sie bei der Ausführung von ETL-Prozessen unterstützen. Einfach ausgedrückt, ermöglichen es ETL-Tools Unternehmen, Daten verschiedener Art aus mehreren Quellen zu sammeln, sie in ein einziges Format zu konvertieren und sie in ein zentrales Repository wie Google BigQuery, Snowflake oder Azure hochzuladen.

Was sind die Vorteile von ETL-Tools?

- Sparen Sie Zeit und eliminieren Sie die manuelle Datenverarbeitung. ETL-Tools helfen Ihnen, Daten automatisch zu sammeln, umzuwandeln und zu konsolidieren.

- Erleichtern Sie die Arbeit mit einer großen Menge komplexer und vielfältiger Daten: Zeitzonen, Kundennamen, Geräte-IDs, Standorte usw.

- Reduzieren Sie das Risiko von Datenfehlern, die durch menschliche Faktoren verursacht werden.

- Entscheidungsfindung verbessern. Durch die Automatisierung der Arbeit mit kritischen Daten und die Reduzierung von Fehlern stellt ETL sicher, dass die Daten, die Sie zur Analyse erhalten, qualitativ hochwertig und vertrauenswürdig sind.

- Da Sie Zeit, Aufwand und Ressourcen sparen, hilft Ihnen der ETL-Prozess letztendlich dabei, Ihren ROI zu steigern.

Betrachten wir Arten von ETL-Tools.

Arten von ETL-Tools

Alle ETL-Tools können je nach Infrastruktur und unterstützender Organisation oder Anbieter grob in vier Typen eingeteilt werden. Einige sind so konzipiert, dass sie in der lokalen Umgebung funktionieren, andere in der Cloud und wieder andere sowohl lokal als auch in der Cloud.

1. Cloudbasierte ETL-Tools

Cloudbasierte ETL-Tools extrahieren Daten aus Quellen und laden sie direkt in den Cloud-Speicher. Sie können diese Daten dann mithilfe der Leistung und Skalierbarkeit der Cloud umwandeln. Dies ist im Wesentlichen ein moderner Ansatz für den bekannten ETL-Prozess, bei dem die Datentransformation erfolgt, nachdem die Daten in den Speicher geladen wurden.

Herkömmliche ETL-Tools extrahieren und transformieren Daten aus verschiedenen Quellen, bevor sie in das Warehouse geladen werden. Mit dem Aufkommen von Cloud-Speichern ist keine Datenbereinigung mehr auf einer Zwischenstufe zwischen dem Quell- und dem Zielspeicherort erforderlich.

Cloudbasierte ETL-Tools sind besonders relevant für Advanced Analytics. Sie können beispielsweise Rohdaten in einen Data Lake laden und diese dann mit Daten aus anderen Quellen kombinieren oder zum Trainieren von Vorhersagemodellen verwenden. Durch das Speichern von Daten im Rohformat können Analysten ihre Möglichkeiten erweitern. Dieser Ansatz ist schneller, da er die Leistung moderner Datenverarbeitungs-Engines nutzt und unnötige Datenbewegungen reduziert.

2. Unternehmens-ETL-Tools

Dies sind ETL-Tools, die von kommerziellen Organisationen entwickelt wurden und oft Teil größerer Analyseplattformen sind. Zu den Vorteilen von Enterprise-ETL-Tools gehören Zuverlässigkeit und Reife, da sie schon lange auf dem Markt sind. Sie können auch erweiterte Funktionen bieten: eine grafische Benutzeroberfläche (GUI) zum Entwerfen von ETL-Flows, Unterstützung für die meisten relationalen und nicht relationalen Datenbanken, ein hohes Maß an Kundenunterstützung und umfangreiche Dokumentation.

In Bezug auf die Minuspunkte sind ETL-Tools für Unternehmen in der Regel teurer als Alternativen, erfordern zusätzliche Schulungen für Mitarbeiter und sind schwierig zu integrieren.

3. Open-Source-ETL-Tools

Dies sind kostenlose ETL-Tools, die eine GUI zum Erstellen und Verwalten von Datenflüssen bieten. Dank der Open-Source-Natur dieser Dienste können Benutzer verstehen, wie sie funktionieren, und ihre Funktionalität erweitern.

Open-Source-ETL-Tools sind eine kostengünstige Alternative zu kostenpflichtigen Diensten. Einige unterstützen keine komplexen Transformationen und bieten möglicherweise keinen Kundensupport an.

4. Benutzerdefinierte ETL-Tools

Das sind ETL-Tools, die Unternehmen mit SQL, Python oder Java selbst erstellen. Einerseits weisen solche Lösungen eine große Flexibilität auf und können an Geschäftsanforderungen angepasst werden. Andererseits benötigen sie viele Ressourcen für ihre Tests, Wartung und Aktualisierung.

Was sind die Kriterien für die Auswahl von ETL-Tools?

Bei der Auswahl eines ETL-Tools sollten Sie Ihre geschäftlichen Anforderungen, die Menge der zu sammelnden Daten, die Quellen dieser Daten und die Art der Verwendung berücksichtigen.

Worauf Sie bei der Auswahl eines ETL-Tools achten sollten:

- Benutzerfreundlichkeit und Wartung.

- Geschwindigkeit des Werkzeugs.

- Datensicherheit und Qualität. ETL-Tools, die Datenqualitätsprüfungen anbieten, helfen dabei, Inkonsistenzen und Duplikate zu identifizieren und Datenfehler zu reduzieren. Überwachungsfunktionen können Sie warnen, wenn Sie es mit inkompatiblen Datentypen und anderen Problemen zu tun haben.

- Fähigkeit, Daten aus vielen verschiedenen Quellen zu verarbeiten. Ein Unternehmen kann mit Hunderten von Quellen mit unterschiedlichen Datenformaten arbeiten. Es kann strukturierte und halbstrukturierte Daten, Echtzeit-Streaming-Daten, Flatfiles, CSV-Dateien usw. geben. Einige dieser Daten werden am besten in Stapeln konvertiert, während andere Daten am besten durch kontinuierliche Streaming-Datenkonvertierung verarbeitet werden.

- Die Anzahl und Vielfalt der verfügbaren Anschlüsse.

- Skalierbarkeit. Die Menge der gesammelten Daten wird im Laufe der Jahre nur noch wachsen. Ja, Sie könnten jetzt mit einer lokalen Datenbank und Batch-Upload zufrieden sein, aber wird das immer genug für Ihr Unternehmen sein? Es ist ideal, um ETL-Prozesse und -Kapazitäten unbegrenzt skalieren zu können! Wenn es darum geht, datengesteuerte Entscheidungen zu treffen, denken Sie groß und schnell und nutzen Sie Cloud-Speicherdienste (wie Google BigQuery), mit denen Sie große Datenmengen schnell und kostengünstig verarbeiten können.

- Fähigkeit zur Integration mit anderen Komponenten Ihrer Datenplattform, einschließlich Warehouses und Data Lakes.

Nachdem wir nun die Arten und Funktionen von ETL-Tools behandelt haben, werfen wir einen Blick auf die beliebtesten dieser Tools.

Top 15 ETL-Tools zum Sammeln von Marketingdaten

Es gibt viele ETL-Tools auf dem Markt, die Ihnen helfen, Ihr Datenmanagement zu vereinfachen und gleichzeitig Zeit und Geld zu sparen. Werfen wir einen Blick auf einige davon, beginnend mit ETL-Tools, die in der Cloud funktionieren.

1. OWOXBI

OWOX BI ist eine digitale ETL/ELT-Analyseplattform ohne Code, die die Datenverwaltung und -berichterstattung vereinfacht. Mit der OWOX BI-Plattform können Sie Marketingdaten für beliebig komplexe Berichte im sicheren Cloud-Speicher von Google BigQuery sammeln.

Hauptmerkmale von OWOX BI:

- Automatische Datenerfassung aus verschiedenen Quellen.

- Automatischer Import von Rohdaten in Google BigQuery.

- Bereinigung, Deduplizierung, Qualitätsüberwachung und Datenaktualisierung.

- Datenmodellierung und Aufbereitung betriebsbereiter Daten.

- Möglichkeit, Berichte ohne die Hilfe von Analysten oder SQL-Kenntnissen zu erstellen.

OWOX BI sammelt automatisch Rohdaten aus verschiedenen Quellen und konvertiert sie in ein Format, das zum Erstellen von Berichten geeignet ist. Sie erhalten vorgefertigte Datensätze, die automatisch in die notwendige Struktur transformiert werden, unter Berücksichtigung der für Vermarkter wichtigen Nuancen. Sie müssen keine Zeit damit verbringen, komplexe Transformationen zu entwickeln und zu warten, sich mit der Datenstruktur zu befassen und Gründe für Abweichungen zu identifizieren.

OWOX BI setzt Ihre kostbare Zeit frei, damit Sie sich mehr auf die Optimierung von Werbekampagnen und Wachstumsbereichen konzentrieren können.

Wenn Sie sich auf OWOX BI verlassen, müssen Sie nicht mehr auf Berichte eines Analysten warten. Basierend auf simulierten Daten können Sie fertige Dashboards oder benutzerdefinierte Berichte erhalten, die für Ihr Unternehmen geeignet sind.

Aufgrund des einzigartigen Ansatzes von OWOX BI können Sie Datenquellen und Datenstrukturen ändern, ohne SQL-Abfragen neu zu schreiben oder die Reihenfolge der Berichte zu ändern. Dies ist besonders relevant mit der Veröffentlichung von Google Analytics 4.

Melden Sie sich für eine Demo an, um mehr über die Möglichkeiten von OWOX BI für Ihr Unternehmen zu erfahren.

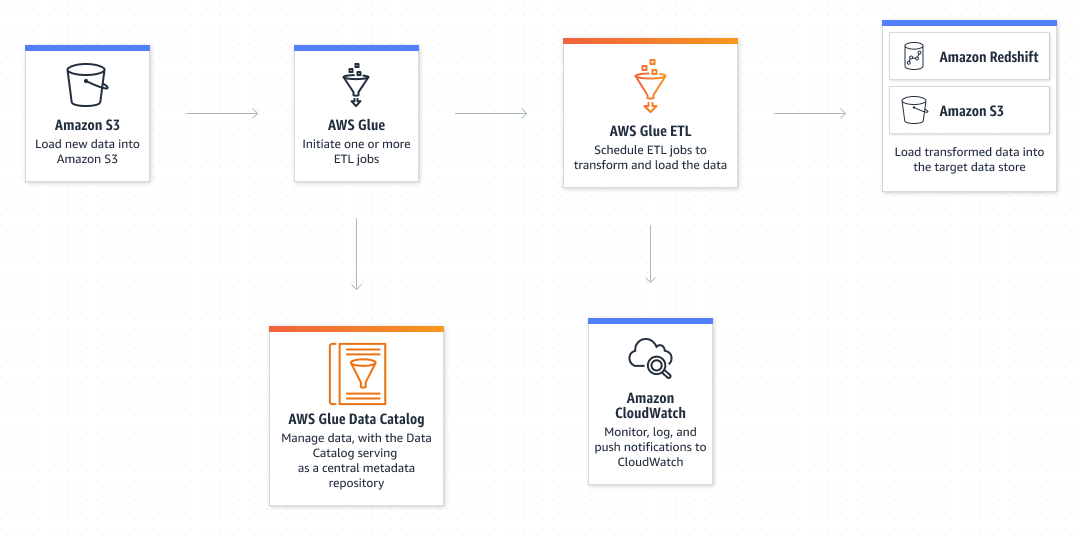

2. AWS-Kleber

AWS Glue ist der serverlose ETL-Service von Amazon, der es einfach macht, Daten aus mehreren Quellen für Analysen, maschinelles Lernen und Anwendungsentwicklung zu entdecken, vorzubereiten, zu verschieben und zu integrieren.

Hauptmerkmale von AWS Glue:

- Integration mit mehr als 70 verschiedenen Datenquellen.

- Fähigkeit, sowohl eine GUI als auch Code (Python/Scala) zu verwenden, um Datenflüsse zu erstellen und zu verwalten.

- Möglichkeit, sowohl im ETL- als auch im ELT-Modus zu arbeiten – AWS Glue konzentriert sich hauptsächlich auf die Stapelverarbeitung, unterstützt aber auch das Streaming von Daten.

- Unterstützung für benutzerdefinierte SQL-Abfragen für einfachere Dateninteraktionen.

- Möglichkeit, Prozesse nach einem Zeitplan auszuführen – Beispielsweise können Sie AWS Glue so konfigurieren, dass Ihre ETL-Aufgaben ausgeführt werden, wenn neue Daten im Amazon S3-Speicher verfügbar werden.

- Mit Data Catalog können Sie schnell verschiedene Datensätze auf AWS finden, ohne sie verschieben zu müssen – Nach der Katalogisierung stehen die Daten sofort für die Suche und Abfrage mit Amazon Athena, Amazon EMR und Amazon Redshift Spectrum zur Verfügung.

- Funktionalität zur Überwachung der Datenqualität.

3. Azure Data Factory

Azure Data Factory ist der cloudbasierte ETL-Dienst von Microsoft für skalierbare serverlose Datenintegration und -transformation. Es bietet eine No-Code-Benutzeroberfläche zum intuitiven Erstellen, Überwachen und Verwalten von Datenflüssen.

Hauptmerkmale von AWS Glue:

- Integration mit mehr als 70 verschiedenen Datenquellen.

- Fähigkeit, sowohl eine GUI als auch Code (Python/Scala) zu verwenden, um Datenflüsse zu erstellen und zu verwalten.

- Möglichkeit, sowohl im ETL- als auch im ELT-Modus zu arbeiten – AWS Glue konzentriert sich hauptsächlich auf die Stapelverarbeitung, unterstützt aber auch das Streaming von Daten.

- Unterstützung für benutzerdefinierte SQL-Abfragen für einfachere Dateninteraktionen.

- Möglichkeit, Prozesse nach einem Zeitplan auszuführen – Beispielsweise können Sie AWS Glue so konfigurieren, dass Ihre ETL-Aufgaben ausgeführt werden, wenn neue Daten im Amazon S3-Speicher verfügbar werden.

- Mit Data Catalog können Sie schnell verschiedene Datensätze auf AWS finden, ohne sie verschieben zu müssen – Nach der Katalogisierung stehen die Daten sofort für die Suche und Abfrage mit Amazon Athena, Amazon EMR und Amazon Redshift Spectrum zur Verfügung.

- Funktionalität zur Überwachung der Datenqualität.

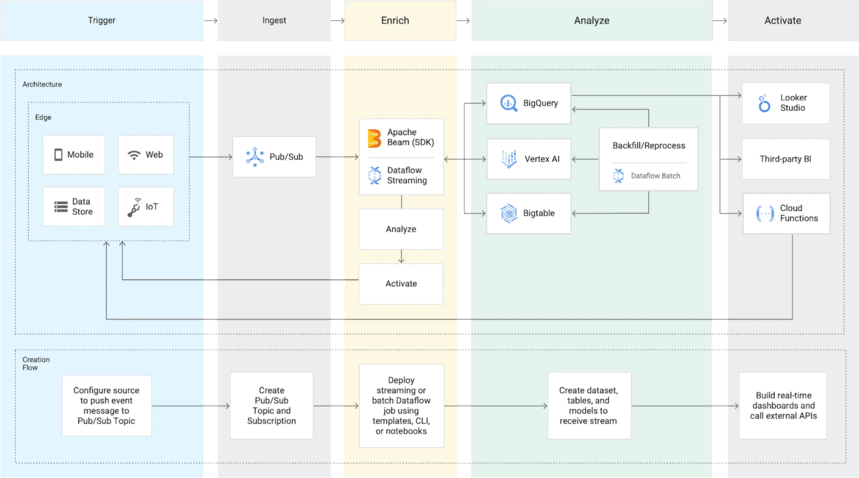

4. Google Cloud-Datenfluss

Dataflow ist ein Cloud-basierter ETL-Dienst von Google, mit dem Sie sowohl Streaming- als auch Batch-Daten verarbeiten können und keinen eigenen Server benötigen.

Hauptmerkmale von Google Cloud Dataflow:

- Unterstützt viele Datenquellen (außer SaaS) – Cloud Dataflow bietet sowohl Batch- als auch Streaming-Datenaufnahme. Für die Stapelverarbeitung kann es sowohl auf GCP-gehostete als auch auf lokale Datenbanken zugreifen. PubSub wird zum Streamen verwendet. Der Dienst überträgt Daten an Google Cloud Storage oder BigQuery.

- Führt Apache Beam-Pipelines auf der Google Cloud Platform aus – Apache bietet Java-, Python- und Go-SDKs zum Präsentieren und Übertragen von Datensätzen, sowohl Batch als auch Streaming. Auf diese Weise können Benutzer das richtige SDK für ihre Datenpipeline auswählen.

- Flexible Preisgestaltung – Sie zahlen nur für die Ressourcen, die Sie verbrauchen, und die Ressourcen werden automatisch basierend auf Ihren Anforderungen und Ihrer Arbeitslast skaliert.

- Mit Dataflow SQL können Sie Ihre SQL-Kenntnisse nutzen, um Dataflow-Streaming-Pipelines direkt über die BigQuery-Weboberfläche zu entwickeln.

- Die integrierte Überwachung ermöglicht es Ihnen, Fehler in Batch- und Streaming-Pipelines zeitnah zu beheben. Sie können auch Warnungen für veraltete Daten und Systemverzögerungen festlegen.

- Kundensupport auf hohem Niveau – Google bietet mehrere Supportpläne für die Google Cloud Platform (zu der Cloud Dataflow gehört) sowie eine umfassende Dokumentation.

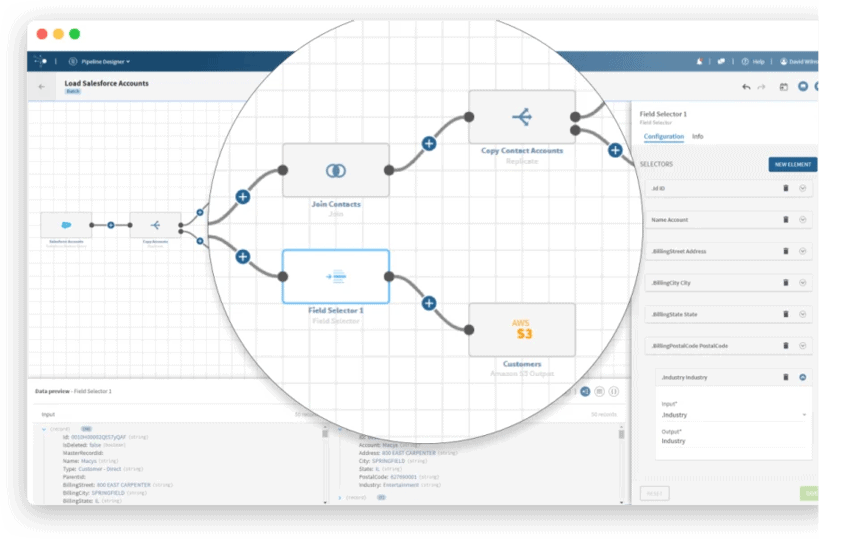

5. Integrieren.io

Integrate.io ist eine ETL-Datenintegrationsplattform, die speziell für E-Commerce-Projekte entwickelt wurde. Es ermöglicht Ihnen, Daten aus Hunderten von Quellen mit verschiedenen Methoden (Integrate.io ETL, ELT, Reverse ETL, API Management) zu verarbeiten. Es bietet eine intuitive, programmierfreie Benutzeroberfläche, um technisch nicht versierten Personen die Arbeit mit Datenströmen zu erleichtern.

Hauptmerkmale von Integrate.io:

- Integrierte Konnektoren für über 150 Datenquellen und -ziele, einschließlich Data Warehouses, Datenbanken und SaaS-Cloud-Plattformen.

- Automatische Transformation – Es gibt über 220 Konvertierungsoptionen mit minimalem Code, um alle Datenanforderungen zu erfüllen.

- Überwachung und Warnungen – Richten Sie automatische Warnungen ein, um sicherzustellen, dass Ihre Pipelines planmäßig ausgeführt werden.

- Möglichkeit, Daten von jeder Quelle zu empfangen, die über eine Rest-API verfügt – Wenn keine Rest-API vorhanden ist, können Sie mit dem Integrate.io-API-Generator Ihre eigene erstellen.

- Unterstützung und Beratung per Telefon oder Videoanruf.

Betrachten wir als Nächstes Unternehmens-ETL-Tools.

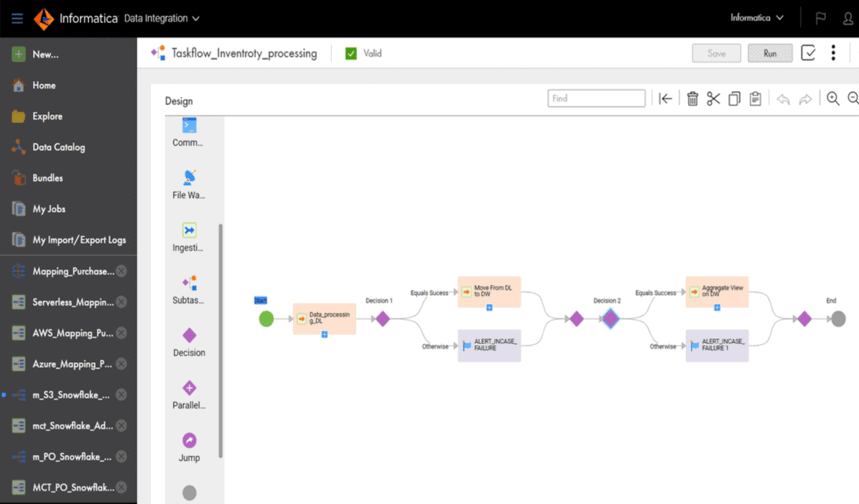

6. Informatica PowerCenter

PowerCenter ist eine von Informatica entwickelte leistungsstarke Datenintegrationsplattform für Unternehmen. Das Unternehmen verfügt auch über eine Cloud-native ETL- und ELT-Lösung namens Cloud Data Integration.

Hauptmerkmale von PowerCenter:

- Riesige Anzahl von Konnektoren, einschließlich für Cloud-Datenspeicher wie AWS, Azure, Google Cloud und Salesforce.

- Unterstützt sowohl Batch- als auch Streaming-Datenverarbeitung.

- Eine grafische Benutzeroberfläche und vorgefertigte Transformationen machen PowerCenter für technisch nicht versierte Fachleute, wie z. B. Marketingspezialisten, nützlich.

- Automatisiertes Testen und Datenvalidierung – PowerCenter warnt vor Fehlern und Ausfällen beim Betrieb von Datenpipelines.

- Es sind zusätzliche Dienste verfügbar, mit denen Sie Datenpipelines entwerfen, bereitstellen und überwachen können. Beispielsweise hilft der Repository-Manager bei der Verwaltung von Benutzern, Designer lässt Benutzer den Datenfluss von der Quelle zum Ziel angeben und der Workflow-Manager definiert die Tasksequenz.

7. Oracle-Datenintegrator

Oracle Data Integrator ist eine ETL-Plattform für Unternehmen zum Erstellen, Bereitstellen und Verwalten komplexer Data Warehouses. Das Tool lädt und transformiert Daten in ein Data Warehouse, indem es die Funktionen der Zieldatenbank nutzt, anstatt sich auf einen regulären ETL-Server zu verlassen. Vorgefertigte Konnektoren vereinfachen die Integration, indem sie die manuellen Integrationsaufgaben automatisieren, die zum Verbinden von Datenbanken und Big Data erforderlich sind.

Hauptmerkmale von Oracle Data Integrator:

- Kompatibel mit Datenbanken wie Sybase, IBM DB2, Teradata, Netezza und Exadata.

- Unterstützt die Arbeit im ETL- und ELT-Modus.

- Findet automatisch Fehler in Daten und verarbeitet sie, bevor sie an den Zielspeicherort verschoben werden.

- Integrierte Big-Data-Unterstützung – Sie können Apache Spark-Code in Übereinstimmung mit Big-Data-Standards verwenden, um Daten zu transformieren und zuzuordnen.

8. SAP-Datendienste

SAP Data Services ist eine Unternehmensdatenverwaltungssoftware. Mit dem Tool können Sie Daten aus beliebigen Quellen extrahieren sowie diese Daten in beliebige Zieldatenbanken transformieren, integrieren und formatieren. Sie können damit Data Marts oder Data Warehouses jeglicher Art erstellen.

Hauptmerkmale von SAP Data Services:

- Die grafische Benutzeroberfläche vereinfacht die Erstellung und Transformation von Datenströmen erheblich.

- Kann sowohl im Batch-Modus als auch in Echtzeit arbeiten.

- Unterstützt Integrationen mit Windows, Sun Solaris, AIX und Linux.

- Ideal für die Skalierung, unabhängig von der Anzahl der Clients.

- Die flache Lernkurve und die Drag-and-Drop-Oberfläche ermöglichen es Datenanalysten oder Dateningenieuren, dieses Tool ohne spezielle Programmierkenntnisse zu verwenden.

- Einfach zu planende und zu steuernde ETL-Prozesse.

- Das Vorhandensein von Variablen hilft, sich wiederholende Aufgaben zu vermeiden – Variablen ermöglichen es Benutzern, verschiedene Aktionen auszuführen, z. B. zu entscheiden, welche Schritte in einer Aufgabe ausgeführt werden sollen oder in welcher Umgebung die Aufgabe ausgeführt werden soll, und Prozessschritte einfach zu ändern, ohne die gesamte Aufgabe neu erstellen zu müssen.

- Integrierte Funktionen (wenn/dann oder Deduplizierungslogik) helfen, Daten zu normalisieren und ihre Qualität zu verbessern.

- Ideal für Unternehmen, die SAP als ERP-System verwenden.

9. IBM DataStage

IBM DataStage ist ein Datenintegrationstool, das Sie beim Entwerfen, Entwickeln und Ausführen von Datenverschiebungs- und Transformationsaufgaben unterstützt. DataStage unterstützt sowohl ETL- als auch ELT-Prozesse. Die Basisversion ist für die lokale Bereitstellung vorgesehen. Es ist jedoch auch eine Cloud-Version des Service namens IBM Cloud Pak for Data verfügbar.

Hauptmerkmale von IBM DataStage:

- Große Anzahl integrierter Konnektoren für die Integration mit Datenquellen und Datenspeichern (einschließlich Oracle, Hadoop System und allen in IBM InfoSphere Information Server enthaltenen Services).

- Erledigen Sie jede ETL-Aufgabe 30 % schneller dank einer parallelen Engine und Workload-Balancing.

- Eine benutzerfreundliche Oberfläche und ein durch maschinelles Lernen unterstütztes Design helfen, die Entwicklungskosten zu senken.

- Mit der Datenherkunft können Sie sehen, wie Daten transformiert und integriert werden.

- Mit IBM InfoSphere QualityStage können Sie die Datenqualität überwachen.

- Besonders relevant für Unternehmen, die mit großen Datensätzen arbeiten, und für große Unternehmen.

10. Microsoft SQL Server-Integrationsdienste (SSIS)

SQL Server Integration Services ist eine Enterprise-ETL-Plattform für die Datenintegration und -transformation. Es ermöglicht Ihnen, Daten aus Quellen wie XML-Dateien, Flatfiles und relationalen Datenbanken zu extrahieren und zu transformieren und sie dann in ein Data Warehouse zu laden. Da es sich um ein Microsoft-Produkt handelt, unterstützt SSIS nur Microsoft SQL Server.

Hauptmerkmale von SSIS:

- Kann SSIS-GUI-Tools verwenden, um Pipelines zu erstellen, ohne eine einzige Codezeile zu schreiben.

- Bietet eine breite Palette integrierter Tasks und Transformationen, die die für die Entwicklung erforderliche Codemenge minimieren.

- Kann mit Plugins in Salesforce und CRM integriert werden; kann auch in Änderungskontrollsoftware wie TFS und GitHub integriert werden.

- Debugging-Funktionen und einfache Fehlerbehandlung in Datenströmen.

Betrachten wir nun Open-Source-ETL-Tools.

11. Offenes Talend-Studio (Nutzungsbedingungen)

Talend Open Studio ist eine kostenlose Open-Source-Integrationssoftware, die dabei hilft, komplexe Daten in verständliche Informationen für Entscheidungsträger umzuwandeln. Dieses einfache und intuitive Tool ist in den USA weit verbreitet. Es kann leicht mit Produkten anderer großer Anbieter konkurrieren.

Mit TOS können Sie im Handumdrehen mit dem Aufbau grundlegender Datenpipelines beginnen. Sie können einfache ETL- und Datenintegrationsaufgaben ausführen, grafische Profile Ihrer Daten abrufen und Dateien aus einer lokal installierten Open-Source-Umgebung verwalten.

Hauptmerkmale von Talend Open Studio:

- Über 900 Konnektoren zum Verbinden verschiedener Datenquellen – Datenquellen können über die Open Studio-GUI per Drag-and-Drop aus Excel, Dropbox, Oracle, Salesforce, Microsoft Dynamics und anderen Datenquellen verbunden werden.

- Funktioniert hervorragend mit Cloud-Speichergiganten wie Amazon AWS, Google Cloud und Microsoft Azure.

- Die Java-Technologie ermöglicht es Benutzern, mehrere Skripte aus Bibliotheken auf der ganzen Welt zu integrieren.

- Die Talend Community ist ein Ort, an dem Sie Best Practices austauschen und neue Tricks finden können, die Sie noch nicht ausprobiert haben.

12. Pentaho-Datenintegration (PDI)

Pentaho Data Integration (früher bekannt als Kettle) ist ein Open-Source-ETL-Tool im Besitz von Hitachi. Der Dienst verfügt über mehrere grafische Benutzeroberflächen zum Erstellen von Datenpipelines. Benutzer können Aufgaben und Datentransformationen mit dem Spoon PDI-Client entwerfen und sie dann mit Kitchen ausführen.

Hauptmerkmale der Pentaho-Datenintegration:

- Verfügbar in zwei Versionen: Community und Enterprise (mit erweiterter Funktionalität).

- Kann in der Cloud oder lokal bereitgestellt werden, ist jedoch auf lokale Batch-Szenarien für ETL spezialisiert.

- Komfortable grafische Benutzeroberfläche mit Drag-and-Drop-Funktionalität.

- Die gemeinsam genutzte Bibliothek vereinfacht die ETL-Ausführung und den Entwicklungsprozess.

- Arbeitet auf Basis von im XML-Format hinterlegten ETL-Verfahren.

- Unterscheidet sich von Wettbewerbern dadurch, dass keine Codegenerierung erforderlich ist.

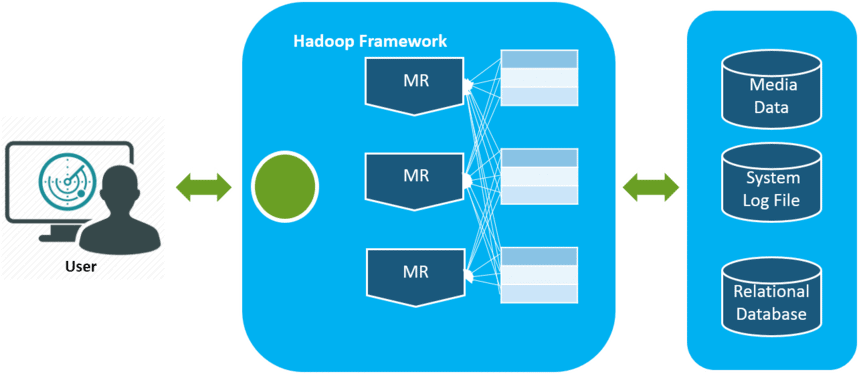

13. Apache Hadoop

Apache Hadoop ist eine Open-Source-Plattform zur Verarbeitung und Speicherung großer Datenmengen durch Verteilung der Rechenlast auf Rechencluster. Der Hauptvorteil von Hadoop ist die Skalierbarkeit. Es geht nahtlos von der Ausführung auf einem einzelnen Knoten zu Tausenden von Knoten über. Darüber hinaus kann der Code gemäß den Geschäftsanforderungen geändert werden.

Hauptmerkmale von Hadoop:

- Open-Source basierend auf Java-Anwendungen und daher kompatibel mit allen Plattformen.

- Fehlertolerant – Wenn ein Knoten ausfällt, können Daten auf diesem Knoten einfach von anderen Knoten wiederhergestellt werden.

- Mehrere Kopien von Daten bedeuten, dass sie auch im Falle eines Hardwareausfalls verfügbar sind.

- Es ist kein Distributed-Computing-Client erforderlich, da sich das Framework um alles kümmert.

14. Skyvia-Datenintegration

Skyvia ist die All-in-One-Cloud-Datenplattform von Devart für Integration, Verwaltung, Sicherung und Datenzugriff.

Skyvia Data Integration ist ein No-Code-ETL- und ELT-Tool für verschiedene Datenintegrationsszenarien. Es funktioniert mit CSV-Dateien, Datenbanken (SQL Server, Oracle, PostgreSQL, MySQL), Cloud-Speicher (Amazon Redshift, Google BigQuery, Snowflake) und Anwendungen (Salesforce, HubSpot, Dynamics CRM und vielen mehr).

Hauptmerkmale der Skyvia-Datenintegration:

- Die Arbeit mit der Cloud erspart Ihnen manuelle Updates oder Bereitstellungen.

- Ermöglicht es Ihnen, Daten in Cloud-Anwendungen und -Datenbanken zu importieren, Cloud-Daten zu replizieren und sie zur gemeinsamen Nutzung in eine CSV-Datei zu exportieren.

- Erstellt eine vollständig anpassbare Datensynchronisierung – Sie entscheiden genau, was Sie extrahieren möchten, einschließlich benutzerdefinierter Felder und Objekte.

- Das Erstellen von Integrationen erfordert keine speziellen technischen Kenntnisse.

- Möglichkeit, Integrationen automatisch nach einem Zeitplan auszuführen

- Dublettenfreier Datenimport mit bidirektionaler Synchronisation.

- Vorgefertigte Vorlagen für gängige Datenintegrationsszenarien.

15. Jaspersoft

Jaspersoft ETL ist die daten- und architekturunabhängige Open-Source-Software von Jaspersoft. Das bedeutet, dass Sie sich mit Daten aus jeder Quelle verbinden und überall damit arbeiten können: vor Ort, in der Cloud oder in einer Hybridumgebung. Darüber hinaus können Sie den Jaspersoft-Quellcode nach Ihren Bedürfnissen ändern.

Das Jaspersoft-Tool ist Teil der Jaspersoft Business Intelligence Suite, die eine anpassbare, flexible und entwicklerfreundliche Business Intelligence-Plattform bietet.

Hauptmerkmale von Jaspersoft:

- Integration mit Standard-Datenverwaltungssystemen (Hadoop, Google Analytics und Cassandra), Anwendungen (SugarCRM, SAP, Salesforce) und Big-Data-Umgebungen (Hadoop, MongoDB).

- Kann sowohl lokal als auch in der Cloud bereitgestellt werden.

- Die grafische Benutzeroberfläche ermöglicht dem Benutzer das einfache Entwerfen, Planen und Ausführen von Datenbewegungen und -transformationen.

- Das Aktivitäts-Dashboard hilft bei der Überwachung der Ausführung von ETL-Aufgaben und der Leistung des Tools.

- Mobile App, mit der Sie Ihre Daten jederzeit und überall abrufen können.

Kurzes Fazit

Die von Unternehmen gesammelten Datenmengen werden täglich größer und werden weiter wachsen. Im Moment reicht es aus, mit lokalen Datenbanken und Batch-Loading zu arbeiten, aber sehr bald wird dies die geschäftlichen Anforderungen nicht mehr erfüllen. Daher ist die Möglichkeit, ETL-Prozesse zu skalieren, praktisch und besonders relevant für Advanced Analytics.

Denken Sie bei der Auswahl eines ETL-Tools an die spezifischen Anforderungen Ihres Unternehmens. Wenn Sie lokal arbeiten und Ihre Daten vorhersehbar sind und nur aus wenigen Quellen stammen, reicht ein traditionelles ETL-Tool aus. Vergessen Sie jedoch nicht, dass immer mehr Unternehmen auf eine Cloud- oder Hybridarchitektur umsteigen.

Unsere Kunden

wachsen 22 % schneller

Wachsen Sie schneller, indem Sie messen, was in Ihrem Marketing am besten funktioniert

Analysieren Sie Ihre Marketingeffizienz, finden Sie die Wachstumsbereiche, steigern Sie den ROI

Demo erhalten