So stellen Sie die Cloud-Skalierbarkeit im Jahr 2023 sicher

Veröffentlicht: 2023-01-11Inhalt

- Was ist Skalierbarkeit?

- Warum müssen wir der Skalierbarkeit besondere Aufmerksamkeit schenken?

- Arten der Skalierung

- Vertikale Skalierbarkeit – Skalierung nach oben

- Horizontale Skalierung - Aufskalieren

- Diagonale Skalierung

- So stellen Sie maximale Skalierbarkeit sicher

- Load-Balancing durchführen

- Wenden Sie sich der automatischen Skalierbarkeit von Webdiensten zu

- Microservices-Container, Clusterisierung

- Caching implementieren

- Setzen Sie CDN-Dienste ein

- Wie gehen wir mit Skalierungsproblemen um?

- Fazit

Da die gemeinsamen Belastungsvolumina von Computersystemen zunehmend wachsen, passen sie sich an und werden in Bezug auf die grundlegende Architektur komplexer. Neue Softwaretools und Integrationen zur Leistungsoptimierung kommen hinzu, Serverkapazitäten werden erweitert etc.

Alle diese Systemoptimierungsprozesse werden durch einen einzigen Begriff definiert – Skalierung – eine der Schlüsselspezialisierungen von DevOps-Experten. Was ist Skalierbarkeit und, was noch wichtiger ist, wie können Sie sie für Ihr spezielles Unternehmen sicherstellen, bei dem die meisten Betriebskapazitäten in der Cloud konzentriert sind? Lassen Sie uns in das Thema eintauchen.

Bildquelle: Static.bluepiit

Bildquelle: Static.bluepiit

Was ist Skalierbarkeit?

Was ist die ultimative Definition von Skalierbarkeit? Es ist im Grunde eine Fähigkeit, die Systemleistung auf möglichst rationale Weise zu steigern. In der Praxis wird dies normalerweise durch Addieren von Rechenressourcen erreicht, sowohl Hardware- als auch Software-Ressourcen. Das Umschreiben von bestehendem Code ist jedoch in den meisten Fällen eine ziemlich drastische Lösung, sodass Unternehmen in 9 von 10 Fällen damit aufhören, die Anzahl der Server zu vervielfachen oder die Fähigkeiten des bestehenden Serversystems zu steigern.

Beachten Sie, dass die Notwendigkeit der Skalierung nicht nur dann auftritt, wenn die Gesamtsystemleistung verzögert und unzureichend wird. Die bestehende und funktionierende Architektur kann gut funktionieren und dennoch können Verzögerungen Prozesse aufgrund des schnell wachsenden Benutzerverkehrs behindern.

Wenn Sie überprüfen möchten, wie effizient Ihre Netzwerkprotokolle und verfügbaren Webserver-Ressourcen funktionieren, können Sie jedes verfügbare Lasttester-Dienstprogramm (wie zum Beispiel Siege) verwenden, das einen künstlichen Benutzerzustrom auf Ihren Server mit Tonnen von Anfragen emuliert. Sie müssen nur zwei Schlüsselparameter verfolgen: n - definiert die Gesamtzahl der Anfragen und c - gibt die Anzahl der gleichzeitigen Anfragen an.

Als Ergebnis erhalten Sie einen RPS-Wert (Requests per Second), der anzeigt, wie viele Anfragen Ihr Serversystem im Moment verarbeiten kann. Dies spiegelt die maximale Anzahl von Benutzern wider, die Ihr System wahrscheinlich zum Absturz bringen werden, wenn sie gleichzeitig versuchen, mit Ihrem Server zu interagieren. Diese Testroutine zeigt Ihnen letztendlich, was Sie erwartet und wie wichtig es ist, eine Architektur zu etablieren, die für Skalierbarkeit anfällig ist.

Auf der anderen Seite, aber denken Sie einmal darüber nach. Vielleicht ist es günstiger, einige Serverkonfigurationen anzupassen und die Einlösungsverfahren in Ihrem speziellen Fall zu optimieren. Auf diese Weise können Sie die Skalierung getrost auf bessere Zeiten verschieben.

Warum müssen wir der Skalierbarkeit besondere Aufmerksamkeit schenken?

Sobald sich ein Unternehmen zu entwickeln beginnt, muss es so flexibel und einfallsreich wie möglich sein. Startups müssen in der Lage sein, sich schnell an sich ändernde Trends und Marktbedingungen anzupassen, um beliebt und wettbewerbsfähig zu sein. Wenn Ihre App skalierbar ist, beschleunigt sie Ihr Wachstum, verbessert die Benutzererfahrung und erreicht ein größeres Publikum. Im Kern ermöglicht Ihnen die Skalierbarkeit, Ihre Anwendung besser zu verwalten und an neue Anforderungen anzupassen. Beim Aufbau einer Wachstumsstrategie für Ihr Unternehmen sollte der Aufbau einer skalierbaren Anwendung eine der ersten Prioritäten sein.

Arten der Skalierung

Zu den wichtigsten und häufigsten Arten von Skalierungsverfahren gehören:

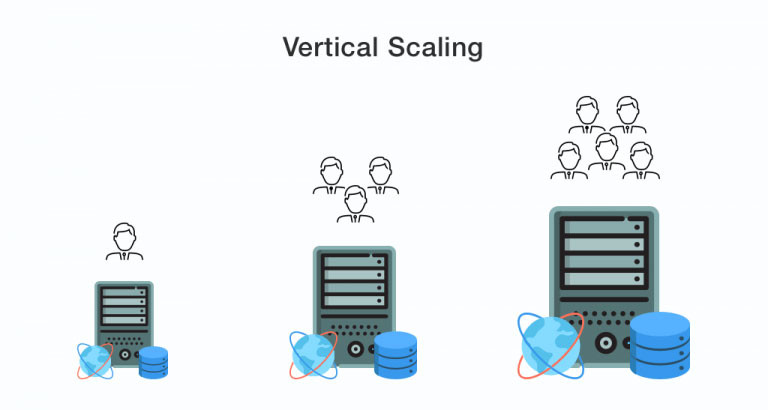

Vertikale Skalierbarkeit – Skalierung nach oben

Bildquelle: Dzone

Bildquelle: Dzone

Vertikale Skalierung bedeutet, dass die Gesamtleistung des Unternehmens gesteigert wird, indem die Leistung interner Serverressourcen – CPUs, Arbeitsspeicher, Laufwerke und Netzwerkkapazitäten – gesteigert wird. Der Server in seiner Grundform bleibt unverändert.

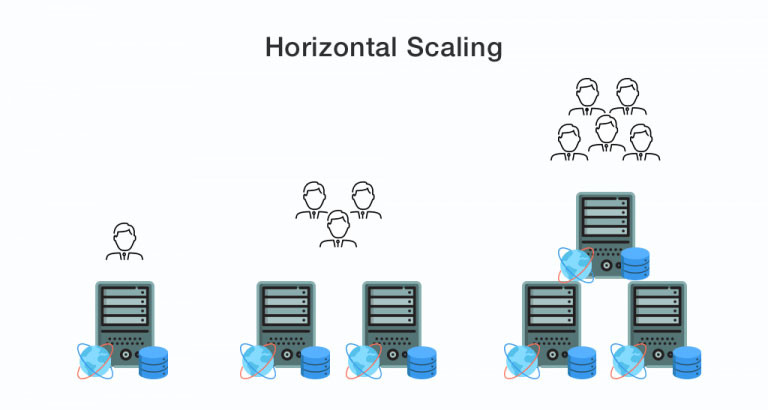

Horizontale Skalierung - Aufskalieren

Bildquelle: Dzone

Bildquelle: Dzone

Auf diesem Gebiet findet ein echter Stand statt – Scale-up vs. Scale-out. Was ist besser?

Insbesondere bei immer größer werdender digitaler Last und Traffic stößt die vertikale Skalierung früher oder später an Grenzen in Form von technischen Spezifikationen von Servern. Hier kommt die horizontale Skalierung ins Spiel. Die grundlegende Bedeutung des Begriffs definiert, dass die Rechenleistung erhöht wird, indem identische Knoten zu den vorhandenen hinzugefügt werden. Die horizontale Skalierung wird am häufigsten bei einer angepassten Serverinfrastruktur (Sonderfall - Rechenzentren) sowie dem festgelegten Interaktionsschema zwischen den Servern festgelegt.

Diagonale Skalierung

Dies ist ein relativ neuer Begriff, den John Allspaw erfunden hat – ein Autor und Mitbegründer von Adaptive Capacity Labs. Die diagonale Skalierung kombiniert also das Beste aus zwei Welten und definiert die vertikale Skalierung der bereits in der bestehenden Serverinfrastruktur implementierten horizontal skalierten Knoten.

So stellen Sie maximale Skalierbarkeit sicher

Nun zu einigen praktischen Tipps, die Ihnen helfen, ein Verfahren zur Cloud-Computing-Skalierbarkeit am besten und mit minimalen Kosten durchzuführen.

Load-Balancing durchführen

Der Lastausgleich impliziert eine Reihe von Anstrengungen zur Verteilung von Computernetzwerkprozessen auf mehrere Hardware-Software-Ressourcen (Laufwerke, CPUs oder separate Server), die in einem Socket oder Cluster konzentriert sind. Das Hauptziel dabei ist, die Ausgaben für Rechenkapazitäten zu optimieren, die Netzwerkleistung zu steigern, den Zeitaufwand bei der Verarbeitung von Netzwerkanfragen zu reduzieren sowie die Wahrscheinlichkeit zu verringern, dass ein bestimmter Server in einem wunderbaren Moment auf DDoS antwortet.

Darüber hinaus verbessert die Verteilung der Last zwischen mehreren Knoten (anstatt einen einzelnen Knoten vollständig auszunutzen) die Zugänglichkeit der von Ihrem Unternehmen bereitgestellten Dienste. Insbesondere bei teils überhöhten Serverzahlen im Ärmel hat man selbst bei Ausfall einer funktionierenden Einheit einen automatischen Ersatz parat.

Das Verfahren des Ausgleichs wird mit Hilfe einer ganzen Reihe von Algorithmen und Methoden implementiert, die jeweils den folgenden OSI-Modellschichten entsprechen: Netzwerk, Transport und Anwendung. In der praktischen Umsetzung erfordern diese den Einsatz mehrerer physischer Server zusammen mit spezialisierter Software ähnlich dem Nginx-Webserver.

Wenden Sie sich der automatischen Skalierbarkeit von Webdiensten zu

Auto-Scaling ist ein spezieller Ansatz zur dynamischen Skalierung im Kontext von Cloud-Diensten (dh der Skalierung, die eine Anpassung der Rechenleistung an das Netzwerklastvolumen impliziert). Insbesondere Nutzer von Diensten, die Auto-Scaling-Verfahren beinhalten (die bekanntesten sind Amazon Web Service, Google Cloud Platform und Microsoft Azure), werden bei Bedarf zusätzliche virtuelle Maschinen zur Verfügung gestellt (die automatisch aus dem Cluster oder Container ausgeschlossen werden können). wenn sich der Datenverkehr und die Intensität der Anfragen beruhigen).

Aufgrund eines solchen Ansatzes erhalten Unternehmen eine verbesserte Zugänglichkeit, Ausfallsicherheit sowie ultimative Möglichkeiten zur Budgeteinsparung. Bei solchen Diensten setzen Sie genau so viel Serverleistung ein, wie Sie gerade benötigen. Dies ist eine durchaus gewinnbringende Option im Gegensatz zur physischen Skalierung, wenn Sie teure Hardware kaufen und weiter warten müssen.

Beachten Sie, dass die automatische Cloud-Skalierbarkeit immer mit Load-Balancing-Lösungen einhergeht.

Microservices-Container, Clusterisierung

Sie können ressourceneffiziente, leistungssteigernde Verfahren einsetzen, die Dienste in Container verpacken und diese Container dann in Clustern zusammenfassen. Auf die Clusterisierung folgt die Definition von Skripten, die entweder fehlende Ressourcen (Instanzen) bei Bedarf hinzufügen oder die Zuweisung von Ressourcen minimieren, um den Überschuss zu vermeiden.

Caching implementieren

Während der horizontalen Skalierung kann einfaches Speicher-Caching nicht für mehrere Knoten gleichzeitig implementiert werden, sodass es optimiert werden muss. Insbesondere können Speicher wie Memcached oder Redis für die kombinierte Verteilung von Cache-Daten zwischen Anwendungsiterationen verwendet werden. Diese Tools arbeiten nach unterschiedlichen Algorithmen, sodass die Menge der zwischengespeicherten Daten reduziert wird. Cache-Speicher sind außerdem gut vor Replikations- und Datenspeicherfehlern geschützt.

Durch die Verwendung von Cache-Speicher ist es wichtig, die Situation zu verhindern, in der verschiedene App-Iterationen gleichzeitig nicht zwischengespeicherte Daten anfordern. Dazu muss man die Caching-Daten außerhalb des Leistungsflusses Ihrer App aktualisieren und direkt in der App verwenden.

Daher kann Caching mit einem geeigneten Ansatz Ihren Systemen helfen, eine Fähigkeit zur Cloud-Skalierung zu erhalten, um intensive Lasten zu bewältigen und eine optimale Ausgabe zu erzielen.

Setzen Sie CDN-Dienste ein

CDN ist ein Netzwerk von physisch entfernten Computern, die Inhalte an Dienstbenutzer übertragen. Mit anderen Worten, es handelt sich um eine verteilte Speicherung und Verwendung von Cache. Normalerweise ist die Verwendung von CDN am relevantesten, wenn ein Webdienst, eine Website oder eine vollständige Anwendung auf eine Benutzergruppe abzielt, die über das Gebiet mehrerer Länder verteilt ist. Die CDN-Preise hängen direkt vom Verkehrsaufkommen ab, das durch den Dienst geleitet wird.

Alternativ kann CDN eine unrentable Lösung sein, wenn Ihr TA trotz seiner breiten territorialen Verteilung Lokalisierungen mit der Konzentration bestimmter Benutzer hat. Nehmen wir beispielsweise an, dass etwa 60 % Ihrer TA in den USA ansässig sind, 30 % in London und die restlichen 10 % über den ganzen Planeten verstreut sind. In einem solchen Fall ist die Verwendung von CDN nur für die letzten 10 % eine rationale Entscheidung (während an anderen Standorten neue Server installiert werden müssen).

Wie gehen wir mit Skalierungsproblemen um?

Zu unseren derzeit besten Beispielen für die von internen Experten durchgeführte Skalierung gehört der Aufbau einer Architektur mit hoher Skalierbarkeit für öffentliche Cloud-Speicher wie AWS, Microsoft Azure, Google Cloud und Digital Ocean. Wir verwenden automatisierte Umgebungsbereitstellungsskripte mit Hilfe von Terraform – einem System der nächsten Generation für die Erstellung, Verwaltung und Konfiguration von Cloud-Infrastrukturen. Wir basieren unsere Server-Cluster auf der Auto-Scaling-Software Kubernetes und der unterstützenden Containerisierungs-Technologie Docker.

Fazit

Bildquelle: CDN.Lynda

Bildquelle: CDN.Lynda

Indem Sie die Skalierbarkeit in der Cloud-Computing-Umgebung durch die oben genannten und andere Methoden nutzen, können Sie schneller und einfacher wachsen und die ganze Zeit agil bleiben. Wer beim Scaling nur den absolut gewissenhaften Ansatz anstrebt, sollte sich unbedingt an Experten wenden. Lassen Sie uns die DevOps-Spezialisten finden, die die optimalste Serverinfrastruktur für Ihr spezielles Unternehmen bereitstellen, die angepasst wird, um Lasten jeder Intensität zu bewältigen.